Cómo identificar cuellos de botella en el escalado de servidores

8 min de lectura - 22 de septiembre de 2025

Aprenda a identificar y solucionar los cuellos de botella de rendimiento en el escalado de servidores para mejorar la experiencia del usuario y optimizar el uso de los recursos.

Cómo identificar cuellos de botella en el escalado de servidores

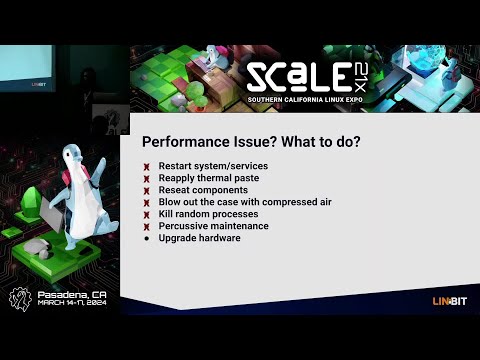

Escalar servidores no consiste sólo en añadir recursos, sino también en encontrar y solucionar los cuellos de botella que limitan el rendimiento. Estos cuellos de botella pueden causar retrasos, caídas y malas experiencias de usuario, incluso con hardware actualizado. Para solucionarlo, concéntrese en:

- Métricas de referencia: Medir el uso de la CPU, la memoria, la E/S del disco, el rendimiento de la red y los tiempos de respuesta en condiciones normales.

- Herramientas de supervisión: Utilice plataformas como New Relic, Grafana y JMeter para rastrear el rendimiento y simular el tráfico.

- Pruebas: Realice pruebas de carga y estrés para identificar puntos de ruptura.

- Análisis: Examine los registros, el uso de recursos y el rendimiento de la base de datos para detectar ineficiencias.

- Correcciones: Optimizar el código, actualizar el hardware (por ejemplo, las unidades SSD) e implementar el escalado horizontal cuando sea necesario.

Diagnóstico de cuellos de botella de rendimiento en sistemas de producción

Establecimiento de líneas de base de rendimiento

Disponer de datos de referencia es crucial para identificar si los cambios en el rendimiento del servidor son fluctuaciones rutinarias o verdaderos cuellos de botella. Las líneas de base proporcionan un punto de referencia que facilita la detección de desviaciones del comportamiento típico del servidor.

Para crear líneas de base precisas, recopile datos de rendimiento que reflejen patrones de tráfico diarios y semanales normales.

Métricas clave de seguimiento

El seguimiento de las métricas correctas es esencial para identificar a tiempo los problemas de rendimiento.

- Utilización de la CPU: Indica cuánta potencia de procesamiento está utilizando su servidor en cada momento. Aunque los rangos aceptables dependen de su configuración específica, la monitorización del uso de la CPU puede revelar cuándo su sistema está sobrecargado o infrautilizado.

- Utilización de la memoria: Controla la cantidad de RAM que consumen tus aplicaciones. Un uso elevado y prolongado de la memoria puede obligar al sistema a depender de un espacio de intercambio más lento basado en disco, lo que ralentiza considerablemente el rendimiento.

- Métricas de E/S de disco: Miden la eficacia con la que el almacenamiento lee y escribe datos. Las métricas clave incluyen IOPS (operaciones de entrada/salida por segundo) y latencia del disco. Por ejemplo, los discos duros tradicionales suelen alcanzar 100-200 IOPS con una latencia de 10-15 milisegundos, mientras que las SSD NVMe pueden ofrecer IOPS mucho más altas con una latencia inferior al milisegundo.

- Rendimiento de la red: Mide la velocidad de transferencia de datos en Mbps o Gbps. Supervisar el ancho de banda entrante y saliente, junto con las tasas de pérdida de paquetes, es vital. Una pérdida de paquetes superior al 0,1% suele indicar congestión en la red o problemas de hardware.

- Tiempos de respuesta: Los tiempos de respuesta reflejan la rapidez con la que sus aplicaciones gestionan las solicitudes. Para las aplicaciones web, lo ideal son tiempos de respuesta de unos cientos de milisegundos. Los estudios de Google destacan que las páginas para móviles que tardan tres segundos o más en cargarse experimentan una tasa de abandono del 53%.

- Métricas específicas de la aplicación: Varían en función de la pila de software, pero pueden incluir los tiempos de consulta de la base de datos, los índices de aciertos de la caché o los recuentos de conexiones activas. Por ejemplo, las consultas rápidas a la base de datos y los altos índices de aciertos de la caché son esenciales para mantener un buen rendimiento general.

La supervisión periódica de estas métricas garantiza que pueda abordar los problemas de rendimiento antes de que sea necesario escalar.

Evaluación comparativa y registro de datos

Para establecer líneas de base fiables, ejecute sus servidores con cargas de producción normales durante al menos dos semanas. Registre los datos a intervalos regulares: cada 5-10 minutos es un buen equilibrio entre detalle y eficiencia de almacenamiento.

La evaluación comparativa de picos de carga también es importante. Mida el rendimiento de su sistema durante los periodos de mayor tráfico para anticipar futuras necesidades de ampliación.

Cuando documente los datos de referencia, incluya marcas de tiempo, valores métricos y contexto relevante. Este registro detallado le ayudará a comparar el rendimiento antes y después de los esfuerzos de ampliación.

Las mediciones del tiempo de actividad son otro componente fundamental. Por ejemplo:

- Un tiempo de actividad del 99% equivale a unas 7 horas de inactividad al mes.

- Un tiempo de actividad del 99,9% reduce el tiempo de inactividad a unos 45 minutos al mes.

- El estándar de oro, el 99,999% de tiempo de actividad (Cinco nueves), permite sólo 30 segundos de tiempo de inactividad al mes.

También puede considerar el uso de la puntuación Apdex para medir la satisfacción del usuario con los tiempos de respuesta. Esta puntuación va de 0 (deficiente) a 1 (excelente) clasificando los tiempos de respuesta en zonas de satisfacción, tolerancia y frustración. Una puntuación superior a 0,85 suele indicar una experiencia de usuario positiva.

Almacene sus datos de referencia en un sistema centralizado para facilitar el acceso y la comparación. Las bases de datos de series temporales o las plataformas de monitorización se utilizan habitualmente para conservar los datos históricos, lo que simplifica la determinación de si los cambios de rendimiento se deben a escalado o a problemas subyacentes del sistema.

Una vez establecidas estas líneas de base, estará listo para pasar a las herramientas y técnicas de supervisión del rendimiento en tiempo real.

Herramientas de supervisión y análisis

Las herramientas de supervisión adecuadas pueden transformar los datos brutos en información práctica, ayudándole a detectar cuellos de botella antes de que perturben la experiencia del usuario. Con una gran variedad de funciones, como alertas en tiempo real y análisis en profundidad del rendimiento, elegir las herramientas adecuadas resulta esencial para identificar y resolver los problemas con eficacia.

Herramientas básicas de supervisión

Las plataformas de supervisión del rendimiento de las aplicaciones (APM ), como New Relic, son indispensables para realizar un seguimiento de las métricas de las aplicaciones y las experiencias de los usuarios. Estas herramientas capturan automáticamente datos clave como tiempos de respuesta, tasas de error y trazas de transacciones. Funciones como el rastreo distribuido facilitan la localización de consultas lentas a bases de datos o llamadas lentas a API.

Grafana es una herramienta de visualización versátil que se integra con múltiples fuentes de datos. Cuando se combina con bases de datos de series temporales como Prometheus o InfluxDB, Grafana destaca en la creación de paneles que vinculan métricas, como la correlación de picos de CPU con tiempos de respuesta más lentos, lo que facilita la detección de problemas de rendimiento de un vistazo.

Apache JMeter es una herramienta de pruebas de carga que simula activamente el tráfico de usuarios para medir cómo los sistemas gestionan los usuarios simultáneos. Al generar tráfico y probar el rendimiento del servidor en diversas condiciones, JMeter ayuda a identificar los puntos de ruptura y las limitaciones de recursos antes de que afecten a los entornos de producción.

La pila ELK (Elasticsearch, Logstash y Kibana) se centra en el análisis de registros y las capacidades de búsqueda. Logstash recopila y procesa los datos de registro, Elasticsearch permite realizar búsquedas y Kibana visualiza los resultados. Esta combinación es ideal para identificar patrones de error, rastrear frecuencias de eventos y vincular registros a caídas de rendimiento.

Las herramientas de supervisión a nivel de sistema como Nagios, Zabbix y Datadog proporcionan una vista de pájaro de las métricas de infraestructura. Estas plataformas supervisan datos críticos de hardware como el uso de la CPU, el consumo de memoria, la E/S de disco y el tráfico de red, lo que las hace esenciales para detectar cuellos de botella relacionados con el hardware y planificar actualizaciones de capacidad.

Las herramientas de supervisión de bases de datos, como pgAdmin para PostgreSQL o MySQL Enterprise Monitor, ofrecen información especializada sobre el rendimiento de las bases de datos. Estas herramientas rastrean métricas como tiempos de ejecución de consultas, contención de bloqueos y uso de buffer pool - detalles que los monitores de propósito general pueden pasar por alto pero que son cruciales para optimizar el rendimiento de la base de datos.

Cada tipo de herramienta sirve a un propósito único: las herramientas APM se centran en el rendimiento de las aplicaciones, los monitores de sistemas gestionan las métricas de hardware y las herramientas de bases de datos se especializan en el análisis del almacenamiento y las consultas. Muchas organizaciones utilizan una combinación de estas herramientas para cubrir toda su pila tecnológica, garantizando tanto la resolución inmediata de problemas como la optimización del rendimiento a largo plazo.

Datos en tiempo real frente a datos históricos

La supervisión en tiempo real ofrece una visibilidad instantánea del rendimiento del sistema, lo que permite a los equipos responder rápidamente a los problemas que surjan. Los paneles se actualizan cada pocos segundos, mostrando métricas en tiempo real como el uso de la CPU, las conexiones activas y los tiempos de respuesta. Esto es fundamental para detectar aumentos repentinos del tráfico, fugas de memoria o componentes defectuosos antes de que se conviertan en problemas mayores.

Las alertas en tiempo real se activan cuando las métricas superan umbrales predefinidos, como un uso de la CPU superior al 80% o tiempos de respuesta superiores a 2 segundos. Estas alertas permiten a los equipos abordar los problemas en cuestión de minutos, minimizando el tiempo de inactividad.

El análisis de datos históricos, por otra parte, descubre tendencias a largo plazo y patrones recurrentes que la supervisión en tiempo real podría pasar por alto. Al examinar los datos durante semanas o meses, los equipos pueden identificar fluctuaciones estacionales del tráfico, descensos graduales del rendimiento o cuellos de botella recurrentes. Por ejemplo, un aumento del 15% en los tiempos de consulta de la base de datos en tres meses podría indicar un aumento de los volúmenes de datos o consultas ineficaces que necesitan optimización.

El análisis histórico también ayuda a planificar la capacidad. Tendencias como el aumento del uso de la memoria o de los volúmenes de tráfico ayudan a predecir cuándo los recursos alcanzarán sus límites, lo que permite escalar o actualizar proactivamente.

Lacombinación de ambos enfoques crea una estrategia de supervisión completa. Los datos en tiempo real proporcionan información inmediata para la gestión de crisis, mientras que el análisis histórico informa de las decisiones estratégicas para prevenir problemas futuros. Muchas herramientas modernas integran a la perfección ambos enfoques, ofreciendo paneles de control en tiempo real junto con el almacenamiento de datos históricos, para que los equipos puedan alternar sin esfuerzo entre la solución de problemas a corto plazo y la planificación a largo plazo.

Los mejores resultados se obtienen cuando los equipos revisan rutinariamente las alertas en tiempo real para abordar los problemas inmediatos y analizan las tendencias históricas para tomar decisiones de escalado y optimización más inteligentes. Este doble enfoque garantiza que los sistemas sigan siendo eficientes y resistentes a lo largo del tiempo.

Cómo encontrar cuellos de botella paso a paso

Una vez establecidas las métricas de referencia y configuradas las herramientas de supervisión, el siguiente paso es localizar los cuellos de botella. Esto implica probar, supervisar y analizar sistemáticamente su sistema bajo carga para identificar dónde surgen los problemas de rendimiento.

Pruebas de carga y estrés

Las pruebas de carga le ayudan a evaluar el rendimiento de su sistema bajo la demanda habitual de los usuarios. Empiece por definir sus objetivos de rendimiento, como tiempos de respuesta aceptables, objetivos de rendimiento y umbrales de tasa de error. Estos objetivos actúan como puntos de referencia para detectar desviaciones. Herramientas como JMeter o Gatling pueden simular el tráfico y aumentar gradualmente la carga hasta que el rendimiento empiece a degradarse.

Las pruebas de estrés, por su parte, empujan el sistema más allá de sus límites normales para revelar puntos de ruptura. Durante ambas pruebas, vigile métricas como el uso de la CPU, el consumo de memoria y el ancho de banda de la red. Por ejemplo, un uso de la CPU cercano al 100%, picos de memoria o un ancho de banda al límite suelen estar relacionados con tiempos de respuesta más lentos o tasas de error más elevadas.

La monitorización de usuarios reales (RUM) puede complementar estas pruebas sintéticas proporcionando datos sobre la experiencia real de los usuarios. Esto puede descubrir cuellos de botella que las pruebas controladas podrían pasar por alto.

El siguiente paso es analizar el uso de los recursos para determinar las causas de los problemas de rendimiento.

Análisis de recursos

Compare los datos de uso de recursos con sus métricas de referencia para descubrir limitaciones ocultas. Esto es lo que hay que buscar

- CPU: Los cuellos de botella suelen producirse cuando el uso supera constantemente el 80% o se dispara de forma inesperada.

- Memoria: Un uso elevado o errático puede indicar fugas de memoria o ineficiencias.

- E/S de disco: Supervise la utilización elevada o los tiempos de espera prolongados, que pueden ralentizar las operaciones.

- Red: Compruebe el uso del ancho de banda y la latencia para identificar respuestas lentas de la API o tiempos de espera.

- Rendimiento de la base de datos: Utilice herramientas como MySQL Workbench o SQL Profiler para analizar los tiempos de ejecución de consultas, indexación y bloqueo de transacciones. Las consultas que tardan más de 100 milisegundos podrían indicar operaciones ineficientes, como el procesamiento fila por fila (RBAR), que necesitan optimización.

Análisis de registros y trazas

Los registros y las trazas proporcionan información crítica cuando se combinan con métricas de referencia y en tiempo real. Los registros pueden resaltar errores recurrentes, tiempos de espera o advertencias de recursos que señalan cuellos de botella. Por ejemplo, los mensajes de tiempo de espera o los errores relacionados con los límites de recursos suelen apuntar directamente a las áreas problemáticas.

Las herramientas de seguimiento distribuido, como OpenTelemetry con Jaeger, permiten rastrear el recorrido de una solicitud a través de microservicios, revelando retrasos causados por consultas lentas a bases de datos, tiempos de espera de API o dependencias de servicios problemáticas. La instrumentación detallada, como el registro de las horas de inicio y fin de las operaciones, puede ayudar a identificar las secciones de código que consumen recursos excesivos. Del mismo modo, los registros de consultas a bases de datos pueden revelar ineficiencias como las operaciones RBAR.

La contención de hilos es otra área que merece la pena examinar. El análisis de los volcados de subprocesos puede revelar bloqueos, hilos muertos o cambios de contexto excesivos, que pueden reducir el rendimiento. La captura de instantáneas de trazas de pila durante los picos de rendimiento puede determinar con mayor precisión las rutas de código exactas que causan retrasos.

Entre marzo y noviembre de 2020, el uso de Miro se multiplicó por siete, alcanzando más de 600.000 usuarios únicos al día. Para hacer frente a los cuellos de botella de los servidores durante esta rápida escalada, el equipo de sistemas de Miro se centró en supervisar el tiempo medio de finalización de las tareas (percentil) en lugar de los promedios o el tamaño de las colas. Este enfoque les ayudó a optimizar los procesos que afectaban a la mayoría de los usuarios.

Fuentes habituales de cuellos de botella y sus efectos

Comprender los cuellos de botella es crucial para orientar los esfuerzos de supervisión y acelerar los tiempos de respuesta. Los diferentes cuellos de botella dejan rastros distintos, que pueden ayudarle a localizar y resolver los problemas con eficacia.

He aquí un desglose de las fuentes de cuellos de botella más frecuentes, sus señales de advertencia, métodos de detección y cómo limitan la escalabilidad:

Profundizar en los cuellos de botella

Loscuellos de botella de la CPU se producen con mayor frecuencia durante los picos de tráfico. Cuando el uso de la CPU supera el 80%, el sistema empieza a poner solicitudes en cola, lo que provoca retrasos y tiempos de espera. En este punto, el escalado horizontal suele ser la única solución viable.

Los problemas de memoria tienden a ser silenciosos hasta que el uso de RAM se acerca a niveles críticos. Una vez que esto sucede, las aplicaciones pueden bloquearse o ralentizarse significativamente debido a las sobrecargas de la recolección de basura, obligando a costosas actualizaciones o esfuerzos de optimización.

Los cuellos de botella en las bases de datos son un reto común en el escalado de aplicaciones web. Síntomas como los tiempos de espera de las consultas y el agotamiento de los grupos de conexiones pueden afectar al rendimiento, lo que a menudo requiere la agrupación de bases de datos o la adición de réplicas de lectura para distribuir la carga.

Las limitaciones de la red suelen aparecer cuando se trabaja con archivos de gran tamaño o llamadas frecuentes a la API. Una latencia elevada o la pérdida de paquetes, especialmente entre distintas regiones, suelen indicar la necesidad de redes de distribución de contenidos (CDN) u otras estrategias de distribución.

Loscuellos de botella en el almacenamiento surgen a medida que aumenta la demanda de datos. Las unidades tradicionales con IOPS limitadas pueden ralentizar las operaciones de archivos y escrituras en bases de datos, por lo que las SSD o las arquitecturas de almacenamiento distribuido son fundamentales para mantener el rendimiento.

Loscuellos de botella en el código de las aplicaciones son únicos porque se derivan de ineficiencias en el diseño o la implementación, como fugas de memoria o estrategias deficientes de almacenamiento en caché. La solución de estos problemas suele requerir la elaboración de perfiles en profundidad, la refactorización o incluso el rediseño de la arquitectura para hacer frente a las demandas de escalado.

Corregir los cuellos de botella para mejorar la escalabilidad

Los cuellos de botella de hardware como la CPU y la memoria pueden mitigarse a veces con el escalado vertical, pero este enfoque tiene sus límites. A la larga, el escalado horizontal se hace inevitable. Por otro lado, los cuellos de botella en las bases de datos y el código de las aplicaciones suelen requerir un trabajo de optimización antes de que los recursos adicionales puedan ser plenamente efectivos.

Corregir los cuellos de botella para mejorar el escalado

Una vez identificados los cuellos de botella, el siguiente paso es abordarlos con eficacia. El objetivo es abordar las causas de raíz en lugar de sólo los síntomas, asegurando que su infraestructura pueda manejar el crecimiento futuro sin encontrarse con los mismos problemas.

Solución de los cuellos de botella identificados

Cuellos de botella en la CPU: Si el uso de la CPU supera regularmente el 80%, es hora de actuar. Empiece por optimizar su código: racionalice los algoritmos ineficaces y reduzca las operaciones que consumen muchos recursos. Aunque la actualización del hardware (escalado vertical) puede proporcionar un alivio inmediato, es sólo una solución temporal. Para una escalabilidad a largo plazo, implemente el equilibrio de carga y el escalado horizontal para distribuir las cargas de trabajo entre varios servidores, ya que un único servidor acabará por alcanzar sus límites.

Problemas de memoria: Utilice herramientas de creación de perfiles para detectar fugas de memoria y optimizar el modo en que su aplicación asigna la memoria. Actualizar la memoria RAM es una buena solución a corto plazo, pero para mejorar la escalabilidad, considere la posibilidad de diseñar aplicaciones sin estado. Éstas distribuyen las cargas de memoria entre varias instancias, lo que hace que su sistema sea más resistente.

Cuellos de botella en la base de datos: Las consultas lentas suelen ser las culpables. Optimícelas y añada los índices adecuados para acelerar el proceso. Otras estrategias incluyen el uso de agrupación de conexiones, la configuración de réplicas de lectura para distribuir las cargas de consulta y la fragmentación de bases de datos para aplicaciones con mucha escritura. La actualización a unidades SSD NVMe también puede proporcionar un aumento significativo del rendimiento.

Limitaciones de red: Si su red tiene problemas, considere actualizar su ancho de banda y utilizar CDN para reducir la distancia que deben recorrer los datos. Comprima las respuestas y minimice el tamaño de la carga útil para que las transferencias de datos sean más eficientes. Para audiencias globales, desplegar servidores en múltiples ubicaciones geográficas puede ayudar a reducir la latencia.

Cuellos de botella en el almacenamiento: Sustituya los discos duros tradicionales por unidades SSD para gestionar mayores IOPS (operaciones de entrada/salida por segundo). Para una gestión más eficiente del almacenamiento, utilice sistemas de almacenamiento distribuidos y separe las cargas de trabajo: por ejemplo, almacenamiento de alto rendimiento para bases de datos y almacenamiento estándar para copias de seguridad.

Estas estrategias funcionan mejor cuando se combinan con un entorno de alojamiento que admita la escalabilidad.

Uso de soluciones de alojamiento escalables

Una infraestructura de alojamiento moderna es un componente clave para resolver y prevenir los cuellos de botella. FDC Servers ofrece opciones de alojamiento adaptadas a los retos de escalabilidad, como servidores dedicados sin medición que eliminan las limitaciones de ancho de banda y soluciones VPS equipadas con procesadores EPYC con almacenamiento NVMe para un rendimiento máximo.

Sus planes de servidores dedicados, a partir de 129 $/mes, son altamente personalizables. Gracias al acceso root y a la posibilidad de modificar el hardware, puede solucionar los problemas de rendimiento sin tener que ceñirse a planes de alojamiento rígidos. Además, el ancho de banda no medido garantiza que los cuellos de botella en la red no le ralentizarán.

Para cargas de trabajo que requieren potencia de procesamiento avanzada, los servidores GPU (desde 1.124 $/mes) proporcionan los recursos necesarios para IA, aprendizaje automático y otras aplicaciones intensivas. Estos servidores también vienen con ancho de banda no medido y configuraciones personalizables para satisfacer demandas específicas.

Para hacer frente a la latencia de la red, la distribución global es clave. FDC Servers opera en más de 70 ubicaciones en todo el mundo, lo que le permite implementar servidores más cerca de sus usuarios para obtener tiempos de respuesta más rápidos. Sus servicios CDN mejoran aún más la entrega de contenidos con puntos de presencia globales optimizados.

¿Necesita recursos rápidamente? Su función de despliegue instantáneo le permite escalar rápidamente, evitando retrasos en el aprovisionamiento de hardware. Esto resulta especialmente útil para gestionar aumentos repentinos del tráfico o solucionar problemas de rendimiento con poca antelación.

La incorporación de estas soluciones de alojamiento puede mejorar significativamente su capacidad para superar los cuellos de botella y prepararse para el crecimiento futuro.

Supervisión y revisión continuas

La supervisión continua es esencial para garantizar que sus soluciones sigan siendo eficaces a lo largo del tiempo. Configure alertas automáticas para métricas clave, como un uso de la CPU superior al 75%, un uso de la memoria superior al 85% o tiempos de respuesta que superen los umbrales aceptables.

Programe revisiones mensuales del rendimiento para seguir las tendencias y detectar problemas emergentes. Vigile las métricas de crecimiento y prevea cuándo sus recursos actuales pueden quedarse cortos. Si planifica las actualizaciones de forma proactiva, evitará costosas correcciones de emergencia que alteran la experiencia del usuario.

Las pruebas de carga periódicas son otro paso fundamental. Pruebe su sistema con los picos de carga previstos y simule picos de tráfico repentinos para asegurarse de que sus soluciones pueden hacer frente a las condiciones del mundo real. Los aumentos graduales de carga y las pruebas de estrés pueden revelar vulnerabilidades ocultas antes de que se conviertan en problemas.

Por último, documente cada incidente de cuello de botella y su resolución. Esto crea una valiosa base de conocimientos para su equipo, facilitando la resolución de problemas similares en el futuro. El seguimiento de la eficacia de sus soluciones también le ayudará a perfeccionar sus estrategias a lo largo del tiempo, garantizando que su infraestructura siga siendo sólida a medida que evolucionan sus necesidades.

Conclusión

Para hacer frente a los retos de escalado de forma eficaz, empiece por establecer líneas de base claras y supervisar su sistema de forma coherente. Comience midiendo métricas clave como el uso de la CPU, la memoria, la E/S del disco y el rendimiento de la red para comprender el rendimiento típico de su sistema. Estos puntos de referencia le ayudarán a detectar anomalías cuando surjan.

Aproveche los cuadros de mando en tiempo real y los datos históricos para detectar y resolver los problemas antes de que perturben la experiencia del usuario. Herramientas como las pruebas de carga y el análisis de registros tienen un valor incalculable para evaluar el rendimiento bajo tensión e identificar los puntos débiles de su infraestructura. Los cuellos de botella habituales, como la sobrecarga de la CPU, las fugas de memoria, la ralentización de las bases de datos, la congestión de la red y las limitaciones de almacenamiento, requieren soluciones específicas y concretas.

Sin embargo, solucionar los cuellos de botella no basta por sí solo. El verdadero cambio radica en la supervisión proactiva y la infraestructura escalable. Un sistema diseñado para adaptarse a la creciente demanda garantiza la fiabilidad a largo plazo y evita problemas recurrentes. Las opciones de alojamiento modernas, como FDC Servers, ofrecen soluciones escalables con un despliegue rápido y una red global que abarca más de 70 ubicaciones. Esta flexibilidad le permite abordar rápidamente los problemas de rendimiento sin tener que esperar a disponer de nuevo hardware.

El secreto para escalar con éxito es mantenerse alerta. Configure alertas automáticas, realice comprobaciones periódicas del rendimiento y conserve registros detallados de los cuellos de botella pasados para futuras consultas. Recuerde que la ampliación no es una tarea puntual, sino un proceso continuo que evoluciona junto con su infraestructura y las necesidades de los usuarios. Con la combinación adecuada de supervisión, herramientas y soluciones de alojamiento escalables, puede crear un sistema que no sólo satisfaga las demandas actuales, sino que también esté preparado para el crecimiento futuro.

Preguntas frecuentes

¿Cuáles son las mejores formas de resolver los cuellos de botella de las bases de datos al escalar servidores?

Para solucionar los cuellos de botella de las bases de datos al escalar servidores, empiece por distribuir el tráfico de forma más uniforme. Esto puede hacerse con herramientas como balanceadores de carga o capas de almacenamiento en caché, que ayudan a aliviar la presión sobre la base de datos. Vigile de cerca las métricas clave mediante herramientas de supervisión: realice un seguimiento de aspectos como los tiempos de respuesta, las tasas de error, el uso de la CPU, la memoria, la E/S del disco y la actividad de la red para identificar problemas antes de que se agraven.

Para los problemas de almacenamiento y rendimiento, considere soluciones de escalado como el escalado vertical (actualización del hardware), el escalado horizontal (adición de más servidores) o la fragmentación de la base de datos. También puede mejorar la eficiencia optimizando las consultas a las bases de datos y garantizando una indexación adecuada. Si se mantiene proactivo con la supervisión y la puesta a punto, mantendrá su sistema funcionando sin problemas a medida que crecen sus servidores.

¿Cómo puedo saber si los problemas de rendimiento de mi servidor se deben a limitaciones del hardware o a un código de aplicación ineficiente?

Para averiguar si el bajo rendimiento de su servidor se debe a limitaciones de hardware o a un código de aplicación mal optimizado, empiece por vigilar las métricas clave del sistema, como el uso de la CPU, el consumo de memoria, la E/S del disco y la actividad de la red. Si estas métricas están constantemente al máximo, es una fuerte señal de que su hardware podría estar luchando para mantener el ritmo. Sin embargo, si las métricas del hardware parecen estar bien pero las aplicaciones siguen yendo lentas, el problema podría estar enterrado en el código.

Las herramientas de monitorización del rendimiento y los registros del servidor son los recursos a los que se puede recurrir para profundizar. Busque pistas como consultas lentas a la base de datos, bucles ineficaces o procesos que acaparan recursos. Las pruebas y los ajustes rutinarios son cruciales para garantizar que su servidor pueda soportar el crecimiento y funcionar sin problemas a medida que aumentan las demandas.

¿Cuáles son las ventajas de las herramientas de supervisión en tiempo real frente al uso de datos históricos para gestionar la escalabilidad del servidor?

Las herramientas de supervisión en tiempo real cambian las reglas del juego cuando se trata de mantener el buen funcionamiento de los sistemas. Proporcionan alertas instantáneas e información procesable, ayudándole a abordar los problemas en el momento en que se producen. Este tipo de información inmediata es clave para evitar problemas de rendimiento durante el escalado del servidor. Además, garantiza que los recursos se asignen de forma eficiente, lo que resulta crucial para gestionar cargas de trabajo en constante cambio.

Mientras tanto, el análisis de datos históricos brilla cuando se trata de detectar tendencias a largo plazo o averiguar las causas de problemas pasados. Pero hay un inconveniente: si sólo confía en los datos históricos, puede perder la oportunidad de actuar rápidamente sobre los problemas actuales. Ese retraso podría provocar tiempos de inactividad o cuellos de botella en el rendimiento. Aunque ambos métodos tienen su lugar, la monitorización en tiempo real es indispensable para realizar ajustes rápidos y mantener el rendimiento óptimo de los servidores en entornos de ritmo rápido.

Cómo instalar y utilizar Redis en un VPS

Aprenda a instalar y configurar Redis en un VPS para un rendimiento, seguridad y gestión óptimos en sus aplicaciones.

9 min de lectura - 7 de enero de 2026

Supervisar su servidor dedicado o VPS, ¿qué opciones hay en 2025?

12 min de lectura - 28 de noviembre de 2025