Cargas de trabajo de IA en entornos virtualizados con GPU: Guía de optimización

11 min de lectura - 10 de octubre de 2025

- Cargas de trabajo de IA en entornos virtualizados con GPU: Guía de optimización

- Conceptos básicos de virtualización de la GPU para IA

- Infraestructura de IA/ML: Explicación de la GPU Time-Slicing

- Requisitos de hardware e infraestructura

- Configuración de la máquina virtual y la GPU

- Supervisión y programación del rendimiento

- Servidores FDC para infraestructuras de IA

- Conclusión

- Preguntas frecuentes

Explore cómo la virtualización de la GPU mejora las cargas de trabajo de IA al aumentar la eficiencia, reducir los costes y optimizar la gestión de recursos en entornos virtualizados.

- Cargas de trabajo de IA en entornos virtualizados con GPU: Guía de optimización

- Conceptos básicos de virtualización de la GPU para IA

- Infraestructura de IA/ML: Explicación de la GPU Time-Slicing

- Requisitos de hardware e infraestructura

- Configuración de la máquina virtual y la GPU

- Supervisión y programación del rendimiento

- Servidores FDC para infraestructuras de IA

- Conclusión

- Preguntas frecuentes

Cargas de trabajo de IA en entornos virtualizados con GPU: Guía de optimización

La virtualización de la GPU está transformando la forma de gestionar las cargas de trabajo de IA. Al dividir una GPU física en varias instancias virtuales, es posible ejecutar varias tareas de IA simultáneamente, lo que mejora la eficiencia y reduce los costes de hardware. Este enfoque es especialmente valioso para entrenar modelos complejos, manejar tareas que consumen muchos recursos y escalar proyectos de IA sin invertir en GPU adicionales.

He aquí por qué es importante:

- Uso eficiente de la GPU: Evita el hardware ocioso compartiendo recursos entre tareas y equipos.

- Ahorro de costes: Las GPU de alto rendimiento son caras; la virtualización garantiza su máxima utilización.

- Flexibilidad: Adapte las instancias virtuales de la GPU a necesidades específicas, como el tamaño de la memoria o las versiones de CUDA.

- Escalabilidad: Ajuste dinámico de los recursos a medida que crecen las cargas de trabajo de IA.

- Fiabilidad: Las instancias aisladas evitan que una tarea afecte a las demás.

Para optimizar el rendimiento:

- Elija GPU con gran memoria y ancho de banda (por ejemplo, NVIDIA A100/H100).

- Utilice almacenamiento NVMe y redes de baja latencia para el manejo de datos.

- Configure máquinas virtuales con paso de GPU o partición de vGPU en función de las necesidades de la carga de trabajo.

- Utilice herramientas como NVIDIA GPU Operator, plugins de Kubernetes y SLURM para la orquestación.

- Monitorice el rendimiento con herramientas como NVIDIA Nsight Systems y DCGM para identificar cuellos de botella.

Servicios de alojamiento como FDC Servers ofrecen soluciones de GPU a medida a partir de 1.124 $/mes, que incluyen ancho de banda sin contador y opciones de implantación global para proyectos de IA a gran escala.

Conclusión: La virtualización de la GPU agiliza la gestión de recursos, aumenta el rendimiento y reduce los costes de las cargas de trabajo de IA, lo que la convierte en una solución práctica para escalar las operaciones de IA de forma eficiente.

Conceptos básicos de virtualización de la GPU para IA

¿Qué es la virtualización de la GPU?

La virtualización de la GPU permite que varios usuarios compartan una única GPU mediante la creación de instancias virtuales, cada una con su propia memoria, núcleos y capacidad de procesamiento dedicados. Esto significa que una sola GPU puede manejar múltiples tareas o usuarios al mismo tiempo, lo que la convierte en una solución eficiente para las cargas de trabajo de IA.

En esencia, esta tecnología se basa en un hipervisor, que actúa como gestor y divide los recursos de la GPU entre las máquinas virtuales. El hipervisor garantiza que cada instancia reciba la parte que le corresponde sin interferencias de otras. En el caso de las tareas de IA, esto permite que una sola GPU NVIDIA A100 o H100 ejecute simultáneamente múltiples experimentos de aprendizaje automático, sesiones de entrenamiento u operaciones de inferencia.

Existen dos métodos principales para compartir estos recursos:

- Virtualización a nivel de hardware: La tecnología MIG (Multi-Instance GPU) de NVIDIA divide físicamente la GPU en secciones aisladas, lo que garantiza una fuerte separación entre las instancias.

- Virtualización a nivel de software: Este método utiliza controladores y software para dividir los recursos de la GPU, lo que ofrece más flexibilidad pero algo menos de aislamiento.

Una diferencia clave entre la virtualización de la GPU y la de la CPU tradicional radica en la gestión de la memoria. Las GPU utilizan memoria de gran ancho de banda (HBM), que funciona de forma diferente a la RAM estándar del sistema. La gestión eficiente de esta memoria es fundamental, especialmente durante las operaciones de IA que consumen muchos recursos, como el ajuste fino o el entrenamiento a gran escala.

Estos conocimientos básicos sientan las bases para explorar cómo la virtualización de la GPU mejora el rendimiento de la IA en escenarios prácticos.

Ventajas para las cargas de trabajo de IA y aprendizaje automático

La virtualización ofrece una serie de ventajas que abordan directamente los retos de las cargas de trabajo de IA y aprendizaje automático (ML).

Maximizar la utilización de la GPU es una de las ventajas más destacadas. Las GPU de alto rendimiento, que pueden costar entre 10.000 y 30.000 dólares, suelen infrautilizarse durante tareas como el preprocesamiento de datos o la configuración de modelos. La virtualización garantiza la plena utilización de estos costosos recursos al permitir que varias tareas compartan la misma GPU, lo que reduce el tiempo de inactividad y recorta los costes de hardware. Este enfoque permite a las organizaciones dar servicio a más usuarios y aplicaciones sin necesidad de GPU físicas adicionales.

La flexibilidad en el desarrollo es otro factor que cambia las reglas del juego. Con la virtualización, los desarrolladores pueden crear instancias de GPU virtuales adaptadas a necesidades específicas, como diferentes versiones de CUDA, tamaños de memoria o configuraciones de controladores. Este aislamiento garantiza que los proyectos que utilizan marcos de trabajo como PyTorch, TensorFlow o JAX puedan coexistir sin conflictos, lo que agiliza los flujos de trabajo y acelera la innovación.

La escalabilidad es mucho más fácil de gestionar. Las cargas de trabajo de la IA pueden variar significativamente en sus demandas. Por ejemplo, el entrenamiento de una pequeña red neuronal puede requerir unos recursos mínimos, mientras que el ajuste fino de un gran modelo lingüístico exige una enorme potencia de cálculo. Las instancias virtuales pueden ampliarse o reducirse dinámicamente, asignando recursos en función de la intensidad de la carga de trabajo. Esta adaptabilidad garantiza un uso eficiente de los recursos en todo momento.

El soporte multiarrendamiento es especialmente valioso para organizaciones con necesidades diversas. Al compartir la infraestructura, diferentes departamentos, clientes o aplicaciones pueden acceder a los recursos de la GPU sin necesidad de gestionar el hardware físico. Los proveedores de servicios en la nube pueden incluso ofrecer la GPU como servicio, lo que permite a los usuarios acceder a instancias de GPU virtuales manteniendo el aislamiento del rendimiento y reduciendo la complejidad administrativa.

Por último, el aislamiento de fallos garantiza la estabilidad. Si una instancia virtual falla o consume recursos excesivos, no afectará a otras instancias que compartan la misma GPU. Esta fiabilidad es fundamental en entornos de producción en los que múltiples servicios de IA deben funcionar de forma fluida y constante.

La virtualización de la GPU no sólo optimiza el uso de los recursos, sino que también dota a los equipos de IA de las herramientas y la flexibilidad necesarias para hacer frente a cargas de trabajo complejas y en constante cambio.

Infraestructura de IA/ML: Explicación de la GPU Time-Slicing

Requisitos de hardware e infraestructura

Obtener el máximo rendimiento de la IA en entornos de GPU virtualizada depende en gran medida de la elección del hardware y la interconexión adecuados. Estas decisiones desempeñan un papel clave a la hora de maximizar el potencial de la virtualización de la GPU para las cargas de trabajo de IA.

Elección de la arquitectura de GPU adecuada

Al seleccionar GPU para tareas de IA, busque modelos con gran capacidad de memoria, rápido ancho de banda y soporte de virtualización integrado. Muchas GPU modernas pueden dividirse en varias instancias aisladas, lo que permite a distintos usuarios o aplicaciones disponer de recursos de cálculo y memoria dedicados. Pero la elección de la GPU adecuada es sólo una parte de la ecuación: la infraestructura de almacenamiento y red también debe ser capaz de mantener el ritmo de su rendimiento.

Requisitos de almacenamiento y red

Las cargas de trabajo de IA a menudo implican la gestión de cantidades masivas de datos, lo que hace que el almacenamiento NVMe de alta velocidad y las redes de baja latencia sean esenciales. En entornos empresariales, las unidades NVMe con altos índices de resistencia son ideales para gestionar los ciclos de lectura/escritura intensos que conllevan las aplicaciones de IA.

Para los intercambios de datos entre nodos, tecnologías como InfiniBand o soluciones Ethernet avanzadas proporcionan el ancho de banda necesario para unas operaciones fluidas. El uso de un sistema de archivos distribuido para permitir la E/S paralela puede ayudar a minimizar los cuellos de botella cuando varios procesos acceden a los datos al mismo tiempo. Una vez satisfechas las necesidades de almacenamiento y red, el siguiente paso consiste en ajustar la alineación de los recursos.

Alineación de recursos y optimización de la topología

Para optimizar la alineación de los recursos, configure NUMA (acceso no uniforme a la memoria) para garantizar conexiones directas entre las GPU, la memoria y las CPU. Asigne interfaces de red de alta velocidad y dedique carriles PCIe para reducir la latencia. Tenga en cuenta que una refrigeración robusta y una capacidad de alimentación suficiente son fundamentales para evitar el estrangulamiento térmico y mantener la estabilidad del sistema. Además, colocar el almacenamiento cerca de las unidades de procesamiento puede reducir aún más la latencia, creando una arquitectura de sistema más eficiente y con mayor capacidad de respuesta.

Configuración de la máquina virtual y la GPU

Una vez configurado el hardware, el siguiente paso es configurar las máquinas virtuales (VM) y las GPU para garantizar un rendimiento óptimo de la IA. Una configuración adecuada libera el potencial de las GPU virtualizadas, haciéndolas más eficaces para las cargas de trabajo de IA. Veamos cómo configurar y gestionar estos recursos de forma eficiente.

Paso completo de GPU frente a particionamiento de vGPU

Cuando se trata de configuraciones de GPU, existen dos enfoques principales: GPU passthrough y vGPU partitioning.

- El paso de GPU dedica una GPU completa a una única máquina virtual, lo que proporciona un rendimiento casi nativo para las exigentes tareas de entrenamiento de IA. Aunque esta configuración maximiza la potencia, limita la GPU a una única máquina virtual, lo que puede resultar ineficaz para cargas de trabajo pequeñas.

- Por otro lado, el particionamiento de vGPU divide una GPU en varios fragmentos virtuales. Este enfoque es más rentable para tareas que no requieren toda la potencia de una GPU, como las cargas de trabajo de inferencia o los trabajos de formación más pequeños.

Las GPU modernas, como las NVIDIA A100 y H100, admiten MIG (Multi-Instance GPU), lo que permite crear hasta siete instancias de GPU aisladas en una sola tarjeta. Esta característica es perfecta para maximizar la utilización del hardware manteniendo los costes bajo control.

La elección correcta depende de tu caso de uso:

- Para la formación a gran escala, como la formación de modelos de lenguaje o la investigación de aprendizaje profundo, la GPU passthrough suele ser la mejor opción.

- Para tareas como el servicio de inferencia, el desarrollo o las pruebas, el particionamiento vGPU ofrece una mejor eficiencia de recursos y ahorro de costes.

Asignación de recursos para el máximo paralelismo

La asignación eficiente de recursos es esencial para evitar cuellos de botella y garantizar la fluidez de las operaciones de IA. A continuación se explica cómo equilibrar los recursos:

- Asignación de CPU: Asigne núcleos de CPU específicos a cada máquina virtual para minimizar el cambio de contexto. Por lo general, la asignación de 4-8 núcleos de CPU por GPU funciona bien, pero esto puede variar en función del marco de IA y la complejidad de la carga de trabajo.

- Gestión de la memoria: Planifica tanto la RAM del sistema como la memoria de la GPU. Asigne al menos 16-32 GB de RAM por GPU para la mayoría de las tareas de IA, reservando al mismo tiempo suficiente memoria para el hipervisor. El uso de páginas enormes también puede reducir la sobrecarga de memoria en operaciones con muchos datos.

- Memoria de la GPU: Cuando utilices el particionamiento vGPU, vigila de cerca el uso de la memoria de la GPU. Algunos marcos de trabajo como PyTorch y TensorFlow pueden asignar dinámicamente la memoria de la GPU, pero el establecimiento de límites garantiza que una carga de trabajo no monopolice los recursos.

- Redes: Habilite SR-IOV (Single Root I/O Virtualization) para interfaces de red para dar a las máquinas virtuales acceso directo al hardware. Esto reduce la latencia de la red, lo que es especialmente importante para el entrenamiento distribuido de IA a través de múltiples nodos.

Herramientas de orquestación de GPU

Una vez asignados los recursos, las herramientas de orquestación pueden simplificar la gestión de las GPU, especialmente en entornos de IA a escala.

- NVIDIA GPU Operator: Esta herramienta automatiza tareas como la instalación de controladores de GPU, la configuración del tiempo de ejecución del contenedor y la supervisión del estado dentro de Kubernetes. Garantiza configuraciones coherentes en todos los clústeres y reduce la carga de trabajo manual.

- Kubernetes GPU Plugins: Plugins como el plugin de dispositivos NVIDIA permiten ajustar la programación y asignación de GPU. Admiten el uso fraccionado de la GPU y permiten una gestión precisa de los recursos para cargas de trabajo basadas en Kubernetes.

- SLURM: SLURM es un programador de tareas diseñado para cargas de trabajo de computación de alto rendimiento (HPC) e inteligencia artificial que ofrece funciones como el conocimiento de la topología de la GPU, la programación equitativa y la reserva de recursos. Es especialmente útil para gestionar entornos multiusuario y multiproyecto.

- Docker con NVIDIA Container Toolkit: Esta configuración permite a los contenedores acceder a las GPU manteniendo el aislamiento entre las cargas de trabajo. Se integra perfectamente con las plataformas de orquestación, lo que la convierte en una opción flexible para implantar aplicaciones de IA.

A medida que crece tu infraestructura de IA, estas herramientas de orquestación se vuelven indispensables. Automatizan la gestión de recursos, mejoran la utilización y proporcionan la inteligencia necesaria para ejecutar varias cargas de trabajo de forma eficiente en hardware compartido.

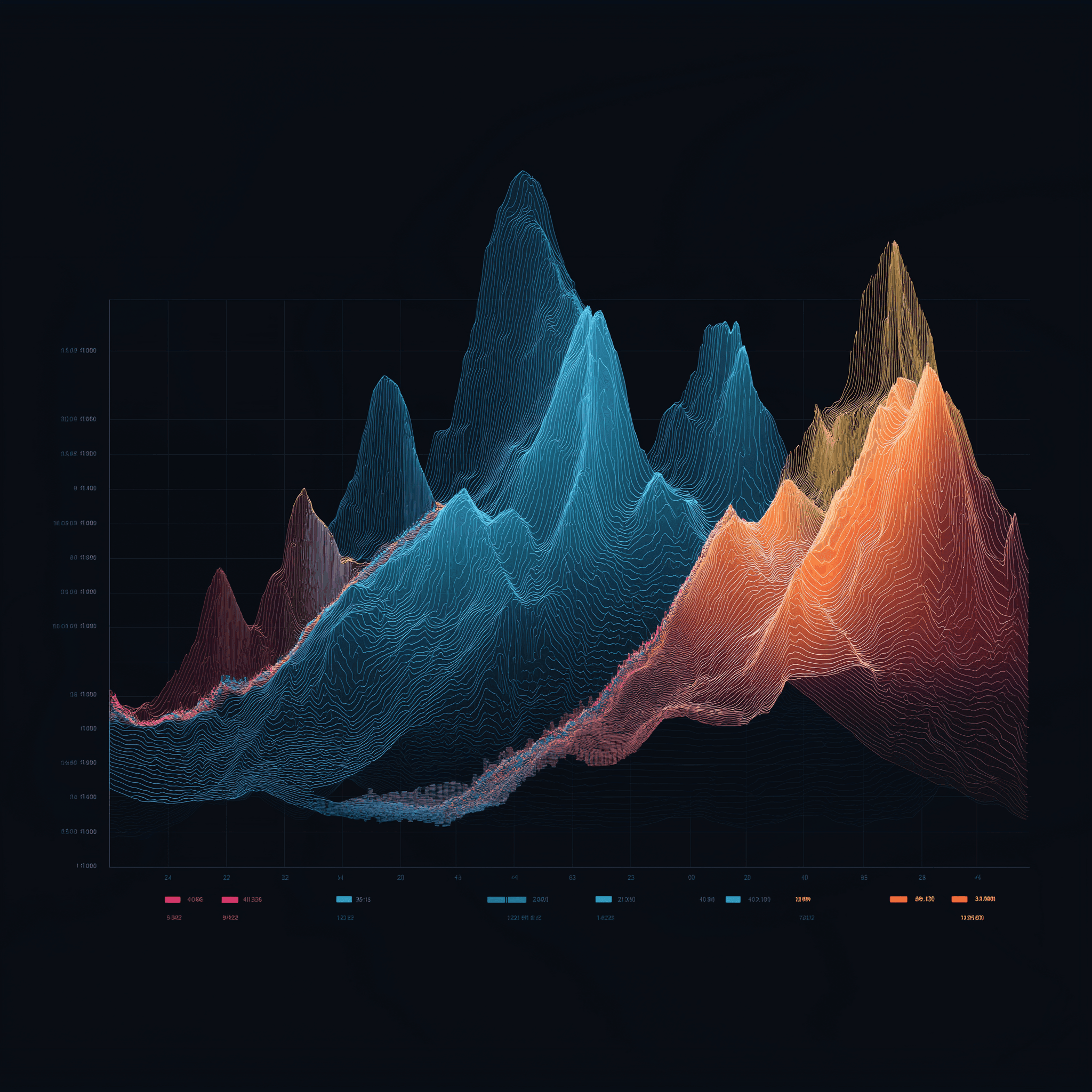

Supervisión y programación del rendimiento

Después de establecer el hardware y las configuraciones, el siguiente paso para que todo funcione sin problemas es centrarse en la supervisión y la programación. Estas dos prácticas son la columna vertebral para mantener el máximo rendimiento de la IA en entornos virtualizados de GPU. Incluso la mejor configuración de hardware puede quedarse corta sin una visibilidad adecuada del uso de los recursos y unas estrategias de programación inteligentes. La creación de perfiles, la programación y la supervisión continua garantizan que las cargas de trabajo de IA sigan siendo eficientes y eficaces.

Perfilado de cargas de trabajo de IA

La creación de perfiles es como tomar el pulso a las cargas de trabajo de IA: ayuda a detectar cuellos de botella y garantiza que los recursos se utilicen correctamente antes de que el rendimiento se vea afectado. El objetivo es comprender cómo consumen las diferentes tareas los recursos de la GPU, la memoria y los ciclos de cálculo.

NVIDIA Nsight Systems es una herramienta de referencia para la creación de perfiles de aplicaciones CUDA, ya que proporciona información detallada sobre la utilización de la GPU, las transferencias de memoria y los tiempos de ejecución del kernel. Para los marcos de aprendizaje profundo, las herramientas de creación de perfiles pueden ayudar a identificar si las cargas de trabajo están ligadas a la GPU, la memoria o la CPU, lo que resulta fundamental para ajustar la asignación de recursos.

Las herramientas específicas para marcos de trabajo, como TensorFlow Profiler y PyTorch Profiler, profundizan aún más. TensorFlow Profiler desglosa los tiempos de paso, mostrando cuánto tiempo se dedica a tareas como la carga de datos, el preprocesamiento y el entrenamiento. Mientras tanto, PyTorch Profiler ofrece una mirada cercana al uso de la memoria, ayudando a detectar fugas de memoria u operaciones tensoriales ineficientes.

A la hora de crear perfiles, las métricas clave que hay que vigilar son las siguientes

- Utilización de la GPU: Intenta alcanzar al menos el 80% durante el entrenamiento para garantizar un uso eficiente.

- Utilización del ancho de banda de la memoria: Muestra el grado de utilización de la memoria de la GPU.

- Eficiencia del kernel: Indica la eficacia con la que las operaciones se alinean con la arquitectura de la GPU.

En entornos virtualizados, la creación de perfiles resulta un poco más complicada debido a la capa de hipervisor añadida. Herramientas como vSphere Performance Charts o la monitorización del rendimiento de KVM pueden salvar las distancias, correlacionando las métricas a nivel de máquina virtual con los datos de perfilado a nivel de invitado. Este enfoque de doble capa ayuda a determinar si los problemas de rendimiento se deben a la capa de virtualización o a la propia carga de trabajo.

La información obtenida a partir de la creación de perfiles alimenta directamente estrategias de programación más inteligentes, manteniendo los recursos asignados de forma eficaz.

Programación de cargas de trabajo con IA

La programación es donde se produce la magia: garantiza que las GPU se utilicen de forma eficiente mientras se gestionan múltiples cargas de trabajo de IA. Las distintas estrategias responden a diferentes necesidades, desde la sincronización de tareas distribuidas hasta la priorización de trabajos críticos.

- Programación en grupo: Perfecto para el entrenamiento síncrono, este método garantiza que todos los procesos del entrenamiento distribuido estén alineados, de modo que ningún trabajador se quede sin hacer nada.

- Programación predictiva: Mediante el análisis de datos históricos, este enfoque predice los tiempos de ejecución de los trabajos en función de factores como el tamaño del modelo y las características del conjunto de datos, lo que permite una colocación más inteligente de la carga de trabajo.

- Tareas preferentes: Las tareas de alta prioridad pueden desplazar temporalmente a las de baja prioridad. Los programadores que tienen en cuenta los puntos de control detienen los trabajos de forma segura, guardan su estado y los reanudan más tarde, cuando los recursos se liberan.

- Programación equitativa: Realiza un seguimiento del uso histórico y ajusta dinámicamente las prioridades para garantizar que los recursos se distribuyen equitativamente entre los usuarios o proyectos.

El método de programación que elijas puede determinar la eficiencia del sistema. Por ejemplo, la programación por lotes funciona bien en configuraciones de investigación con plazos flexibles, mientras que la programación en tiempo real es esencial para cargas de trabajo de inferencia que exigen baja latencia.

Una vez establecida la programación, la supervisión continua garantiza que todo siga su curso.

Supervisión y evaluación comparativa

La supervisión continua actúa como sistema de alerta temprana, detectando posibles problemas antes de que interrumpan la producción. La combinación de métricas en tiempo real con datos históricos ayuda a descubrir tendencias y patrones que, de otro modo, podrían pasar desapercibidos.

Las herramientas de monitorización de la GPU deben realizar un seguimiento de todos los parámetros, desde la utilización y el uso de la memoria hasta la temperatura y el consumo de energía. NVIDIA Data Center GPU Manager (DCGM) es una opción robusta, que se integra con plataformas como Prometheus y Grafana para proporcionar una visión completa. Estas herramientas pueden ayudar a detectar problemas como el estrangulamiento térmico o la presión de la memoria que podrían afectar al rendimiento.

La supervisión a nivel de aplicación se centra en métricas específicas de la IA, como la pérdida de entrenamiento, la precisión de validación y las tasas de convergencia. Herramientas como MLflow y Weights & Biases combinan estas métricas con los datos de rendimiento del sistema, ofreciendo una imagen completa del estado de la carga de trabajo.

Para la formación distribuida, la supervisión de la red es imprescindible. Es importante realizar un seguimiento del uso del ancho de banda, la latencia y la pérdida de paquetes entre nodos. Las interconexiones de alta velocidad, como InfiniBand, requieren herramientas especializadas para garantizar una sincronización de gradientes fluida y un entrenamiento paralelo de los datos.

La evaluación comparativa ayuda a establecer líneas de base de rendimiento y a validar las optimizaciones. Las pruebasMLPerf son una opción estándar para evaluar el entrenamiento y la inferencia en varios modelos de IA y configuraciones de hardware. La ejecución de estas pruebas en su entorno virtualizado establece las expectativas de referencia y pone de relieve los problemas de configuración.

Las pruebas sintéticas, como las del repositorio DeepLearningExamples de NVIDIA, también son útiles. Simulan escenarios específicos, ayudan a aislar la sobrecarga de virtualización y confirman que su entorno está funcionando según lo esperado.

La evaluación comparativa periódica -por ejemplo, una vez al mes- puede revelar problemas como actualizaciones de controladores, cambios en la configuración o degradación del hardware que, de otro modo, podrían pasar desapercibidos.

Servidores FDC para infraestructuras de IA

Para lograr el máximo rendimiento de los sistemas de IA, no es negociable disponer de una infraestructura de alojamiento fiable. El socio de alojamiento adecuado garantiza que sus estrategias de creación de perfiles, programación y supervisión funcionen a la perfección, proporcionando la columna vertebral necesaria para optimizar eficazmente las cargas de trabajo de IA.

Esta infraestructura estable es la que permite el despliegue avanzado de las técnicas de creación de perfiles, programación y orquestación comentadas anteriormente.

Servidores GPU para cargas de trabajo de IA

FDC Servers ofrece alojamiento de GPU adaptado específicamente para aplicaciones de IA y aprendizaje automático. A partir de 1.124 dólares al mes, sus servidores de GPU incluyen ancho de banda ilimitado, algo imprescindible cuando se trabaja con grandes conjuntos de datos o formación distribuida. Esta característica elimina las preocupaciones sobre los límites de transferencia de datos, ayudándole a mantener costes predecibles.

Sus servidores son altamente personalizables, lo que le permite ajustar las configuraciones de hardware para modelos de IA de alta memoria o configuraciones de GPU especializadas, como las necesarias para tareas de visión por ordenador. Su despliegue instantáneo permite ampliar rápidamente los recursos de GPU para satisfacer demandas fluctuantes.

Entre las funciones clave se incluyen la compatibilidad con el paso de GPU, la partición de vGPU y la programación personalizada, todas ellas fundamentales para manejar las exigentes cargas de trabajo de IA.

Ancho de banda ilimitado e implantación global

El ancho de banda ilimitado cambia las reglas del juego en los proyectos de IA con grandes volúmenes de datos. La formación de grandes modelos a menudo requiere mover terabytes de datos entre sistemas de almacenamiento, nodos de cálculo y herramientas de supervisión. Al eliminar los límites de transferencia de datos, FDC Servers mantiene su presupuesto predecible y sus flujos de trabajo ininterrumpidos.

Con 74 ubicaciones en todo el mundo, FDC Servers proporciona el alcance geográfico necesario para la infraestructura de IA moderna. Esta red global le permite situar los recursos informáticos más cerca de las fuentes de datos, lo que reduce la latencia en las configuraciones de formación distribuida. Para la inferencia, los modelos pueden desplegarse en ubicaciones periféricas, lo que garantiza tiempos de respuesta más rápidos para los usuarios finales.

La infraestructura global también desempeña un papel fundamental en la recuperación ante desastres y la redundancia. Si una ubicación sufre una interrupción, las cargas de trabajo pueden migrarse sin problemas a otra región, manteniendo las operaciones en marcha sin problemas. Para las organizaciones que gestionan canalizaciones de IA multirregionales, disponer de una infraestructura coherente en las 74 ubicaciones garantiza la uniformidad en las configuraciones de virtualización, las herramientas de supervisión y las estrategias de programación, independientemente de dónde se desplieguen los recursos.

Además, FDC Servers ofrece asistencia 24 horas al día, 7 días a la semana, para resolver cualquier problema, ya esté relacionado con los controladores de GPU, los conflictos de virtualización o la asignación de recursos. Esto garantiza un tiempo de inactividad mínimo, incluso en entornos de GPU virtualizados y complejos.

En conjunto, estas características proporcionan una base sólida para lograr un rendimiento optimizado de la IA.

Conclusión

Esta guía destaca cómo la combinación de hardware avanzado, recursos ajustados y una infraestructura sólida puede aumentar significativamente el rendimiento de la IA.

Para sacar el máximo partido de sus cargas de trabajo de IA, alinee su hardware, asignación de recursos e infraestructura con sus requisitos específicos. Para obtener el máximo rendimiento, la GPU passthrough es ideal, mientras que la partición vGPU ofrece una forma eficiente de compartir recursos.

La sinergia entre la selección de hardware y el ajuste de recursos es clave para optimizar el rendimiento. El uso de GPU con un amplio ancho de banda de memoria, la integración de almacenamiento NVMe y la garantía de un alto rendimiento de la red pueden mejorar directamente la eficiencia del entrenamiento y el resultado del modelo. El ajuste preciso de la topología del sistema reduce los retrasos de interconexión, mientras que la creación de perfiles y la programación inteligente maximizan el uso de la GPU. Las herramientas de orquestación garantizan un rendimiento constante y de alto nivel.

Todo ello unido a un socio de alojamiento fiable. Para las organizaciones que desean superar los problemas de recursos, es fundamental contar con un alojamiento fiable. FDC Servers ofrece alojamiento de GPU por 1.124 dólares al mes con ancho de banda no medido, una opción que elimina los límites de transferencia de datos y los costes impredecibles.

Con funciones como la escalabilidad geográfica, la implementación instantánea y la asistencia 24/7, puede ampliar las operaciones de IA sin problemas. Tanto si gestiona la formación distribuida por regiones como si despliega modelos de inferencia de bordes, una infraestructura fiable elimina muchos de los obstáculos técnicos que suelen ralentizar los proyectos de IA.

Lograr el éxito en la IA requiere una combinación perfecta de potencia de GPU, gestión precisa de recursos y alojamiento fiable. Siguiendo estas estrategias y aprovechando la infraestructura de FDC Servers, podrá allanar el camino hacia el máximo rendimiento de la IA.

Preguntas frecuentes

¿Cómo hace la virtualización de la GPU que las cargas de trabajo de IA sean más eficientes y rentables?

La virtualización de la GPU permite que varias máquinas virtuales utilicen una única GPU física, lo que aumenta la eficiencia y reduce los costes. Al compartir recursos, se elimina la necesidad de hardware adicional, lo que permite aprovechar mejor el que ya está disponible y recortar los gastos generales.

Esta configuración también facilita el escalado y la gestión. Las organizaciones pueden asumir más cargas de trabajo de IA sin necesidad de una GPU distinta para cada máquina virtual. ¿Cuál es el resultado? Rendimiento optimizado y costes controlados: una combinación ideal para proyectos de IA y aprendizaje automático.

¿Cuál es la diferencia entre el paso de GPU y el particionamiento de vGPU, y cuándo se debe utilizar cada uno?

Cuando se trata de GPU passthrough, toda la GPU se dedica a una sola máquina virtual (VM), ofreciendo un rendimiento que es casi indistinguible de la ejecución en hardware físico. Esto la convierte en la opción preferida para tareas exigentes como el entrenamiento de modelos de IA, el aprendizaje profundo o el renderizado 3D, donde es esencial exprimir hasta el último gramo de rendimiento.

Por el contrario, el particionamiento vGPU divide una única GPU en varios segmentos basados en hardware, lo que permite que varias máquinas virtuales o usuarios compartan la misma GPU simultáneamente. Esta configuración funciona mejor en entornos compartidos como escritorios virtuales o estaciones de trabajo colaborativas, donde la prioridad es equilibrar la flexibilidad y el uso eficiente de los recursos.

¿Cuáles son las mejores herramientas y estrategias para supervisar y optimizar las cargas de trabajo de IA en entornos virtualizados de GPU?

Para sacar el máximo partido de las cargas de trabajo de IA en entornos virtualizados de GPU, es esencial utilizar herramientas de monitorización de GPU que ofrezcan datos en tiempo real sobre el uso de recursos y el rendimiento. Por ejemplo, las soluciones de gestión vGPU de NVIDIA facilitan el seguimiento de la utilización de la GPU y la optimización de la distribución de los recursos.

Otro enfoque clave es el uso de plataformas de orquestación como Kubernetes. Estas plataformas pueden ajustar dinámicamente las cargas de trabajo y asignar los recursos de forma más eficaz, lo que ayuda a conseguir un mejor rendimiento de la GPU. Además, el ajuste regular de los hiperparámetros y el perfeccionamiento de las canalizaciones de datos contribuyen en gran medida a mantener altos los niveles de rendimiento. La monitorización continua de las métricas de la GPU permite detectar con antelación los cuellos de botella y evitar conflictos de recursos, lo que garantiza que las tareas de IA se ejecuten sin problemas.

Cómo instalar y utilizar Redis en un VPS

Aprenda a instalar y configurar Redis en un VPS para un rendimiento, seguridad y gestión óptimos en sus aplicaciones.

9 min de lectura - 7 de enero de 2026

Supervisar su servidor dedicado o VPS, ¿qué opciones hay en 2025?

12 min de lectura - 28 de noviembre de 2025