Come identificare i colli di bottiglia nella scalabilità dei server

8 min di lettura - 22 settembre 2025

Imparate a identificare e risolvere i colli di bottiglia delle prestazioni nello scaling dei server per migliorare l'esperienza degli utenti e ottimizzare l'uso delle risorse.

Come individuare i colli di bottiglia nello scaling dei server

Scalare i server non significa solo aggiungere risorse, ma anche trovare e risolvere i colli di bottiglia che limitano le prestazioni. Questi colli di bottiglia possono causare ritardi, arresti anomali ed esperienze negative per gli utenti, anche con hardware aggiornato. Per risolvere questo problema, concentratevi su:

- Metriche di base: Misurare l'uso della CPU, la memoria, l'I/O del disco, il throughput della rete e i tempi di risposta in condizioni normali.

- Strumenti di monitoraggio: Utilizzare piattaforme come New Relic, Grafana e JMeter per monitorare le prestazioni e simulare il traffico.

- Test: Eseguire test di carico e di stress per identificare i punti di rottura.

- Analisi: Esaminare i log, l'utilizzo delle risorse e le prestazioni del database per individuare le inefficienze.

- Correzioni: Ottimizzare il codice, aggiornare l'hardware (ad esempio, SSD) e implementare lo scaling orizzontale, se necessario.

Diagnosticare i colli di bottiglia delle prestazioni nei sistemi di produzione

Impostazione delle linee di base delle prestazioni

Disporre di dati di base è fondamentale per identificare se i cambiamenti nelle prestazioni del server sono fluttuazioni di routine o veri e propri colli di bottiglia. Le linee di base forniscono un punto di riferimento, rendendo più facile individuare le deviazioni dal comportamento tipico del server.

Per creare linee di base accurate, raccogliete dati sulle prestazioni che riflettano i normali modelli di traffico giornalieri e settimanali.

Metriche chiave da monitorare

Tracciare le metriche giuste è essenziale per identificare tempestivamente i problemi di prestazioni.

- Utilizzo della CPU: Indica la quantità di potenza di elaborazione utilizzata dal server in qualsiasi momento. Anche se gli intervalli accettabili dipendono dalla configurazione specifica, il monitoraggio dell'utilizzo della CPU può rivelare quando il sistema è sovraccarico o sottoutilizzato.

- Utilizzo della memoria: Questo dato tiene conto della quantità di RAM consumata dalle applicazioni. Un utilizzo prolungato della memoria può costringere il sistema ad affidarsi allo spazio di swap su disco, rallentando notevolmente le prestazioni.

- Metriche di I/O del disco: Misurano l'efficienza con cui lo storage legge e scrive i dati. Le metriche principali includono IOPS (Input/Output Operations Per Second) e la latenza del disco. Ad esempio, le unità disco tradizionali raggiungono in genere 100-200 IOPS con una latenza di 10-15 millisecondi, mentre le unità SSD NVMe possono fornire IOPS molto più elevati con una latenza inferiore al millisecondo.

- Throughput di rete: Misura la velocità di trasferimento dei dati in Mbps o Gbps. Il monitoraggio della larghezza di banda in entrata e in uscita e dei tassi di perdita dei pacchetti è fondamentale. Una perdita di pacchetti superiore allo 0,1% indica spesso una congestione della rete o problemi hardware.

- Tempi di risposta: I tempi di risposta riflettono la velocità con cui le applicazioni gestiscono le richieste. Per le applicazioni web, i tempi di risposta entro poche centinaia di millisecondi sono ideali. Una ricerca di Google evidenzia che le pagine mobili che impiegano tre o più secondi per caricarsi registrano un tasso di abbandono del 53%.

- Metriche specifiche dell'applicazione: Variano a seconda dello stack software, ma possono includere i tempi di interrogazione del database, le percentuali di accesso alla cache o il conteggio delle connessioni attive. Ad esempio, le query di database veloci e le alte percentuali di accesso alla cache sono essenziali per mantenere alte le prestazioni complessive.

Il monitoraggio regolare di queste metriche consente di risolvere i problemi di prestazioni prima che si renda necessario il ridimensionamento.

Benchmarking e registrazione dei dati

Per stabilire parametri di riferimento affidabili, fate funzionare i vostri server con carichi di produzione normali per almeno due settimane. Registrate i dati a intervalli regolari: ogni 5-10 minuti è un buon compromesso tra dettaglio ed efficienza di archiviazione.

Anche ilbenchmarking dei picchi di carico è importante. Misurare le prestazioni del sistema durante i periodi di maggior traffico per anticipare le future esigenze di scalabilità.

Quando si documentano i dati di base, includere i timestamp, i valori delle metriche e il contesto pertinente. Questo registro dettagliato vi aiuterà a confrontare le prestazioni prima e dopo gli sforzi di scaling.

Le misurazioni dei tempi di attività sono un altro componente critico. Ad esempio:

- Il 99% di uptime equivale a circa 7 ore di downtime al mese.

- Il 99,9% di uptime riduce i tempi di inattività a circa 45 minuti al mese.

- Il gold standard, 99,999% di uptime (Five Nines), consente solo 30 secondi di downtime al mese.

Potreste anche considerare l'utilizzo del punteggio Apdex per valutare la soddisfazione degli utenti sui tempi di risposta. Questo punteggio va da 0 (scarso) a 1 (eccellente), classificando i tempi di risposta in zone di soddisfazione, tolleranza e frustrazione. Un punteggio superiore a 0,85 indica generalmente un'esperienza utente positiva.

Archiviate i dati di base in un sistema centralizzato per facilitarne l'accesso e il confronto. I database di serie temporali o le piattaforme di monitoraggio sono comunemente usati per conservare i dati storici, rendendo più semplice determinare se le variazioni delle prestazioni sono dovute allo scaling o a problemi di sistema sottostanti.

Una volta definiti i dati di base, si è pronti a passare agli strumenti e alle tecniche di monitoraggio delle prestazioni in tempo reale.

Strumenti di monitoraggio e analisi

Gli strumenti di monitoraggio giusti possono trasformare i dati grezzi in informazioni utili, aiutandovi a rilevare i colli di bottiglia prima che interrompano l'esperienza degli utenti. Grazie a una serie di funzionalità come gli avvisi in tempo reale e l'analisi approfondita delle prestazioni, la scelta degli strumenti giusti diventa essenziale per identificare e risolvere i problemi in modo efficace.

Strumenti di monitoraggio principali

Le piattaforme di Application Performance Monitoring (APM) come New Relic sono indispensabili per monitorare le metriche delle applicazioni e le esperienze degli utenti. Questi strumenti acquisiscono automaticamente dati chiave come i tempi di risposta, i tassi di errore e le tracce delle transazioni. Funzioni come il tracciamento distribuito rendono più facile individuare le query di database lente o le chiamate API lente.

Grafana è uno strumento di visualizzazione versatile che si integra con diverse fonti di dati. Se abbinato a database di serie temporali come Prometheus o InfluxDB, Grafana eccelle nella creazione di dashboard che collegano le metriche, come ad esempio la correlazione tra i picchi di CPU e i tempi di risposta più lenti, rendendo più facile individuare i problemi di prestazioni a colpo d'occhio.

Apache JMeter è uno strumento di test di carico che simula attivamente il traffico degli utenti per misurare come i sistemi gestiscono gli utenti contemporanei. Generando traffico e testando il throughput del server in varie condizioni, JMeter aiuta a identificare i punti di rottura e i limiti delle risorse prima che abbiano un impatto sugli ambienti di produzione.

Lo stack ELK (Elasticsearch, Logstash e Kibana) si concentra sulle capacità di analisi e ricerca dei log. Logstash raccoglie ed elabora i dati di log, Elasticsearch li rende ricercabili e Kibana visualizza i risultati. Questa combinazione è ideale per identificare gli schemi di errore, tracciare la frequenza degli eventi e collegare i log ai cali di prestazioni.

Strumenti di monitoraggio a livello di sistema come Nagios, Zabbix e Datadog forniscono una visione d'insieme delle metriche dell'infrastruttura. Queste piattaforme monitorano dati hardware critici come l'utilizzo della CPU, il consumo di memoria, l'I/O del disco e il traffico di rete, rendendoli essenziali per individuare i colli di bottiglia legati all'hardware e pianificare gli aggiornamenti della capacità.

Gli strumenti di monitoraggio dei database, come pgAdmin per PostgreSQL o MySQL Enterprise Monitor, offrono approfondimenti specifici sulle prestazioni dei database. Questi strumenti tengono traccia di metriche come i tempi di esecuzione delle query, la contesa sui lock e l'utilizzo del buffer pool, dettagli che i monitor generici potrebbero trascurare ma che sono fondamentali per ottimizzare le prestazioni del database.

Ogni tipo di strumento ha uno scopo specifico: gli strumenti APM si concentrano sulle prestazioni delle applicazioni, i monitor di sistema gestiscono le metriche hardware e gli strumenti di database sono specializzati nell'analisi dello storage e delle query. Molte organizzazioni utilizzano un mix di questi strumenti per coprire l'intero stack tecnologico, garantendo sia la risoluzione immediata dei problemi che l'ottimizzazione delle prestazioni a lungo termine.

Dati in tempo reale e dati storici

Il monitoraggio in tempo reale offre una visibilità al secondo delle prestazioni del sistema, consentendo ai team di rispondere rapidamente ai problemi emergenti. I dashboard si aggiornano ogni pochi secondi, mostrando metriche in tempo reale come l'utilizzo della CPU, le connessioni attive e i tempi di risposta. Questo è fondamentale per individuare improvvisi picchi di traffico, perdite di memoria o componenti in avaria prima che si trasformino in problemi più gravi.

Gli avvisi in tempo reale vengono attivati quando le metriche superano soglie predefinite, come ad esempio un utilizzo della CPU superiore all'80% o tempi di risposta superiori a 2 secondi. Questi avvisi consentono ai team di risolvere i problemi entro pochi minuti, riducendo al minimo i tempi di inattività.

L**'analisi dei dati storici**, invece, scopre tendenze a lungo termine e schemi ricorrenti che il monitoraggio in tempo reale potrebbe ignorare. Esaminando i dati per settimane o mesi, i team possono identificare le fluttuazioni stagionali del traffico, i cali graduali delle prestazioni o i colli di bottiglia ricorrenti. Ad esempio, un aumento del 15% dei tempi di interrogazione del database nell'arco di tre mesi potrebbe segnalare volumi di dati in crescita o query inefficienti da ottimizzare.

L'analisi storica supporta anche la pianificazione della capacità. Tendenze come l'aumento dell'utilizzo della memoria o l'incremento dei volumi di traffico aiutano a prevedere quando le risorse raggiungeranno i loro limiti, consentendo di scalare o aggiornare in modo proattivo.

La combinazione di entrambi gli approcci crea una strategia di monitoraggio completa. I dati in tempo reale forniscono un feedback immediato per la gestione delle crisi, mentre l'analisi storica informa le decisioni strategiche per prevenire problemi futuri. Molti strumenti moderni integrano perfettamente i due approcci, offrendo dashboard in tempo reale accanto all'archiviazione dei dati storici, in modo che i team possano passare senza problemi dalla risoluzione dei problemi a breve termine alla pianificazione a lungo termine.

I risultati migliori si ottengono quando i team esaminano regolarmente gli avvisi in tempo reale per risolvere i problemi immediati e analizzano le tendenze storiche per prendere decisioni più intelligenti in materia di scalabilità e ottimizzazione. Questo duplice approccio garantisce che i sistemi rimangano efficienti e resistenti nel tempo.

Come trovare i colli di bottiglia passo dopo passo

Una volta stabilite le metriche di base e impostati gli strumenti di monitoraggio, il passo successivo è individuare i colli di bottiglia. Si tratta di testare, monitorare e analizzare sistematicamente il sistema sotto carico per identificare i punti in cui si verificano i problemi di prestazioni.

Test di carico e di stress

I test di carico aiutano a valutare le prestazioni del sistema in base alle richieste tipiche degli utenti. Iniziate definendo gli obiettivi di prestazione, come i tempi di risposta accettabili, gli obiettivi di throughput e le soglie di errore. Questi obiettivi fungono da benchmark per individuare le deviazioni. Strumenti come JMeter o Gatling possono simulare il traffico e aumentare gradualmente il carico finché le prestazioni non iniziano a degradarsi.

I test di stress, invece, spingono il sistema oltre i suoi limiti normali per rivelare i punti di rottura. Durante entrambi i test, è necessario tenere sotto controllo metriche come l'utilizzo della CPU, il consumo di memoria e la larghezza di banda della rete. Ad esempio, un utilizzo della CPU prossimo al 100%, picchi di memoria o larghezza di banda al massimo sono spesso correlati a tempi di risposta più lenti o a tassi di errore più elevati.

Il monitoraggio degli utenti reali (RUM) può integrare questi test sintetici fornendo dati sulle esperienze reali degli utenti. In questo modo si possono scoprire i colli di bottiglia che i test controllati potrebbero ignorare.

Il passo successivo consiste nell'analizzare l'utilizzo delle risorse per individuare le cause principali dei problemi di prestazioni.

Analisi delle risorse

Confrontate i dati sull'utilizzo delle risorse con le metriche di base per scoprire i vincoli nascosti. Ecco cosa cercare:

- CPU: I colli di bottiglia si verificano spesso quando l'utilizzo supera costantemente l'80% o ha picchi inaspettati.

- Memoria: Un utilizzo elevato o irregolare potrebbe indicare perdite di memoria o inefficienze.

- I/O del disco: Monitorare l'utilizzo elevato o i lunghi tempi di attesa, che possono rallentare le operazioni.

- Rete: Controllare l'utilizzo della larghezza di banda e la latenza per identificare risposte API lente o timeout.

- Prestazioni del database: Utilizzate strumenti come MySQL Workbench o SQL Profiler per analizzare i tempi di esecuzione delle query, l'indicizzazione e il blocco delle transazioni. Le query che richiedono più di 100 millisecondi potrebbero indicare operazioni inefficienti, come l'elaborazione riga per riga (RBAR), che richiedono un'ottimizzazione.

Analisi dei log e delle tracce

I registri e le tracce forniscono informazioni critiche se combinati con le metriche di base e in tempo reale. I registri possono evidenziare errori ricorrenti, timeout o avvisi sulle risorse che segnalano colli di bottiglia. Ad esempio, i messaggi di timeout o gli errori relativi ai limiti delle risorse spesso indicano direttamente le aree problematiche.

Strumenti di tracciamento distribuiti come OpenTelemetry con Jaeger consentono di seguire il percorso di una richiesta attraverso i microservizi, rivelando i ritardi causati da interrogazioni lente del database, timeout dell'API o dipendenze problematiche del servizio. Una strumentazione dettagliata, come la registrazione degli orari di inizio e fine delle operazioni, può aiutare a identificare le sezioni di codice che consumano risorse eccessive. Allo stesso modo, i log delle query del database possono rivelare inefficienze come le operazioni RBAR.

La contesa sui thread è un'altra area da esaminare. L'analisi dei dump dei thread può rivelare deadlock, starvation dei thread o un'eccessiva commutazione di contesto, tutti fattori che possono ridurre le prestazioni. L'acquisizione di snapshot dello stack trace durante i picchi di prestazioni può ulteriormente individuare gli esatti percorsi del codice che causano i ritardi.

Tra marzo e novembre 2020, Miro ha registrato un aumento di utilizzo di sette volte, raggiungendo oltre 600.000 utenti unici al giorno. Per risolvere i colli di bottiglia del server durante questa rapida scalata, il team di sistema di Miro si è concentrato sul monitoraggio del tempo mediano di completamento delle attività (percentile) piuttosto che sulle medie o sulle dimensioni delle code. Questo approccio ha permesso di ottimizzare i processi che avevano un impatto sulla maggior parte degli utenti.

Fonti comuni di colli di bottiglia e loro effetti

La comprensione dei colli di bottiglia è fondamentale per indirizzare gli sforzi di monitoraggio e accelerare i tempi di risposta. I diversi colli di bottiglia lasciano tracce distinte, che possono aiutare a individuare e risolvere efficacemente i problemi.

Ecco una panoramica delle fonti più frequenti di colli di bottiglia, i loro segnali di avvertimento, i metodi di rilevamento e il modo in cui limitano la scalabilità:

Approfondimento sui colli di bottiglia

Icolli di bottiglia della CPU si verificano più spesso durante i picchi di traffico. Quando l'utilizzo della CPU supera l'80%, il sistema inizia a mettere in coda le richieste, causando ritardi e timeout. A questo punto, il ridimensionamento orizzontale diventa spesso l'unica soluzione possibile.

I problemi di memoria tendono a rimanere silenti finché l'utilizzo della RAM non si avvicina a livelli critici. In questo caso, le applicazioni possono bloccarsi o rallentare in modo significativo a causa del sovraccarico della garbage collection, costringendo a costosi aggiornamenti o sforzi di ottimizzazione.

I colli di bottiglia del database sono una sfida comune nelle applicazioni web in scala. Sintomi come il timeout delle query e l'esaurimento dei pool di connessioni possono compromettere le prestazioni, richiedendo spesso il clustering del database o l'aggiunta di repliche di lettura per distribuire il carico.

I vincoli di rete si manifestano in genere quando si tratta di file di grandi dimensioni o di frequenti chiamate API. L'elevata latenza o la perdita di pacchetti, soprattutto tra regioni diverse, segnalano spesso la necessità di reti di distribuzione dei contenuti (CDN) o di altre strategie di distribuzione.

I colli di bottiglia dello storage si presentano quando la richiesta di dati aumenta. Le unità tradizionali con IOPS limitati possono rallentare le operazioni sui file e le scritture dei database, rendendo le unità SSD o le architetture di storage distribuito fondamentali per mantenere le prestazioni.

Icolli di bottiglia del codice applicativo sono unici perché derivano da inefficienze nella progettazione o nell'implementazione, come perdite di memoria o strategie di caching inadeguate. La soluzione di questi problemi spesso richiede una profilazione approfondita, un refactoring o addirittura una rielaborazione dell'architettura per gestire le esigenze di scalabilità.

Affrontare i colli di bottiglia per una migliore scalabilità

I colli di bottiglia hardware, come la CPU e la memoria, possono talvolta essere attenuati con lo scaling verticale, ma questo approccio ha dei limiti. Alla fine, lo scaling orizzontale diventa inevitabile. D'altra parte, i colli di bottiglia del database e del codice applicativo richiedono tipicamente un lavoro di ottimizzazione prima che le risorse aggiuntive possano essere pienamente efficaci.

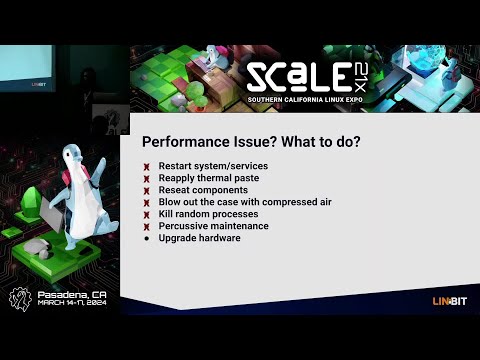

Risolvere i colli di bottiglia per una migliore scalabilità

Una volta identificati i colli di bottiglia, il passo successivo è affrontarli in modo efficace. L'obiettivo è affrontare le cause alla radice piuttosto che i semplici sintomi, assicurando che l'infrastruttura possa gestire la crescita futura senza incorrere negli stessi problemi.

Risolvere i colli di bottiglia identificati

Colli di bottiglia della CPU: Se l'utilizzo della CPU supera regolarmente l'80%, è ora di agire. Iniziate con l'ottimizzazione del codice: ottimizzate gli algoritmi inefficienti e riducete le operazioni ad alto consumo di risorse. L'aggiornamento dell'hardware (vertical scaling) può fornire un sollievo immediato, ma è solo una soluzione temporanea. Per una scalabilità a lungo termine, implementate il bilanciamento del carico e la scalabilità orizzontale per distribuire i carichi di lavoro su più server, poiché un singolo server finirà per raggiungere i suoi limiti.

Problemi di memoria: Utilizzate gli strumenti di profilazione per individuare le perdite di memoria e ottimizzare il modo in cui l'applicazione alloca la memoria. L'aggiornamento della RAM è una buona soluzione a breve termine, ma per una migliore scalabilità è bene considerare la progettazione di applicazioni stateless. Queste distribuiscono i carichi di memoria su più istanze, rendendo il sistema più resistente.

Colli di bottiglia del database: Le query lente sono spesso la causa. Ottimizzatele e aggiungete indici appropriati per accelerare le cose. Altre strategie includono l'uso del pooling delle connessioni, l'impostazione di repliche di lettura per distribuire i carichi delle query e lo sharding dei database per le applicazioni che richiedono una scrittura elevata. Anche l'aggiornamento alle unità SSD NVMe può fornire un significativo aumento delle prestazioni.

Limiti di rete: Se la rete è in difficoltà, valutate la possibilità di potenziare la larghezza di banda e di utilizzare le CDN per ridurre la distanza percorsa dai dati. Comprimete le risposte e riducete al minimo le dimensioni dei payload per rendere più efficienti i trasferimenti di dati. Per un pubblico globale, la distribuzione di server in più località geografiche può contribuire a ridurre la latenza.

Colli di bottiglia dello storage: Sostituire i dischi rigidi tradizionali con unità SSD per gestire un numero maggiore di IOPS (operazioni di input/output al secondo). Per una gestione più efficiente dello storage, utilizzare sistemi di storage distribuiti e carichi di lavoro separati: ad esempio, storage ad alte prestazioni per i database e storage standard per i backup.

Queste strategie funzionano meglio se abbinate a un ambiente di hosting che supporta la scalabilità.

Utilizzare soluzioni di hosting scalabili

Una moderna infrastruttura di hosting è un componente chiave per risolvere e prevenire i colli di bottiglia. FDC Servers offre opzioni di hosting adatte alle sfide della scalabilità, come i server dedicati non misurati che eliminano le limitazioni della larghezza di banda e le soluzioni VPS alimentate da processori EPYC con storage NVMe per prestazioni di punta.

I loro piani di server dedicati, a partire da 129 dollari al mese, sono altamente personalizzabili. Grazie all'accesso root e alla possibilità di modificare l'hardware, è possibile risolvere i problemi di prestazioni senza essere vincolati a piani di hosting rigidi. Inoltre, la larghezza di banda non misurata garantisce che i colli di bottiglia della rete non vi rallentino.

Per i carichi di lavoro che richiedono una potenza di elaborazione avanzata, i server GPU (a partire da 1.124 dollari al mese) forniscono le risorse necessarie per l'intelligenza artificiale, l'apprendimento automatico e altre applicazioni intensive. Questi server sono inoltre dotati di larghezza di banda non misurata e di configurazioni personalizzabili per soddisfare esigenze specifiche.

Per affrontare la latenza della rete, la distribuzione globale è fondamentale. FDC Servers opera in oltre 70 sedi in tutto il mondo, consentendovi di distribuire i server più vicini ai vostri utenti per ottenere tempi di risposta più rapidi. I loro servizi CDN migliorano ulteriormente la distribuzione dei contenuti con punti di presenza globali ottimizzati.

Avete bisogno di risorse in fretta? La loro funzione di distribuzione istantanea vi permette di scalare rapidamente, evitando ritardi nel provisioning dell'hardware. Ciò è particolarmente utile per gestire improvvisi picchi di traffico o per risolvere problemi di prestazioni con breve preavviso.

L'integrazione di queste soluzioni di hosting può migliorare significativamente la vostra capacità di superare i colli di bottiglia e di prepararvi alla crescita futura.

Monitoraggio e revisione continui

Il monitoraggio continuo è essenziale per garantire che le soluzioni adottate rimangano efficaci nel tempo. Impostate avvisi automatici per le metriche chiave, come l'utilizzo della CPU superiore al 75%, l'utilizzo della memoria superiore all'85% o i tempi di risposta che superano le soglie accettabili.

Programmate revisioni mensili delle prestazioni per monitorare le tendenze e individuare i problemi emergenti. Tenete d'occhio le metriche di crescita e prevedete quando le risorse attuali potrebbero essere insufficienti. Pianificando gli aggiornamenti in modo proattivo, si possono evitare costosi interventi di emergenza che compromettono l'esperienza degli utenti.

Un altro passo fondamentale è rappresentato dai test di carico regolari. Testate il vostro sistema con i picchi di carico previsti e simulate improvvisi picchi di traffico per assicurarvi che le vostre soluzioni siano in grado di gestire le condizioni del mondo reale. Aumenti graduali del carico e stress test possono rivelare vulnerabilità nascoste prima che diventino problemi.

Infine, documentate tutti gli episodi di collo di bottiglia e la loro risoluzione. In questo modo si crea una preziosa base di conoscenze per il team, rendendo più facile affrontare problemi simili in futuro. Il monitoraggio dell'efficacia delle vostre soluzioni vi aiuterà inoltre a perfezionare le vostre strategie nel tempo, garantendo che la vostra infrastruttura rimanga solida in base all'evoluzione delle vostre esigenze.

Conclusione

Per affrontare in modo efficace i problemi di scalabilità, è necessario stabilire delle linee di base chiare e monitorare il sistema in modo costante. Iniziate a misurare metriche chiave come l'utilizzo della CPU, la memoria, l'I/O del disco e il throughput della rete per capire le prestazioni tipiche del vostro sistema. Questi benchmark vi aiuteranno a individuare le anomalie quando si presentano.

Sfruttate i dashboard in tempo reale e i dati storici per individuare e risolvere i problemi prima che interrompano l'esperienza degli utenti. Strumenti come i test di carico e l'analisi dei log sono preziosi per valutare le prestazioni sotto stress e identificare i punti deboli della vostra infrastruttura. I colli di bottiglia più comuni, come il sovraccarico della CPU, le perdite di memoria, i rallentamenti del database, la congestione della rete e le limitazioni dello storage, richiedono soluzioni specifiche e mirate.

Tuttavia, la correzione dei colli di bottiglia non è sufficiente da sola. La vera svolta sta nel monitoraggio proattivo e nell'infrastruttura scalabile. Un sistema progettato per adattarsi all'aumento della domanda garantisce un'affidabilità a lungo termine, evitando problemi ricorrenti. Le moderne opzioni di hosting, come FDC Servers, offrono soluzioni scalabili con un'implementazione rapida e una rete globale con oltre 70 sedi. Questa flessibilità vi permette di risolvere rapidamente i problemi di prestazioni senza dover aspettare un nuovo hardware.

Il segreto per scalare con successo è rimanere vigili. Impostate avvisi automatici, eseguite controlli regolari delle prestazioni e tenete un registro dettagliato dei colli di bottiglia passati per riferimenti futuri. Ricordate che lo scaling non è un'operazione una tantum, ma un processo continuo che si evolve insieme all'infrastruttura e alle esigenze degli utenti. Con la giusta combinazione di monitoraggio, strumenti e soluzioni di hosting scalabili, è possibile costruire un sistema che non solo soddisfi le esigenze di oggi, ma sia anche pronto per la crescita di domani.

Domande frequenti

Quali sono i modi migliori per risolvere i colli di bottiglia dei database quando si scalano i server?

Per risolvere i colli di bottiglia del database quando si scalano i server, iniziate a distribuire il traffico in modo più uniforme. Questo può essere fatto con strumenti come i bilanciatori di carico o i livelli di caching, che aiutano ad alleggerire la pressione sul database. Tenete d'occhio le metriche chiave utilizzando strumenti di monitoraggio: monitorate i tempi di risposta, i tassi di errore, l'utilizzo della CPU, la memoria, l'I/O del disco e l'attività di rete per identificare i problemi prima che si aggravino.

Per i problemi di storage e di prestazioni, prendete in considerazione soluzioni di scaling come lo scaling verticale (aggiornamento dell'hardware), lo scaling orizzontale (aggiunta di altri server) o lo sharding del database. È inoltre possibile migliorare l'efficienza ottimizzando le query del database e garantendo un'indicizzazione adeguata. Mantenendo un atteggiamento proattivo con il monitoraggio e la messa a punto, manterrete il vostro sistema in funzione senza problemi man mano che i vostri server crescono.

Come posso sapere se i problemi di prestazioni del mio server sono causati da limitazioni hardware o da un codice applicativo inefficiente?

Per capire se la lentezza delle prestazioni del vostro server è dovuta a limiti hardware o a un codice applicativo mal ottimizzato, iniziate a tenere d'occhio le principali metriche di sistema, come l'utilizzo della CPU, il consumo di memoria, l'I/O del disco e l'attività di rete. Se queste metriche sono costantemente al massimo, è un forte segnale che l'hardware potrebbe avere difficoltà a tenere il passo. Tuttavia, se le metriche dell'hardware sembrano a posto ma le applicazioni sono ancora in ritardo, il problema potrebbe essere nascosto nel codice.

Gli strumenti di monitoraggio delle prestazioni e i registri del server sono le risorse ideali per scavare più a fondo. Cercate indizi come query di database lente, loop inefficienti o processi che assorbono risorse. I test e la messa a punto di routine sono fondamentali per garantire che il server sia in grado di gestire la crescita e di funzionare senza problemi quando le richieste aumentano.

Quali sono i vantaggi degli strumenti di monitoraggio in tempo reale rispetto ai dati storici per la gestione della scalabilità dei server?

Gli strumenti di monitoraggio in tempo reale cambiano le carte in tavola quando si tratta di mantenere il funzionamento dei sistemi senza intoppi. Forniscono avvisi immediati e approfondimenti pratici, aiutandovi a risolvere i problemi nel momento stesso in cui si verificano. Questo tipo di feedback immediato è fondamentale per evitare intoppi nelle prestazioni durante la scalabilità dei server. Inoltre, garantisce un'allocazione efficiente delle risorse, fondamentale per gestire carichi di lavoro in continua evoluzione.

Nel frattempo, l'analisi dei dati storici brilla quando si tratta di individuare le tendenze a lungo termine o di capire le cause alla radice dei problemi passati. Ma c'è un problema: se ci si affida solo ai dati storici, si rischia di perdere la possibilità di agire rapidamente sui problemi attuali. Questo ritardo potrebbe portare a tempi di inattività o a colli di bottiglia nelle prestazioni. Sebbene entrambi i metodi abbiano il loro posto, il monitoraggio in tempo reale è indispensabile per apportare modifiche rapide e mantenere le prestazioni dei server al meglio in ambienti caratterizzati da ritmi elevati.

Come installare e utilizzare Redis su un VPS

Scoprite come installare e configurare Redis su un VPS per ottenere prestazioni, sicurezza e gestione ottimali nelle vostre applicazioni.

9 min di lettura - 7 gennaio 2026

Monitoraggio del server dedicato o del VPS, quali sono le opzioni nel 2025?

12 min di lettura - 28 novembre 2025

Avete domande o avete bisogno di una soluzione personalizzata?

Opzioni flessibili

Portata globale

Distribuzione immediata

Opzioni flessibili

Portata globale

Distribuzione immediata