Comment identifier les goulets d'étranglement dans la mise à l'échelle des serveurs ?

8 min de lecture - 22 septembre 2025

Apprenez à identifier et à corriger les goulets d'étranglement dans la mise à l'échelle des serveurs afin d'améliorer l'expérience des utilisateurs et d'optimiser l'utilisation des ressources.

Comment identifier les goulets d'étranglement dans la mise à l'échelle des serveurs ?

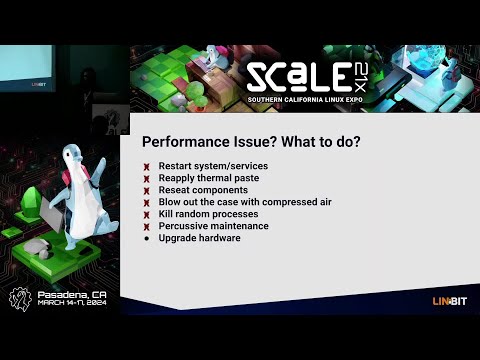

La mise à l'échelle des serveurs ne consiste pas seulement à ajouter des ressources, mais aussi à trouver et à corriger les goulets d'étranglement qui limitent les performances. Ces goulets d'étranglement peuvent entraîner des retards, des pannes et de mauvaises expériences pour les utilisateurs, même avec un matériel mis à niveau. Pour y remédier, il faut se concentrer sur les points suivants

- Les mesures de base: Mesurer l'utilisation de l'unité centrale, la mémoire, les entrées/sorties sur disque, le débit du réseau et les temps de réponse dans des conditions normales.

- Outils de surveillance: Utilisez des plateformes comme New Relic, Grafana et JMeter pour suivre les performances et simuler le trafic.

- Tests: Effectuez des tests de charge et de stress pour identifier les points de rupture.

- Analyse: Examinez les journaux, l'utilisation des ressources et les performances de la base de données pour repérer les inefficacités.

- Corrections: Optimiser le code, mettre à niveau le matériel (par exemple, les disques SSD) et mettre en œuvre une mise à l'échelle horizontale si nécessaire.

Diagnostiquer les goulets d'étranglement dans les systèmes de production

Établir des données de référence sur les performances

Il est essentiel de disposer de données de référence pour déterminer si les changements dans les performances du serveur sont des fluctuations de routine ou de véritables goulets d'étranglement. Les lignes de base constituent un point de référence qui permet de repérer plus facilement les écarts par rapport au comportement habituel du serveur.

Pour créer des bases de référence précises, rassemblez des données de performance qui reflètent des modèles de trafic quotidiens et hebdomadaires normaux.

Principales mesures à suivre

Il est essentiel de suivre les bonnes mesures pour identifier rapidement les problèmes de performances.

- Utilisation de l'unité centrale: Cette mesure indique la puissance de traitement utilisée par votre serveur à tout moment. Bien que les plages acceptables dépendent de votre configuration spécifique, le suivi de l'utilisation de l'UC peut révéler si votre système est surchargé ou sous-utilisé.

- Utilisation de la mémoire: Il s'agit de la quantité de mémoire vive consommée par vos applications. Une utilisation élevée et prolongée de la mémoire peut obliger le système à recourir à l'espace d'échange sur disque, plus lent, ce qui ralentit considérablement les performances.

- Mesures d'E/S sur disque: Elles mesurent l'efficacité avec laquelle votre système de stockage lit et écrit des données. Les principales mesures comprennent les IOPS (opérations d'entrée/sortie par seconde) et la latence du disque. Par exemple, les disques durs traditionnels atteignent généralement 100 à 200 IOPS avec une latence de 10 à 15 millisecondes, tandis que les disques SSD NVMe peuvent fournir des IOPS beaucoup plus élevés avec une latence inférieure à la milliseconde.

- Débit du réseau: Il mesure les taux de transfert de données en Mbps ou Gbps. Il est essentiel de surveiller la bande passante entrante et sortante, ainsi que les taux de perte de paquets. Une perte de paquets supérieure à 0,1 % indique souvent une congestion du réseau ou des problèmes matériels.

- Temps de réponse: Les temps de réponse reflètent la rapidité avec laquelle vos applications traitent les demandes. Pour les applications web, des temps de réponse de quelques centaines de millisecondes sont idéaux. Une étude de Google montre que les pages mobiles qui mettent trois secondes ou plus à se charger connaissent un taux d'abandon de 53 %.

- Mesures spécifiques à l'application: Elles varient en fonction de votre pile logicielle, mais peuvent inclure les temps d'interrogation de la base de données, les taux de réussite de la mémoire cache ou le nombre de connexions actives. Par exemple, des requêtes de base de données rapides et des taux d'accès au cache élevés sont essentiels pour maintenir des performances globales élevées.

Un contrôle régulier de ces mesures vous permet de résoudre les problèmes de performances avant qu'une mise à l'échelle ne devienne nécessaire.

Analyse comparative et enregistrement des données

Pour établir des références fiables, faites fonctionner vos serveurs sous des charges de production normales pendant au moins deux semaines. Enregistrez les données à intervalles réguliers - toutes les 5 à 10 minutes est un bon équilibre entre le détail et l'efficacité du stockage.

L'analyse comparative des charges de pointe est également importante. Mesurez les performances de votre système pendant les périodes de trafic les plus intenses afin d'anticiper les besoins futurs en matière d'évolutivité.

Lorsque vous documentez les données de référence, incluez les horodatages, les valeurs métriques et le contexte pertinent. Cet enregistrement détaillé vous aidera à comparer les performances avant et après les efforts de mise à l'échelle.

Lesmesures de disponibilité constituent un autre élément essentiel. Par exemple :

- Un temps de disponibilité de 99 % équivaut à environ 7 heures d'indisponibilité par mois.

- Un temps de disponibilité de 99,9 % réduit les temps d'arrêt à environ 45 minutes par mois.

- L'étalon-or, un temps de disponibilité de 99,999 % (Five Nines), ne permet que 30 secondes d'indisponibilité par mois.

Vous pouvez également envisager d'utiliser le score Apdex pour évaluer la satisfaction des utilisateurs en ce qui concerne les temps de réponse. Ce score va de 0 (mauvais) à 1 (excellent) en classant les temps de réponse en zones de satisfaction, de tolérance et de frustration. Un score supérieur à 0,85 indique généralement une expérience positive pour l'utilisateur.

Stockez vos données de référence dans un système centralisé pour faciliter l'accès et la comparaison. Les bases de données de séries chronologiques ou les plateformes de surveillance sont couramment utilisées pour conserver les données historiques, ce qui permet de déterminer plus facilement si les changements de performances sont dus à une mise à l'échelle ou à des problèmes sous-jacents du système.

Une fois ces données de base en place, vous êtes prêt à passer aux outils et techniques de surveillance des performances en temps réel.

Outils de surveillance et d'analyse

Les bons outils de surveillance peuvent transformer les données brutes en informations exploitables et vous aider à détecter les goulets d'étranglement avant qu'ils ne perturbent l'expérience des utilisateurs. Grâce à diverses fonctionnalités telles que les alertes en temps réel et l'analyse approfondie des performances, il est essentiel de choisir les bons outils pour identifier et résoudre les problèmes de manière efficace.

Outils de surveillance de base

Lesplateformes de surveillance des performances des applications (APM) telles que New Relic sont indispensables pour suivre les métriques des applications et les expériences des utilisateurs. Ces outils capturent automatiquement des données clés telles que les temps de réponse, les taux d'erreur et les traces de transactions. Des fonctionnalités telles que le traçage distribué facilitent la localisation des requêtes de base de données lentes ou des appels d'API paresseux.

Grafana est un outil de visualisation polyvalent qui s'intègre à de multiples sources de données. Associé à des bases de données de séries temporelles comme Prometheus ou InfluxDB, Grafana excelle dans la création de tableaux de bord qui relient les métriques - par exemple en corrélant les pics de CPU avec des temps de réponse plus lents - ce qui permet de repérer plus facilement les problèmes de performance d'un seul coup d'œil.

Apache JMeter est un outil de test de charge qui simule activement le trafic des utilisateurs afin de mesurer la façon dont les systèmes gèrent les utilisateurs simultanés. En générant du trafic et en testant le débit du serveur dans diverses conditions, JMeter permet d'identifier les points de rupture et les limitations de ressources avant qu'ils n'aient un impact sur les environnements de production.

La pile ELK (Elasticsearch, Logstash et Kibana) se concentre sur l'analyse des journaux et les capacités de recherche. Logstash recueille et traite les données des journaux, Elasticsearch les rend consultables et Kibana visualise les résultats. Cette combinaison est idéale pour identifier les schémas d'erreur, suivre la fréquence des événements et relier les journaux aux baisses de performance.

Lesoutils de surveillance au niveau du système tels que Nagios, Zabbix et Datadog offrent une vue d'ensemble des mesures de l'infrastructure. Ces plateformes surveillent les données matérielles critiques telles que l'utilisation de l'unité centrale, la consommation de mémoire, les entrées/sorties de disque et le trafic réseau, ce qui les rend essentielles pour détecter les goulets d'étranglement liés au matériel et planifier les mises à niveau de capacité.

Lesoutils de surveillance des bases de données, tels que pgAdmin pour PostgreSQL ou MySQL Enterprise Monitor, offrent des informations spécialisées sur les performances des bases de données. Ces outils suivent des paramètres tels que les temps d'exécution des requêtes, la contention des verrous et l'utilisation du pool de mémoire tampon - des détails que les moniteurs généraux peuvent négliger mais qui sont cruciaux pour optimiser les performances des bases de données.

Chaque type d'outil a sa propre fonction : les outils APM se concentrent sur les performances des applications, les moniteurs système gèrent les mesures matérielles et les outils de base de données se spécialisent dans le stockage et l'analyse des requêtes. De nombreuses entreprises utilisent une combinaison de ces outils pour couvrir l'ensemble de leur pile technologique, ce qui permet de résoudre immédiatement les problèmes et d'optimiser les performances à long terme.

Données en temps réel et données historiques

Lasurveillance en temps réel offre une visibilité immédiate sur les performances du système, ce qui permet aux équipes de réagir rapidement aux problèmes émergents. Les tableaux de bord sont actualisés toutes les quelques secondes et affichent des mesures en temps réel telles que l'utilisation du processeur, les connexions actives et les temps de réponse. Ces données sont essentielles pour détecter les hausses soudaines de trafic, les fuites de mémoire ou les composants défaillants avant qu'ils ne se transforment en problèmes plus importants.

Des alertes en temps réel sont déclenchées lorsque les mesures franchissent des seuils prédéfinis, par exemple lorsque l'utilisation de l'unité centrale dépasse 80 % ou que les temps de réponse dépassent 2 secondes. Ces alertes permettent aux équipes de résoudre les problèmes en quelques minutes, minimisant ainsi les temps d'arrêt.

L'analyse des données historiques, quant à elle, permet de découvrir des tendances à long terme et des schémas récurrents que la surveillance en temps réel pourrait laisser de côté. En examinant les données sur plusieurs semaines ou mois, les équipes peuvent identifier les fluctuations saisonnières du trafic, les baisses progressives de performance ou les goulets d'étranglement récurrents. Par exemple, une augmentation de 15 % des temps d'interrogation des bases de données sur trois mois peut être le signe d'un volume de données croissant ou de requêtes inefficaces qui doivent être optimisées.

L'analyse historique permet également de planifier les capacités. Les tendances telles que l'augmentation de l'utilisation de la mémoire ou l'escalade des volumes de trafic permettent de prévoir le moment où les ressources atteindront leurs limites, ce qui permet une mise à l'échelle ou des mises à niveau proactives.

En combinant ces deux approches, on obtient une stratégie de surveillance bien équilibrée. Les données en temps réel fournissent un retour d'information immédiat pour la gestion des crises, tandis que l'analyse historique permet de prendre des décisions stratégiques pour prévenir les problèmes futurs. De nombreux outils modernes intègrent ces deux approches de manière transparente, offrant des tableaux de bord en temps réel parallèlement au stockage des données historiques, de sorte que les équipes peuvent passer sans effort du dépannage à court terme à la planification à long terme.

Les meilleurs résultats sont obtenus lorsque les équipes examinent régulièrement les alertes en temps réel pour répondre aux préoccupations immédiates et analysent les tendances historiques pour prendre des décisions plus intelligentes en matière de mise à l'échelle et d'optimisation. Cette double approche garantit l'efficacité et la résilience des systèmes au fil du temps.

Comment identifier les goulets d'étranglement, étape par étape ?

Une fois que vous avez établi des mesures de référence et mis en place des outils de surveillance, l'étape suivante consiste à repérer les goulets d'étranglement. Il s'agit de tester, de surveiller et d'analyser systématiquement votre système sous charge afin d'identifier l'origine des problèmes de performance.

Tests de charge et de stress

Les tests de charge vous permettent d'évaluer les performances de votre système face à une demande typique de la part des utilisateurs. Commencez par définir vos objectifs de performance, tels que les temps de réponse acceptables, les objectifs de débit et les seuils de taux d'erreur. Ces objectifs servent de points de référence pour repérer les écarts. Des outils tels que JMeter ou Gatling permettent de simuler le trafic et d'augmenter progressivement la charge jusqu'à ce que les performances commencent à se dégrader.

Les tests de stress, quant à eux, poussent le système au-delà de ses limites normales pour révéler les points de rupture. Pendant les deux tests, gardez un œil sur les mesures telles que l'utilisation de l'unité centrale, la consommation de mémoire et la bande passante du réseau. Par exemple, une utilisation de l'unité centrale proche de 100 %, des pics de mémoire ou une bande passante saturée correspondent souvent à des temps de réponse plus lents ou à des taux d'erreur plus élevés.

La surveillance des utilisateurs réels (RUM) peut compléter ces tests synthétiques en fournissant des données sur les expériences réelles des utilisateurs. Cela permet de découvrir des goulets d'étranglement que les tests contrôlés risquent de ne pas voir.

L'étape suivante consiste à analyser l'utilisation des ressources pour identifier les causes profondes des problèmes de performance.

Analyse des ressources

Comparez les données d'utilisation des ressources à vos mesures de référence pour découvrir les contraintes cachées. Voici ce qu'il faut rechercher :

- CPU : Les goulets d'étranglement apparaissent souvent lorsque l'utilisation dépasse régulièrement 80 % ou qu'elle connaît des pics inattendus.

- Mémoire : Une utilisation élevée ou irrégulière peut indiquer des fuites de mémoire ou des inefficacités.

- E/S disque : Surveillez l'utilisation élevée ou les longs temps d'attente, qui peuvent ralentir les opérations.

- Réseau : Vérifiez l'utilisation de la bande passante et la latence pour identifier les réponses d'API lentes ou les dépassements de délai.

- Performances de la base de données : Utilisez des outils tels que MySQL Workbench ou SQL Profiler pour analyser les temps d'exécution des requêtes, l'indexation et le verrouillage des transactions. Les requêtes qui prennent plus de 100 millisecondes peuvent indiquer des opérations inefficaces, comme le traitement ligne par ligne (RBAR), qui doivent être optimisées.

Analyse des journaux et des traces

Les journaux et les traces fournissent des informations essentielles lorsqu'ils sont combinés à des mesures de référence et en temps réel. Les journaux peuvent mettre en évidence des erreurs récurrentes, des dépassements de délai ou des avertissements relatifs aux ressources qui signalent des goulets d'étranglement. Par exemple, les messages de dépassement de délai ou les erreurs liées aux limites de ressources pointent souvent directement vers les zones problématiques.

Les outils de traçage distribués comme OpenTelemetry avec Jaeger vous permettent de suivre le parcours d'une requête à travers les microservices, révélant les retards causés par des requêtes de base de données lentes, des dépassements de délai d'API ou des dépendances de service problématiques. Une instrumentation détaillée, telle que l'enregistrement des heures de début et de fin des opérations, peut aider à identifier les sections de code qui consomment des ressources excessives. De même, les journaux des requêtes de base de données peuvent révéler des inefficacités telles que les opérations RBAR.

La contention des threads est un autre domaine qui mérite d'être examiné. L'analyse des vidages de threads peut révéler des blocages, des interruptions de threads ou des changements de contexte excessifs, autant d'éléments qui peuvent nuire aux performances. La capture d'instantanés de trace de pile pendant les pics de performance peut permettre d'identifier plus précisément les chemins de code à l'origine des retards.

Entre mars et novembre 2020, l'utilisation de Miro a été multipliée par sept, atteignant plus de 600 000 utilisateurs uniques par jour. Pour remédier aux goulets d'étranglement des serveurs pendant cette montée en charge rapide, l'équipe système de Miro s'est concentrée sur la surveillance du temps médian d'achèvement des tâches (percentile) plutôt que sur les moyennes ou les tailles de file d'attente. Cette approche a permis d'optimiser les processus qui affectaient la majorité des utilisateurs.

Sources communes de goulots d'étranglement et leurs effets

Il est essentiel de comprendre les goulets d'étranglement pour cibler les efforts de surveillance et accélérer les temps de réponse. Les différents goulets d'étranglement laissent des traces distinctes, ce qui peut vous aider à localiser et à résoudre les problèmes de manière efficace.

Voici une analyse des sources de goulots d'étranglement les plus fréquentes, de leurs signes avant-coureurs, des méthodes de détection et de la manière dont elles limitent l'évolutivité :

Approfondir les goulets d'étranglement

Lesgoulets d'étranglement de l'unité centrale se produisent le plus souvent lors de pics de trafic. Lorsque l'utilisation de l'unité centrale dépasse 80 %, le système commence à mettre les demandes en file d'attente, ce qui entraîne des retards et des dépassements de délai. À ce stade, la mise à l'échelle horizontale devient souvent la seule solution viable.

Les problèmes de mémoire ont tendance à rester silencieux jusqu'à ce que l'utilisation de la RAM atteigne des niveaux critiques. Dans ce cas, les applications peuvent se bloquer ou ralentir considérablement en raison de la surcharge de la collecte des ordures, ce qui oblige à des mises à niveau coûteuses ou à des efforts d'optimisation.

Lesgoulets d'étranglement dans les bases de données sont un problème courant dans les applications web évolutives. Des symptômes tels que les délais d'attente des requêtes et l'épuisement des pools de connexion peuvent paralyser les performances, nécessitant souvent la mise en cluster des bases de données ou l'ajout de répliques de lecture pour répartir la charge.

Lescontraintes liées au réseau apparaissent généralement lorsqu'il s'agit de fichiers volumineux ou d'appels d'API fréquents. Une latence élevée ou une perte de paquets, en particulier entre différentes régions, indique souvent la nécessité de recourir à des réseaux de diffusion de contenu (CDN) ou à d'autres stratégies de distribution.

Lesgoulets d'étranglement au niveau du stockage apparaissent lorsque les demandes de données augmentent. Les disques traditionnels avec une IOPS limitée peuvent ralentir les opérations de fichiers et les écritures dans les bases de données, ce qui rend les disques SSD ou les architectures de stockage distribuées essentiels pour maintenir les performances.

Lesgoulots d'étranglement du code d'application sont uniques car ils proviennent d'inefficacités dans la conception ou la mise en œuvre, telles que les fuites de mémoire ou les mauvaises stratégies de mise en cache. La résolution de ces problèmes nécessite souvent un profilage approfondi, une refonte ou même un remaniement de l'architecture pour gérer les demandes de mise à l'échelle.

S'attaquer aux goulets d'étranglement pour une meilleure évolutivité

Les goulets d'étranglement matériels tels que l'unité centrale et la mémoire peuvent parfois être atténués par une mise à l'échelle verticale, mais cette approche a ses limites. En fin de compte, la mise à l'échelle horizontale devient inévitable. Par ailleurs, les goulets d'étranglement au niveau de la base de données et du code de l'application nécessitent généralement un travail d'optimisation avant que des ressources supplémentaires puissent être pleinement efficaces.

Corriger les goulets d'étranglement pour une meilleure mise à l'échelle

Une fois les goulets d'étranglement identifiés, l'étape suivante consiste à s'y attaquer efficacement. L'objectif est de s'attaquer aux causes profondes plutôt qu'aux symptômes, afin de s'assurer que votre infrastructure pourra supporter la croissance future sans rencontrer les mêmes problèmes.

Résoudre les goulets d'étranglement identifiés

Goulets d'étranglement au niveau de l'unité centrale : Si l'utilisation de l'unité centrale dépasse régulièrement 80 %, il est temps d'agir. Commencez par optimiser votre code - rationalisez les algorithmes inefficaces et réduisez les opérations gourmandes en ressources. Si la mise à niveau de votre matériel (mise à l'échelle verticale) peut apporter un soulagement immédiat, ce n'est qu'une solution temporaire. Pour une évolutivité à long terme, mettez en œuvre l'équilibrage des charges et l'évolutivité horizontale afin de répartir les charges de travail sur plusieurs serveurs, car un seul serveur finira par atteindre ses limites.

Problèmes de mémoire : Utilisez des outils de profilage pour détecter les fuites de mémoire et optimiser la façon dont votre application alloue la mémoire. La mise à niveau de votre mémoire vive est une bonne solution à court terme, mais pour une meilleure évolutivité, envisagez de concevoir des applications sans état. Celles-ci répartissent les charges de mémoire entre plusieurs instances, ce qui rend votre système plus résistant.

Goulots d'étranglement de la base de données : Les requêtes lentes sont souvent en cause. Optimisez-les et ajoutez des index appropriés pour accélérer les choses. D'autres stratégies consistent à utiliser le pooling de connexions, à mettre en place des répliques de lecture pour répartir les charges de requête et à diviser les bases de données pour les applications à forte densité d'écriture. La mise à niveau vers des disques SSD NVMe peut également améliorer considérablement les performances.

Contraintes de réseau : Si votre réseau est en difficulté, envisagez d'améliorer votre bande passante et d'utiliser des CDN pour réduire la distance que les données doivent parcourir. Compressez les réponses et réduisez la taille des données utiles pour rendre les transferts de données plus efficaces. Pour les publics internationaux, le déploiement de serveurs sur plusieurs sites géographiques peut contribuer à réduire les temps de latence.

Goulets d'étranglement au niveau du stockage : Remplacez les disques durs traditionnels par des disques SSD pour gérer des IOPS (opérations d'entrée/sortie par seconde) plus élevées. Pour une gestion plus efficace du stockage, utilisez des systèmes de stockage distribués et séparez les charges de travail - par exemple, un stockage haute performance pour les bases de données et un stockage standard pour les sauvegardes.

Ces stratégies fonctionnent mieux lorsqu'elles sont associées à un environnement d'hébergement qui prend en charge l'évolutivité.

Utiliser des solutions d'hébergement évolutives

Une infrastructure d'hébergement moderne est un élément clé pour résoudre et prévenir les goulots d'étranglement. FDC Servers propose des options d'hébergement adaptées aux défis de l'évolutivité, telles que des serveurs dédiés sans compteur qui éliminent les limitations de bande passante et des solutions VPS alimentées par des processeurs EPYC avec un stockage NVMe pour des performances de pointe.

Leurs plans de serveurs dédiés, à partir de 129 $/mois, sont hautement personnalisables. Grâce à l'accès root et à la possibilité de modifier le matériel, vous pouvez résoudre les problèmes de performance sans être enfermé dans des plans d'hébergement rigides. De plus, la bande passante sans compteur garantit que les goulots d'étranglement du réseau ne vous ralentiront pas.

Pour les charges de travail nécessitant une puissance de traitement avancée, les serveurs GPU (à partir de 1 124 $/mois) fournissent les ressources nécessaires à l'IA, à l'apprentissage automatique et à d'autres applications intensives. Ces serveurs s'accompagnent également d'une bande passante sans compteur et de configurations personnalisables pour répondre à des demandes spécifiques.

Pour s'attaquer à la latence du réseau, la distribution mondiale est essentielle. FDC Servers opère dans plus de 70 sites à travers le monde, ce qui vous permet de déployer des serveurs plus proches de vos utilisateurs pour des temps de réponse plus rapides. Leurs services CDN améliorent encore la diffusion de contenu grâce à des points de présence optimisés à l'échelle mondiale.

Besoin de ressources rapidement ? Leur fonction de déploiement instantané vous permet de monter en puissance rapidement, en évitant les retards dans le provisionnement du matériel. Cette fonction est particulièrement utile pour gérer les hausses soudaines de trafic ou résoudre les problèmes de performance dans les plus brefs délais.

L'intégration de ces solutions d'hébergement peut améliorer considérablement votre capacité à surmonter les goulets d'étranglement et à vous préparer à la croissance future.

Surveillance et examen continus

Une surveillance continue est essentielle pour s'assurer que vos solutions restent efficaces au fil du temps. Mettez en place des alertes automatiques pour les mesures clés, telles que l'utilisation de l'unité centrale dépassant 75 %, l'utilisation de la mémoire supérieure à 85 % ou les temps de réponse qui dépassent les seuils acceptables.

Planifiez des examens mensuels des performances afin de suivre les tendances et de repérer les problèmes émergents. Gardez un œil sur les indicateurs de croissance et anticipez le moment où vos ressources actuelles risquent d'être insuffisantes. En planifiant les mises à niveau de manière proactive, vous éviterez les réparations d'urgence coûteuses qui perturbent l'expérience des utilisateurs.

Des tests de charge réguliers constituent une autre étape cruciale. Testez votre système en fonction des pics de charge prévus et simulez des pics de trafic soudains pour vous assurer que vos correctifs peuvent faire face aux conditions réelles. L'augmentation progressive de la charge et les tests de résistance peuvent révéler des vulnérabilités cachées avant qu'elles ne deviennent des problèmes.

Enfin, documentez chaque incident de goulot d'étranglement et sa résolution. Vous créerez ainsi une base de connaissances précieuse pour votre équipe, ce qui facilitera la résolution de problèmes similaires à l'avenir. Le suivi de l'efficacité de vos solutions vous aidera également à affiner vos stratégies au fil du temps, garantissant ainsi la robustesse de votre infrastructure au fur et à mesure de l'évolution de vos besoins.

Conclusion

Pour relever efficacement les défis liés à la mise à l'échelle, commencez par établir des bases de référence claires et par surveiller votre système en permanence. Commencez par mesurer des paramètres clés tels que l'utilisation de l'unité centrale, la mémoire, les entrées/sorties de disque et le débit du réseau afin de comprendre les performances habituelles de votre système. Ces points de référence vous aideront à repérer les anomalies lorsqu'elles surviennent.

Exploitez les tableaux de bord en temps réel et les données historiques pour détecter et résoudre les problèmes avant qu'ils ne perturbent l'expérience des utilisateurs. Des outils tels que les tests de charge et l'analyse des journaux sont inestimables pour évaluer les performances sous contrainte et identifier les points faibles de votre infrastructure. Les goulets d'étranglement courants tels que la surcharge de l'unité centrale, les fuites de mémoire, les ralentissements des bases de données, la congestion du réseau et les limites du stockage requièrent des solutions spécifiques et ciblées.

Toutefois, la correction des goulets d'étranglement n'est pas suffisante en soi. Ce qui change vraiment la donne, c'est la surveillance proactive et l'évolutivité de l'infrastructure. Un système conçu pour s'adapter à une demande croissante garantit une fiabilité à long terme, évitant ainsi les problèmes récurrents. Les options d'hébergement modernes, telles que FDC Servers, offrent des solutions évolutives avec un déploiement rapide et un réseau mondial couvrant plus de 70 sites. Cette flexibilité vous permet de résoudre rapidement les problèmes de performance sans attendre un nouveau matériel.

Le secret d'une mise à l'échelle réussie est de rester vigilant. Mettez en place des alertes automatisées, effectuez des contrôles de performance réguliers et conservez des enregistrements détaillés des goulets d'étranglement antérieurs pour référence ultérieure. N'oubliez pas que la mise à l'échelle n'est pas une tâche ponctuelle - c'est un processus continu qui évolue en même temps que votre infrastructure et les besoins des utilisateurs. Avec la bonne combinaison de surveillance, d'outils et de solutions d'hébergement évolutives, vous pouvez construire un système qui non seulement répond aux demandes d'aujourd'hui, mais qui est également prêt pour la croissance de demain.

FAQ

Quelles sont les meilleures façons de résoudre les goulots d'étranglement des bases de données lors de la mise à l'échelle des serveurs ?

Pour résoudre les goulets d'étranglement des bases de données lors de la mise à l'échelle des serveurs, commencez par répartir le trafic de manière plus homogène. Pour ce faire, vous pouvez utiliser des outils tels que des équilibreurs de charge ou des couches de mise en cache, qui permettent d'alléger la pression exercée sur votre base de données. Surveillez de près les mesures clés à l'aide d'outils de surveillance - suivez des éléments tels que les temps de réponse, les taux d'erreur, l'utilisation de l'unité centrale, la mémoire, les entrées/sorties de disque et l'activité du réseau afin d'identifier les problèmes avant qu'ils ne s'aggravent.

En cas de problèmes de stockage et de performances, envisagez des solutions d'extension telles que l'extension verticale (mise à niveau du matériel), l'extension horizontale (ajout de serveurs) ou le partage de la base de données. Vous pouvez également améliorer l'efficacité en optimisant les requêtes de base de données et en veillant à ce que l'indexation soit correcte. En restant proactif en matière de surveillance et d'ajustement, vous assurerez le bon fonctionnement de votre système au fur et à mesure de la croissance de vos serveurs.

Comment puis-je savoir si les problèmes de performance de mon serveur sont dus à des limitations matérielles ou à un code d'application inefficace ?

Pour déterminer si les performances médiocres de votre serveur sont dues à des limites matérielles ou à un code d'application mal optimisé, commencez par surveiller les principales mesures du système, telles que l'utilisation de l'unité centrale, la consommation de mémoire, les entrées/sorties de disque et l'activité du réseau. Si ces paramètres sont constamment au maximum, c'est un signe fort que votre matériel a peut-être du mal à suivre. En revanche, si les mesures matérielles semblent correctes mais que les applications sont toujours à la traîne, le problème peut être enfoui dans le code.

Les outils de surveillance des performances et les journaux des serveurs sont vos ressources de prédilection pour approfondir la question. Recherchez des indices tels que des requêtes de base de données lentes, des boucles inefficaces ou des processus qui accaparent les ressources. Les tests et les réglages de routine sont essentiels pour garantir que votre serveur peut gérer la croissance et fonctionner sans heurts lorsque les demandes augmentent.

Quels sont les avantages des outils de surveillance en temps réel par rapport à l'utilisation de données historiques pour gérer l'évolutivité des serveurs ?

Les outils de surveillance en temps réel changent la donne lorsqu'il s'agit d'assurer le bon fonctionnement des systèmes. Ils fournissent des alertes instantanées et des informations exploitables, ce qui vous aide à résoudre les problèmes au fur et à mesure qu'ils surviennent. Ce type de retour d'information immédiat est essentiel pour éviter les problèmes de performances lors de la montée en charge des serveurs. En outre, il garantit que vos ressources sont allouées efficacement, ce qui est essentiel pour gérer des charges de travail en constante évolution.

Par ailleurs, l'analyse des données historiques permet de repérer les tendances à long terme ou de découvrir les causes profondes de problèmes antérieurs. Mais il y a un hic : si vous ne vous fiez qu'aux données historiques, vous risquez de ne pas pouvoir agir rapidement sur les problèmes actuels. Ce retard pourrait entraîner des temps d'arrêt ou des goulets d'étranglement au niveau des performances. Si les deux méthodes ont leur place, la surveillance en temps réel est indispensable pour procéder à des ajustements rapides et maintenir les serveurs à leur meilleur niveau dans des environnements en constante évolution.

Comment installer et utiliser Redis sur un VPS

Apprenez à installer et à configurer Redis sur un VPS pour optimiser les performances, la sécurité et la gestion de vos applications.

9 min de lecture - 7 janvier 2026

Surveiller son serveur dédié ou son VPS, quelles sont les options en 2025 ?

12 min de lecture - 28 novembre 2025