Charges de travail AI dans les environnements virtualisés GPU : Guide d'optimisation

11 min de lecture - 10 octobre 2025

- Charges de travail AI dans les environnements virtualisés GPU : Guide d'optimisation

- Principes de base de la virtualisation du GPU pour l'IA

- Infrastructure AI/ML : Le GPU à découpage temporel expliqué

- Exigences en matière de matériel et d'infrastructure

- Configuration de la machine virtuelle et du GPU

- Surveillance des performances et planification

- Serveurs FDC pour l'infrastructure d'IA

- Conclusion

- FAQ

Découvrez comment la virtualisation du GPU améliore les charges de travail de l'IA en améliorant l'efficacité, en réduisant les coûts et en optimisant la gestion des ressources dans les environnements virtualisés.

- Charges de travail AI dans les environnements virtualisés GPU : Guide d'optimisation

- Principes de base de la virtualisation du GPU pour l'IA

- Infrastructure AI/ML : Le GPU à découpage temporel expliqué

- Exigences en matière de matériel et d'infrastructure

- Configuration de la machine virtuelle et du GPU

- Surveillance des performances et planification

- Serveurs FDC pour l'infrastructure d'IA

- Conclusion

- FAQ

Charges de travail AI dans les environnements virtualisés GPU : Guide d'optimisation

Lavirtualisation des GPU transforme la façon dont les charges de travail d'IA sont gérées. En divisant un GPU physique en plusieurs instances virtuelles, vous pouvez exécuter plusieurs tâches d'IA simultanément, améliorant ainsi l'efficacité et réduisant les coûts du matériel. Cette approche est particulièrement utile pour l'entraînement de modèles complexes, la gestion de tâches gourmandes en ressources et la mise à l'échelle de projets d'IA sans investir dans des GPU supplémentaires.

Voici pourquoi elle est importante :

- Utilisation efficace des GPU: Évitez le matériel inutilisé en partageant les ressources entre les tâches et les équipes.

- Réduction des coûts: Les GPU haute performance sont coûteux ; la virtualisation garantit une utilisation maximale.

- Flexibilité: Adaptez les instances virtuelles de GPU à des besoins spécifiques, tels que la taille de la mémoire ou les versions CUDA.

- Évolutivité: Ajustez dynamiquement les ressources en fonction de la croissance des charges de travail d'IA.

- Fiabilité: Les instances isolées permettent d'éviter qu'une tâche n'affecte les autres.

Pour optimiser les performances :

- Choisissez des GPU dotés d'une mémoire et d'une bande passante élevées (par exemple, NVIDIA A100/H100).

- Utilisez un stockage NVMe et des réseaux à faible latence pour le traitement des données.

- Configurez les machines virtuelles avec le GPU passthrough ou le partitionnement vGPU en fonction des besoins de la charge de travail.

- Exploiter des outils tels que NVIDIA GPU Operator, les plugins Kubernetes et SLURM pour l'orchestration.

- Surveillez les performances avec des outils comme NVIDIA Nsight Systems et DCGM pour identifier les goulots d'étranglement.

Des services d'hébergement comme FDC Servers proposent des solutions GPU sur mesure à partir de 1 124 $/mois, y compris une bande passante sans compteur et des options de déploiement mondial pour les projets d'IA à grande échelle.

À retenir: La virtualisation du GPU rationalise la gestion des ressources, augmente les performances et réduit les coûts pour les charges de travail d'IA, ce qui en fait une solution pratique pour développer efficacement les opérations d'IA.

Principes de base de la virtualisation du GPU pour l'IA

Qu'est-ce que la virtualisation du GPU ?

La virtualisation du GPU permet à plusieurs utilisateurs de partager un seul GPU en créant des instances virtuelles, chacune ayant sa propre mémoire, ses propres cœurs et sa propre puissance de traitement. Cela signifie qu'un seul GPU peut gérer plusieurs tâches ou utilisateurs en même temps, ce qui en fait une solution efficace pour les charges de travail d'IA.

Au cœur de cette technologie se trouve un hyperviseur, qui agit comme un gestionnaire et répartit les ressources GPU entre les machines virtuelles. L'hyperviseur veille à ce que chaque instance reçoive la part qui lui est attribuée sans interférence de la part des autres. Pour les tâches d'IA, cela permet à un seul GPU NVIDIA A100 ou H100 d'exécuter simultanément plusieurs expériences d'apprentissage automatique, des sessions de formation ou des opérations d'inférence.

Il existe deux méthodes principales pour partager ces ressources :

- La virtualisation au niveau du matériel: La technologie MIG (Multi-Instance GPU) de NVIDIA divise physiquement le GPU en sections isolées, ce qui garantit une forte séparation entre les instances.

- La virtualisation au niveau logiciel: Cette méthode utilise des pilotes et des logiciels pour diviser les ressources GPU, ce qui offre plus de flexibilité mais un peu moins d'isolation.

L'une des principales différences entre la virtualisation des GPU et la virtualisation traditionnelle des CPU réside dans la gestion de la mémoire. Les GPU utilisent une mémoire à large bande passante (HBM), qui fonctionne différemment de la RAM standard du système. Il est essentiel de gérer efficacement cette mémoire, en particulier lors d'opérations d'intelligence artificielle gourmandes en ressources, telles que le réglage fin ou l'entraînement à grande échelle.

Cette compréhension fondamentale ouvre la voie à l'exploration de la manière dont la virtualisation des GPU améliore les performances de l'IA dans des scénarios pratiques.

Avantages pour les charges de travail d'IA et d'apprentissage automatique

La virtualisation offre une série d'avantages qui répondent directement aux défis posés par les charges de travail d'IA et d'apprentissage automatique (ML).

L'optimisation de l'utilisation des GPU est l'un des principaux avantages. Les GPU haute performance, qui peuvent coûter entre 10 000 et 30 000 dollars, sont souvent sous-utilisés lors de tâches telles que le prétraitement des données ou la configuration des modèles. La virtualisation garantit que ces ressources coûteuses sont pleinement utilisées en permettant à plusieurs tâches de partager le même GPU, ce qui réduit les temps d'inactivité et les coûts de matériel. Cette approche permet aux entreprises de servir davantage d'utilisateurs et d'applications sans avoir besoin de GPU physiques supplémentaires.

La flexibilité du développement change également la donne. Grâce à la virtualisation, les développeurs peuvent créer des instances de GPU virtuelles adaptées à des besoins spécifiques, tels que différentes versions de CUDA, tailles de mémoire ou configurations de pilotes. Cette isolation garantit que les projets utilisant des frameworks tels que PyTorch, TensorFlow ou JAX peuvent coexister sans conflits, rationalisant ainsi les flux de travail et accélérant l'innovation.

L'évolutivité devient beaucoup plus facile à gérer. Les charges de travail de l'IA peuvent varier considérablement dans leurs exigences. Par exemple, l'entraînement d'un petit réseau neuronal peut nécessiter des ressources minimales, tandis que le réglage fin d'un grand modèle de langage exige une puissance de calcul massive. Les instances virtuelles peuvent augmenter ou diminuer dynamiquement, en allouant des ressources en fonction de l'intensité de la charge de travail. Cette adaptabilité garantit une utilisation efficace des ressources à tout moment.

La prise en charge de la multi-location est particulièrement précieuse pour les organisations dont les besoins sont diversifiés. En partageant l'infrastructure, différents départements, clients ou applications peuvent accéder aux ressources GPU sans avoir à gérer le matériel physique. Les fournisseurs de cloud computing peuvent même proposer le GPU-as-a-Service, permettant aux utilisateurs d'accéder à des instances de GPU virtuelles tout en maintenant l'isolation des performances et en réduisant la complexité administrative.

Enfin, l'isolation des pannes garantit la stabilité. Si une instance virtuelle tombe en panne ou consomme des ressources excessives, les autres instances partageant le même GPU ne seront pas perturbées. Cette fiabilité est essentielle dans les environnements de production où plusieurs services d'intelligence artificielle doivent fonctionner de manière fluide et cohérente.

La virtualisation des GPU permet non seulement d'optimiser l'utilisation des ressources, mais aussi de doter les équipes d'IA des outils et de la flexibilité nécessaires pour faire face à des charges de travail complexes et en constante évolution.

Infrastructure AI/ML : Le GPU à découpage temporel expliqué

Exigences en matière de matériel et d'infrastructure

L'obtention des meilleures performances d'IA dans les environnements GPU virtualisés dépend fortement des bons choix en matière de matériel et d'interconnexion. Ces décisions jouent un rôle clé dans l'optimisation du potentiel de la virtualisation du GPU pour les charges de travail d'IA.

Choisir la bonne architecture GPU

Lors de la sélection des GPU pour les tâches d'IA, il convient de rechercher des modèles dotés d'une grande capacité de mémoire, d'une bande passante rapide et d'une prise en charge intégrée de la virtualisation. De nombreux GPU modernes peuvent être divisés en plusieurs instances isolées, ce qui permet à différents utilisateurs ou applications de disposer de ressources de calcul et de mémoire dédiées. Mais le choix du bon GPU n'est qu'une partie de l'équation - votre infrastructure de stockage et de réseau doit également être en mesure de suivre ses performances.

Exigences en matière de stockage et de réseau

Les charges de travail d'IA impliquent souvent la gestion de quantités massives de données, ce qui rend le stockage NVMe à grande vitesse et les réseaux à faible latence essentiels. Dans les environnements d'entreprise, les disques NVMe dotés d'une forte endurance sont idéaux pour gérer les cycles de lecture/écriture lourds qui accompagnent les applications d'IA.

Pour les échanges de données entre les nœuds, des technologies comme InfiniBand ou des solutions Ethernet avancées fournissent la bande passante nécessaire pour des opérations fluides. L'utilisation d'un système de fichiers distribués pour permettre des E/S parallèles peut contribuer à minimiser les goulets d'étranglement lorsque plusieurs processus accèdent aux données en même temps. Une fois les besoins en stockage et en réseau satisfaits, l'étape suivante consiste à affiner l'alignement des ressources.

Alignement des ressources et optimisation de la topologie

Pour optimiser l'alignement des ressources, configurez NUMA (Non-Uniform Memory Access) afin de garantir des connexions directes entre les GPU, la mémoire et les CPU. Attribuez des interfaces réseau à haut débit et dédiez des voies PCIe pour réduire la latence. Gardez à l'esprit qu'un refroidissement robuste et une capacité d'alimentation suffisante sont essentiels pour éviter l'étranglement thermique et maintenir la stabilité du système. En outre, le fait de positionner le stockage à proximité des unités de traitement peut réduire davantage la latence, créant ainsi une architecture système plus efficace et plus réactive.

Configuration de la machine virtuelle et du GPU

Une fois le matériel installé, l'étape suivante consiste à configurer les machines virtuelles (VM) et les GPU pour garantir des performances optimales en matière d'IA. Une configuration adéquate permet de libérer le potentiel des GPU virtualisés et de les rendre plus efficaces pour les charges de travail d'IA. Voyons comment configurer et gérer efficacement ces ressources.

Passage intégral du GPU ou partitionnement du vGPU

En ce qui concerne les configurations de GPU, il existe deux approches principales : Le GPU passthrough et le partitionnement vGPU.

- Le GPU passthrough dédie un GPU entier à une seule VM, ce qui permet d'obtenir des performances quasi natives pour les tâches d'entraînement à l'IA exigeantes. Bien que cette configuration maximise la puissance, elle limite le GPU à une seule VM, ce qui peut s'avérer inefficace pour les petites charges de travail.

- Le partitionnement vGPU, quant à lui, divise un GPU en plusieurs tranches virtuelles. Cette approche est plus rentable pour les tâches qui ne nécessitent pas la pleine puissance d'un GPU, comme les charges de travail d'inférence ou les petits travaux de formation.

Les GPU modernes tels que les NVIDIA A100 et H100 prennent en charge le MIG (Multi-Instance GPU), qui permet d'isoler jusqu'à sept instances de GPU sur une seule carte. Cette fonction est idéale pour maximiser l'utilisation du matériel tout en maîtrisant les coûts.

Le bon choix dépend de votre cas d'utilisation :

- Pour l'entraînement à grande échelle, comme l'entraînement de modèles de langage ou la recherche sur l'apprentissage profond, le GPU passthrough est généralement la meilleure option.

- Pour des tâches telles que le service d'inférence, le développement ou les tests, le partitionnement vGPU offre une meilleure efficacité des ressources et une réduction des coûts.

Allocation des ressources pour un parallélisme maximal

Une allocation efficace des ressources est essentielle pour éviter les goulots d'étranglement et garantir des opérations d'IA fluides. Voici comment équilibrer vos ressources :

- Allocation du CPU: Attribuez des cœurs de processeur spécifiques à chaque machine virtuelle afin de minimiser les changements de contexte. En général, l'allocation de 4 à 8 cœurs de CPU par GPU fonctionne bien, mais cela peut varier en fonction du cadre d'IA et de la complexité de la charge de travail.

- Gestion de la mémoire: Planifiez la mémoire vive du système et la mémoire du GPU. Allouez au moins 16 à 32 Go de RAM par GPU pour la plupart des tâches d'IA, tout en réservant suffisamment de mémoire pour l'hyperviseur. L'utilisation de pages volumineuses peut également réduire la surcharge de mémoire dans les opérations nécessitant beaucoup de données.

- Mémoire du GPU: Lorsque vous utilisez le partitionnement vGPU, surveillez de près l'utilisation de la mémoire du GPU. Certains frameworks comme PyTorch et TensorFlow peuvent allouer dynamiquement de la mémoire GPU, mais fixer des limites permet de s'assurer qu'une charge de travail ne monopolise pas les ressources.

- Réseau: Activez le SR-IOV (Single Root I/O Virtualization) pour les interfaces réseau afin de donner aux machines virtuelles un accès direct au matériel. Cela réduit la latence du réseau, ce qui est particulièrement important pour l'apprentissage distribué de l'IA sur plusieurs nœuds.

Outils d'orchestration GPU

Une fois les ressources allouées, les outils d'orchestration peuvent simplifier la gestion des GPU, en particulier dans les environnements d'IA à grande échelle.

- NVIDIA GPU Operator: Cet outil automatise des tâches telles que l'installation de pilotes GPU, la configuration de conteneurs d'exécution et la surveillance de l'état de santé dans Kubernetes. Il garantit des configurations cohérentes entre les clusters et réduit la charge de travail manuelle.

- Plugins GPU Kubernetes: Les plugins tels que le plugin de périphérique NVIDIA vous permettent d'affiner la planification et l'allocation des GPU. Ils prennent en charge l'utilisation fractionnée des GPU et permettent une gestion précise des ressources pour les charges de travail basées sur Kubernetes.

- SLURM: Un planificateur de tâches conçu pour les charges de travail de calcul haute performance (HPC) et d'IA, SLURM offre des fonctionnalités telles que la connaissance de la topologie du GPU, la planification du partage équitable et les réservations de ressources. Il est particulièrement utile pour gérer des environnements multi-utilisateurs et multi-projets.

- Docker avec NVIDIA Container Toolkit: Cette configuration permet aux conteneurs d'accéder aux GPU tout en maintenant l'isolation entre les charges de travail. Elle s'intègre de manière transparente aux plateformes d'orchestration, ce qui en fait une option flexible pour le déploiement d'applications d'IA.

Au fur et à mesure que votre infrastructure d'IA se développe, ces outils d'orchestration deviennent indispensables. Ils automatisent la gestion des ressources, améliorent l'utilisation et fournissent l'intelligence nécessaire pour exécuter efficacement plusieurs charges de travail sur du matériel partagé.

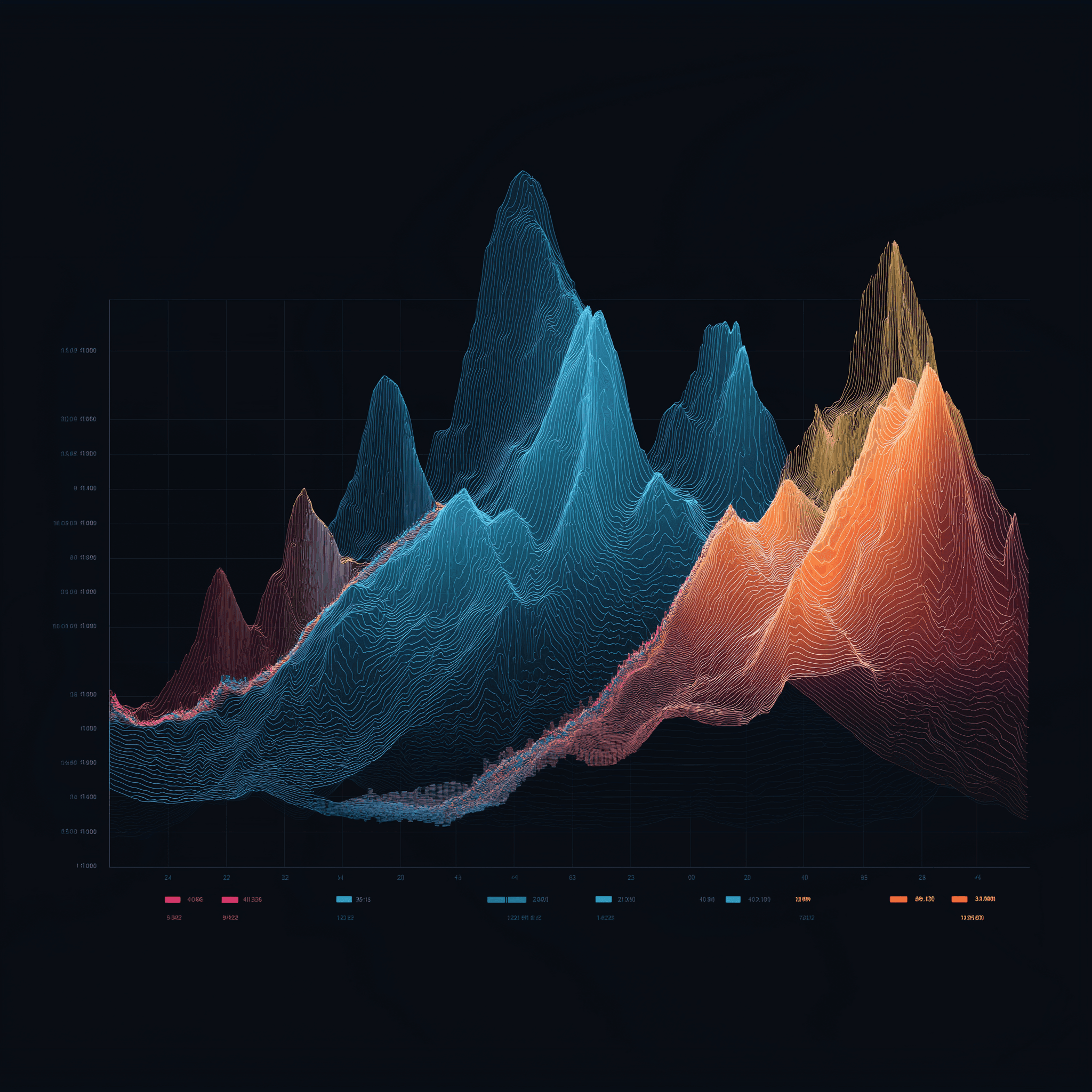

Surveillance des performances et planification

Après avoir mis en place votre matériel et vos configurations, l'étape suivante pour que tout fonctionne bien est de se concentrer sur la surveillance et la planification. Ces deux pratiques constituent l'épine dorsale du maintien des performances optimales de l'IA dans les environnements GPU virtualisés. Même la meilleure configuration matérielle peut s'avérer insuffisante sans une bonne visibilité de l'utilisation des ressources et des stratégies de planification intelligentes. Le profilage, la planification et la surveillance continue garantissent l'efficacité des charges de travail d'IA.

Profilage des charges de travail d'IA

L'établissement de profils revient à prendre le pouls de vos charges de travail d'IA - il permet de repérer les goulets d'étranglement et de s'assurer que les ressources sont utilisées à bon escient avant que les performances n'en pâtissent. L'objectif est de comprendre comment les différentes tâches consomment les ressources GPU, la mémoire et les cycles de calcul.

NVIDIA Nsight Systems est l'outil de référence pour le profilage des applications CUDA. Il fournit des informations détaillées sur l'utilisation du GPU, les transferts de mémoire et les temps d'exécution du noyau. Pour les frameworks d'apprentissage profond, les outils de profilage peuvent aider à identifier si les charges de travail sont liées au GPU, à la mémoire ou au CPU, ce qui est essentiel pour affiner l'allocation des ressources.

Les outils spécifiques aux frameworks tels que TensorFlow Profiler et PyTorch Profiler vont encore plus loin. TensorFlow Profiler décompose les temps d'étape, montrant combien de temps est consacré à des tâches telles que le chargement des données, le prétraitement et l'entraînement. De son côté, PyTorch Profiler examine de près l'utilisation de la mémoire, ce qui permet de détecter les fuites de mémoire ou les opérations tensorielles inefficaces.

Lors de l'établissement du profil, les mesures clés à surveiller sont les suivantes :

- L 'utilisation du GPU: Visez au moins 80 % pendant l'entraînement pour garantir une utilisation efficace.

- Utilisation de la bande passante de la mémoire: Cette mesure indique dans quelle mesure la mémoire du GPU est utilisée.

- Efficacité du noyau: Indique dans quelle mesure les opérations s'alignent sur l'architecture du GPU.

Dans les environnements virtualisés, le profilage devient un peu plus délicat en raison de l'ajout d'une couche d'hyperviseur. Des outils tels que vSphere Performance Charts ou KVM Performance Monitoring peuvent combler le fossé, en corrélant les mesures au niveau de la VM avec les données de profilage au niveau de l'invité. Cette approche à deux niveaux permet de déterminer si les problèmes de performances sont dus à la couche de virtualisation ou à la charge de travail elle-même.

Les informations tirées du profilage alimentent directement des stratégies de planification plus intelligentes, ce qui permet d'allouer les ressources de manière efficace.

Planification des charges de travail par l'IA

C'est au niveau de la planification que la magie opère - en s'assurant que les GPU sont utilisés efficacement tout en jonglant avec de multiples charges de travail d'IA. Différentes stratégies répondent à différents besoins, de la synchronisation des tâches distribuées à la priorisation des tâches critiques.

- Planification en groupe: Parfaite pour la formation synchrone, cette méthode garantit que tous les processus de la formation distribuée sont alignés, de sorte qu'aucun travailleur ne reste inactif.

- Ordonnancement prédictif: En analysant les données historiques, cette approche prédit les durées d'exécution des tâches en fonction de facteurs tels que la taille du modèle et les caractéristiques de l'ensemble de données, ce qui permet un placement plus intelligent de la charge de travail.

- Préemption des tâches: Les tâches hautement prioritaires peuvent temporairement supplanter les tâches moins prioritaires. Les programmateurs tenant compte des points de contrôle mettent les tâches en pause en toute sécurité, sauvegardent leur état et les reprennent plus tard lorsque les ressources se libèrent.

- Ordonnancement équitable: Il suit l'historique de l'utilisation et ajuste dynamiquement les priorités pour garantir une répartition équitable des ressources entre les utilisateurs ou les projets.

La méthode d'ordonnancement que vous choisissez peut améliorer ou réduire l'efficacité du système. Par exemple, l'ordonnancement par lots fonctionne bien dans les installations de recherche avec des délais flexibles, tandis que l'ordonnancement en temps réel est essentiel pour les charges de travail d'inférence qui exigent une faible latence.

Une fois la planification mise en place, une surveillance continue permet de s'assurer que tout se déroule comme prévu.

Surveillance et analyse comparative

La surveillance continue agit comme un système d'alerte précoce, détectant les problèmes potentiels avant qu'ils ne perturbent la production. La combinaison de mesures en temps réel et de données historiques permet de découvrir des tendances et des modèles qui pourraient autrement passer inaperçus.

Les outils de surveillance des GPU doivent tout contrôler, de l'utilisation de la mémoire à la température en passant par la consommation d'énergie. Le Data Center GPU Manager (DCGM ) de NVIDIA est une option robuste qui s'intègre à des plateformes telles que Prometheus et Grafana pour fournir une vue d'ensemble. Ces outils peuvent aider à détecter des problèmes tels que l'étranglement thermique ou la pression de la mémoire qui pourraient nuire aux performances.

La surveillance au niveau de l'application se concentre sur les mesures spécifiques à l'IA, telles que la perte d'entraînement, la précision de la validation et les taux de convergence. Des outils tels que MLflow et Weights & Biases combinent ces mesures avec les données de performance du système, offrant ainsi une image complète de la santé de la charge de travail.

Pour la formation distribuée, la surveillance du réseau est indispensable. Il est important de suivre l'utilisation de la bande passante, la latence et la perte de paquets entre les nœuds. Les interconnexions à haut débit comme InfiniBand nécessitent des outils spécialisés pour garantir une synchronisation fluide des gradients et un entraînement parallèle des données.

L'analyse comparative permet d'établir des références de performance et de valider les optimisations. Les benchmarksMLPerf sont un choix standard pour évaluer l'entraînement et l'inférence sur différents modèles d'IA et configurations matérielles. L'exécution de ces tests dans votre environnement virtualisé permet d'établir des attentes de base et de mettre en évidence les problèmes de configuration.

Les benchmarks synthétiques, comme ceux du référentiel DeepLearningExamples de NVIDIA, sont également utiles. Ils simulent des scénarios spécifiques, ce qui permet d'isoler les frais généraux de virtualisation et de confirmer que votre environnement fonctionne comme prévu.

Des analyses comparatives régulières, par exemple une fois par mois, peuvent révéler des problèmes tels que des mises à jour de pilotes, des dérives de configuration ou des dégradations matérielles qui pourraient autrement passer inaperçues.

Serveurs FDC pour l'infrastructure d'IA

Pour obtenir des performances optimales dans les systèmes d'IA, il n'est pas négociable de disposer d'une infrastructure d'hébergement fiable. Le bon partenaire d'hébergement garantit que vos stratégies de profilage, d'ordonnancement et de surveillance fonctionnent de manière transparente, en fournissant l'épine dorsale nécessaire pour optimiser efficacement les charges de travail d'IA.

Cette infrastructure stable permet un déploiement avancé des techniques de profilage, de planification et d'orchestration évoquées précédemment.

Serveurs GPU pour les charges de travail d'IA

FDC Servers propose un hébergement GPU spécialement conçu pour les applications d'IA et d'apprentissage automatique. À partir de 1 124 $ par mois, leurs serveurs GPU sont dotés d'une bande passante non mesurée, ce qui est indispensable lorsque l'on travaille avec de grands ensembles de données ou un entraînement distribué. Cette fonctionnalité élimine les inquiétudes concernant les limites de transfert de données, ce qui vous aide à maintenir des coûts prévisibles.

Leurs serveurs sont hautement personnalisables, ce qui vous permet d'affiner les configurations matérielles pour les modèles d'IA à mémoire élevée ou les configurations GPU spécialisées, telles que celles requises pour les tâches de vision par ordinateur. Grâce au déploiement instantané, vous pouvez rapidement augmenter les ressources GPU pour répondre aux demandes fluctuantes.

Les principales fonctionnalités comprennent la prise en charge du GPU passthrough, du partitionnement vGPU et de la planification personnalisée, autant d'éléments essentiels pour gérer les charges de travail d'IA exigeantes.

Bande passante non mesurée et déploiement mondial

La bande passante sans compteur change la donne pour les projets d'IA gourmands en données. L'entraînement de grands modèles nécessite souvent de déplacer des téraoctets de données entre les systèmes de stockage, les nœuds de calcul et les outils de surveillance. En éliminant les plafonds de transfert de données, FDC Servers permet à votre budget de rester prévisible et à vos flux de travail de ne pas être interrompus.

Avec 74 sites dans le monde, FDC Servers offre la couverture géographique nécessaire à une infrastructure d'IA moderne. Ce réseau mondial vous permet de positionner les ressources de calcul plus près des sources de données, réduisant ainsi la latence dans les configurations d'apprentissage distribuées. Pour l'inférence, les modèles peuvent être déployés en périphérie, ce qui garantit des temps de réponse plus rapides pour les utilisateurs finaux.

L'infrastructure mondiale joue également un rôle essentiel dans la reprise après sinistre et la redondance. Si un site subit une panne, les charges de travail peuvent être migrées de manière transparente vers une autre région, ce qui permet de maintenir le bon déroulement des opérations. Pour les organisations qui gèrent des pipelines d'IA multirégionaux, le fait de disposer d'une infrastructure cohérente sur l'ensemble des 74 sites garantit l'uniformité des configurations de virtualisation, des outils de surveillance et des stratégies de planification, quel que soit l'endroit où vos ressources sont déployées.

En outre, FDC Servers offre un support 24/7 pour résoudre tous les problèmes, qu'ils soient liés aux pilotes GPU, aux conflits de virtualisation ou à l'allocation des ressources. Cela permet de minimiser les temps d'arrêt, même dans des environnements GPU complexes et virtualisés.

L'ensemble de ces caractéristiques constitue une base solide pour optimiser les performances de l'IA.

Conclusion

Ce guide montre comment l'association d'un matériel avancé, de ressources finement ajustées et d'une infrastructure solide peut considérablement améliorer les performances de l'IA.

Pour tirer le meilleur parti de vos charges de travail d'IA, adaptez votre matériel, l'allocation des ressources et l'infrastructure à vos besoins spécifiques. Pour des performances maximales, le GPU passthrough est idéal, tandis que le partitionnement vGPU offre un moyen efficace de partager les ressources.

La synergie entre la sélection du matériel et le réglage des ressources est essentielle pour optimiser les performances. L'utilisation de GPU dotés d'une large bande passante, l'intégration d'un stockage NVMe et la garantie d'un débit réseau élevé peuvent directement améliorer l'efficacité de l'entraînement et le résultat du modèle. Le réglage fin de la topologie du système réduit les délais d'interconnexion, tandis que le profilage et la planification intelligente maximisent l'utilisation des GPU. Les outils d'orchestration garantissent en outre des performances constantes et de haut niveau.

Un partenaire d'hébergement fiable relie le tout. Pour les organisations qui cherchent à surmonter les défis liés aux ressources, un hébergement fiable est essentiel. FDC Servers propose un hébergement GPU à 1 124 $/mois avec une bande passante non mesurée - une option qui élimine les limites de transfert de données et les coûts imprévisibles.

Grâce à des fonctionnalités telles que l'évolutivité géographique, le déploiement instantané et l'assistance 24/7, vous pouvez faire évoluer les opérations d'IA de manière transparente. Qu'il s'agisse de gérer une formation distribuée dans plusieurs régions ou de déployer des modèles d'inférence de pointe, une infrastructure fiable élimine la plupart des obstacles techniques qui ralentissent souvent les projets d'IA.

Pour réussir dans le domaine de l'IA, il faut un mélange homogène de puissance GPU, une gestion précise des ressources et un hébergement fiable. En suivant ces stratégies et en tirant parti de l'infrastructure de FDC Servers, vous pouvez ouvrir la voie à des performances optimales en matière d'IA.

FAQ

Comment la virtualisation du GPU rend-elle les charges de travail d'IA plus efficaces et plus rentables ?

La virtualisation du GPU permet à plusieurs machines virtuelles d'utiliser un seul GPU physique, ce qui augmente l'efficacité tout en réduisant les coûts. En partageant les ressources, elle élimine le besoin de matériel supplémentaire, ce qui permet de mieux utiliser ce qui est déjà disponible et de réduire les dépenses globales.

Cette configuration facilite également la mise à l'échelle et la gestion. Les entreprises peuvent prendre en charge davantage de charges de travail d'IA sans avoir besoin d'un GPU distinct pour chaque machine virtuelle. Le résultat ? Des performances rationalisées et des coûts contrôlés - une combinaison idéale pour les projets d'IA et d'apprentissage automatique.

Quelle est la différence entre le GPU passthrough et le partitionnement vGPU, et quand devriez-vous utiliser chacun d'entre eux ?

Dans le cas du GPU passthrough, l'ensemble du GPU est dédié à une seule machine virtuelle (VM), offrant des performances quasiment identiques à celles d'une exécution sur du matériel physique. Cela en fait une option de choix pour les tâches exigeantes telles que l'apprentissage de modèles d'IA, l'apprentissage profond ou le rendu 3D, où il est essentiel d'exploiter au maximum les performances.

En revanche, le partitionnement vGPU divise un seul GPU en plusieurs segments matériels, ce qui permet à plusieurs VM ou utilisateurs de partager le même GPU simultanément. Cette configuration est idéale pour les environnements partagés tels que les bureaux virtuels ou les postes de travail collaboratifs, où la priorité est d'équilibrer la flexibilité et l'utilisation efficace des ressources.

Quels sont les meilleurs outils et stratégies pour surveiller et optimiser les charges de travail d'IA dans les environnements virtualisés par GPU ?

Pour tirer le meilleur parti des charges de travail d'IA dans les environnements virtualisés par le GPU, il est essentiel d'utiliser des outils de surveillance du GPU qui fournissent des données en temps réel sur l'utilisation des ressources et les performances. Par exemple, les solutions de gestion vGPU de NVIDIA facilitent le suivi de l'utilisation des GPU et l'optimisation de la distribution des ressources.

Une autre approche clé consiste à utiliser des plateformes d'orchestration comme Kubernetes. Ces plateformes peuvent ajuster dynamiquement les charges de travail et allouer les ressources plus efficacement, ce qui vous aide à obtenir de meilleures performances GPU. En outre, l'ajustement régulier des hyperparamètres et l'affinement des pipelines de données jouent un rôle important dans le maintien de niveaux de performance élevés. En surveillant en permanence les mesures du GPU, vous pouvez repérer rapidement les goulets d'étranglement et éviter les conflits de ressources, ce qui garantit le bon déroulement de vos tâches d'IA.

Comment installer et utiliser Redis sur un VPS

Apprenez à installer et à configurer Redis sur un VPS pour optimiser les performances, la sécurité et la gestion de vos applications.

9 min de lecture - 7 janvier 2026

Surveiller son serveur dédié ou son VPS, quelles sont les options en 2025 ?

12 min de lecture - 28 novembre 2025