Sarcini de lucru AI în medii virtualizate GPU: Ghid de optimizare

11 min citire - 10 octombrie 2025

- Sarcini de lucru AI în medii virtualizate GPU: Ghid de optimizare

- Noțiuni de bază despre virtualizarea GPU pentru AI

- Infrastructura AI/ML: Explicarea GPU-ului de feliere a timpului

- Cerințe hardware și de infrastructură

- Configurarea mașinii virtuale și a GPU-ului

- Monitorizarea performanței și programarea

- Servere FDC pentru infrastructura AI

- Concluzie

- Întrebări frecvente

Explorați modul în care virtualizarea GPU îmbunătățește sarcinile de lucru AI prin creșterea eficienței, reducerea costurilor și optimizarea gestionării resurselor în mediile virtualizate.

- Sarcini de lucru AI în medii virtualizate GPU: Ghid de optimizare

- Noțiuni de bază despre virtualizarea GPU pentru AI

- Infrastructura AI/ML: Explicarea GPU-ului de feliere a timpului

- Cerințe hardware și de infrastructură

- Configurarea mașinii virtuale și a GPU-ului

- Monitorizarea performanței și programarea

- Servere FDC pentru infrastructura AI

- Concluzie

- Întrebări frecvente

Sarcini de lucru AI în medii virtualizate GPU: Ghid de optimizare

Virtualizarea GPU transformă modul în care sunt gestionate sarcinile de lucru AI. Prin împărțirea unui GPU fizic în mai multe instanțe virtuale, puteți rula mai multe sarcini AI simultan, îmbunătățind eficiența și reducând costurile hardware. Această abordare este deosebit de valoroasă pentru instruirea modelelor complexe, gestionarea sarcinilor cu resurse intensive și scalarea proiectelor AI fără a investi în GPU-uri suplimentare.

Iată de ce este important:

- Utilizarea eficientă a GPU: Evitați hardware-ul inactiv prin partajarea resurselor între sarcini și echipe.

- Reducerea costurilor: GPU-urile de înaltă performanță sunt scumpe; virtualizarea asigură o utilizare maximă.

- Flexibilitate: Adaptați instanțele GPU virtuale la nevoi specifice, cum ar fi dimensiunea memoriei sau versiunile CUDA.

- Scalabilitate: Ajustați dinamic resursele pe măsură ce volumul de lucru AI crește.

- Fiabilitate: Instanțele izolate împiedică o sarcină să le afecteze pe celelalte.

Pentru a optimiza performanța:

- Alegeți GPU-uri cu memorie și lățime de bandă mari (de exemplu, NVIDIA A100/H100).

- Utilizați stocare NVMe și rețele cu latență redusă pentru gestionarea datelor.

- Configurați mașini virtuale cu passthrough GPU sau partiționare vGPU în funcție de necesitățile volumului de lucru.

- Utilizați instrumente precum NVIDIA GPU Operator, pluginuri Kubernetes și SLURM pentru orchestrare.

- Monitorizați performanța cu instrumente precum NVIDIA Nsight Systems și DCGM pentru a identifica blocajele.

Serviciile de găzduire precum FDC Servers oferă soluții GPU personalizate începând de la 1 124 de dolari/lună, inclusiv lățime de bandă nemediată și opțiuni de implementare globală pentru proiecte AI la scară largă.

Concluzie: Virtualizarea GPU simplifică gestionarea resurselor, sporește performanța și reduce costurile pentru sarcinile de lucru AI, ceea ce o face o soluție practică pentru scalarea eficientă a operațiunilor AI.

Noțiuni de bază despre virtualizarea GPU pentru AI

Ce este virtualizarea GPU?

Virtualizarea GPU permite mai multor utilizatori să partajeze un singur GPU prin crearea de instanțe virtuale, fiecare cu propria memorie, nuclee și putere de procesare dedicate. Aceasta înseamnă că un singur GPU poate gestiona mai multe sarcini sau utilizatori în același timp, ceea ce îl transformă într-o soluție eficientă pentru volumele de lucru AI.

La bază, această tehnologie se bazează pe un hipervizor, care acționează ca un manager, împărțind resursele GPU între mașinile virtuale. Hipervizorul se asigură că fiecare instanță își primește partea alocată, fără interferențe din partea celorlalte. Pentru sarcinile AI, acest lucru permite unui singur GPU NVIDIA A100 sau H100 să ruleze simultan mai multe experimente de învățare automată, sesiuni de instruire sau operațiuni de inferență.

Există două metode principale pentru partajarea acestor resurse:

- Virtualizarea la nivel hardware: Tehnologia Multi-Instance GPU (MIG) de la NVIDIA împarte fizic GPU-ul în secțiuni izolate, asigurând o separare puternică între instanțe.

- Virtualizarea la nivel software: Această metodă utilizează drivere și software pentru a împărți resursele GPU, oferind mai multă flexibilitate, dar o izolare ceva mai redusă.

O distincție cheie între virtualizarea GPU și cea tradițională CPU constă în gestionarea memoriei. GPU-urile utilizează memorie cu lățime de bandă mare (HBM), care funcționează diferit de memoria RAM standard a sistemului. Gestionarea eficientă a acestei memorii este esențială, în special în timpul operațiunilor de inteligență artificială care necesită multe resurse, cum ar fi reglarea fină sau formarea la scară largă.

Această înțelegere fundamentală pregătește terenul pentru explorarea modului în care virtualizarea GPU îmbunătățește performanța IA în scenarii practice.

Beneficii pentru AI și sarcinile de lucru de învățare automată

Virtualizarea oferă o serie de beneficii care răspund în mod direct provocărilor legate de sarcinile de lucru din AI și machine learning (ML).

Maximizarea utilizării GPU este unul dintre cele mai importante avantaje. GPU-urile de înaltă performanță, care pot costa între 10.000 și 30.000 de dolari, sunt adesea subutilizate în timpul sarcinilor precum preprocesarea datelor sau configurarea modelului. Virtualizarea asigură utilizarea deplină a acestor resurse costisitoare, permițând mai multor sarcini să partajeze același GPU, reducând timpul de inactivitate și reducând costurile hardware. Această abordare permite organizațiilor să deservească mai mulți utilizatori și aplicații fără a avea nevoie de GPU-uri fizice suplimentare.

Flexibilitatea în dezvoltare este un alt factor care schimbă regulile jocului. Cu ajutorul virtualizării, dezvoltatorii pot crea instanțe GPU virtuale adaptate nevoilor specifice, cum ar fi diferite versiuni CUDA, dimensiuni ale memoriei sau configurații ale driverelor. Această izolare asigură faptul că proiectele care utilizează cadre precum PyTorch, TensorFlow sau JAX pot coexista fără conflicte, simplificând fluxurile de lucru și accelerând inovarea.

Scalabilitatea devine mult mai ușor de gestionat. Sarcinile de lucru ale IA pot varia semnificativ în ceea ce privește cerințele lor. De exemplu, antrenarea unei rețele neuronale mici poate necesita resurse minime, în timp ce ajustarea unui model de limbaj mare necesită o putere de calcul masivă. Instanțele virtuale pot crește sau scădea dinamic, alocând resurse în funcție de intensitatea volumului de lucru. Această adaptabilitate asigură utilizarea eficientă a resurselor în orice moment.

Suportul multi-tenancy este deosebit de valoros pentru organizațiile cu nevoi diverse. Prin partajarea infrastructurii, diferite departamente, clienți sau aplicații pot accesa resursele GPU fără a fi nevoie să gestioneze hardware-ul fizic. Furnizorii de cloud pot oferi chiar GPU-as-a-Service, permițând utilizatorilor să acceseze instanțe GPU virtuale, menținând în același timp izolarea performanței și reducând complexitatea administrativă.

În cele din urmă, izolarea erorilor asigură stabilitatea. Dacă o instanță virtuală se blochează sau consumă resurse excesive, acest lucru nu va afecta alte instanțe care partajează același GPU. Această fiabilitate este esențială în mediile de producție în care mai multe servicii AI trebuie să funcționeze fără probleme și în mod constant.

Virtualizarea GPU nu numai că optimizează utilizarea resurselor, ci și oferă echipelor AI instrumentele și flexibilitatea necesare pentru a face față sarcinilor de lucru complexe și în continuă schimbare.

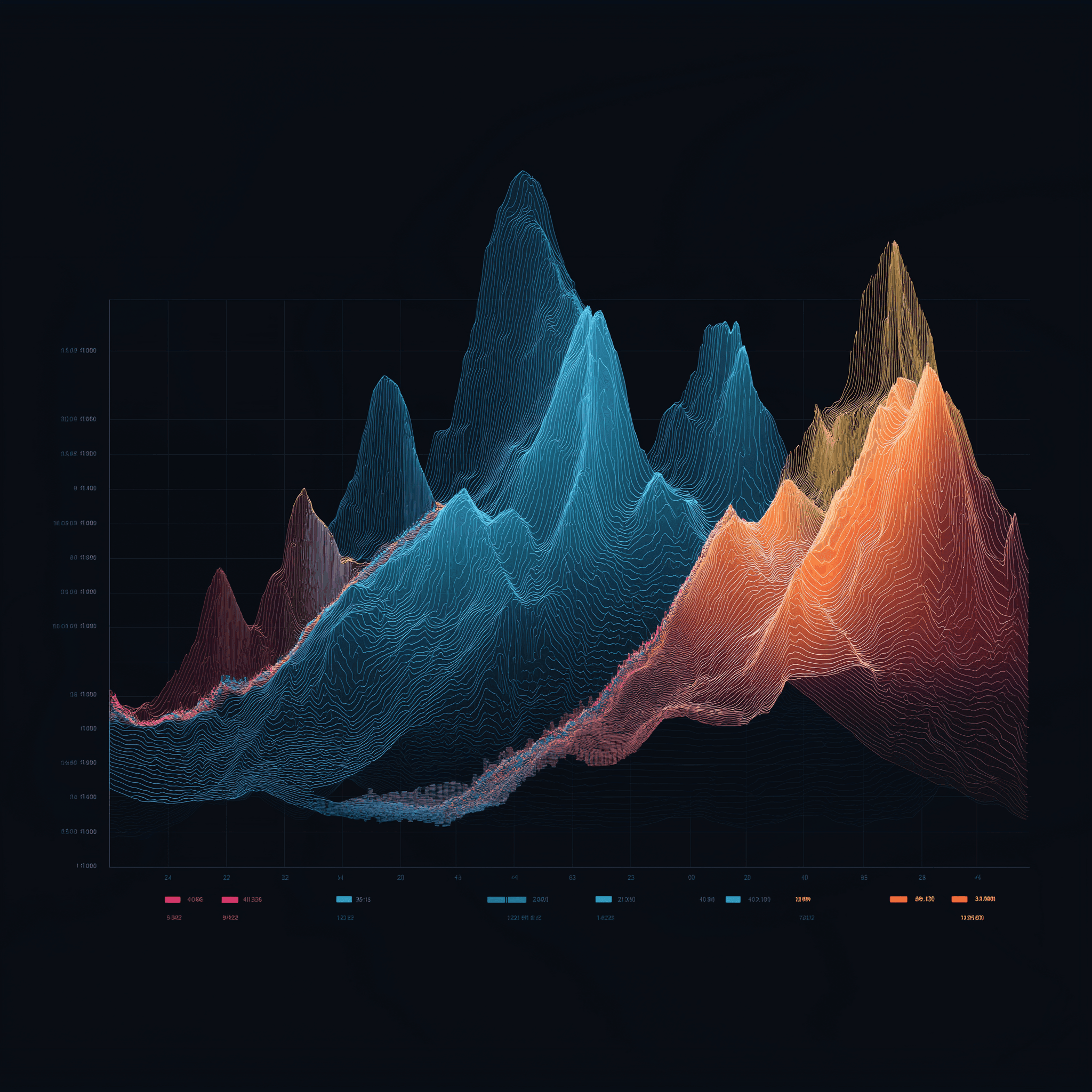

Infrastructura AI/ML: Explicarea GPU-ului de feliere a timpului

Cerințe hardware și de infrastructură

Obținerea celei mai bune performanțe AI în mediile GPU virtualizate depinde în mare măsură de alegerea corectă a hardware-ului și a interconectării. Aceste decizii joacă un rol cheie în maximizarea potențialului virtualizării GPU pentru sarcinile de lucru AI.

Alegerea arhitecturii GPU potrivite

Atunci când selectați GPU-uri pentru sarcini AI, căutați modele cu capacitate mare de memorie, lățime de bandă rapidă și suport de virtualizare încorporat. Multe GPU-uri moderne pot fi împărțite în mai multe instanțe izolate, permițând diferiților utilizatori sau aplicații să dispună de resurse dedicate de calcul și memorie. Dar alegerea GPU-ului potrivit este doar o parte a ecuației - infrastructura de stocare și de rețea trebuie să fie capabilă să țină pasul cu performanța acestuia.

Cerințe privind stocarea și rețeaua

Sarcinile de lucru ale IA implică adesea gestionarea unor cantități masive de date, ceea ce face ca stocarea NVMe de mare viteză și rețelele cu latență redusă să fie esențiale. În mediile de întreprindere, unitățile NVMe cu ratinguri puternice de anduranță sunt ideale pentru gestionarea ciclurilor grele de citire/scriere care vin cu aplicații AI.

Pentru schimburile de date între noduri, tehnologiile precum InfiniBand sau soluțiile Ethernet avansate oferă lățimea de bandă necesară pentru operațiuni fără probleme. Utilizarea unui sistem de fișiere distribuit pentru a permite I/O paralele poate ajuta la minimizarea blocajelor atunci când mai multe procese accesează datele în același timp. Odată ce nevoile de stocare și de rețea sunt satisfăcute, următorul pas este ajustarea modului de aliniere a resurselor.

Alinierea resurselor și optimizarea topologiei

Pentru a optimiza alinierea resurselor, configurați NUMA (Non-Uniform Memory Access) pentru a asigura conexiuni directe între GPU-uri, memorie și CPU-uri. Atribuiți interfețe de rețea de mare viteză și dedicați benzi PCIe pentru a reduce latența. Rețineți că o răcire robustă și o capacitate de alimentare suficientă sunt esențiale pentru a evita strangularea termică și a menține stabilitatea sistemului. În plus, poziționarea stocării aproape de unitățile de procesare poate reduce și mai mult latența, creând o arhitectură de sistem mai eficientă și mai receptivă.

Configurarea mașinii virtuale și a GPU-ului

Odată ce hardware-ul este configurat, următorul pas este configurarea mașinilor virtuale (VM) și a GPU-urilor pentru a asigura performanțe AI optime. Configurațiile adecvate deblochează potențialul GPU-urilor virtualizate, făcându-le mai eficiente pentru sarcinile de lucru AI. Să ne scufundăm în modul de configurare și gestionare eficientă a acestor resurse.

Full GPU Passthrough vs. partiționarea vGPU

Când vine vorba de configurațiile GPU, există două abordări principale: GPU passthrough și partiționarea vGPU.

- GPU passthrough dedică un întreg GPU unei singure VM, oferind o performanță aproape nativă pentru sarcinile solicitante de instruire AI. Deși această configurație maximizează puterea, limitează GPU-ul la o singură mașină virtuală, ceea ce poate fi ineficient pentru volumele de lucru mai mici.

- Partiționarea vGPU, pe de altă parte, împarte un GPU în mai multe felii virtuale. Această abordare este mai rentabilă pentru sarcinile care nu necesită întreaga putere a unui GPU, cum ar fi sarcinile de lucru de inferență sau sarcinile de formare mai mici.

GPU-urile moderne precum NVIDIA A100 și H100 suportă MIG (Multi-Instance GPU), permițând până la șapte instanțe GPU izolate pe o singură placă. Această caracteristică este perfectă pentru maximizarea utilizării hardware, menținând în același timp costurile sub control.

Alegerea corectă depinde de cazul dvs. de utilizare:

- Pentru instruirea pe scară largă, cum ar fi instruirea modelelor lingvistice sau cercetarea în domeniul învățării profunde, GPU passthrough este de obicei opțiunea cea mai bună.

- Pentru sarcini precum servirea inferențelor, dezvoltarea sau testarea, partiționarea vGPU oferă o mai bună eficiență a resurselor și economii de costuri.

Alocarea resurselor pentru paralelism maxim

Alocarea eficientă a resurselor este esențială pentru evitarea blocajelor și asigurarea unor operațiuni AI fără probleme. Iată cum să vă echilibrați resursele:

- Alocarea CPU: Alocați nuclee CPU specifice fiecărei mașini virtuale pentru a minimiza schimbarea contextului. De obicei, alocarea a 4-8 nuclee CPU per GPU funcționează bine, dar acest lucru poate varia în funcție de cadrul AI și de complexitatea volumului de lucru.

- Gestionarea memoriei: Planificați atât memoria RAM a sistemului, cât și memoria GPU. Alocați cel puțin 16-32 GB de RAM per GPU pentru majoritatea sarcinilor AI, rezervând în același timp suficientă memorie pentru hipervizor. Utilizarea paginilor uriașe poate reduce, de asemenea, supraîncărcarea memoriei în cazul operațiunilor cu multe date.

- Memorie GPU: Atunci când utilizați partiționarea vGPU, monitorizați îndeaproape utilizarea memoriei GPU. Unele cadre precum PyTorch și TensorFlow pot aloca dinamic memoria GPU, dar stabilirea unor limite asigură că un volum de lucru nu monopolizează resursele.

- Rețele: Activați SR-IOV (Single Root I/O Virtualization) pentru interfețele de rețea pentru a oferi VM-urilor acces hardware direct. Acest lucru reduce latența rețelei, ceea ce este deosebit de important pentru instruirea AI distribuită pe mai multe noduri.

Instrumente de orchestrare GPU

Odată ce resursele sunt alocate, instrumentele de orchestrare pot simplifica gestionarea GPU-urilor, în special în mediile AI scalate.

- NVIDIA GPU Operator: Acest instrument automatizează sarcini precum instalarea driverelor GPU, configurarea timpilor de execuție a containerelor și monitorizarea stării în cadrul Kubernetes. Asigură configurații consecvente între clustere și reduce volumul de lucru manual.

- Plugin-uri GPU Kubernetes: Pluginurile precum pluginul pentru dispozitive NVIDIA vă permit să reglați cu precizie programarea și alocarea GPU. Acestea acceptă utilizarea fracționată a GPU și permit gestionarea precisă a resurselor pentru sarcinile de lucru bazate pe Kubernetes.

- SLURM: Un programator de sarcini conceput pentru sarcini de calcul de înaltă performanță (HPC) și AI, SLURM oferă caracteristici precum cunoașterea topologiei GPU, programarea echitabilă și rezervarea resurselor. Este deosebit de util pentru gestionarea mediilor multiutilizator și multiproiect.

- Docker cu NVIDIA Container Toolkit: Această configurație permite containerelor să acceseze GPU, menținând în același timp izolarea între sarcinile de lucru. Se integrează perfect cu platformele de orchestrare, ceea ce o face o opțiune flexibilă pentru implementarea aplicațiilor AI.

Pe măsură ce infrastructura AI crește, aceste instrumente de orchestrare devin indispensabile. Ele automatizează gestionarea resurselor, îmbunătățesc utilizarea și oferă inteligența necesară pentru a rula eficient mai multe sarcini de lucru pe hardware partajat.

Monitorizarea performanței și programarea

După setarea hardware-ului și a configurațiilor, următorul pas pentru ca lucrurile să funcționeze fără probleme este să vă concentrați asupra monitorizării și programării. Aceste două practici reprezintă coloana vertebrală a menținerii performanței AI de vârf în mediile virtualizate GPU. Chiar și cea mai bună configurație hardware poate eșua fără o vizibilitate adecvată a utilizării resurselor și fără strategii inteligente de programare. Profilarea, programarea și monitorizarea continuă asigură menținerea eficienței și eficacității volumelor de lucru AI.

Profilarea sarcinii de lucru AI

Profilarea este ca și cum ai lua pulsul volumelor de lucru AI - ajută la identificarea blocajelor și asigură utilizarea judicioasă a resurselor înainte ca performanța să fie afectată. Scopul este de a înțelege modul în care diferite sarcini consumă resursele GPU, memoria și ciclurile de calcul.

NVIDIA Nsight Systems este un instrument de bază pentru profilarea aplicațiilor CUDA, oferind informații detaliate despre utilizarea GPU, transferurile de memorie și timpii de execuție ai kernel-ului. Pentru cadrele de învățare profundă, instrumentele de profilare pot ajuta la identificarea faptului dacă volumele de lucru sunt legate de GPU, memorie sau CPU, ceea ce este esențial pentru reglarea fină a alocării resurselor.

Instrumentele specifice cadrului, precum TensorFlow Profiler și PyTorch Profiler, merg și mai departe. TensorFlow Profiler analizează timpii pe etape, arătând cât timp este petrecut cu sarcini precum încărcarea datelor, preprocesarea și formarea. În același timp, PyTorch Profiler oferă o privire atentă la utilizarea memoriei, ajutând la detectarea scurgerilor de memorie sau a operațiunilor tensoriale ineficiente.

În timpul profilării, parametrii cheie de urmărit includ:

- Utilizarea GPU: Vizați cel puțin 80% în timpul antrenamentului pentru a asigura o utilizare eficientă.

- Utilizarea lățimii de bandă a memoriei: Aceasta arată cât de bine este utilizată memoria GPU.

- Eficiența nucleului: Indică cât de eficient se aliniază operațiunile cu arhitectura GPU.

În mediile virtualizate, profilarea devine un pic mai complicată din cauza stratului de hipervizor adăugat. Instrumente precum vSphere Performance Charts sau monitorizarea performanțelor KVM pot reduce decalajul, corelând metricile la nivel de VM cu datele de profilare la nivel de guest. Această abordare pe două niveluri ajută la determinarea faptului dacă sughițurile de performanță se datorează nivelului de virtualizare sau volumului de lucru în sine.

Cunoștințele obținute în urma profilării se regăsesc direct în strategii de planificare mai inteligente, menținând resursele alocate în mod eficient.

Programarea AI a sarcinii de lucru

Programarea este locul în care se întâmplă magia - asigurându-se că GPU-urile sunt utilizate eficient în timp ce jonglează cu mai multe sarcini de lucru AI. Strategii diferite răspund unor nevoi diferite, de la sincronizarea sarcinilor distribuite la prioritizarea sarcinilor critice.

- Programarea în grup: Perfectă pentru formarea sincronă, această metodă asigură alinierea tuturor proceselor din formarea distribuită, astfel încât niciun lucrător să nu stea degeaba.

- Programarea predictivă: Prin analizarea datelor istorice, această abordare prezice timpul de execuție al sarcinilor pe baza unor factori precum dimensiunea modelului și caracteristicile setului de date, permițând o plasare mai inteligentă a sarcinii de lucru.

- Preluarea sarcinilor: Sarcinile cu prioritate ridicată le pot înlocui temporar pe cele cu prioritate scăzută. Programatorii care iau în considerare punctele de control întrerup sarcinile în siguranță, le salvează starea și le reiau mai târziu, când resursele se eliberează.

- Programare echitabilă: Urmărește utilizarea istorică și ajustează dinamic prioritățile pentru a se asigura că resursele sunt distribuite corect între utilizatori sau proiecte.

Metoda de planificare pe care o alegeți poate face sau desface eficiența sistemului. De exemplu, programarea pe loturi funcționează bine în configurațiile de cercetare cu termene limită flexibile, în timp ce programarea în timp real este esențială pentru volumele de lucru de inferență care necesită o latență redusă.

Odată ce programarea este pusă în aplicare, monitorizarea continuă asigură că totul rămâne pe drumul cel bun.

Monitorizare și analiză comparativă

Monitorizarea continuă acționează ca un sistem de avertizare timpurie, detectând eventualele probleme înainte ca acestea să perturbe producția. Combinarea măsurătorilor în timp real cu datele istorice ajută la descoperirea tendințelor și modelelor care altfel ar putea trece neobservate.

Instrumentele de monitorizare a GPU-urilor ar trebui să urmărească totul, de la utilizare și utilizarea memoriei la temperatură și consum de energie. Data Center GPU Manager (DCGM) de la NVIDIA este o opțiune robustă, care se integrează cu platforme precum Prometheus și Grafana pentru a oferi o vizualizare completă. Aceste instrumente pot ajuta la detectarea unor probleme precum restricționarea termică sau presiunea asupra memoriei care ar putea afecta performanța.

Monitorizarea la nivel de aplicație se concentrează asupra parametrilor specifici inteligenței artificiale, cum ar fi pierderea de formare, precizia validării și ratele de convergență. Instrumente precum MLflow și Weights & Biases combină acești parametri cu datele de performanță ale sistemului, oferind o imagine completă a sănătății volumului de lucru.

Pentru instruirea distribuită, monitorizarea rețelei este o necesitate. Este important să se urmărească utilizarea lățimii de bandă, latența și pierderea pachetelor între noduri. Interconexiunile de mare viteză, cum ar fi InfiniBand, necesită instrumente specializate pentru a asigura sincronizarea fără probleme a gradientului și formarea paralelă a datelor.

Benchmarking-ul ajută la stabilirea liniilor de bază de performanță și la validarea optimizărilor. Criteriile de referințăMLPerf sunt o alegere standard pentru evaluarea instruirii și a inferenței între diverse modele AI și configurații hardware. Rularea acestor teste în mediul dvs. virtualizat stabilește așteptările de bază și evidențiază problemele de configurare.

Reperele sintetice, precum cele din depozitul DeepLearningExamples al NVIDIA, sunt, de asemenea, utile. Acestea simulează scenarii specifice, ajutând la izolarea supraîncărcării virtualizării și confirmând că mediul dvs. funcționează conform așteptărilor.

Benchmarking-ul regulat - de exemplu, o dată pe lună - poate dezvălui probleme precum actualizările de drivere, derapajele de configurare sau degradarea hardware care altfel ar putea trece neobservate.

Servere FDC pentru infrastructura AI

Pentru a obține performanțe de vârf în sistemele AI, nu este negociabil să aveți o infrastructură de găzduire fiabilă. Partenerul de găzduire potrivit vă asigură că strategiile de profilare, programare și monitorizare funcționează perfect, oferind coloana vertebrală necesară pentru optimizarea eficientă a volumelor de lucru AI.

Această infrastructură stabilă este cea care permite implementarea avansată a tehnicilor de profilare, programare și orchestrare discutate anterior.

Servere GPU pentru sarcini de lucru AI

FDC Servers oferă găzduire GPU adaptată special pentru AI și aplicații de învățare automată. Începând de la 1.124 de dolari pe lună, serverele lor GPU sunt dotate cu lățime de bandă nereglementată - o necesitate atunci când se lucrează cu seturi mari de date sau cu instruire distribuită. Această caracteristică elimină preocupările legate de limitele de transfer de date, ajutându-vă să mențineți costuri previzibile.

Serverele lor sunt extrem de personalizabile, permițându-vă să ajustați configurațiile hardware pentru modele AI cu memorie mare sau configurații GPU specializate, cum ar fi cele necesare pentru sarcinile de computer vision. Datorită implementării instantanee, puteți crește rapid resursele GPU pentru a face față cererilor fluctuante.

Caracteristicile cheie includ suport pentru passthrough GPU, partiționare vGPU și planificare personalizată, toate esențiale pentru gestionarea sarcinilor de lucru AI solicitante.

Lățime de bandă nemediată și implementare globală

Lățimea de bandă nelimitată este o schimbare radicală pentru proiectele de inteligență artificială cu un volum mare de date. Instruirea modelelor mari necesită adesea mutarea terabytes de date între sistemele de stocare, nodurile de calcul și instrumentele de monitorizare. Prin eliminarea plafoanelor de transfer de date, FDC Servers vă menține bugetul previzibil și fluxurile de lucru neîntrerupte.

Cu 74 de locații globale, FDC Servers oferă acoperirea geografică necesară pentru infrastructura AI modernă. Această rețea globală vă permite să poziționați resursele de calcul mai aproape de sursele de date, reducând latența în configurațiile de instruire distribuite. Pentru inferență, modelele pot fi implementate în locații periferice, asigurând timpi de răspuns mai rapizi pentru utilizatorii finali.

Infrastructura globală joacă, de asemenea, un rol esențial în recuperarea în caz de dezastru și redundanță. În cazul în care o locație se confruntă cu o întrerupere, volumele de lucru pot fi migrate fără probleme în altă regiune, menținând operațiunile fără probleme. Pentru organizațiile care gestionează conducte AI multiregionale, existența unei infrastructuri coerente în toate cele 74 de locații asigură uniformitatea configurațiilor de virtualizare, a instrumentelor de monitorizare și a strategiilor de programare - indiferent de locul în care sunt implementate resursele.

În plus, FDC Servers oferă suport 24/7 pentru a rezolva orice problemă, fie că este legată de driverele GPU, conflictele de virtualizare sau alocarea resurselor. Acest lucru asigură un timp minim de nefuncționare, chiar și în medii GPU complexe, virtualizate.

Aceste caracteristici oferă împreună o bază solidă pentru obținerea unei performanțe AI optimizate.

Concluzie

Acest ghid evidențiază modul în care combinarea hardware-ului avansat, a resurselor bine reglate și a unei infrastructuri solide poate crește semnificativ performanța AI.

Pentru a obține maximum din sarcinile de lucru AI, aliniați-vă hardware-ul, alocarea resurselor și infrastructura la cerințele dvs. specifice. Pentru performanțe maxime, passthrough-ul GPU este ideal, în timp ce partiționarea vGPU oferă o modalitate eficientă de partajare a resurselor.

Sinergia dintre selectarea hardware-ului și reglarea resurselor este esențială pentru optimizarea performanței. Utilizarea GPU-urilor cu o lățime de bandă de memorie mare, integrarea stocării NVMe și asigurarea unui debit de rețea ridicat pot îmbunătăți în mod direct eficiența formării și rezultatul modelului. Reglarea fină a topologiei sistemului reduce întârzierile de interconectare, în timp ce profilarea și programarea inteligentă maximizează utilizarea GPU. Instrumentele de orchestrare asigură în continuare o performanță constantă, de nivel înalt.

Un partener de găzduire de încredere leagă totul. Pentru organizațiile care doresc să depășească provocările legate de resurse, găzduirea fiabilă este esențială. FDC Servers oferă găzduire GPU la 1.124 $/lună cu lățime de bandă nemăsurată - o opțiune care elimină limitele de transfer de date și costurile imprevizibile.

Cu caracteristici precum scalabilitate geografică, implementare instantanee și suport 24/7, puteți scala operațiunile AI fără probleme. Fie că gestionați instruirea distribuită pe regiuni sau implementați modele de inferență de margine, infrastructura fiabilă elimină multe dintre obstacolele tehnice care adesea încetinesc proiectele AI.

Obținerea succesului în IA necesită un amestec perfect de putere GPU, gestionare precisă a resurselor și găzduire fiabilă. Urmând aceste strategii și valorificând infrastructura FDC Servers, puteți deschide calea către performanțe AI de vârf.

Întrebări frecvente

Cum face virtualizarea GPU ca sarcinile de lucru AI să fie mai eficiente și mai rentabile?

Virtualizarea GPU permite mai multor mașini virtuale să utilizeze un singur GPU fizic, sporind eficiența și reducând în același timp costurile. Prin partajarea resurselor, se elimină nevoia de hardware suplimentar, utilizând mai bine ceea ce este deja disponibil și reducând cheltuielile generale.

Această configurație face, de asemenea, scalarea și gestionarea mult mai ușoară. Organizațiile pot prelua mai multe sarcini de lucru AI fără a avea nevoie de un GPU separat pentru fiecare mașină virtuală. Rezultatul? Performanță raționalizată și costuri controlate - o combinație ideală pentru AI și proiectele de învățare automată.

Care este diferența dintre passthrough-ul GPU și partiționarea vGPU și când ar trebui să le utilizați pe fiecare?

Atunci când vine vorba de GPU passthrough, întregul GPU este dedicat unei singure mașini virtuale (VM), oferind o performanță care este aproape imposibil de distins de rularea pe hardware fizic. Acest lucru o face o opțiune de bază pentru sarcini solicitante, cum ar fi formarea de modele AI, învățarea profundă sau randarea 3D, unde este esențial să se obțină fiecare gram de performanță.

În schimb, partiționarea vGPU împarte un singur GPU în mai multe segmente bazate pe hardware, permițând mai multor VM-uri sau utilizatori să partajeze același GPU simultan. Această configurație funcționează cel mai bine pentru mediile partajate, cum ar fi desktop-urile virtuale sau stațiile de lucru colaborative, unde prioritatea este echilibrarea flexibilității și utilizarea eficientă a resurselor.

Care sunt cele mai bune instrumente și strategii pentru monitorizarea și optimizarea volumelor de lucru AI în mediile virtualizate GPU?

Pentru a profita la maximum de sarcinile de lucru AI în mediile virtualizate cu GPU, este esențial să se utilizeze instrumente de monitorizare GPU care oferă date în timp real privind utilizarea resurselor și performanța. De exemplu, soluțiile NVIDIA de gestionare a vGPU facilitează urmărirea utilizării GPU și optimizarea modului în care sunt distribuite resursele.

O altă abordare cheie este utilizarea platformelor de orchestrare precum Kubernetes. Aceste platforme pot ajusta dinamic sarcinile de lucru și pot aloca resursele mai eficient, ajutându-vă să obțineți performanțe GPU mai bune. În plus, reglarea periodică a hiperparametrilor și rafinarea conductelor de date joacă un rol important în menținerea unor niveluri ridicate de performanță. Prin monitorizarea continuă a parametrilor GPU, puteți identifica din timp blocajele și puteți evita conflictele de resurse, asigurându-vă că sarcinile AI se desfășoară fără probleme.

Cum să instalați și să utilizați Redis pe un VPS

Aflați cum să instalați și să configurați Redis pe un VPS pentru performanță optimă, securitate și gestionare în aplicațiile dvs.

9 min citire - 7 ianuarie 2026

Monitorizarea serverului dvs. dedicat sau VPS, care sunt opțiunile în 2025?

12 min citire - 28 noiembrie 2025

Aveți întrebări sau aveți nevoie de o soluție personalizată?

Opțiuni flexibile

Acoperire globală

Implementare instantanee

Opțiuni flexibile

Acoperire globală

Implementare instantanee