Como identificar estrangulamentos no escalonamento de servidores

8 min de leitura - 22 de setembro de 2025

Saiba como identificar e corrigir estrangulamentos de desempenho no escalonamento de servidores para melhorar a experiência do utilizador e otimizar a utilização de recursos.

Como identificar estrangulamentos no escalonamento de servidores

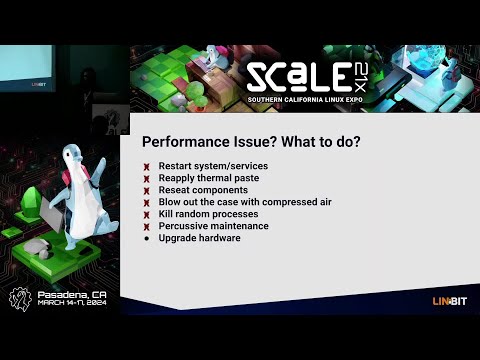

O escalonamento de servidores não se trata apenas de adicionar recursos - trata-se de encontrar e corrigir os estrangulamentos que limitam o desempenho. Estes estrangulamentos podem causar atrasos, falhas e más experiências de utilizador, mesmo com hardware atualizado. Para resolver isso, concentre-se em:

- Métricas de linha de base: Medir o uso da CPU, memória, E/S de disco, taxa de transferência de rede e tempos de resposta em condições normais.

- Ferramentas de monitoramento: Use plataformas como New Relic, Grafana e JMeter para rastrear o desempenho e simular o tráfego.

- Testes: Realize testes de carga e estresse para identificar pontos de rutura.

- Análise: Examine os logs, o uso de recursos e o desempenho do banco de dados para identificar ineficiências.

- Correcções: Otimizar o código, atualizar o hardware (por exemplo, SSDs) e implementar o escalonamento horizontal quando necessário.

Diagnosticando gargalos de desempenho em sistemas de produção

Configurando linhas de base de desempenho

Ter dados de linha de base é crucial para identificar se as alterações no desempenho do servidor são flutuações de rotina ou gargalos reais. As linhas de base fornecem um ponto de referência, facilitando a identificação de desvios do comportamento típico do servidor.

Para criar linhas de base precisas, reúna dados de desempenho que reflictam os padrões normais de tráfego diário e semanal.

Principais métricas a monitorizar

O rastreamento das métricas corretas é essencial para identificar problemas de desempenho com antecedência.

- Utilização da CPU: Mostra a quantidade de poder de processamento que o servidor está a utilizar em qualquer momento. Embora os intervalos aceitáveis dependam da sua configuração específica, a monitorização da utilização da CPU pode revelar quando o seu sistema está sobrecarregado ou subutilizado.

- Utilização da memória: Este rastreia a quantidade de RAM que as suas aplicações estão a consumir. Uma utilização elevada e prolongada da memória pode forçar o sistema a depender de um espaço de troca mais lento baseado no disco, diminuindo significativamente o desempenho.

- Métricas de E/S do disco: Medem a eficiência com que o armazenamento lê e grava dados. As principais métricas incluem IOPS (operações de entrada/saída por segundo) e latência do disco. Por exemplo, os discos rígidos tradicionais normalmente atingem 100-200 IOPS com latência de 10-15 milissegundos, enquanto os SSDs NVMe podem fornecer IOPS muito mais altos com latência de sub-milissegundos.

- Taxa de transferência de rede: Mede as taxas de transferência de dados em Mbps ou Gbps. É vital monitorizar a largura de banda de entrada e de saída, juntamente com as taxas de perda de pacotes. A perda de pacotes superior a 0,1% indica frequentemente congestionamento da rede ou problemas de hardware.

- Tempos de resposta: Os tempos de resposta reflectem a rapidez com que as suas aplicações tratam os pedidos. Para aplicações Web, os tempos de resposta dentro de algumas centenas de milissegundos são ideais. Uma pesquisa da Google salienta que as páginas móveis que demoram três ou mais segundos a carregar registam uma taxa de abandono de 53%.

- Métricas específicas da aplicação: Estas variam consoante a sua pilha de software, mas podem incluir tempos de consulta da base de dados, taxas de acerto da cache ou contagens de ligações activas. Por exemplo, consultas rápidas à base de dados e altas taxas de acerto do cache são essenciais para manter um bom desempenho geral.

A monitorização regular destas métricas garante que pode resolver os problemas de desempenho antes de ser necessário aumentar a escala.

Benchmarking e registo de dados

Para estabelecer linhas de base fiáveis, execute os seus servidores sob cargas de produção normais durante, pelo menos, duas semanas. Registe os dados em intervalos regulares - a cada 5-10 minutos é um bom equilíbrio entre detalhe e eficiência de armazenamento.

O benchmarking de pico de carga também é importante. Meça o desempenho do seu sistema durante os períodos de tráfego mais intenso para antecipar futuras necessidades de escalonamento.

Ao documentar os dados de linha de base, inclua carimbos de data/hora, valores de métrica e contexto relevante. Este registo detalhado ajudá-lo-á a comparar o desempenho antes e depois dos esforços de escalonamento.

As medições de tempo de atividade são outro componente crítico. Por exemplo:

- 99% de tempo de atividade equivale a cerca de 7 horas de tempo de inatividade por mês.

- O tempo de atividade de 99,9% reduz o tempo de inatividade para cerca de 45 minutos por mês.

- O padrão de ouro, 99,999% de tempo de atividade (cinco noves), permite apenas 30 segundos de tempo de inatividade por mês.

Também pode considerar a utilização da pontuação Apdex para avaliar a satisfação do utilizador com os tempos de resposta. Esta pontuação varia de 0 (mau) a 1 (excelente), categorizando os tempos de resposta em zonas de satisfação, tolerância e frustração. Uma pontuação superior a 0,85 indica geralmente uma experiência de utilizador positiva.

Armazene os seus dados de base num sistema centralizado para facilitar o acesso e a comparação. As bases de dados de séries temporais ou as plataformas de monitorização são normalmente utilizadas para reter dados históricos, tornando mais simples determinar se as alterações de desempenho se devem a problemas de escala ou de sistema subjacentes.

Com estas linhas de base implementadas, está pronto para passar às ferramentas e técnicas de monitorização do desempenho em tempo real.

Ferramentas de monitorização e análise

As ferramentas de monitorização corretas podem transformar dados brutos em informações acionáveis, ajudando-o a detetar estrangulamentos antes que estes perturbem as experiências dos utilizadores. Com uma variedade de funcionalidades, como alertas em tempo real e análise aprofundada do desempenho, a escolha das ferramentas certas torna-se essencial para identificar e resolver problemas de forma eficaz.

Principais ferramentas de monitorização

As plataformas de monitorização do desempenho das aplicações (APM), como a New Relic, são indispensáveis para acompanhar as métricas das aplicações e as experiências dos utilizadores. Estas ferramentas capturam automaticamente dados chave como tempos de resposta, taxas de erro e traços de transação. Recursos como rastreamento distribuído facilitam a identificação de consultas de banco de dados lentas ou chamadas de API lentas.

O Grafana é uma ferramenta de visualização versátil que se integra a várias fontes de dados. Quando emparelhado com bancos de dados de séries temporais, como Prometheus ou InfluxDB, o Grafana se destaca na criação de painéis que vinculam métricas - como correlacionar picos de CPU com tempos de resposta mais lentos - facilitando a identificação de problemas de desempenho em um relance.

O Apache JMeter é uma ferramenta de teste de carga que simula ativamente o tráfego de utilizadores para medir como os sistemas lidam com utilizadores simultâneos. Ao gerar tráfego e testar o rendimento do servidor em várias condições, o JMeter ajuda a identificar pontos de rutura e limitações de recursos antes de afectarem os ambientes de produção.

O ELK Stack (Elasticsearch, Logstash e Kibana) centra-se na análise de registos e nas capacidades de pesquisa. O Logstash reúne e processa dados de registo, o Elasticsearch torna-os pesquisáveis e o Kibana visualiza os resultados. Esta combinação é ideal para identificar padrões de erro, acompanhar frequências de eventos e associar registos a quedas de desempenho.

As ferramentas de monitorização ao nível do sistema, como o Nagios, o Zabbix e o Datadog, fornecem uma visão panorâmica das métricas da infraestrutura. Estas plataformas monitorizam dados críticos de hardware, como a utilização da CPU, consumo de memória, E/S do disco e tráfego de rede, o que as torna essenciais para detetar estrangulamentos relacionados com o hardware e planear actualizações de capacidade.

As ferramentas de monitorização de bases de dados, como o pgAdmin para PostgreSQL ou o MySQL Enterprise Monitor, oferecem informações especializadas sobre o desempenho da base de dados. Estas ferramentas acompanham métricas como tempos de execução de consultas, contenção de bloqueios e utilização do buffer pool - detalhes que os monitores de uso geral podem ignorar, mas que são cruciais para otimizar o desempenho da base de dados.

Cada tipo de ferramenta serve um objetivo único: as ferramentas APM centram-se no desempenho das aplicações, os monitores do sistema tratam das métricas de hardware e as ferramentas de bases de dados especializam-se na análise do armazenamento e das consultas. Muitas organizações utilizam uma mistura destas ferramentas para cobrir toda a sua pilha tecnológica, assegurando a resolução imediata de problemas e a otimização do desempenho a longo prazo.

Dados em tempo real vs. dados históricos

A monitorização em tempo real oferece visibilidade imediata do desempenho do sistema, permitindo que as equipas respondam rapidamente a problemas emergentes. Os painéis de controlo são actualizados a cada poucos segundos, apresentando métricas em tempo real, como a utilização da CPU, ligações activas e tempos de resposta. Isto é fundamental para detetar picos de tráfego repentinos, fugas de memória ou componentes com falhas antes que se transformem em problemas maiores.

Os alertas em tempo real são acionados quando as métricas ultrapassam limites predefinidos - como a utilização da CPU superior a 80% ou os tempos de resposta superiores a 2 segundos. Estes alertas permitem que as equipas resolvam os problemas em minutos, minimizando o tempo de inatividade.

A análise de dados históricos, por outro lado, revela tendências a longo prazo e padrões recorrentes que a monitorização em tempo real pode não detetar. Ao examinar os dados ao longo de semanas ou meses, as equipas podem identificar flutuações de tráfego sazonais, declínios de desempenho graduais ou estrangulamentos recorrentes. Por exemplo, um aumento de 15% nos tempos de consulta da base de dados ao longo de três meses pode indicar volumes de dados crescentes ou consultas ineficientes que necessitam de otimização.

A análise histórica também apoia o planeamento da capacidade. Tendências como o aumento da utilização da memória ou a escalada dos volumes de tráfego ajudam a prever quando os recursos atingirão os seus limites, permitindo escalonamentos ou actualizações proactivas.

A combinação de ambas as abordagens cria uma estratégia de monitorização completa. Os dados em tempo real fornecem feedback imediato para a gestão de crises, enquanto a análise histórica informa as decisões estratégicas para evitar problemas futuros. Muitas ferramentas modernas integram perfeitamente ambas, oferecendo painéis de controlo em tempo real juntamente com o armazenamento de dados históricos, para que as equipas possam alternar sem esforço entre a resolução de problemas a curto prazo e o planeamento a longo prazo.

Os melhores resultados surgem quando as equipas revêem regularmente os alertas em tempo real para resolver problemas imediatos e analisam as tendências históricas para tomar decisões mais inteligentes de escalonamento e otimização. Esta abordagem dupla garante que os sistemas permaneçam eficientes e resistentes ao longo do tempo.

Como encontrar estrangulamentos passo a passo

Depois de estabelecer métricas de linha de base e configurar ferramentas de monitorização, o passo seguinte é identificar os estrangulamentos. Isto envolve testar, monitorizar e analisar sistematicamente o seu sistema sob carga para identificar onde surgem os problemas de desempenho.

Testes de carga e de stress

Os testes de carga ajudam-no a avaliar o desempenho do seu sistema sob uma procura típica do utilizador. Comece por definir os seus objectivos de desempenho, tais como tempos de resposta aceitáveis, objectivos de débito e limites de taxa de erro. Estes objectivos funcionam como pontos de referência para detetar desvios. Ferramentas como o JMeter ou o Gatling podem simular o tráfego e aumentar gradualmente a carga até que o desempenho comece a degradar-se.

Os testes de stress, por outro lado, levam o sistema para além dos seus limites normais para revelar pontos de rutura. Durante ambos os testes, fique de olho em métricas como o uso da CPU, o consumo de memória e a largura de banda da rede. Por exemplo, a utilização da CPU próxima dos 100%, os picos de memória ou a largura de banda máxima estão frequentemente relacionados com tempos de resposta mais lentos ou taxas de erro mais elevadas.

A monitorização de utilizadores reais (RUM) pode complementar estes testes sintéticos, fornecendo dados sobre as experiências reais dos utilizadores. Isto pode revelar pontos de estrangulamento que os testes controlados podem não detetar.

O passo seguinte é analisar a utilização de recursos para identificar as causas principais dos problemas de desempenho.

Análise de recursos

Compare os dados de utilização de recursos com as suas métricas de base para descobrir restrições ocultas. Aqui está o que procurar:

- CPU: Os estrangulamentos ocorrem frequentemente quando a utilização excede consistentemente os 80% ou regista picos inesperados.

- Memória: A utilização elevada ou irregular pode indicar fugas de memória ou ineficiências.

- E/S de disco: Monitorize a utilização elevada ou os longos tempos de espera, que podem abrandar as operações.

- Rede: Verifique o uso da largura de banda e a latência para identificar respostas lentas da API ou tempos limite.

- Desempenho do banco de dados: Utilize ferramentas como o MySQL Workbench ou o SQL Profiler para analisar os tempos de execução das consultas, a indexação e o bloqueio de transacções. As consultas que demoram mais de 100 milissegundos podem indicar operações ineficientes, como o processamento linha a linha (RBAR), que precisam de otimização.

Análise de logs e rastreamento

Os registos e rastreios fornecem informações críticas quando combinados com métricas de linha de base e em tempo real. Os logs podem destacar erros recorrentes, timeouts ou avisos de recursos que sinalizam gargalos. Por exemplo, mensagens de tempo limite ou erros relacionados com limites de recursos apontam muitas vezes diretamente para áreas problemáticas.

As ferramentas de rastreamento distribuído, como o OpenTelemetry com Jaeger, permitem rastrear a jornada de uma solicitação nos microsserviços, revelando atrasos causados por consultas lentas a bancos de dados, tempos limite de API ou dependências de serviço problemáticas. A instrumentação detalhada, como o registo das horas de início e fim das operações, pode ajudar a identificar secções de código que consomem recursos excessivos. Da mesma forma, os registos de consultas à base de dados podem expor ineficiências como as operações RBAR.

A contenção de threads é outra área que merece ser examinada. A análise de despejos de thread pode revelar deadlocks, thread starvation ou troca excessiva de contexto, que podem reduzir o desempenho. A captura de instantâneos de rastreamento de pilha durante picos de desempenho pode identificar ainda mais os caminhos de código exatos que causam atrasos.

Entre março e novembro de 2020, o Miro teve um aumento de sete vezes no uso, atingindo mais de 600.000 usuários únicos por dia. Para resolver os gargalos do servidor durante esse rápido dimensionamento, a equipe de sistemas do Miro se concentrou no monitoramento do tempo médio de conclusão da tarefa (percentil) em vez de médias ou tamanhos de fila. Esta abordagem ajudou-os a otimizar os processos que afectavam a maioria dos utilizadores.

Fontes comuns de gargalos e seus efeitos

Compreender os estrangulamentos é crucial para direcionar os esforços de monitorização e acelerar os tempos de resposta. Diferentes estrangulamentos deixam traços distintos, que podem ajudá-lo a identificar e resolver problemas de forma eficaz.

Aqui está uma análise das fontes de estrangulamento mais frequentes, os seus sinais de aviso, métodos de deteção e como limitam a escalabilidade:

Mergulhar mais fundo nos estrangulamentos

Os estrangulamentos da CPU ocorrem mais frequentemente durante picos de tráfego. Quando a utilização da CPU excede os 80%, o sistema começa a colocar os pedidos em fila de espera, levando a atrasos e timeouts. Nesta altura, o escalonamento horizontal torna-se frequentemente a única solução viável.

Os problemas de memória tendem a ser silenciosos até que a utilização da RAM se aproxime de níveis críticos. Quando isso acontece, as aplicações podem falhar ou ficar significativamente mais lentas devido a sobrecargas de recolha de lixo, obrigando a actualizações dispendiosas ou a esforços de otimização.

Os estrangulamentos da base de dados são um desafio comum no escalonamento de aplicações Web. Sintomas como tempos limite de consulta e pools de ligação esgotados podem prejudicar o desempenho, exigindo muitas vezes o agrupamento da base de dados ou a adição de réplicas de leitura para distribuir a carga.

As restrições de rede aparecem normalmente quando se lida com ficheiros grandes ou chamadas frequentes à API. A latência elevada ou a perda de pacotes, especialmente em diferentes regiões, indica frequentemente a necessidade de redes de distribuição de conteúdos (CDN) ou outras estratégias de distribuição.

Os estrangulamentos no armazenamento surgem à medida que a procura de dados aumenta. As unidades tradicionais com IOPS limitado podem abrandar as operações de ficheiros e as gravações em bases de dados, tornando os SSD ou as arquitecturas de armazenamento distribuído essenciais para manter o desempenho.

Os estrangulamentos no código da aplicação são únicos porque resultam de ineficiências na conceção ou implementação, como fugas de memória ou estratégias de cache deficientes. A correção destes problemas requer muitas vezes uma análise aprofundada do perfil, refactoring, ou mesmo a reformulação da arquitetura para lidar com as exigências de escalonamento.

Resolvendo gargalos para melhor escalabilidade

Gargalos de hardware como CPU e memória podem às vezes ser mitigados com escalonamento vertical, mas essa abordagem tem limites. Eventualmente, o escalonamento horizontal torna-se inevitável. Por outro lado, os estrangulamentos da base de dados e do código da aplicação requerem normalmente um trabalho de otimização antes que os recursos adicionais possam ser totalmente eficazes.

Correção de estrangulamentos para um melhor escalonamento

Uma vez identificados os estrangulamentos, o passo seguinte é resolvê-los eficazmente. O objetivo é atacar as causas de raiz e não apenas os sintomas, garantindo que a sua infraestrutura pode lidar com o crescimento futuro sem se deparar com os mesmos problemas.

Correção dos estrangulamentos identificados

Gargalos de CPU: Se a utilização da CPU exceder regularmente os 80%, é altura de agir. Comece por otimizar o seu código - simplifique os algoritmos ineficientes e reduza as operações que consomem muitos recursos. Embora a atualização do hardware (escalonamento vertical) possa proporcionar um alívio imediato, é apenas uma solução temporária. Para uma escalabilidade a longo prazo, implemente o balanceamento de carga e a escalabilidade horizontal para distribuir as cargas de trabalho por vários servidores, uma vez que um único servidor acabará por atingir os seus limites.

Problemas de memória: Utilize ferramentas de criação de perfis para detetar fugas de memória e otimizar a forma como a sua aplicação atribui memória. Atualizar a sua RAM é uma boa solução a curto prazo, mas para uma melhor escalabilidade, considere a possibilidade de conceber aplicações sem estado. Estas distribuem as cargas de memória por várias instâncias, tornando o seu sistema mais resistente.

Gargalos na base de dados: As consultas lentas são frequentemente as culpadas. Optimize-as e adicione índices adequados para acelerar o processo. Outras estratégias incluem o uso de pooling de conexões, a configuração de réplicas de leitura para distribuir as cargas de consulta e a fragmentação de bancos de dados para aplicativos que exigem muita gravação. A atualização para SSDs NVMe também pode proporcionar um aumento significativo no desempenho.

Restrições de rede: Se sua rede estiver com dificuldades, considere atualizar sua largura de banda e usar CDNs para reduzir a distância que os dados precisam percorrer. Comprima as respostas e minimize o tamanho da carga útil para tornar as transferências de dados mais eficientes. Para públicos globais, a implantação de servidores em várias localizações geográficas pode ajudar a reduzir a latência.

Gargalos de armazenamento: Substitua os discos rígidos tradicionais por SSDs para lidar com IOPS (operações de entrada/saída por segundo) mais elevados. Para uma gestão mais eficiente do armazenamento, utilize sistemas de armazenamento distribuídos e cargas de trabalho separadas - por exemplo, armazenamento de alto desempenho para bases de dados e armazenamento padrão para cópias de segurança.

Estas estratégias funcionam melhor quando combinadas com um ambiente de alojamento que suporte a escalabilidade.

Utilizar soluções de alojamento escaláveis

A infraestrutura de hospedagem moderna é um componente-chave na resolução e prevenção de gargalos. A FDC Servers oferece opções de hospedagem adaptadas aos desafios de escalabilidade, como servidores dedicados não medidos que eliminam limitações de largura de banda e soluções VPS alimentadas por processadores EPYC com armazenamento NVMe para desempenho máximo.

Os seus planos de servidores dedicados, a partir de $129/mês, são altamente personalizáveis. Com acesso à raiz e a capacidade de modificar o hardware, pode resolver problemas de desempenho sem ficar preso a planos de alojamento rígidos. Além disso, a largura de banda ilimitada garante que os estrangulamentos da rede não o vão atrasar.

Para cargas de trabalho que requerem um poder de processamento avançado, os servidores GPU (a partir de $1.124/mês) fornecem os recursos necessários para IA, aprendizagem automática e outras aplicações intensivas. Esses servidores também vêm com largura de banda ilimitada e configurações personalizáveis para atender a demandas específicas.

Para lidar com a latência da rede, a distribuição global é fundamental. Os servidores FDC operam em mais de 70 locais em todo o mundo, permitindo que você implante servidores mais próximos de seus usuários para tempos de resposta mais rápidos. Seus serviços CDN aprimoram ainda mais a entrega de conteúdo com pontos de presença globais otimizados.

Precisa de recursos rapidamente? A sua funcionalidade de implementação instantânea permite-lhe aumentar a escala rapidamente, evitando atrasos no aprovisionamento de hardware. Isto é especialmente útil para lidar com picos de tráfego repentinos ou resolver problemas de desempenho num curto espaço de tempo.

A incorporação destas soluções de alojamento pode melhorar significativamente a sua capacidade de ultrapassar estrangulamentos e preparar-se para o crescimento futuro.

Monitorização e revisão contínuas

A monitorização contínua é essencial para garantir que as suas correcções permanecem eficazes ao longo do tempo. Configure alertas automáticos para métricas importantes, como utilização da CPU superior a 75%, utilização de memória superior a 85% ou tempos de resposta que ultrapassem os limites aceitáveis.

Agende revisões mensais de desempenho para acompanhar as tendências e detetar problemas emergentes. Mantenha-se atento às métricas de crescimento e preveja quando os seus recursos actuais podem ficar aquém das necessidades. Ao planear as actualizações de forma proactiva, pode evitar correcções de emergência dispendiosas que perturbam a experiência do utilizador.

Os testes de carga regulares são outro passo fundamental. Teste o seu sistema com picos de carga previstos e simule picos de tráfego repentinos para garantir que as suas correcções conseguem lidar com as condições do mundo real. O aumento gradual da carga e os testes de stress podem revelar vulnerabilidades ocultas antes de se tornarem problemas.

Finalmente, documente cada incidente de estrangulamento e a sua resolução. Isto cria uma base de conhecimentos valiosa para a sua equipa, facilitando a resolução de problemas semelhantes no futuro. O acompanhamento da eficácia das suas soluções também ajudará a aperfeiçoar as suas estratégias ao longo do tempo, garantindo que a sua infraestrutura se mantém robusta à medida que as suas necessidades evoluem.

Conclusão

Para enfrentar os desafios de escalonamento de forma eficaz, comece por estabelecer linhas de base claras e monitorizar o seu sistema de forma consistente. Comece por medir as principais métricas, como a utilização da CPU, a memória, as E/S do disco e o débito da rede, para compreender o desempenho típico do seu sistema. Estes parâmetros de referência ajudá-lo-ão a identificar anomalias quando estas surgirem.

Utilize painéis de controlo em tempo real e dados históricos para detetar e resolver problemas antes que estes perturbem a experiência do utilizador. Ferramentas como o teste de carga e a análise de registos são inestimáveis para avaliar o desempenho sob stress e identificar pontos fracos na sua infraestrutura. Os estrangulamentos comuns, como a sobrecarga da CPU, as fugas de memória, os abrandamentos da base de dados, o congestionamento da rede e as limitações de armazenamento exigem soluções específicas e direcionadas.

No entanto, corrigir os estrangulamentos não é suficiente por si só. O verdadeiro fator de mudança reside na monitorização proactiva e na infraestrutura escalável. Um sistema concebido para se adaptar à crescente procura garante fiabilidade a longo prazo, evitando problemas recorrentes. As opções de alojamento modernas, como os servidores FDC, oferecem soluções escaláveis com implementação rápida e uma rede global que abrange mais de 70 locais. Essa flexibilidade permite que você resolva problemas de desempenho rapidamente sem esperar por um novo hardware.

O segredo para um escalonamento bem-sucedido é manter-se vigilante. Configure alertas automáticos, efectue verificações de desempenho regulares e mantenha registos detalhados de estrangulamentos anteriores para referência futura. Lembre-se, o escalonamento não é uma tarefa única - é um processo contínuo que evolui a par da sua infraestrutura e das necessidades dos utilizadores. Com a combinação certa de monitorização, ferramentas e soluções de alojamento escaláveis, pode criar um sistema que não só satisfaz as exigências actuais, como também está preparado para o crescimento futuro.

Perguntas frequentes

Quais são as melhores formas de resolver os estrangulamentos da base de dados ao escalar servidores?

Para resolver os estrangulamentos da base de dados ao dimensionar os servidores, comece por distribuir o tráfego de forma mais uniforme. Isto pode ser feito com ferramentas como balanceadores de carga ou camadas de cache, que ajudam a aliviar a pressão sobre a sua base de dados. Mantenha-se atento às principais métricas utilizando ferramentas de monitorização - acompanhe aspectos como tempos de resposta, taxas de erro, utilização da CPU, memória, E/S do disco e atividade de rede para identificar problemas antes que estes se agravem.

Para os desafios de armazenamento e desempenho, considere soluções de escalonamento, como o escalonamento vertical (atualização do hardware), o escalonamento horizontal (adição de mais servidores) ou a fragmentação da base de dados. Também é possível melhorar a eficiência optimizando as consultas de bases de dados e assegurando uma indexação adequada. Ao manter-se proactivo com a monitorização e o ajuste fino, manterá o seu sistema a funcionar sem problemas à medida que os seus servidores crescem.

Como posso saber se os problemas de desempenho do meu servidor são causados por limitações de hardware ou código de aplicação ineficiente?

Para descobrir se o desempenho lento do seu servidor se deve a limites de hardware ou a um código de aplicação mal optimizado, comece por observar as principais métricas do sistema, como a utilização da CPU, o consumo de memória, as E/S do disco e a atividade da rede. Se estas métricas estiverem constantemente no máximo, é um forte sinal de que o seu hardware pode estar a ter dificuldades em acompanhar o ritmo. No entanto, se as métricas de hardware parecerem boas, mas as aplicações continuarem a registar atrasos, o problema pode estar enterrado no código.

As ferramentas de monitorização do desempenho e os registos do servidor são os recursos essenciais para aprofundar a questão. Procure pistas como consultas de bases de dados lentas, loops ineficientes ou processos que consomem muitos recursos. Os testes de rotina e a afinação são cruciais para garantir que o seu servidor consegue lidar com o crescimento e funcionar sem problemas à medida que as exigências aumentam.

Quais são as vantagens das ferramentas de monitorização em tempo real em relação à utilização de dados históricos para gerir a escalabilidade do servidor?

As ferramentas de monitorização em tempo real são um fator de mudança quando se trata de manter os sistemas a funcionar sem problemas. Fornecem alertas instantâneos e informações acionáveis, ajudando-o a resolver os problemas à medida que vão surgindo. Este tipo de feedback imediato é fundamental para evitar problemas de desempenho durante o escalonamento do servidor. Além disso, garante que os seus recursos são atribuídos de forma eficiente, o que é crucial para gerir cargas de trabalho em constante mudança.

Entretanto, a análise de dados históricos é excelente quando se trata de detetar tendências a longo prazo ou de descobrir as causas de problemas passados. Mas há um senão - se confiar apenas nos dados históricos, pode perder a oportunidade de agir rapidamente sobre os problemas actuais. Esse atraso pode levar a períodos de inatividade ou a estrangulamentos no desempenho. Embora ambos os métodos tenham o seu lugar, a monitorização em tempo real é indispensável para fazer ajustes rápidos e manter os servidores com o melhor desempenho em ambientes de ritmo acelerado.

Como instalar e usar o Redis em um VPS

Saiba como instalar e configurar o Redis num VPS para obter o melhor desempenho, segurança e gestão nas suas aplicações.

9 min de leitura - 7 de janeiro de 2026

Monitorizar o seu servidor dedicado ou VPS, quais são as opções em 2025?

12 min de leitura - 28 de novembro de 2025