Obciążenia AI w zwirtualizowanych środowiskach GPU: Przewodnik po optymalizacji

11 min czytania - 10 października 2025

- Obciążenia AI w zwirtualizowanych środowiskach GPU: Przewodnik po optymalizacji

- Podstawy wirtualizacji GPU dla AI

- Infrastruktura AI/ML: Wyjaśnienie technologii Time-Slicing GPU

- Wymagania sprzętowe i infrastrukturalne

- Konfiguracja maszyny wirtualnej i GPU

- Monitorowanie wydajności i planowanie

- Serwery FDC dla infrastruktury AI

- Podsumowanie

- Często zadawane pytania

Dowiedz się, w jaki sposób wirtualizacja GPU zwiększa obciążenia związane ze sztuczną inteligencją poprzez poprawę wydajności, redukcję kosztów i optymalizację zarządzania zasobami w środowiskach zwirtualizowanych.

- Obciążenia AI w zwirtualizowanych środowiskach GPU: Przewodnik po optymalizacji

- Podstawy wirtualizacji GPU dla AI

- Infrastruktura AI/ML: Wyjaśnienie technologii Time-Slicing GPU

- Wymagania sprzętowe i infrastrukturalne

- Konfiguracja maszyny wirtualnej i GPU

- Monitorowanie wydajności i planowanie

- Serwery FDC dla infrastruktury AI

- Podsumowanie

- Często zadawane pytania

Obciążenia AI w zwirtualizowanych środowiskach GPU: Przewodnik po optymalizacji

Wirtualizacja GPU zmienia sposób zarządzania obciążeniami AI. Dzieląc fizyczny układ GPU na wiele wirtualnych instancji, można uruchomić kilka zadań AI jednocześnie, zwiększając wydajność i zmniejszając koszty sprzętu. Takie podejście jest szczególnie cenne w przypadku trenowania złożonych modeli, obsługi zadań wymagających dużej ilości zasobów i skalowania projektów AI bez konieczności inwestowania w dodatkowe układy GPU.

Oto dlaczego ma to znaczenie:

- Efektywne wykorzystanie GPU: Unikanie bezczynności sprzętu dzięki współdzieleniu zasobów między zadaniami i zespołami.

- Oszczędność kosztów: Wysokowydajne układy GPU są drogie; wirtualizacja zapewnia ich maksymalne wykorzystanie.

- Elastyczność: Dostosowanie wirtualnych instancji GPU do konkretnych potrzeb, takich jak rozmiar pamięci lub wersje CUDA.

- Skalowalność: Dynamiczne dostosowywanie zasobów w miarę wzrostu obciążeń AI.

- Niezawodność: Izolowane instancje zapobiegają wpływowi jednego zadania na inne.

Optymalizacja wydajności:

- Wybierz układy GPU z dużą pamięcią i przepustowością (np. NVIDIA A100/H100).

- Do obsługi danych używaj pamięci masowej NVMe i sieci o niskich opóźnieniach.

- Skonfiguruj maszyny wirtualne z funkcją GPU passthrough lub partycjonowaniem vGPU w oparciu o potrzeby obciążenia.

- Wykorzystaj narzędzia takie jak NVIDIA GPU Operator, wtyczki Kubernetes i SLURM do orkiestracji.

- Monitoruj wydajność za pomocą narzędzi takich jak NVIDIA Nsight Systems i DCGM w celu identyfikacji wąskich gardeł.

Usługi hostingowe, takie jak FDC Servers, zapewniają dostosowane do potrzeb rozwiązania GPU już od 1124 USD/miesiąc, w tym niezmierzoną przepustowość i opcje globalnego wdrożenia dla projektów AI na dużą skalę.

Wnioski: Wirtualizacja GPU usprawnia zarządzanie zasobami, zwiększa wydajność i obniża koszty obciążeń AI, co czyni ją praktycznym rozwiązaniem do efektywnego skalowania operacji AI.

Podstawy wirtualizacji GPU dla AI

Czym jest wirtualizacja układów GPU?

Wirtualizacja GPU umożliwia wielu użytkownikom współdzielenie jednego układu GPU poprzez tworzenie wirtualnych instancji, z których każda posiada własną dedykowaną pamięć, rdzenie i moc obliczeniową. Oznacza to, że pojedynczy układ GPU może obsługiwać wiele zadań lub użytkowników w tym samym czasie, co czyni go wydajnym rozwiązaniem dla obciążeń AI.

U podstaw tej technologii leży hiperwizor, który działa jako menedżer, dzieląc zasoby GPU między maszyny wirtualne. Hiperwizor zapewnia, że każda instancja otrzymuje przydzielony jej udział bez zakłóceń ze strony innych. W przypadku zadań związanych ze sztuczną inteligencją, umożliwia to pojedynczemu układowi GPU NVIDIA A100 lub H100 jednoczesne uruchamianie wielu eksperymentów uczenia maszynowego, sesji szkoleniowych lub operacji wnioskowania.

Istnieją dwie główne metody udostępniania tych zasobów:

- Wirtualizacja na poziomie sprzętowym: Technologia Multi-Instance GPU (MIG) firmy NVIDIA fizycznie dzieli procesor graficzny na odizolowane sekcje, zapewniając silną separację między instancjami.

- Wirtualizacja na poziomie oprogramowania: Ta metoda wykorzystuje sterowniki i oprogramowanie do podziału zasobów GPU, oferując większą elastyczność, ale nieco mniejszą izolację.

Jedną z kluczowych różnic pomiędzy GPU a tradycyjną wirtualizacją CPU jest zarządzanie pamięcią. Układy GPU wykorzystują pamięć o wysokiej przepustowości (HBM), która działa inaczej niż standardowa systemowa pamięć RAM. Efektywne zarządzanie tą pamięcią ma krytyczne znaczenie, zwłaszcza podczas operacji AI wymagających dużej ilości zasobów, takich jak dostrajanie lub szkolenie na dużą skalę.

To fundamentalne zrozumienie stanowi podstawę do zbadania, w jaki sposób wirtualizacja GPU zwiększa wydajność sztucznej inteligencji w praktycznych scenariuszach.

Korzyści dla obciążeń związanych ze sztuczną inteligencją i uczeniem maszynowym

Wirtualizacja oferuje szereg korzyści, które bezpośrednio odpowiadają na wyzwania związane z obciążeniami sztucznej inteligencji i uczenia maszynowego (ML).

Jedną z wyróżniających się zalet jest maksymalizacja wykorzystania GPU. Wysokowydajne układy GPU, które mogą kosztować od 10 000 do 30 000 USD, są często niedostatecznie wykorzystywane podczas zadań takich jak wstępne przetwarzanie danych lub konfiguracja modelu. Wirtualizacja zapewnia pełne wykorzystanie tych kosztownych zasobów, umożliwiając wielu zadaniom współdzielenie tego samego układu GPU, skracając czas bezczynności i obniżając koszty sprzętu. Takie podejście umożliwia organizacjom obsługę większej liczby użytkowników i aplikacji bez konieczności stosowania dodatkowych fizycznych układów GPU.

Kolejnym przełomem jest elastyczność w procesie tworzenia oprogramowania. Dzięki wirtualizacji, deweloperzy mogą tworzyć wirtualne instancje GPU dostosowane do konkretnych potrzeb, takich jak różne wersje CUDA, rozmiary pamięci lub konfiguracje sterowników. Izolacja ta zapewnia, że projekty wykorzystujące frameworki takie jak PyTorch, TensorFlow czy JAX mogą współistnieć bez konfliktów, usprawniając przepływy pracy i przyspieszając wprowadzanie innowacji.

Skalowalność staje się znacznie łatwiejsza w zarządzaniu. Obciążenia AI mogą znacznie różnić się pod względem wymagań. Przykładowo, trenowanie małej sieci neuronowej może wymagać minimalnych zasobów, podczas gdy dostrajanie dużego modelu językowego wymaga ogromnej mocy obliczeniowej. Wirtualne instancje mogą dynamicznie skalować się w górę lub w dół, przydzielając zasoby w oparciu o intensywność obciążenia. Ta zdolność adaptacji zapewnia efektywne wykorzystanie zasobów przez cały czas.

Obsługa wielu dzierżawców jest szczególnie cenna dla organizacji o zróżnicowanych potrzebach. Dzięki współdzieleniu infrastruktury, różne działy, klienci lub aplikacje mogą uzyskać dostęp do zasobów GPU bez konieczności zarządzania fizycznym sprzętem. Dostawcy usług w chmurze mogą nawet oferować usługę GPU-as-a-Service, umożliwiając użytkownikom korzystanie z wirtualnych instancji GPU przy jednoczesnym zachowaniu izolacji wydajności i zmniejszeniu złożoności administracyjnej.

Wreszcie, izolacja błędów zapewnia stabilność. Jeśli jedna wirtualna instancja ulegnie awarii lub zużyje nadmierną ilość zasobów, nie zakłóci to działania innych instancji korzystających z tego samego układu GPU. Niezawodność ta ma kluczowe znaczenie w środowiskach produkcyjnych, w których wiele usług AI musi działać płynnie i konsekwentnie.

Wirtualizacja GPU nie tylko optymalizuje wykorzystanie zasobów, ale także zapewnia zespołom AI narzędzia i elastyczność niezbędne do radzenia sobie ze złożonymi, stale zmieniającymi się obciążeniami.

Infrastruktura AI/ML: Wyjaśnienie technologii Time-Slicing GPU

Wymagania sprzętowe i infrastrukturalne

Uzyskanie najlepszej wydajności sztucznej inteligencji w zwirtualizowanych środowiskach GPU zależy w dużej mierze od dokonania właściwego wyboru sprzętu i połączeń. Decyzje te odgrywają kluczową rolę w maksymalizacji potencjału wirtualizacji GPU dla obciążeń AI.

Wybór odpowiedniej architektury GPU

Wybierając układy GPU do zadań AI, należy szukać modeli z dużą pojemnością pamięci, szybką przepustowością i wbudowaną obsługą wirtualizacji. Wiele nowoczesnych układów GPU można podzielić na wiele odizolowanych instancji, umożliwiając różnym użytkownikom lub aplikacjom korzystanie z dedykowanych zasobów obliczeniowych i pamięci. Wybór odpowiedniego układu GPU to jednak tylko część równania - wspierająca go infrastruktura sieciowa i pamięci masowej również musi być w stanie nadążyć za jego wydajnością.

Wymagania dotyczące pamięci masowej i sieci

Obciążenia związane ze sztuczną inteligencją często wiążą się z zarządzaniem ogromnymi ilościami danych, co sprawia, że szybka pamięć masowa NV Me i sieci o niskich opóźnieniach są niezbędne. W środowiskach korporacyjnych dyski NVMe o wysokiej wytrzymałości są idealne do obsługi ciężkich cykli odczytu/zapisu, które występują w aplikacjach AI.

W przypadku wymiany danych między węzłami, technologie takie jak InfiniBand lub zaawansowane rozwiązania Ethernet zapewniają przepustowość niezbędną do płynnego działania. Korzystanie z rozproszonego systemu plików w celu umożliwienia równoległego I/O może pomóc zminimalizować wąskie gardła, gdy wiele procesów uzyskuje dostęp do danych w tym samym czasie. Po zaspokojeniu potrzeb związanych z pamięcią masową i siecią, kolejnym krokiem jest dopracowanie sposobu wyrównania zasobów.

Wyrównanie zasobów i optymalizacja topologii

Aby zoptymalizować wyrównanie zasobów, należy skonfigurować NUMA (Non-Uniform Memory Access) w celu zapewnienia bezpośrednich połączeń między układami GPU, pamięcią i procesorami CPU. Przydziel szybkie interfejsy sieciowe i dedykowane ścieżki PCIe, aby zmniejszyć opóźnienia. Należy pamiętać, że solidne chłodzenie i wystarczająca moc mają kluczowe znaczenie dla uniknięcia dławienia termicznego i utrzymania stabilności systemu. Dodatkowo, umieszczenie pamięci masowej w pobliżu jednostek obliczeniowych może dodatkowo zmniejszyć opóźnienia, tworząc bardziej wydajną i responsywną architekturę systemu.

Konfiguracja maszyny wirtualnej i GPU

Po skonfigurowaniu sprzętu, kolejnym krokiem jest konfiguracja maszyn wirtualnych i procesorów graficznych w celu zapewnienia optymalnej wydajności sztucznej inteligencji. Odpowiednie konfiguracje odblokowują potencjał zwirtualizowanych układów GPU, czyniąc je bardziej efektywnymi dla obciążeń AI. Przyjrzyjmy się, jak skonfigurować te zasoby i efektywnie nimi zarządzać.

Pełny GPU Passthrough vs. partycjonowanie vGPU

Jeśli chodzi o konfiguracje GPU, istnieją dwa główne podejścia: GPU passthrough i vGPU partitioning.

- GPU passthrough dedykuje cały procesor graficzny pojedynczej maszynie wirtualnej, zapewniając niemal natywną wydajność dla wymagających zadań szkoleniowych AI. Taka konfiguracja maksymalizuje moc obliczeniową, ale jednocześnie ogranicza GPU do jednej maszyny wirtualnej, co może być nieefektywne w przypadku mniejszych obciążeń.

- Z kolei partycjonowanie vGPU dzieli układ GPU na wiele wirtualnych wycinków. Podejście to jest bardziej opłacalne w przypadku zadań, które nie wymagają pełnej mocy układu GPU, takich jak obciążenia związane z wnioskowaniem lub mniejsze zadania szkoleniowe.

Nowoczesne układy GPU, takie jak NVIDIA A100 i H100, obsługują technologię MIG (Multi-Instance GPU), umożliwiając utworzenie do siedmiu odizolowanych instancji GPU na jednej karcie. Funkcja ta jest idealna do maksymalizacji wykorzystania sprzętu przy jednoczesnym utrzymaniu kosztów w ryzach.

Właściwy wybór zależy od konkretnego zastosowania:

- W przypadku szkoleń na dużą skalę, takich jak szkolenie modeli językowych lub badania nad głębokim uczeniem, GPU passthrough jest zazwyczaj lepszą opcją.

- W przypadku zadań takich jak obsługa wnioskowania, rozwój lub testowanie, partycjonowanie vGPU oferuje lepszą wydajność zasobów i oszczędność kosztów.

Alokacja zasobów dla maksymalnej równoległości

Efektywna alokacja zasobów jest niezbędna, aby uniknąć wąskich gardeł i zapewnić płynne działanie sztucznej inteligencji. Oto jak zrównoważyć zasoby:

- Alokacja CPU: Przydziel określone rdzenie CPU do każdej maszyny wirtualnej, aby zminimalizować przełączanie kontekstu. Zazwyczaj przydział 4-8 rdzeni CPU na GPU działa dobrze, ale może się to różnić w zależności od struktury AI i złożoności obciążenia.

- Zarządzanie pamięcią: Zaplanuj zarówno systemową pamięć RAM, jak i pamięć GPU. Przydziel co najmniej 16-32 GB pamięci RAM na GPU dla większości zadań AI, rezerwując jednocześnie wystarczającą ilość pamięci dla hiperwizora. Korzystanie z ogromnych stron może również zmniejszyć narzut pamięci w operacjach wymagających dużej ilości danych.

- Pamięć GPU: Podczas korzystania z partycjonowania vGPU należy uważnie monitorować wykorzystanie pamięci GPU. Niektóre frameworki, takie jak PyTorch i TensorFlow, mogą dynamicznie przydzielać pamięć GPU, ale ustalenie limitów gwarantuje, że jedno obciążenie nie zmonopolizuje zasobów.

- Sieć: Włącz SR-IOV (Single Root I/O Virtualization) dla interfejsów sieciowych, aby zapewnić maszynom wirtualnym bezpośredni dostęp sprzętowy. Zmniejsza to opóźnienia sieciowe, co jest szczególnie ważne w przypadku rozproszonego szkolenia AI na wielu węzłach.

Narzędzia do orkiestracji GPU

Po przydzieleniu zasobów, narzędzia do orkiestracji mogą uprościć zarządzanie układami GPU, zwłaszcza w skalowanych środowiskach sztucznej inteligencji.

- NVIDIA GPU Operator: Narzędzie to automatyzuje zadania takie jak instalacja sterowników GPU, konfiguracja środowiska uruchomieniowego kontenera i monitorowanie kondycji w ramach Kubernetes. Zapewnia ono spójne konfiguracje w różnych klastrach i zmniejsza ręczne obciążenie pracą.

- Wtyczki GPU Kubernetes: Wtyczki takie jak NVIDIA device plugin umożliwiają precyzyjne dostosowanie harmonogramu i alokacji GPU. Obsługują one ułamkowe wykorzystanie GPU i umożliwiają precyzyjne zarządzanie zasobami dla obciążeń opartych na Kubernetes.

- SLURM: Harmonogram zadań zaprojektowany z myślą o wysokowydajnych obliczeniach (HPC) i obciążeniach AI, SLURM oferuje takie funkcje jak świadomość topologii GPU, planowanie sprawiedliwego podziału i rezerwacje zasobów. Jest szczególnie przydatny do zarządzania środowiskami z wieloma użytkownikami i wieloma projektami.

- Docker z NVIDIA Container Toolkit: Ta konfiguracja umożliwia kontenerom dostęp do układów GPU przy jednoczesnym zachowaniu izolacji między obciążeniami. Integruje się ona płynnie z platformami orkiestracji, co czyni ją elastyczną opcją wdrażania aplikacji AI.

W miarę rozwoju infrastruktury sztucznej inteligencji narzędzia do orkiestracji stają się niezbędne. Automatyzują one zarządzanie zasobami, poprawiają ich wykorzystanie i zapewniają inteligencję potrzebną do wydajnego uruchamiania wielu obciążeń na współdzielonym sprzęcie.

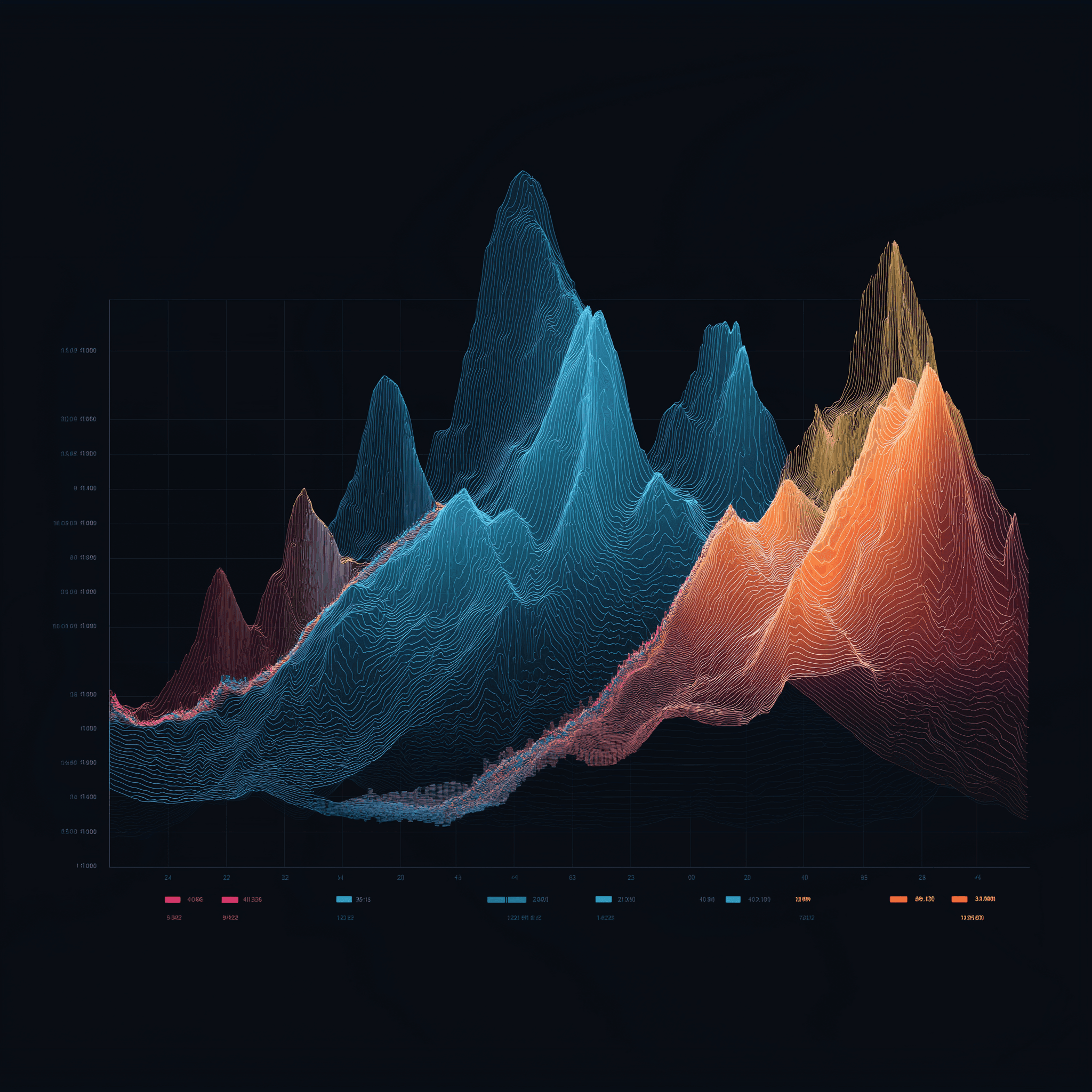

Monitorowanie wydajności i planowanie

Po skonfigurowaniu sprzętu i konfiguracji, następnym krokiem do zapewnienia płynnego działania jest skupienie się na monitorowaniu i planowaniu. Te dwie praktyki stanowią podstawę utrzymania szczytowej wydajności AI w środowiskach zwirtualizowanych GPU. Nawet najlepsza konfiguracja sprzętowa może okazać się niewystarczająca bez odpowiedniego wglądu w wykorzystanie zasobów i inteligentnych strategii planowania. Profilowanie, planowanie i bieżące monitorowanie zapewniają, że obciążenia AI pozostają wydajne i efektywne.

Profilowanie obciążeń AI

Profilowanie jest jak mierzenie pulsu obciążeń AI - pomaga wskazać wąskie gardła i zapewnia rozsądne wykorzystanie zasobów, zanim wydajność spadnie. Celem jest zrozumienie, w jaki sposób różne zadania wykorzystują zasoby GPU, pamięć i cykle obliczeniowe.

NVIDIA Nsight Systems to podstawowe narzędzie do profilowania aplikacji CUDA, zapewniające szczegółowy wgląd w wykorzystanie GPU, transfery pamięci i czasy wykonywania jądra. W przypadku frameworków głębokiego uczenia, narzędzia do profilowania mogą pomóc zidentyfikować, czy obciążenia są związane z GPU, pamięcią lub CPU, co ma kluczowe znaczenie dla precyzyjnego dostrojenia alokacji zasobów.

Narzędzia specyficzne dla frameworka, takie jak TensorFlow Profiler i PyTorch Profiler, sięgają jeszcze głębiej. TensorFlow Profiler rozkłada czasy kroków, pokazując, ile czasu poświęca się na zadania takie jak ładowanie danych, przetwarzanie wstępne i szkolenie. Tymczasem PyTorch Profiler oferuje dokładne spojrzenie na wykorzystanie pamięci, pomagając wychwycić wycieki pamięci lub nieefektywne operacje tensorowe.

Podczas profilowania, kluczowe metryki do obejrzenia obejmują:

- Wykorzystanie GPU: Celuj w co najmniej 80% podczas treningu, aby zapewnić efektywne wykorzystanie.

- Wykorzystanie przepustowości pamięci: Pokazuje, jak dobrze wykorzystywana jest pamięć GPU.

- Wydajność jądra: Wskazuje, jak efektywnie operacje są dostosowane do architektury GPU.

W środowiskach zwirtualizowanych profilowanie staje się nieco trudniejsze ze względu na dodatkową warstwę hiperwizora. Narzędzia takie jak vSphere Performance Charts lub monitorowanie wydajności KVM mogą wypełnić lukę, korelując metryki na poziomie maszyny wirtualnej z danymi profilowania na poziomie gościa. Takie dwuwarstwowe podejście pomaga określić, czy czkawka wydajności wynika z warstwy wirtualizacji, czy z samego obciążenia.

Spostrzeżenia uzyskane z profilowania przekładają się bezpośrednio na inteligentniejsze strategie planowania, zapewniając efektywną alokację zasobów.

AI Workload Scheduling

Harmonogramowanie to miejsce, w którym dzieje się magia - zapewniając efektywne wykorzystanie układów GPU podczas żonglowania wieloma obciążeniami AI. Różne strategie zaspokajają różne potrzeby, od synchronizacji rozproszonych zadań po nadawanie priorytetów krytycznym zadaniom.

- Planowanie grupowe: Idealna do synchronicznego treningu, metoda ta zapewnia, że wszystkie procesy w rozproszonym treningu są wyrównane, więc żaden pracownik nie pozostaje bezczynny.

- Planowanie predykcyjne: Analizując dane historyczne, podejście to przewiduje czasy wykonywania zadań w oparciu o czynniki takie jak rozmiar modelu i charakterystyka zbioru danych, umożliwiając inteligentniejsze rozmieszczanie obciążeń.

- Preemption zadań: Zadania o wysokim priorytecie mogą tymczasowo zepchnąć te o niższym priorytecie. Harmonogramy uwzględniające punkty kontrolne bezpiecznie wstrzymują zadania, zapisują ich stan i wznawiają je później, gdy zasoby się zwolnią.

- Planowanie sprawiedliwego podziału: Śledzi historyczne wykorzystanie i dynamicznie dostosowuje priorytety, aby zapewnić sprawiedliwą dystrybucję zasobów wśród użytkowników lub projektów.

Wybrana metoda planowania może wpłynąć na wydajność systemu. Przykładowo, planowanie wsadowe sprawdza się dobrze w konfiguracjach badawczych z elastycznymi terminami, podczas gdy planowanie w czasie rzeczywistym jest niezbędne dla obciążeń wnioskowania, które wymagają niskich opóźnień.

Po wprowadzeniu harmonogramu, ciągłe monitorowanie zapewnia, że wszystko pozostaje na dobrej drodze.

Monitorowanie i analiza porównawcza

Ciągłe monitorowanie działa jak system wczesnego ostrzegania, wychwytując potencjalne problemy, zanim zakłócą one produkcję. Połączenie wskaźników w czasie rzeczywistym z danymi historycznymi pomaga odkryć trendy i wzorce, które w przeciwnym razie mogłyby pozostać niezauważone.

Narzędzia do monitorowania układów GPU powinny śledzić wszystko, od wykorzystania i użycia pamięci, po temperaturę i zużycie energii. Data Center GPU Manager (DCGM) firmy NVIDIA to solidna opcja, integrująca się z platformami takimi jak Prometheus i Grafana w celu zapewnienia kompleksowego widoku. Narzędzia te mogą pomóc w wykrywaniu problemów, takich jak dławienie termiczne lub presja na pamięć, które mogą negatywnie wpływać na wydajność.

Monitorowanie na poziomie aplikacji koncentruje się na metrykach specyficznych dla sztucznej inteligencji, takich jak straty uczenia, dokładność walidacji i wskaźniki konwergencji. Narzędzia takie jak MLflow i Weights & Biases łączą te metryki z danymi o wydajności systemu, oferując pełny obraz stanu obciążenia.

W przypadku szkoleń rozproszonych monitorowanie sieci jest koniecznością. Ważne jest, aby śledzić wykorzystanie przepustowości, opóźnienia i utratę pakietów między węzłami. Szybkie połączenia, takie jak InfiniBand, wymagają specjalistycznych narzędzi, aby zapewnić płynną synchronizację gradientów i równoległe uczenie danych.

Testy porównawcze pomagają ustalić wartości bazowe wydajności i zweryfikować optymalizacje. Testy porównawcze MLPerf są standardowym wyborem do oceny szkolenia i wnioskowania w różnych modelach sztucznej inteligencji i konfiguracjach sprzętowych. Uruchamianie tych testów w zwirtualizowanym środowisku określa podstawowe oczekiwania i podkreśla kwestie konfiguracyjne.

Przydatne są również syntetyczne testy porównawcze, takie jak te w repozytorium DeepLearningExamples firmy NVIDIA. Symulują one określone scenariusze, pomagając wyizolować koszty ogólne wirtualizacji i potwierdzić, że środowisko działa zgodnie z oczekiwaniami.

Regularne testy porównawcze - powiedzmy raz w miesiącu - mogą ujawnić problemy, takie jak aktualizacje sterowników, dryf konfiguracji lub degradacja sprzętu, które w przeciwnym razie mogłyby pozostać niezauważone.

Serwery FDC dla infrastruktury AI

Aby osiągnąć najwyższą wydajność w systemach AI, posiadanie niezawodnej infrastruktury hostingowej nie podlega negocjacjom. Odpowiedni partner hostingowy zapewnia, że strategie profilowania, planowania i monitorowania działają płynnie, zapewniając szkielet niezbędny do skutecznej optymalizacji obciążeń AI.

Ta stabilna infrastruktura umożliwia zaawansowane wdrażanie omówionych wcześniej technik profilowania, harmonogramowania i orkiestracji.

Serwery GPU dla obciążeń AI

FDC Servers oferuje hosting GPU dostosowany specjalnie do aplikacji AI i uczenia maszynowego. Począwszy od 1124 USD miesięcznie, ich serwery GPU są wyposażone w niezmierzoną przepustowość - niezbędną podczas pracy z dużymi zbiorami danych lub rozproszonym szkoleniem. Funkcja ta eliminuje obawy o limity transferu danych, pomagając utrzymać przewidywalne koszty.

Serwery firmy są wysoce konfigurowalne, co pozwala dostosować konfiguracje sprzętowe do modeli sztucznej inteligencji o dużej pamięci lub wyspecjalizowanych konfiguracji GPU, takich jak te potrzebne do zadań związanych z wizją komputerową. Dzięki natychmiastowemu wdrożeniu można szybko skalować zasoby GPU, aby sprostać zmieniającym się wymaganiom.

Kluczowe funkcje obejmują obsługę GPU passthrough, partycjonowanie vGPU i niestandardowe planowanie, wszystkie krytyczne dla obsługi wymagających obciążeń AI.

Niezmierzona przepustowość i globalne wdrożenie

Niezmierzona przepustowość to przełom w projektach AI wymagających dużej ilości danych. Trenowanie dużych modeli często wymaga przenoszenia terabajtów danych między systemami pamięci masowej, węzłami obliczeniowymi i narzędziami monitorującymi. Eliminując limity transferu danych, FDC Servers utrzymuje przewidywalny budżet i niezakłócony przepływ pracy.

Dzięki 74 lokalizacjom na całym świecie, FDC Servers zapewnia zasięg geograficzny niezbędny dla nowoczesnej infrastruktury AI. Ta globalna sieć umożliwia umieszczenie zasobów obliczeniowych bliżej źródeł danych, zmniejszając opóźnienia w rozproszonych konfiguracjach szkoleniowych. W przypadku wnioskowania, modele mogą być wdrażane w lokalizacjach brzegowych, zapewniając szybszy czas reakcji dla użytkowników końcowych.

Globalna infrastruktura odgrywa również kluczową rolę w odzyskiwaniu danych po awarii i redundancji. Jeśli jedna lokalizacja stanie w obliczu awarii, obciążenia można płynnie przenieść do innego regionu, utrzymując płynność operacji. W przypadku organizacji zarządzających potokami AI w wielu regionach, posiadanie spójnej infrastruktury we wszystkich 74 lokalizacjach zapewnia jednolitość konfiguracji wirtualizacji, narzędzi monitorowania i strategii planowania - bez względu na to, gdzie rozmieszczone są zasoby.

Dodatkowo, FDC Servers oferuje całodobowe wsparcie w celu rozwiązywania wszelkich problemów związanych ze sterownikami GPU, konfliktami wirtualizacji lub alokacją zasobów. Zapewnia to minimalny czas przestoju, nawet w złożonych, zwirtualizowanych środowiskach GPU.

Wszystkie te funkcje stanowią solidną podstawę do osiągnięcia zoptymalizowanej wydajności sztucznej inteligencji.

Podsumowanie

Niniejszy przewodnik podkreśla, w jaki sposób połączenie zaawansowanego sprzętu, precyzyjnie dostrojonych zasobów i solidnej infrastruktury może znacznie zwiększyć wydajność sztucznej inteligencji.

Aby jak najlepiej wykorzystać obciążenia związane ze sztuczną inteligencją, należy dostosować sprzęt, alokację zasobów i infrastrukturę do konkretnych wymagań. Aby uzyskać maksymalną wydajność, idealnym rozwiązaniem jest GPU passthrough, podczas gdy partycjonowanie vGPU oferuje efektywny sposób udostępniania zasobów.

Synergia pomiędzy wyborem sprzętu i dostosowaniem zasobów jest kluczem do optymalizacji wydajności. Korzystanie z układów GPU o dużej przepustowości pamięci, integracja pamięci masowej NVMe i zapewnienie wysokiej przepustowości sieci może bezpośrednio zwiększyć wydajność szkolenia i wyniki modelu. Precyzyjne dostrojenie topologii systemu zmniejsza opóźnienia połączeń, a profilowanie i inteligentne planowanie maksymalizują wykorzystanie GPU. Narzędzia do orkiestracji dodatkowo zapewniają spójną wydajność na wysokim poziomie.

Wszystko to spaja niezawodny partner hostingowy. Dla organizacji, które chcą sprostać wyzwaniom związanym z zasobami, niezawodny hosting ma kluczowe znaczenie. FDC Servers oferuje hosting GPU w cenie 1 124 USD/miesiąc z nielimitowaną przepustowością - opcja, która eliminuje limity transferu danych i nieprzewidywalne koszty.

Dzięki funkcjom takim jak skalowalność geograficzna, natychmiastowe wdrożenie i wsparcie 24/7, możesz płynnie skalować operacje AI. Niezależnie od tego, czy zarządzasz rozproszonym szkoleniem w różnych regionach, czy wdrażasz modele wnioskowania brzegowego, niezawodna infrastruktura usuwa wiele przeszkód technicznych, które często spowalniają projekty AI.

Osiągnięcie sukcesu w AI wymaga płynnego połączenia mocy GPU, precyzyjnego zarządzania zasobami i niezawodnego hostingu. Postępując zgodnie z tymi strategiami i wykorzystując infrastrukturę FDC Servers, możesz utorować drogę do szczytowej wydajności AI.

Często zadawane pytania

W jaki sposób wirtualizacja GPU zwiększa wydajność i opłacalność obciążeń AI?

Wirtualizacja GPU pozwala wielu maszynom wirtualnym korzystać z jednego fizycznego układu GPU, zwiększając wydajność przy jednoczesnym obniżeniu kosztów. Współdzielenie zasobów eliminuje potrzebę zakupu dodatkowego sprzętu, lepiej wykorzystując to, co jest już dostępne i obniżając ogólne koszty.

Taka konfiguracja znacznie ułatwia również skalowanie i zarządzanie. Organizacje mogą przyjmować więcej obciążeń związanych ze sztuczną inteligencją bez konieczności posiadania oddzielnego układu GPU dla każdej maszyny wirtualnej. Rezultat? Usprawniona wydajność i kontrolowane koszty - idealne połączenie dla projektów AI i uczenia maszynowego.

Jaka jest różnica między GPU passthrough a partycjonowaniem vGPU i kiedy należy używać każdego z nich?

Jeśli chodzi o GPU passthrough, cały procesor graficzny jest dedykowany pojedynczej maszynie wirtualnej (VM), oferując wydajność, która jest prawie nie do odróżnienia od działania na fizycznym sprzęcie. Sprawia to, że jest to najlepsza opcja do wymagających zadań, takich jak szkolenie modeli sztucznej inteligencji, głębokie uczenie lub renderowanie 3D, w których kluczowe znaczenie ma wyciśnięcie każdej uncji wydajności.

Z kolei partycjonowanie vGPU dzieli pojedynczy układ GPU na wiele segmentów sprzętowych, umożliwiając kilku maszynom wirtualnym lub użytkownikom jednoczesne współdzielenie tego samego układu GPU. Taka konfiguracja sprawdza się najlepiej w środowiskach współdzielonych, takich jak wirtualne pulpity lub współpracujące stacje robocze, gdzie priorytetem jest zrównoważenie elastyczności i efektywnego wykorzystania zasobów.

Jakie są najlepsze narzędzia i strategie monitorowania i optymalizacji obciążeń AI w środowiskach zwirtualizowanych przez GPU?

Aby w pełni wykorzystać obciążenia AI w środowiskach zwirtualizowanych przez GPU, niezbędne jest wykorzystanie narzędzi do monitorowania GPU, które oferują dane w czasie rzeczywistym na temat wykorzystania zasobów i wydajności. Przykładowo, rozwiązania do zarządzania vGPU firmy NVIDIA ułatwiają śledzenie wykorzystania GPU i optymalizację sposobu dystrybucji zasobów.

Innym kluczowym podejściem jest wykorzystanie platform orkiestracji, takich jak Kubernetes. Platformy te mogą dynamicznie dostosowywać obciążenia i efektywniej alokować zasoby, pomagając osiągnąć lepszą wydajność GPU. Ponadto, regularne dostrajanie hiperparametrów i udoskonalanie potoków danych odgrywa dużą rolę w utrzymaniu wysokiego poziomu wydajności. Ciągłe monitorowanie wskaźników GPU pozwala wcześnie wykrywać wąskie gardła i unikać konfliktów zasobów, zapewniając płynne działanie zadań AI.

Jak zainstalować i używać Redis na serwerze VPS

Dowiedz się, jak zainstalować i skonfigurować Redis na serwerze VPS, aby uzyskać optymalną wydajność, bezpieczeństwo i zarządzanie aplikacjami.

9 min czytania - 7 stycznia 2026

Monitorowanie serwera dedykowanego lub VPS, jakie są opcje w 2025 roku?

12 min czytania - 28 listopada 2025

Masz pytania lub potrzebujesz niestandardowego rozwiązania?

Elastyczne opcje

Globalny zasięg

Natychmiastowe wdrożenie

Elastyczne opcje

Globalny zasięg

Natychmiastowe wdrożenie