AI-werklasten in gevirtualiseerde GPU-omgevingen: Optimalisatiegids

11 min lezen - 10 oktober 2025

- AI-werklasten in gevirtualiseerde GPU-omgevingen: Optimalisatiegids

- GPU-virtualisatie basiskennis voor AI

- AI/ML-infrastructuur: Time-Slicing GPU uitgelegd

- Vereisten voor hardware en infrastructuur

- Configuratie van virtuele machines en GPU's

- Prestatiemonitoring en planning

- FDC-servers voor AI-infrastructuur

- Conclusie

- FAQs

Ontdek hoe GPU-virtualisatie AI-workloads verbetert door de efficiëntie te verbeteren, de kosten te verlagen en het resourcebeheer in gevirtualiseerde omgevingen te optimaliseren.

- AI-werklasten in gevirtualiseerde GPU-omgevingen: Optimalisatiegids

- GPU-virtualisatie basiskennis voor AI

- AI/ML-infrastructuur: Time-Slicing GPU uitgelegd

- Vereisten voor hardware en infrastructuur

- Configuratie van virtuele machines en GPU's

- Prestatiemonitoring en planning

- FDC-servers voor AI-infrastructuur

- Conclusie

- FAQs

AI-werklasten in gevirtualiseerde GPU-omgevingen: Optimalisatiegids

GPU-virtualisatie verandert de manier waarop AI-workloads worden beheerd. Door een fysieke GPU op te splitsen in meerdere virtuele instanties kun je meerdere AI-taken tegelijk uitvoeren, waardoor de efficiëntie verbetert en de hardwarekosten dalen. Deze aanpak is vooral waardevol voor het trainen van complexe modellen, het afhandelen van resource-intensieve taken en het schalen van AI-projecten zonder te investeren in extra GPU's.

Dit is waarom het belangrijk is:

- Efficiënt GPU-gebruik: Voorkom ongebruikte hardware door resources te delen over taken en teams.

- Kostenbesparingen: Krachtige GPU's zijn duur; virtualisatie zorgt voor maximaal gebruik.

- Flexibiliteit: Pas virtuele GPU-instanties aan specifieke behoeften aan, zoals geheugengrootte of CUDA-versies.

- Schaalbaarheid: Resources dynamisch aanpassen wanneer AI-workloads groeien.

- Betrouwbaarheid: Geïsoleerde instanties voorkomen dat één taak andere taken beïnvloedt.

Prestaties optimaliseren:

- Kies GPU's met veel geheugen en bandbreedte (bijvoorbeeld NVIDIA A100/H100).

- Gebruik NVMe-opslag en netwerken met lage latentie voor gegevensverwerking.

- Configureer virtuele machines met GPU passthrough of vGPU partitionering op basis van de werklastbehoeften.

- Gebruik tools zoals NVIDIA GPU Operator, Kubernetes plugins en SLURM voor orkestratie.

- Bewaak de prestaties met tools zoals NVIDIA Nsight Systems en DCGM om knelpunten te identificeren.

Hostingdiensten zoals FDC Servers bieden GPU-oplossingen op maat vanaf $1.124/maand, inclusief onbeperkte bandbreedte en wereldwijde implementatieopties voor grootschalige AI-projecten.

Meenemen: GPU-virtualisatie stroomlijnt het resourcebeheer, verbetert de prestaties en verlaagt de kosten voor AI-workloads, waardoor het een praktische oplossing is voor het efficiënt schalen van AI-activiteiten.

GPU-virtualisatie basiskennis voor AI

Wat is GPU-virtualisatie?

GPU-virtualisatie stelt meerdere gebruikers in staat om één GPU te delen door virtuele instanties aan te maken, elk met zijn eigen specifieke geheugen, cores en verwerkingskracht. Dit betekent dat een enkele GPU meerdere taken of gebruikers tegelijkertijd kan verwerken, waardoor het een efficiënte oplossing is voor AI-workloads.

In de kern maakt deze technologie gebruik van een hypervisor, die fungeert als manager en GPU-resources verdeelt over virtuele machines. De hypervisor zorgt ervoor dat elke instantie zijn toegewezen deel krijgt zonder tussenkomst van anderen. Voor AI-taken stelt dit een enkele NVIDIA A100 of H100 GPU in staat om meerdere machine learning-experimenten, trainingssessies of inferentiebewerkingen tegelijkertijd uit te voeren.

Er zijn twee belangrijke methoden om deze bronnen te delen:

- Virtualisatie op hardwareniveau: NVIDIA's Multi-Instance GPU (MIG) technologie splitst de GPU fysiek op in geïsoleerde secties en zorgt zo voor een sterke scheiding tussen instanties.

- Virtualisatie op softwareniveau: Deze methode maakt gebruik van stuurprogramma's en software om GPU-bronnen te verdelen en biedt meer flexibiliteit, maar iets minder isolatie.

Een belangrijk verschil tussen GPU- en traditionele CPU-virtualisatie ligt in geheugenbeheer. GPU's gebruiken geheugen met hoge bandbreedte (HBM), dat anders werkt dan standaard systeem-RAM. Het efficiënt beheren van dit geheugen is cruciaal, vooral tijdens resource-intensieve AI-bewerkingen zoals fijnafstemming of grootschalige training.

Dit fundamentele inzicht vormt de basis voor het onderzoeken hoe GPU-virtualisatie de AI-prestaties in praktische scenario's verbetert.

Voordelen voor AI en Machine Learning-werklasten

Virtualisatie biedt een reeks voordelen die direct inspelen op de uitdagingen van AI en machine learning (ML) workloads.

Het maximaliseren van het gebruik van GPU's is een van de belangrijkste voordelen. Krachtige GPU's, die tussen de $10.000 en $30.000 kunnen kosten, worden vaak onderbenut tijdens taken als data preprocessing of model setup. Virtualisatie zorgt ervoor dat deze kostbare bronnen volledig worden benut doordat meerdere taken dezelfde GPU kunnen delen, waardoor de inactieve tijd afneemt en de hardwarekosten dalen. Deze aanpak stelt organisaties in staat om meer gebruikers en toepassingen te bedienen zonder dat er extra fysieke GPU's nodig zijn.

Flexibiliteit in ontwikkeling is een andere game-changer. Met virtualisatie kunnen ontwikkelaars virtuele GPU-instanties maken die zijn aangepast aan specifieke behoeften, zoals verschillende CUDA-versies, geheugengroottes of driverconfiguraties. Deze isolatie zorgt ervoor dat projecten die frameworks zoals PyTorch, TensorFlow of JAX gebruiken zonder conflicten naast elkaar kunnen bestaan, waardoor workflows worden gestroomlijnd en innovatie wordt versneld.

Schaalbaarheid wordt veel eenvoudiger te beheren. AI workloads kunnen aanzienlijk variëren in hun eisen. Voor het trainen van een klein neuraal netwerk zijn bijvoorbeeld minimale resources nodig, terwijl voor het finetunen van een groot taalmodel enorme rekenkracht nodig is. Virtuele instanties kunnen dynamisch op- of afschalen en resources toewijzen op basis van de intensiteit van de werklast. Dit aanpassingsvermogen zorgt te allen tijde voor een efficiënt gebruik van bronnen.

Multi-tenancy ondersteuning is vooral waardevol voor organisaties met uiteenlopende behoeften. Door de infrastructuur te delen, hebben verschillende afdelingen, klanten of toepassingen toegang tot GPU-resources zonder dat ze fysieke hardware hoeven te beheren. Cloudproviders kunnen zelfs GPU-as-a-Service aanbieden, waardoor gebruikers virtuele GPU-instanties kunnen gebruiken met behoud van prestatie-isolatie en minder administratieve complexiteit.

Tot slot zorgt foutisolatie voor stabiliteit. Als een virtuele instantie crasht of buitensporig veel bronnen verbruikt, worden andere instanties die dezelfde GPU delen niet verstoord. Deze betrouwbaarheid is cruciaal in productieomgevingen waar meerdere AI-services soepel en consistent moeten draaien.

GPU-virtualisatie optimaliseert niet alleen het resourcegebruik, maar geeft AI-teams ook de tools en flexibiliteit die nodig zijn om complexe, steeds veranderende workloads aan te pakken.

AI/ML-infrastructuur: Time-Slicing GPU uitgelegd

Vereisten voor hardware en infrastructuur

Het behalen van de beste AI-prestaties in gevirtualiseerde GPU-omgevingen is sterk afhankelijk van de juiste hardware- en interconnectiekeuzes. Deze beslissingen spelen een belangrijke rol bij het maximaliseren van het potentieel van GPU-virtualisatie voor AI-workloads.

De juiste GPU-architectuur kiezen

Wanneer u GPU's selecteert voor AI-taken, zoek dan naar modellen met een hoge geheugencapaciteit, snelle bandbreedte en ingebouwde virtualisatieondersteuning. Veel moderne GPU's kunnen worden opgesplitst in meerdere geïsoleerde instanties, zodat verschillende gebruikers of toepassingen kunnen beschikken over specifieke reken- en geheugenbronnen. Maar het kiezen van de juiste GPU is slechts een deel van de vergelijking - je ondersteunende opslag- en netwerkinfrastructuur moet ook in staat zijn om de prestaties bij te houden.

Opslag- en netwerkvereisten

AI-werklasten omvatten vaak het beheer van enorme hoeveelheden gegevens, waardoor snelle NVMe-opslag en netwerken met lage latentie essentieel zijn. In bedrijfsomgevingen zijn NVMe-schijven met een hoog uithoudingsvermogen ideaal voor het verwerken van de zware lees-/schrijfcycli van AI-toepassingen.

Voor gegevensuitwisseling tussen nodes bieden technologieën zoals InfiniBand of geavanceerde Ethernet-oplossingen de bandbreedte die nodig is voor soepele operaties. Het gebruik van een gedistribueerd bestandssysteem om parallelle I/O mogelijk te maken, kan knelpunten minimaliseren wanneer meerdere processen tegelijkertijd gegevens benaderen. Zodra aan de opslag- en netwerkbehoeften is voldaan, is de volgende stap het afstemmen van de middelen.

Bronnen uitlijnen en topologie optimaliseren

Configureer NUMA (Non-Uniform Memory Access) om directe verbindingen tussen GPU's, geheugen en CPU's te garanderen. Wijs snelle netwerkinterfaces toe en wijs PCIe lanes toe om latentie te verminderen. Houd in gedachten dat robuuste koeling en voldoende stroomcapaciteit cruciaal zijn om thermische throttling te voorkomen en de stabiliteit van het systeem te behouden. Daarnaast kan het plaatsen van opslag dicht bij verwerkingseenheden de latentie verder verlagen, waardoor een efficiëntere en responsievere systeemarchitectuur ontstaat.

Configuratie van virtuele machines en GPU's

Zodra de hardware is ingesteld, is de volgende stap het configureren van virtuele machines (VM's) en GPU's om optimale AI-prestaties te garanderen. De juiste configuraties ontsluiten het potentieel van gevirtualiseerde GPU's, waardoor ze effectiever worden voor AI-werklasten. Laten we eens kijken hoe we deze resources efficiënt kunnen configureren en beheren.

Volledige GPU-doorvoer vs. vGPU-partitionering

Als het gaat om GPU-configuraties, zijn er twee hoofdbenaderingen: GPU passthrough en vGPU partitionering.

- GPU passthrough wijst een volledige GPU toe aan een enkele VM en levert bijna native prestaties voor veeleisende AI-trainingstaken. Hoewel deze opstelling de kracht maximaliseert, beperkt het de GPU tot één VM, wat inefficiënt kan zijn voor kleinere werklasten.

- Bij vGPU-partitionering daarentegen wordt een GPU opgedeeld in meerdere virtuele slices. Deze aanpak is kosteneffectiever voor taken die niet het volledige vermogen van een GPU vereisen, zoals inferentiebelastingen of kleinere trainingstaken.

Moderne GPU's zoals de NVIDIA A100 en H100 ondersteunen MIG (Multi-Instance GPU), waardoor tot zeven geïsoleerde GPU-instanties op één kaart mogelijk zijn. Deze functie is perfect om het gebruik van hardware te maximaliseren en tegelijkertijd de kosten in de hand te houden.

De juiste keuze hangt af van je use case:

- Voor grootschalige training, zoals het trainen van taalmodellen of deep learning onderzoek, is GPU passthrough meestal de betere optie.

- Voor taken zoals inferentie serveren, ontwikkeling of testen biedt vGPU-partitionering een betere resource-efficiëntie en kostenbesparing.

Resourcetoewijzing voor maximaal parallellisme

Efficiënte toewijzing van resources is essentieel om knelpunten te voorkomen en een soepele werking van AI te garanderen. Hier leest u hoe u uw resources in balans brengt:

- CPU-toewijzing: Wijs specifieke CPU cores toe aan elke VM om context switching te minimaliseren. Meestal werkt het goed om 4-8 CPU cores per GPU toe te wijzen, maar dit kan variëren afhankelijk van het AI framework en de complexiteit van de werklast.

- Geheugenbeheer: Plan zowel systeem RAM als GPU geheugen. Wijs ten minste 16-32 GB RAM per GPU toe voor de meeste AI-taken en reserveer voldoende geheugen voor de hypervisor. Het gebruik van grote pagina's kan ook de geheugenoverhead verminderen bij gegevensintensieve bewerkingen.

- GPU-geheugen: Wanneer u vGPU-partitionering gebruikt, moet u het GPU-geheugengebruik goed in de gaten houden. Sommige frameworks zoals PyTorch en TensorFlow kunnen dynamisch GPU-geheugen toewijzen, maar het instellen van limieten zorgt ervoor dat één werklast geen bronnen monopoliseert.

- Netwerken: Schakel SR-IOV (Single Root I/O Virtualization) in voor netwerkinterfaces om VM's directe hardwaretoegang te geven. Dit vermindert de netwerklatentie, wat vooral belangrijk is voor gedistribueerde AI-training op meerdere nodes.

GPU-orkestratiehulpmiddelen

Zodra resources zijn toegewezen, kunnen orkestratietools het beheer van GPU's vereenvoudigen, vooral in geschaalde AI-omgevingen.

- NVIDIA GPU Operator: Deze tool automatiseert taken zoals het installeren van GPU-stuurprogramma's, het instellen van container runtime en het monitoren van de gezondheid binnen Kubernetes. Het zorgt voor consistente configuraties in clusters en vermindert de handmatige werklast.

- Kubernetes GPU Plugins: Met plugins zoals de NVIDIA device plugin kun je GPU scheduling en toewijzing fijn afstellen. Ze ondersteunen fractioneel GPU-gebruik en maken nauwkeurig resource management mogelijk voor Kubernetes-gebaseerde workloads.

- SLURM: Een taakplanner ontworpen voor high-performance computing (HPC) en AI werklasten, SLURM biedt functies zoals GPU topologie bewustzijn, fair-share planning en resource reserveringen. Het is vooral handig voor het beheren van omgevingen met meerdere gebruikers en projecten.

- Docker met NVIDIA Container Toolkit: Deze setup geeft containers toegang tot GPU's terwijl isolatie tussen werklasten behouden blijft. Het integreert naadloos met orkestratieplatforms, waardoor het een flexibele optie is voor het implementeren van AI-toepassingen.

Naarmate je AI-infrastructuur groeit, worden deze orkestratietools onmisbaar. Ze automatiseren resource management, verbeteren het gebruik en bieden de intelligentie die nodig is om meerdere werklasten efficiënt te laten draaien op gedeelde hardware.

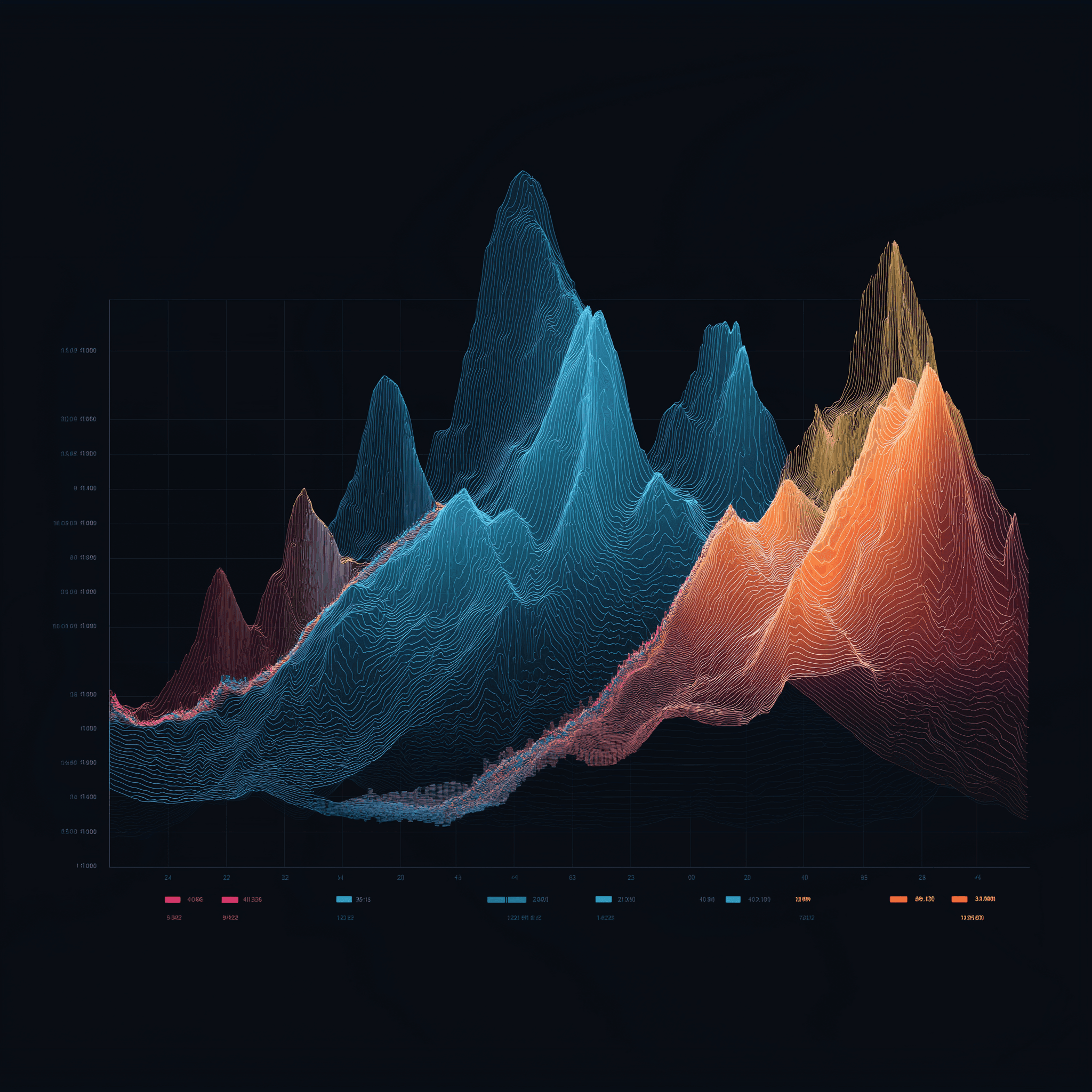

Prestatiemonitoring en planning

Na het instellen van je hardware en configuraties is de volgende stap om alles soepel te laten draaien het monitoren en plannen. Deze twee praktijken vormen de ruggengraat van het handhaven van piekprestaties van AI in gevirtualiseerde GPU-omgevingen. Zelfs de beste hardware-instellingen kunnen tekortschieten zonder goed inzicht in het resourcegebruik en slimme planningsstrategieën. Profiling, scheduling en continue monitoring zorgen ervoor dat AI workloads efficiënt en effectief blijven.

AI werklast profilering

Profilering is als het meten van de pols van je AI workloads - het helpt knelpunten op te sporen en zorgt ervoor dat resources verstandig worden gebruikt voordat de prestaties onder druk komen te staan. Het doel is om te begrijpen hoe verschillende taken GPU-resources, geheugen en rekencycli gebruiken.

NVIDIA Nsight Systems is een veelgebruikt hulpmiddel voor het profileren van CUDA-applicaties en biedt gedetailleerde inzichten in GPU-gebruik, geheugenoverdrachten en kerneluitvoeringstijden. Voor deep learning frameworks kunnen profiling tools helpen identificeren of werklasten GPU-, geheugen- of CPU-gebonden zijn, wat cruciaal is voor het fijn afstellen van de toewijzing van resources.

Raamwerkspecifieke tools zoals TensorFlow Profiler en PyTorch Profiler gaan nog dieper. TensorFlow Profiler splitst stappentijden uit en laat zien hoeveel tijd er wordt besteed aan taken zoals het laden van gegevens, preprocessing en training. Ondertussen biedt PyTorch Profiler een nauwkeurige blik op geheugengebruik, zodat geheugenlekken of inefficiënte tensorbewerkingen kunnen worden opgespoord.

Bij het profileren zijn de belangrijkste meetgegevens onder andere:

- GPU-gebruik: Streef naar ten minste 80% tijdens de training om efficiënt gebruik te garanderen.

- Bandbreedtegebruik geheugen: Dit laat zien hoe goed het GPU-geheugen wordt gebruikt.

- Kernel efficiëntie: Geeft aan hoe effectief bewerkingen zijn afgestemd op de GPU-architectuur.

In gevirtualiseerde omgevingen wordt profilering iets lastiger vanwege de toegevoegde hypervisor-laag. Tools zoals vSphere Performance Charts of KVM prestatiemonitoring kunnen de kloof overbruggen door metriek op VM-niveau te correleren met profileringsgegevens op gastniveau. Deze tweelaagse aanpak helpt te bepalen of prestatieproblemen te wijten zijn aan de virtualisatielaag of aan de werklast zelf.

De inzichten die worden verkregen uit profiling worden direct gebruikt voor slimmere planningsstrategieën, waardoor resources effectief worden toegewezen.

AI Workload Scheduling

Planning is waar de magie gebeurt - ervoor zorgen dat GPU's efficiënt worden gebruikt terwijl er met meerdere AI-workloads wordt gewerkt. Verschillende strategieën spelen in op verschillende behoeften, van het synchroniseren van gedistribueerde taken tot het toekennen van prioriteit aan kritieke taken.

- Groepsplanning: Deze methode is perfect voor synchrone training en zorgt ervoor dat alle processen in gedistribueerde training op elkaar zijn afgestemd, zodat geen enkele werker inactief blijft.

- Voorspellend plannen: Door historische gegevens te analyseren, voorspelt deze aanpak de runtimes van jobs op basis van factoren zoals de grootte van het model en de kenmerken van de dataset.

- Job preemption: Taken met een hoge prioriteit kunnen tijdelijk taken met een lagere prioriteit overslaan. Checkpoint-bewuste schedulers pauzeren taken veilig, slaan hun status op en hervatten later wanneer de bronnen vrijkomen.

- Fair-share planning: Houdt historisch gebruik bij en past dynamisch prioriteiten aan om ervoor te zorgen dat bronnen eerlijk worden verdeeld over gebruikers of projecten.

De planningsmethode die u kiest kan de efficiëntie van het systeem maken of breken. Batchplanning werkt bijvoorbeeld goed in onderzoeksopstellingen met flexibele deadlines, terwijl realtime planning essentieel is voor inferentiewerklasten die een lage latentie vereisen.

Als de planning eenmaal staat, zorgt continue monitoring ervoor dat alles op schema blijft.

Monitoring en benchmarking

Continue monitoring fungeert als een systeem voor vroegtijdige waarschuwing en vangt potentiële problemen op voordat ze de productie verstoren. Door real-time statistieken te combineren met historische gegevens kunnen trends en patronen worden ontdekt die anders misschien onopgemerkt zouden blijven.

GPU-monitoringprogramma's moeten alles bijhouden, van gebruik en geheugengebruik tot temperatuur en stroomverbruik. NVIDIA's Data Center GPU Manager (DCGM) is een robuuste optie, die integreert met platforms als Prometheus en Grafana om een uitgebreid beeld te geven. Deze tools kunnen helpen bij het detecteren van problemen zoals thermische throttling of geheugendruk die de prestaties kunnen schaden.

Monitoring op applicatieniveau richt zich op AI-specifieke meetgegevens zoals verlies bij training, validatienauwkeurigheid en convergentiesnelheden. Tools zoals MLflow en Weights & Biases combineren deze meetgegevens met systeemprestatiegegevens en bieden zo een compleet beeld van de gezondheid van de werklast.

Voor gedistribueerde training is netwerkbewaking een must. Het is belangrijk om bandbreedtegebruik, latentie en pakketverlies tussen knooppunten bij te houden. Voor snelle interconnecties zoals InfiniBand zijn speciale tools nodig om een soepele synchronisatie van gradiënten en parallelle training van gegevens te garanderen.

Benchmarking helpt bij het vaststellen van basisregels voor prestaties en het valideren van optimalisaties. MLPerf-benchmarks zijn een standaardkeuze voor het evalueren van training en inferentie voor verschillende AI-modellen en hardwareopstellingen. Door deze tests in uw gevirtualiseerde omgeving uit te voeren, stelt u de basisverwachtingen vast en brengt u configuratieproblemen aan het licht.

Synthetische benchmarks, zoals die in NVIDIA's DeepLearningExamples repository, zijn ook nuttig. Ze simuleren specifieke scenario's, helpen bij het isoleren van virtualisatie-overhead en bevestigen dat uw omgeving presteert zoals verwacht.

Regelmatige benchmarking - bijvoorbeeld één keer per maand - kan problemen aan het licht brengen zoals driver updates, configuratieafwijkingen of hardwaredegradatie die anders misschien onopgemerkt blijven.

FDC-servers voor AI-infrastructuur

Om topprestaties te bereiken in AI-systemen is een betrouwbare hostinginfrastructuur onontbeerlijk. De juiste hostingpartner zorgt ervoor dat uw profilerings-, plannings- en bewakingsstrategieën naadloos werken en biedt de ruggengraat die nodig is om AI-workloads effectief te optimaliseren.

Deze stabiele infrastructuur maakt een geavanceerde inzet van de eerder besproken profilerings-, scheduling- en orkestratietechnieken mogelijk.

GPU-servers voor AI-werklasten

FDC Servers biedt GPU-hosting die speciaal is afgestemd op AI- en machine learning-toepassingen. Vanaf $1.124 per maand worden hun GPU-servers geleverd met onbeperkte bandbreedte - een must-have bij het werken met grote datasets of gedistribueerde training. Dankzij deze functie hoeft u zich geen zorgen te maken over limieten voor gegevensoverdracht, waardoor u voorspelbare kosten kunt behouden.

Hun servers zijn in hoge mate aanpasbaar, zodat u hardwareconfiguraties kunt afstemmen voor AI-modellen met veel geheugen of gespecialiseerde GPU-opstellingen, zoals die nodig zijn voor computervisietaken. Met directe implementatie kunt u GPU-resources snel opschalen om te voldoen aan fluctuerende eisen.

Belangrijke functies zijn onder andere ondersteuning voor GPU passthrough, vGPU partitionering en aangepaste planning, allemaal cruciaal voor het verwerken van veeleisende AI workloads.

Onbeperkte bandbreedte en wereldwijde implementatie

Onbeperkte bandbreedte is een game-changer voor AI-projecten die veel gegevens vergen. Voor het trainen van grote modellen moeten vaak terabytes aan gegevens worden verplaatst tussen opslagsystemen, rekenknooppunten en monitoringtools. Door de limieten voor gegevensoverdracht te elimineren, houdt FDC Servers uw budget voorspelbaar en uw workflows ononderbroken.

Met 74 wereldwijde locaties biedt FDC Servers het geografische bereik dat nodig is voor moderne AI-infrastructuur. Dankzij dit wereldwijde netwerk kunt u computermiddelen dichter bij de gegevensbronnen plaatsen, waardoor de latentie in gedistribueerde trainingsopstellingen afneemt. Voor inferentie kunnen modellen worden ingezet op locaties aan de rand, zodat eindgebruikers sneller kunnen reageren.

De wereldwijde infrastructuur speelt ook een cruciale rol bij noodherstel en redundantie. Als een locatie uitvalt, kunnen workloads naadloos worden gemigreerd naar een andere regio, zodat de activiteiten soepel blijven verlopen. Voor organisaties die AI-pijplijnen met meerdere regio's beheren, zorgt een consistente infrastructuur op alle 74 locaties voor uniformiteit in virtualisatie-instellingen, monitoringtools en planningsstrategieën, ongeacht waar uw resources worden ingezet.

Daarnaast biedt FDC Servers 24/7 ondersteuning bij problemen met GPU-stuurprogramma's, virtualisatieconflicten of resourcetoewijzing. Dit zorgt voor minimale downtime, zelfs in complexe gevirtualiseerde GPU-omgevingen.

Deze functies vormen samen een sterke basis voor het bereiken van geoptimaliseerde AI-prestaties.

Conclusie

Deze handleiding laat zien hoe het combineren van geavanceerde hardware, nauwkeurig afgestemde resources en een solide infrastructuur de AI-prestaties aanzienlijk kan verbeteren.

Om het maximale uit uw AI-werklasten te halen, moet u uw hardware, resourcetoewijzing en infrastructuur afstemmen op uw specifieke vereisten. Voor maximale prestaties is GPU passthrough ideaal, terwijl vGPU-partitionering een efficiënte manier is om resources te delen.

De synergie tussen hardwareselectie en resource tuning is de sleutel tot het optimaliseren van prestaties. Het gebruik van GPU's met een ruime geheugenbandbreedte, de integratie van NVMe-opslag en een hoge netwerkdoorvoer kunnen de trainingsefficiëntie en modeluitvoer direct verbeteren. Het nauwkeurig afstellen van de systeemtopologie vermindert interconnectievertragingen, terwijl profilering en intelligente planning het GPU-gebruik maximaliseren. Orkestratiehulpmiddelen zorgen verder voor consistente prestaties op hoog niveau.

Een betrouwbare hostingpartner verbindt alles. Voor organisaties die uitdagingen op het gebied van resources willen overwinnen, is betrouwbare hosting van cruciaal belang. FDC Servers biedt GPU-hosting voor $1.124/maand met onbeperkte bandbreedte - een optie die limieten voor gegevensoverdracht en onvoorspelbare kosten elimineert.

Met functies zoals geografische schaalbaarheid, onmiddellijke inzet en 24/7 ondersteuning kunt u AI-activiteiten naadloos schalen. Of u nu gedistribueerde training in verschillende regio's beheert of edge-inferentiemodellen inzet, een betrouwbare infrastructuur neemt veel van de technische hindernissen weg die AI-projecten vaak vertragen.

Om succes te boeken op het gebied van AI is een naadloze combinatie nodig van GPU-kracht, nauwkeurig resourcebeheer en betrouwbare hosting. Door deze strategieën te volgen en gebruik te maken van de infrastructuur van FDC Servers, kunt u de weg vrijmaken voor topprestaties op het gebied van AI.

FAQs

Hoe maakt GPU-virtualisatie AI-workloads efficiënter en kosteneffectiever?

Met GPU-virtualisatie kunnen meerdere virtuele machines gebruikmaken van één fysieke GPU, waardoor de efficiëntie toeneemt en de kosten dalen. Door resources te delen, is er geen extra hardware nodig, waardoor beter gebruik wordt gemaakt van wat al beschikbaar is en de totale kosten worden verlaagd.

Deze opzet maakt schalen en beheer ook veel eenvoudiger. Organisaties kunnen meer AI workloads aan zonder dat ze voor elke virtuele machine een aparte GPU nodig hebben. Het resultaat? Gestroomlijnde prestaties en gecontroleerde kosten - een ideale combinatie voor AI en machine learning projecten.

Wat is het verschil tussen GPU passthrough en vGPU partitionering, en wanneer moet je ze allebei gebruiken?

Bij GPU passthrough wordt de volledige GPU toegewezen aan een enkele virtuele machine (VM), waardoor prestaties worden geboden die bijna niet te onderscheiden zijn van die op fysieke hardware. Hierdoor is dit de optie bij uitstek voor veeleisende taken zoals AI-model training, deep learning of 3D rendering, waarbij het essentieel is om elk grammetje prestatie eruit te persen.

Daarentegen splitst vGPU-partitionering een enkele GPU op in meerdere op hardware gebaseerde segmenten, waardoor meerdere VM's of gebruikers tegelijkertijd dezelfde GPU kunnen delen. Deze opzet werkt het beste voor gedeelde omgevingen zoals virtuele desktops of werkstations voor samenwerking, waar een balans tussen flexibiliteit en efficiënt resourcegebruik prioriteit heeft.

Wat zijn de beste tools en strategieën voor het monitoren en optimaliseren van AI-workloads in gevirtualiseerde GPU-omgevingen?

Om het maximale uit AI-workloads in gevirtualiseerde GPU-omgevingen te halen, is het essentieel om GPU-monitoringtools te gebruiken die realtime gegevens over resourcegebruik en prestaties bieden. De vGPU-beheeroplossingen van NVIDIA maken het bijvoorbeeld eenvoudiger om het gebruik van GPU's bij te houden en de verdeling van bronnen te optimaliseren.

Een andere belangrijke aanpak is het gebruik van orkestratieplatforms zoals Kubernetes. Deze platforms kunnen workloads dynamisch aanpassen en resources effectiever toewijzen, waardoor je betere GPU-prestaties kunt bereiken. Daarnaast speelt het regelmatig afstellen van hyperparameters en het verfijnen van datapijplijnen een grote rol bij het hoog houden van prestatieniveaus. Door GPU-metriek continu te monitoren, kunt u knelpunten vroegtijdig opsporen en conflicten met bronnen voorkomen, zodat uw AI-taken soepel verlopen.

Hoe Redis installeren en gebruiken op een VPS

Leer hoe u Redis op een VPS installeert en configureert voor optimale prestaties, beveiliging en beheer in uw applicaties.

9 min lezen - 7 januari 2026

Je Dedicated server of VPS monitoren, wat zijn de opties in 2025?

12 min lezen - 28 november 2025

Heb je vragen of wil je een oplossing op maat?

Flexibele opties

Wereldwijd bereik

Onmiddellijke inzet

Flexibele opties

Wereldwijd bereik

Onmiddellijke inzet