Wie man Engpässe bei der Skalierung von Servern identifiziert

8 Min. Lesezeit - 22. September 2025

Lernen Sie, wie Sie Leistungsengpässe bei der Skalierung von Servern erkennen und beheben können, um die Benutzerfreundlichkeit zu verbessern und die Ressourcennutzung zu optimieren.

Wie man Engpässe bei der Skalierung von Servern identifiziert

Bei der Skalierung von Servern geht es nicht nur um das Hinzufügen von Ressourcen, sondern auch um das Auffinden und Beheben von Engpässen, die die Leistung einschränken. Diese Engpässe können zu Verzögerungen, Abstürzen und schlechten Benutzererfahrungen führen, selbst bei aufgerüsteter Hardware. Konzentrieren Sie sich auf diese Problematik:

- Grundlegende Metriken: Messen Sie die CPU-Auslastung, den Arbeitsspeicher, die Festplatten-E/A, den Netzwerkdurchsatz und die Antwortzeiten unter normalen Bedingungen.

- Überwachungs-Tools: Verwenden Sie Plattformen wie New Relic, Grafana und JMeter, um die Leistung zu verfolgen und den Datenverkehr zu simulieren.

- Testen: Führen Sie Last- und Stresstests durch, um Schwachstellen zu identifizieren.

- Analyse: Untersuchen Sie Protokolle, Ressourcennutzung und Datenbankleistung, um Ineffizienzen festzustellen.

- Beheben: Optimieren Sie den Code, aktualisieren Sie die Hardware (z. B. SSDs) und implementieren Sie bei Bedarf eine horizontale Skalierung.

Diagnose von Leistungsengpässen in Produktionssystemen

Einrichten von Leistungs-Baselines

Baseline-Daten sind entscheidend, um festzustellen, ob es sich bei Änderungen in der Serverleistung um Routineschwankungen oder tatsächliche Engpässe handelt. Baselines bieten einen Bezugspunkt, der es leichter macht, Abweichungen vom typischen Serververhalten zu erkennen.

Um genaue Baselines zu erstellen, sollten Sie Leistungsdaten sammeln, die normale tägliche und wöchentliche Verkehrsmuster widerspiegeln.

Zu verfolgende Schlüsselmetriken

Die Verfolgung der richtigen Metriken ist für die frühzeitige Erkennung von Leistungsproblemen unerlässlich.

- CPU-Auslastung: Diese Kennzahl gibt an, wie viel Rechenleistung Ihr Server zu einem bestimmten Zeitpunkt verbraucht. Während akzeptable Bereiche von Ihrer spezifischen Einrichtung abhängen, kann die Überwachung der CPU-Auslastung aufzeigen, wann Ihr System entweder überlastet oder unterausgelastet ist.

- Speichernutzung: Hier wird die Menge des Arbeitsspeichers erfasst, die Ihre Anwendungen verbrauchen. Eine anhaltend hohe Speichernutzung kann das System dazu zwingen, auf langsameren festplattenbasierten Auslagerungsspeicher zurückzugreifen, was die Leistung erheblich verlangsamt.

- Festplatten-E/A-Metriken: Diese messen, wie effizient Ihr Speicher Daten liest und schreibt. Zu den wichtigsten Metriken gehören IOPS (Input/Output Operations Per Second) und die Festplattenlatenz. Herkömmliche Festplattenlaufwerke erreichen beispielsweise typischerweise 100-200 IOPS bei einer Latenz von 10-15 Millisekunden, während NVMe-SSDs viel höhere IOPS bei einer Latenz von unter einer Millisekunde liefern können.

- Netzwerkdurchsatz: Hier werden die Datenübertragungsraten in Mbps oder Gbps gemessen. Die Überwachung sowohl der eingehenden als auch der ausgehenden Bandbreite sowie der Paketverlustraten ist entscheidend. Paketverluste von mehr als 0,1 % deuten häufig auf eine Überlastung des Netzwerks oder auf Hardware-Probleme hin.

- Antwortzeiten: Die Antwortzeiten zeigen, wie schnell Ihre Anwendungen Anfragen bearbeiten. Für Webanwendungen sind Antwortzeiten von wenigen hundert Millisekunden ideal. Untersuchungen von Google zeigen, dass bei mobilen Seiten, die drei oder mehr Sekunden zum Laden benötigen, eine Abbruchrate von 53 % zu verzeichnen ist.

- Anwendungsspezifische Metriken: Diese variieren je nach Software-Stack, können aber Datenbankabfragezeiten, Cache-Trefferraten oder die Anzahl aktiver Verbindungen umfassen. So sind beispielsweise schnelle Datenbankabfragen und hohe Cache-Trefferraten für eine gute Gesamtleistung unerlässlich.

Die regelmäßige Überwachung dieser Metriken gewährleistet, dass Sie Leistungsprobleme angehen können, bevor eine Skalierung erforderlich wird.

Benchmarking und Aufzeichnung von Daten

Um zuverlässige Basiswerte zu ermitteln, sollten Sie Ihre Server mindestens zwei Wochen lang unter normaler Produktionslast laufen lassen. Zeichnen Sie die Daten in regelmäßigen Abständen auf - alle 5-10 Minuten ist ein gutes Gleichgewicht zwischen Detailgenauigkeit und Speichereffizienz.

EinBenchmarking der Spitzenlast ist ebenfalls wichtig. Messen Sie, wie Ihr System in den Zeiten mit der höchsten Auslastung arbeitet, um künftige Skalierungsanforderungen vorhersehen zu können.

Wenn Sie die Basisdaten dokumentieren, sollten Sie Zeitstempel, Metrikwerte und relevanten Kontext angeben. Anhand dieser detaillierten Aufzeichnungen können Sie die Leistung vor und nach den Skalierungsmaßnahmen vergleichen.

Betriebszeitmessungen sind eine weitere wichtige Komponente. Ein Beispiel:

- Eine Betriebszeit von 99 % entspricht etwa 7 Stunden Ausfallzeit pro Monat.

- Eine Betriebszeit von 99,9 % reduziert die Ausfallzeit auf etwa 45 Minuten pro Monat.

- Der Goldstandard, 99,999 % Betriebszeit (Five Nines), lässt nur 30 Sekunden Ausfallzeit pro Monat zu.

Sie können auch eine Apdex-Bewertung in Betracht ziehen, um die Zufriedenheit der Benutzer mit den Antwortzeiten zu messen. Diese Bewertung reicht von 0 (schlecht) bis 1 (ausgezeichnet), wobei die Antwortzeiten in die Bereiche "zufrieden", "tolerant" und "frustriert" eingeteilt werden. Ein Wert über 0,85 deutet im Allgemeinen auf eine positive Benutzererfahrung hin.

Speichern Sie Ihre Basisdaten in einem zentralen System, um einen einfachen Zugriff und Vergleich zu ermöglichen. Zeitseriendatenbanken oder Überwachungsplattformen werden häufig verwendet, um historische Daten zu speichern, so dass es einfacher ist, festzustellen, ob Leistungsänderungen auf Skalierung oder zugrunde liegende Systemprobleme zurückzuführen sind.

Mit diesen Basisdaten sind Sie bereit, sich mit Tools und Techniken zur Leistungsüberwachung in Echtzeit zu befassen.

Überwachungs- und Analysetools

Die richtigen Überwachungstools können Rohdaten in verwertbare Erkenntnisse umwandeln und Ihnen helfen, Engpässe zu erkennen, bevor sie die Benutzererfahrung beeinträchtigen. Mit einer Vielzahl von Funktionen wie Echtzeitwarnungen und detaillierten Leistungsanalysen ist die Wahl der richtigen Tools entscheidend für die effektive Erkennung und Lösung von Problemen.

Zentrale Überwachungs-Tools

Application Performance Monitoring (APM)-Plattformen wie New Relic sind unverzichtbar für die Verfolgung von Anwendungsmetriken und Benutzererfahrungen. Diese Tools erfassen automatisch wichtige Daten wie Antwortzeiten, Fehlerraten und Transaktionsspuren. Funktionen wie verteiltes Tracing machen es einfacher, langsame Datenbankabfragen oder schleppende API-Aufrufe zu lokalisieren.

Grafana ist ein vielseitiges Visualisierungstool, das sich mit mehreren Datenquellen integrieren lässt. In Verbindung mit Zeitseriendatenbanken wie Prometheus oder InfluxDB eignet sich Grafana hervorragend für die Erstellung von Dashboards, die Metriken miteinander verknüpfen, z. B. die Korrelation von CPU-Spitzen mit langsameren Antwortzeiten, wodurch Leistungsprobleme auf einen Blick erkennbar werden.

Apache JMeter ist ein Tool für Lasttests, das aktiv den Benutzerverkehr simuliert, um zu messen, wie Systeme mit gleichzeitigen Benutzern umgehen. Durch die Generierung von Datenverkehr und das Testen des Serverdurchsatzes unter verschiedenen Bedingungen hilft JMeter, Schwachstellen und Ressourcenbeschränkungen zu erkennen, bevor sie sich auf die Produktionsumgebung auswirken.

Der ELK-Stack (Elasticsearch, Logstash und Kibana) konzentriert sich auf Protokollanalyse und Suchfunktionen. Logstash sammelt und verarbeitet Protokolldaten, Elasticsearch macht sie durchsuchbar, und Kibana visualisiert die Ergebnisse. Diese Kombination ist ideal für die Identifizierung von Fehlermustern, die Verfolgung von Ereignishäufigkeiten und die Verknüpfung von Protokollen mit Leistungsabfällen.

Überwachungswerkzeuge auf Systemebene wie Nagios, Zabbix und Datadog bieten eine Vogelperspektive auf die Infrastrukturmetriken. Diese Plattformen überwachen kritische Hardwaredaten wie CPU-Nutzung, Speicherverbrauch, Festplatten-E/A und Netzwerkverkehr und sind daher für die Erkennung von hardwarebedingten Engpässen und die Planung von Kapazitätserweiterungen unerlässlich.

Datenbanküberwachungswerkzeuge wie pgAdmin for PostgreSQL oder MySQL Enterprise Monitor bieten spezielle Einblicke in die Datenbankleistung. Diese Werkzeuge verfolgen Metriken wie Abfrageausführungszeiten, Sperrkonflikte und Pufferpoolauslastung - Details, die von allgemeinen Überwachungswerkzeugen möglicherweise übersehen werden, aber für die Optimierung der Datenbankleistung entscheidend sind.

Jede Art von Tool dient einem bestimmten Zweck: APM-Tools konzentrieren sich auf die Anwendungsleistung, Systemmonitore behandeln Hardware-Metriken, und Datenbank-Tools sind auf die Speicher- und Abfrageanalyse spezialisiert. Viele Unternehmen verwenden eine Mischung aus diesen Tools, um ihren gesamten Technologiebereich abzudecken und sowohl eine sofortige Problemlösung als auch eine langfristige Leistungsoptimierung zu gewährleisten.

Echtzeit vs. historische Daten

Die Echtzeitüberwachung liefert sekundengenaue Einblicke in die Systemleistung und ermöglicht es den Teams, schnell auf auftretende Probleme zu reagieren. Dashboards werden alle paar Sekunden aktualisiert und zeigen Live-Metriken wie CPU-Auslastung, aktive Verbindungen und Antwortzeiten an. Dies ist entscheidend, um plötzliche Datenverkehrsspitzen, Speicherlecks oder ausfallende Komponenten zu erkennen, bevor sie sich zu größeren Problemen auswachsen.

Echtzeitwarnungen werden ausgelöst, wenn die Metriken vordefinierte Schwellenwerte überschreiten, z. B. wenn die CPU-Auslastung 80 % oder die Antwortzeiten 2 Sekunden überschreiten. Diese Warnungen ermöglichen es den Teams, Probleme innerhalb von Minuten zu beheben und Ausfallzeiten zu minimieren.

Die Analyse historischer Daten hingegen deckt langfristige Trends und wiederkehrende Muster auf, die bei der Echtzeitüberwachung möglicherweise übersehen werden. Durch die Untersuchung von Daten über Wochen oder Monate hinweg können Teams saisonale Verkehrsschwankungen, allmähliche Leistungsabfälle oder wiederkehrende Engpässe erkennen. Ein Anstieg der Datenbankabfragezeiten um 15 % über einen Zeitraum von drei Monaten könnte beispielsweise auf wachsende Datenmengen oder ineffiziente Abfragen hinweisen, die optimiert werden müssen.

Die historische Analyse unterstützt auch die Kapazitätsplanung. Anhand von Trends wie der zunehmenden Speichernutzung oder dem steigenden Datenverkehr lässt sich vorhersagen, wann die Ressourcen an ihre Grenzen stoßen, was eine proaktive Skalierung oder Aufrüstung ermöglicht.

Durchdie Kombination beider Ansätze entsteht eine abgerundete Überwachungsstrategie. Echtzeitdaten liefern unmittelbares Feedback für das Krisenmanagement, während historische Analysen strategische Entscheidungen zur Vermeidung künftiger Probleme ermöglichen. Viele moderne Tools integrieren beides nahtlos und bieten Echtzeit-Dashboards neben der Speicherung historischer Daten, so dass Teams mühelos zwischen kurzfristiger Fehlerbehebung und langfristiger Planung wechseln können.

Die besten Ergebnisse werden erzielt, wenn Teams routinemäßig Echtzeitwarnungen überprüfen, um unmittelbare Probleme anzugehen, und historische Trends analysieren, um intelligentere Skalierungs- und Optimierungsentscheidungen zu treffen. Dieser duale Ansatz stellt sicher, dass die Systeme auf Dauer effizient und belastbar bleiben.

So finden Sie Engpässe Schritt für Schritt

Sobald Sie die Basiskennzahlen festgelegt und die Überwachungstools eingerichtet haben, besteht der nächste Schritt darin, Engpässe aufzuspüren. Dazu gehört das systematische Testen, Überwachen und Analysieren Ihres Systems unter Last, um festzustellen, wo Leistungsprobleme auftreten.

Last- und Stresstests

Mithilfe von Lasttests können Sie die Leistung Ihres Systems bei typischen Benutzeranforderungen beurteilen. Legen Sie zunächst Ihre Leistungsziele fest, z. B. akzeptable Antwortzeiten, Durchsatzziele und Schwellenwerte für die Fehlerrate. Diese Ziele dienen als Benchmarks, um Abweichungen festzustellen. Tools wie JMeter oder Gatling können den Datenverkehr simulieren und die Last schrittweise erhöhen, bis die Leistung nachlässt.

Bei Stresstests hingegen wird das System über seine normalen Grenzen hinaus belastet, um Schwachstellen aufzudecken. Während beider Tests sollten Sie Metriken wie CPU-Auslastung, Speicherverbrauch und Netzwerkbandbreite im Auge behalten. Eine CPU-Auslastung von nahezu 100 %, Speicherspitzen oder eine überlastete Bandbreite korrelieren häufig mit langsameren Antwortzeiten oder höheren Fehlerraten.

Real User Monitoring (RUM) kann diese synthetischen Tests ergänzen, indem es Daten über tatsächliche Benutzererfahrungen liefert. Dadurch können Engpässe aufgedeckt werden, die bei kontrollierten Tests möglicherweise übersehen werden.

Der nächste Schritt besteht darin, die Ressourcennutzung zu analysieren, um die Ursachen von Leistungsproblemen zu ermitteln.

Ressourcen-Analyse

Vergleichen Sie die Daten zur Ressourcennutzung mit Ihren Basiskennzahlen, um versteckte Einschränkungen aufzudecken. Darauf sollten Sie achten:

- CPU: Engpässe treten häufig auf, wenn die Nutzung konstant über 80 % liegt oder unerwartet in die Höhe schnellt.

- Arbeitsspeicher: Eine hohe oder unregelmäßige Nutzung kann auf Speicherlecks oder Ineffizienzen hinweisen.

- Festplatten-E/A: Achten Sie auf hohe Auslastung oder lange Wartezeiten, die den Betrieb verlangsamen können.

- Netzwerk: Überprüfen Sie die Bandbreitennutzung und die Latenzzeit, um langsame API-Antworten oder Timeouts zu erkennen.

- Datenbankleistung: Verwenden Sie Werkzeuge wie MySQL Workbench oder SQL Profiler, um die Ausführungszeiten von Abfragen, Indizierung und Transaktionssperren zu analysieren. Abfragen, die länger als 100 Millisekunden dauern, könnten auf ineffiziente Operationen wie zeilenweise Verarbeitung (RBAR) hinweisen, die optimiert werden müssen.

Protokoll- und Trace-Analyse

Logs und Traces liefern in Kombination mit Baseline- und Echtzeitmetriken wichtige Erkenntnisse. Protokolle können wiederkehrende Fehler, Timeouts oder Ressourcenwarnungen aufzeigen, die auf Engpässe hinweisen. So weisen beispielsweise Timeout-Meldungen oder Fehler im Zusammenhang mit Ressourcenbeschränkungen oft direkt auf Problembereiche hin.

Verteilte Tracing-Tools wie OpenTelemetry mit Jaeger ermöglichen es Ihnen, den Weg einer Anfrage über Microservices hinweg zu verfolgen und Verzögerungen aufzudecken, die durch langsame Datenbankabfragen, API-Timeouts oder problematische Service-Abhängigkeiten verursacht werden. Detaillierte Instrumentierung, wie z. B. die Protokollierung der Start- und Endzeiten von Operationen, kann helfen, Codeabschnitte zu identifizieren, die übermäßig viele Ressourcen verbrauchen. In ähnlicher Weise können Datenbankabfrageprotokolle Ineffizienzen wie RBAR-Operationen aufdecken.

Thread-Konkurrenz ist ein weiterer untersuchenswerter Bereich. Die Analyse von Thread-Dumps kann Deadlocks, Thread-Starvation oder übermäßige Kontextwechsel aufdecken, die allesamt die Leistung beeinträchtigen können. Die Aufzeichnung von Stack-Trace-Snapshots während Leistungsspitzen kann die genauen Codepfade, die Verzögerungen verursachen, weiter eingrenzen.

Zwischen März und November 2020 hat sich die Nutzung von Miro versiebenfacht und erreichte über 600.000 Nutzer pro Tag. Um Engpässe auf dem Server während dieser schnellen Skalierung zu beheben, konzentrierte sich das Systemteam von Miro auf die Überwachung der mittleren Task-Abschlusszeit (Perzentil) und nicht auf Durchschnittswerte oder Warteschlangengrößen. Dieser Ansatz half ihnen, Prozesse zu optimieren, die sich auf die Mehrheit der Benutzer auswirken.

Häufige Engpassursachen und ihre Auswirkungen

Das Verständnis von Engpässen ist entscheidend für die gezielte Überwachung und die Beschleunigung der Antwortzeiten. Verschiedene Engpässe hinterlassen unterschiedliche Spuren, die Ihnen helfen können, Probleme zu erkennen und effektiv zu lösen.

Im Folgenden finden Sie eine Aufschlüsselung der häufigsten Engpassquellen, ihrer Warnzeichen, Erkennungsmethoden und der Art und Weise, wie sie die Skalierbarkeit einschränken:

Tiefer in Engpässe eintauchen

CPU-Engpässe treten am häufigsten bei starkem Datenverkehr auf. Wenn die CPU-Auslastung 80 % übersteigt, beginnt das System, Anfragen in eine Warteschlange zu stellen, was zu Verzögerungen und Zeitüberschreitungen führt. An diesem Punkt ist eine horizontale Skalierung oft die einzige praktikable Lösung.

Speicherprobleme bleiben meist unbemerkt, bis die RAM-Auslastung ein kritisches Niveau erreicht. Sobald dies der Fall ist, können Anwendungen abstürzen oder aufgrund von Überlastungen durch die Garbage Collection deutlich langsamer werden, so dass teure Upgrades oder Optimierungsmaßnahmen erforderlich werden.

Datenbankengpässe sind eine häufige Herausforderung bei der Skalierung von Webanwendungen. Symptome wie Abfrage-Timeouts und erschöpfte Verbindungspools können die Leistung lähmen und erfordern oft ein Datenbank-Clustering oder die Hinzufügung von Read Replicas, um die Last zu verteilen.

Netzwerkbeschränkungen treten typischerweise bei großen Dateien oder häufigen API-Aufrufen auf. Hohe Latenzzeiten oder Paketverluste, insbesondere über verschiedene Regionen hinweg, deuten oft auf die Notwendigkeit von Content Delivery Networks (CDNs) oder anderen Verteilungsstrategien hin.

Speicherengpässe entstehen, wenn die Datenanforderungen steigen. Herkömmliche Laufwerke mit begrenzter IOPS können Datei- und Datenbankschreibvorgänge verlangsamen, so dass SSDs oder verteilte Speicherarchitekturen für die Aufrechterhaltung der Leistung entscheidend sind.

Engpässe im Anwendungscode sind einzigartig, da sie auf Ineffizienzen im Design oder in der Implementierung zurückzuführen sind, z. B. auf Speicherlecks oder schlechte Caching-Strategien. Um diese Probleme zu beheben, ist oft eine gründliche Profilerstellung, ein Refactoring oder sogar eine Überarbeitung der Architektur erforderlich, um die Skalierungsanforderungen zu erfüllen.

Behebung von Engpässen für bessere Skalierbarkeit

Hardware-Engpässe wie CPU und Speicher können manchmal durch vertikale Skalierung gemildert werden, aber dieser Ansatz hat seine Grenzen. Schließlich wird eine horizontale Skalierung unumgänglich. Andererseits erfordern Engpässe bei Datenbanken und Anwendungscode in der Regel Optimierungsarbeiten, bevor zusätzliche Ressourcen ihre volle Wirkung entfalten können.

Behebung von Engpässen für eine bessere Skalierung

Sobald Engpässe identifiziert sind, besteht der nächste Schritt darin, sie effektiv zu beheben. Ziel ist es, die Ursachen und nicht nur die Symptome zu bekämpfen, um sicherzustellen, dass Ihre Infrastruktur künftiges Wachstum bewältigen kann, ohne auf dieselben Probleme zu stoßen.

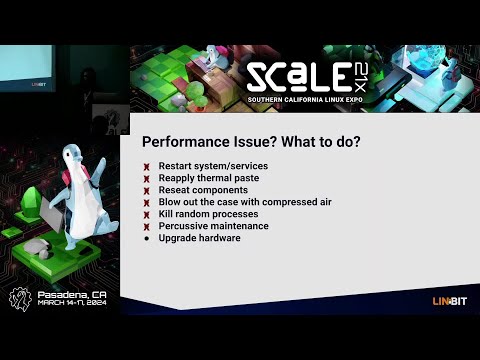

Behebung identifizierter Engpässe

CPU-Engpässe: Wenn die CPU-Auslastung regelmäßig 80 % übersteigt, ist es an der Zeit zu handeln. Beginnen Sie mit der Optimierung Ihres Codes - straffen Sie ineffiziente Algorithmen und reduzieren Sie ressourcenintensive Operationen. Eine Aufrüstung Ihrer Hardware (vertikale Skalierung) kann zwar sofort Abhilfe schaffen, ist aber nur eine vorübergehende Lösung. Um eine langfristige Skalierbarkeit zu erreichen, sollten Sie einen Lastausgleich und eine horizontale Skalierung einführen, um die Arbeitslasten auf mehrere Server zu verteilen, da ein einzelner Server irgendwann an seine Grenzen stoßen wird.

Speicherprobleme: Verwenden Sie Profiling-Tools, um Speicherlecks zu erkennen und die Speicherzuweisung Ihrer Anwendung zu optimieren. Eine Aufrüstung des Arbeitsspeichers ist eine gute kurzfristige Lösung, aber für eine bessere Skalierbarkeit sollten Sie zustandslose Anwendungen entwickeln. Diese verteilen die Speicherlast auf mehrere Instanzen und machen Ihr System widerstandsfähiger.

Engpässe in der Datenbank: Langsame Abfragen sind oft der Grund dafür. Optimieren Sie sie und fügen Sie geeignete Indizes hinzu, um die Abläufe zu beschleunigen. Weitere Strategien sind die Verwendung von Verbindungspools, die Einrichtung von Lesereplikaten zur Verteilung von Abfragelasten und das Sharding von Datenbanken für schreibintensive Anwendungen. Ein Upgrade auf NVMe-SSDs kann ebenfalls zu einer erheblichen Leistungssteigerung führen.

Netzwerkeinschränkungen: Wenn Ihr Netzwerk Probleme hat, sollten Sie ein Upgrade der Bandbreite in Erwägung ziehen und CDNs nutzen, um die Entfernung, die Daten zurücklegen müssen, zu verringern. Komprimieren Sie Antworten und minimieren Sie die Größe der Nutzdaten, um die Datenübertragung effizienter zu gestalten. Für ein globales Publikum kann der Einsatz von Servern an mehreren geografischen Standorten dazu beitragen, die Latenz zu verringern.

Speicherengpässe: Ersetzen Sie herkömmliche Festplatten durch SSDs, um höhere IOPS (Input/Output-Operationen pro Sekunde) zu bewältigen. Verwenden Sie für eine effizientere Speicherverwaltung verteilte Speichersysteme und trennen Sie die Arbeitslasten - zum Beispiel Hochleistungsspeicher für Datenbanken und Standardspeicher für Backups.

Diese Strategien funktionieren am besten, wenn sie mit einer Hosting-Umgebung kombiniert werden, die Skalierbarkeit unterstützt.

Verwendung skalierbarer Hosting-Lösungen

Eine moderne Hosting-Infrastruktur ist eine Schlüsselkomponente bei der Behebung und Vermeidung von Engpässen. FDC Servers bietet Hosting-Optionen, die auf die Herausforderungen der Skalierbarkeit zugeschnitten sind, wie z. B. ungemessene dedizierte Server, die Bandbreitenbeschränkungen beseitigen, und VPS-Lösungen mit EPYC-Prozessoren und NVMe-Speicher für Spitzenleistung.

Die dedizierten Serverpläne, die bei 129 US-Dollar/Monat beginnen, sind in hohem Maße anpassbar. Mit Root-Zugriff und der Möglichkeit, die Hardware zu ändern, können Sie Leistungsprobleme angehen, ohne an starre Hosting-Pläne gebunden zu sein. Außerdem sorgt die ungemessene Bandbreite dafür, dass Netzwerkengpässe Sie nicht ausbremsen.

Für Arbeitslasten, die eine erweiterte Verarbeitungsleistung erfordern, bieten GPU-Server (ab 1.124 US-Dollar/Monat) die Ressourcen, die für KI, maschinelles Lernen und andere intensive Anwendungen benötigt werden. Diese Server bieten außerdem eine ungemessene Bandbreite und anpassbare Konfigurationen, um spezifische Anforderungen zu erfüllen.

Um die Netzwerklatenz in den Griff zu bekommen, ist eine globale Verteilung der Schlüssel. FDC Servers ist an über 70 Standorten weltweit vertreten, sodass Sie Server in der Nähe Ihrer Nutzer einsetzen können, um schnellere Reaktionszeiten zu erzielen. Die CDN-Dienste des Unternehmens verbessern die Bereitstellung von Inhalten durch optimierte globale Präsenzpunkte weiter.

Sie brauchen schnell Ressourcen? Mit der Funktion zur sofortigen Bereitstellung können Sie schnell skalieren und Verzögerungen bei der Hardwarebereitstellung vermeiden. Dies ist besonders nützlich, um plötzliche Verkehrsspitzen zu bewältigen oder Leistungsprobleme kurzfristig zu beheben.

Die Integration dieser Hosting-Lösungen kann Ihre Fähigkeit, Engpässe zu überwinden und sich auf zukünftiges Wachstum vorzubereiten, erheblich verbessern.

Laufende Überwachung und Überprüfung

Eine kontinuierliche Überwachung ist unerlässlich, um sicherzustellen, dass Ihre Korrekturen im Laufe der Zeit wirksam bleiben. Richten Sie automatische Warnmeldungen für wichtige Kennzahlen ein, z. B. für eine CPU-Auslastung von mehr als 75 %, eine Speicherauslastung von mehr als 85 % oder für Antwortzeiten, die die zulässigen Schwellenwerte überschreiten.

Planen Sie monatliche Leistungsüberprüfungen, um Trends zu verfolgen und aufkommende Probleme zu erkennen. Behalten Sie die Wachstumsmetriken im Auge und sehen Sie voraus, wann Ihre aktuellen Ressourcen nicht mehr ausreichen könnten. Wenn Sie Upgrades proaktiv planen, können Sie kostspielige Notfallreparaturen vermeiden, die die Benutzerfreundlichkeit beeinträchtigen.

Regelmäßige Lasttests sind ein weiterer wichtiger Schritt. Testen Sie Ihr System unter den zu erwartenden Lastspitzen und simulieren Sie plötzliche Verkehrsspitzen, um sicherzustellen, dass Ihre Korrekturen den realen Bedingungen gewachsen sind. Allmähliche Laststeigerungen und Stresstests können versteckte Schwachstellen aufdecken, bevor sie zu Problemen werden.

Dokumentieren Sie schließlich alle Engpässe und deren Behebung. So entsteht eine wertvolle Wissensbasis für Ihr Team, die es Ihnen erleichtert, ähnliche Probleme in Zukunft zu lösen. Die Verfolgung der Effektivität Ihrer Lösungen hilft Ihnen außerdem, Ihre Strategien im Laufe der Zeit zu verfeinern und sicherzustellen, dass Ihre Infrastruktur stabil bleibt, wenn sich Ihre Anforderungen weiterentwickeln.

Fazit

Um Skalierungsprobleme effektiv anzugehen, sollten Sie zunächst klare Basiswerte festlegen und Ihr System konsequent überwachen. Messen Sie zunächst wichtige Messwerte wie CPU-Auslastung, Arbeitsspeicher, Festplatten-E/A und Netzwerkdurchsatz, um die typische Leistung Ihres Systems zu ermitteln. Diese Benchmarks helfen Ihnen, Anomalien zu erkennen, wenn sie auftreten.

Nutzen Sie Echtzeit-Dashboards und historische Daten, um Probleme zu erkennen und zu beheben, bevor sie die Benutzererfahrung beeinträchtigen. Tools wie Lasttests und Protokollanalysen sind von unschätzbarem Wert, um die Leistung unter Stress zu bewerten und Schwachstellen in Ihrer Infrastruktur zu identifizieren. Häufige Engpässe wie CPU-Überlastung, Speicherlecks, Datenbankverlangsamung, Netzwerküberlastung und Speicherbeschränkungen erfordern spezifische, gezielte Lösungen.

Die Behebung von Engpässen allein ist jedoch nicht ausreichend. Der wahre Wendepunkt liegt in der proaktiven Überwachung und der skalierbaren Infrastruktur. Ein System, das so konzipiert ist, dass es sich an die steigende Nachfrage anpassen kann, gewährleistet langfristige Zuverlässigkeit und verhindert wiederkehrende Probleme. Moderne Hosting-Optionen wie FDC Servers bieten skalierbare Lösungen mit schneller Bereitstellung und einem globalen Netzwerk, das über 70 Standorte umfasst. Diese Flexibilität ermöglicht es Ihnen, Leistungsprobleme schnell zu beheben, ohne auf neue Hardware warten zu müssen.

Das Geheimnis einer erfolgreichen Skalierung liegt in der Wachsamkeit. Richten Sie automatische Warnmeldungen ein, führen Sie regelmäßige Leistungsprüfungen durch und führen Sie detaillierte Aufzeichnungen über frühere Engpässe, damit Sie später darauf zurückgreifen können. Denken Sie daran, dass die Skalierung keine einmalige Aufgabe ist - sie ist ein fortlaufender Prozess, der sich mit Ihrer Infrastruktur und den Anforderungen der Benutzer weiterentwickelt. Mit der richtigen Kombination aus Überwachung, Tools und skalierbaren Hosting-Lösungen können Sie ein System aufbauen, das nicht nur die heutigen Anforderungen erfüllt, sondern auch für das Wachstum von morgen gerüstet ist.

Häufig gestellte Fragen

Wie lassen sich Datenbankengpässe bei der Skalierung von Servern am besten beheben?

Um Datenbankengpässe bei der Skalierung von Servern zu beheben, sollten Sie zunächst den Datenverkehr gleichmäßiger verteilen. Dies kann mit Tools wie Load Balancern oder Caching-Schichten geschehen, die den Druck auf Ihre Datenbank verringern. Behalten Sie die wichtigsten Metriken mithilfe von Überwachungstools genau im Auge - verfolgen Sie Dinge wie Antwortzeiten, Fehlerraten, CPU-Nutzung, Arbeitsspeicher, Festplatten-E/A und Netzwerkaktivität, um Probleme zu erkennen, bevor sie eskalieren.

Bei Speicher- und Leistungsproblemen sollten Sie Skalierungslösungen wie vertikale Skalierung (Aufrüstung Ihrer Hardware), horizontale Skalierung (Hinzufügen weiterer Server) oder Datenbank-Sharing in Betracht ziehen. Sie können die Effizienz auch durch die Optimierung von Datenbankabfragen und die Gewährleistung einer ordnungsgemäßen Indizierung verbessern. Durch proaktive Überwachung und Feinabstimmung können Sie dafür sorgen, dass Ihr System auch bei wachsenden Servern reibungslos funktioniert.

Wie kann ich feststellen, ob die Leistungsprobleme meines Servers durch Hardware-Einschränkungen oder ineffizienten Anwendungscode verursacht werden?

Um herauszufinden, ob die schleppende Leistung Ihres Servers auf Hardwarebeschränkungen oder schlecht optimierten Anwendungscode zurückzuführen ist, sollten Sie zunächst die wichtigsten Systemmetriken wie CPU-Auslastung, Speicherverbrauch, Festplatten-E/A und Netzwerkaktivität im Auge behalten. Wenn diese Metriken durchgängig an der Obergrenze liegen, ist das ein deutliches Zeichen dafür, dass Ihre Hardware möglicherweise nicht mehr mithalten kann. Wenn jedoch die Hardware-Metriken in Ordnung zu sein scheinen, die Anwendungen aber immer noch hinterherhinken, könnte das Problem im Code verborgen sein.

Leistungsüberwachungs-Tools und Serverprotokolle sind die besten Mittel, um dem Problem auf den Grund zu gehen. Suchen Sie nach Hinweisen auf langsame Datenbankabfragen, ineffiziente Schleifen oder Prozesse, die Ressourcen verbrauchen. Routinemäßige Tests und Optimierungen sind entscheidend, um sicherzustellen, dass Ihr Server das Wachstum bewältigen kann und bei steigenden Anforderungen reibungslos funktioniert.

Was sind die Vorteile von Echtzeit-Überwachungstools gegenüber der Verwendung historischer Daten für die Verwaltung der Server-Skalierbarkeit?

Echtzeit-Überwachungstools sind ein entscheidender Faktor, wenn es darum geht, den reibungslosen Betrieb von Systemen zu gewährleisten. Sie liefern sofortige Warnmeldungen und verwertbare Erkenntnisse und helfen Ihnen, Probleme zu lösen, sobald sie auftreten. Diese Art von sofortigem Feedback ist der Schlüssel zur Vermeidung von Leistungsproblemen bei der Skalierung von Servern. Außerdem wird so sichergestellt, dass Ihre Ressourcen effizient zugewiesen werden, was für die Verwaltung der sich ständig ändernden Arbeitslasten entscheidend ist.

In der Zwischenzeit ist die Analyse historischer Daten von großem Nutzen, wenn es darum geht, langfristige Trends zu erkennen oder die Ursachen vergangener Probleme herauszufinden. Die Sache hat jedoch einen Haken: Wenn Sie sich nur auf historische Daten verlassen, verpassen Sie möglicherweise die Chance, schnell auf aktuelle Probleme zu reagieren. Diese Verzögerung könnte zu Ausfallzeiten oder Leistungsengpässen führen. Obwohl beide Methoden ihre Berechtigung haben, ist die Überwachung in Echtzeit unverzichtbar, wenn es darum geht, schnelle Anpassungen vorzunehmen und die optimale Leistung der Server in schnelllebigen Umgebungen aufrechtzuerhalten.

Wie man Redis auf einem VPS installiert und verwendet

Erfahren Sie, wie Sie Redis auf einem VPS installieren und konfigurieren, um optimale Leistung, Sicherheit und Verwaltung für Ihre Anwendungen zu gewährleisten.

9 Min. Lesezeit - 7. Januar 2026

Welche Möglichkeiten gibt es im Jahr 2025, um Ihren Dedicated Server oder VPS zu überwachen?

12 Min. Lesezeit - 28. November 2025

Sie haben Fragen oder benötigen eine individuelle Lösung?

Flexible Optionen

Globale Reichweite

Sofortige Bereitstellung

Flexible Optionen

Globale Reichweite

Sofortige Bereitstellung