Jak identifikovat úzká místa při škálování serverů

8 min čtení - 22. září 2025

Naučte se identifikovat a odstraňovat úzká místa výkonu při škálování serverů, abyste zvýšili uživatelský komfort a optimalizovali využití zdrojů.

Jak identifikovat úzká místa při škálování serverů

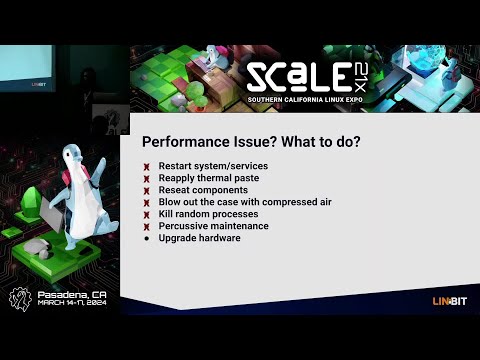

Škálování serverů není jen o přidávání zdrojů - je to o hledání a odstraňování úzkých míst, která omezují výkon. Tato úzká místa mohou způsobovat zpoždění, pády a špatnou uživatelskou zkušenost, a to i s modernizovaným hardwarem. Při řešení těchto problémů se zaměřte na:

- Základní metriky: Měření využití procesoru, paměti, diskových vstupů a výstupů, propustnosti sítě a doby odezvy za normálních podmínek.

- Monitorovací nástroje: Ke sledování výkonu a simulaci provozu používejte platformy jako New Relic, Grafana a JMeter.

- Testování: Provádějte zátěžové a stresové testy, abyste identifikovali zlomová místa.

- Analýza: Zkoumejte protokoly, využití prostředků a výkon databáze, abyste zjistili neefektivitu.

- Opravy: Optimalizace kódu, upgrade hardwaru (např. SSD) a v případě potřeby implementace horizontálního škálování.

Diagnostika úzkých míst výkonu v produkčních systémech

Nastavení referenčních hodnot výkonu

Pro zjištění, zda jsou změny ve výkonu serveru běžnými výkyvy, nebo skutečnými úzkými místy, je zásadní mít k dispozici výchozí údaje. Základní hodnoty poskytují referenční bod, který usnadňuje odhalení odchylek od typického chování serveru.

Chcete-li vytvořit přesné výchozí hodnoty, shromážděte údaje o výkonu, které odrážejí běžné denní a týdenní vzorce provozu.

Klíčové metriky, které je třeba sledovat

Sledování správných metrik je zásadní pro včasnou identifikaci problémů s výkonem.

- Využití procesoru: Tato hodnota ukazuje, kolik výpočetního výkonu váš server v daném okamžiku využívá. Přijatelné rozsahy závisí na konkrétním nastavení, sledování využití procesoru však může odhalit, kdy je systém přetížen nebo nedostatečně využíván.

- Využití paměti: Tato hodnota sleduje množství paměti RAM, které vaše aplikace spotřebovávají. Dlouhodobě vysoké využití paměti může systém donutit spoléhat se na pomalejší odkládací prostor na disku, což výrazně zpomalí výkon.

- Metriky diskových vstupů a výstupů: Ty měří, jak efektivně vaše úložiště čte a zapisuje data. Mezi klíčové metriky patří IOPS (vstupně-výstupní operace za sekundu) a latence disku. Například tradiční pevné disky obvykle dosahují 100-200 IOPS s latencí 10-15 milisekund, zatímco disky NVMe SSD mohou poskytovat mnohem vyšší IOPS s latencí pod milisekundu.

- Síťová propustnost: Tato hodnota měří rychlost přenosu dat v Mb/s nebo Gb/s. Zásadní je sledování příchozí i odchozí šířky pásma spolu s mírou ztráty paketů. Ztráta paketů přesahující 0,1 % často indikuje přetížení sítě nebo problémy s hardwarem.

- Doba odezvy: Doba odezvy odráží, jak rychle aplikace zpracovávají požadavky. Pro webové aplikace je ideální doba odezvy do několika set milisekund. Výzkum společnosti Google zdůrazňuje, že u mobilních stránek, jejichž načtení trvá tři a více sekund, je míra opuštění 53 %.

- Metriky specifické pro jednotlivé aplikace: Tyto metriky se liší v závislosti na vašem softwarovém balíku, ale mohou zahrnovat dobu dotazů do databáze, počet zásahů do mezipaměti nebo počet aktivních připojení. Například rychlé dotazy do databáze a vysoká míra zasažení mezipaměti jsou nezbytné pro udržení vysokého celkového výkonu.

Pravidelné sledování těchto metrik zajistí, že budete moci řešit problémy s výkonem dříve, než bude nutné škálování.

Srovnávací měření a zaznamenávání dat

Chcete-li stanovit spolehlivé výchozí hodnoty, provozujte servery při běžném produkčním zatížení po dobu alespoň dvou týdnů. Zaznamenávejte data v pravidelných intervalech - každých 5 až 10 minut je dobrou rovnováhou mezi podrobností a efektivitou úložiště.

Důležité je takésrovnávání při špičkovém zatížení. Změřte, jak si systém vede během nejvytíženějších období provozu, abyste mohli předvídat budoucí potřeby škálování.

Při dokumentování základních dat uvádějte časové značky, hodnoty metrik a relevantní kontext. Tento podrobný záznam vám pomůže porovnat výkon před a po škálování.

Další důležitou součástí jsouměření doby provozuschopnosti. Např:

- 99 % provozuschopnosti odpovídá zhruba 7 hodinám výpadku za měsíc.

- Doba provozuschopnosti 99,9 % snižuje prostoje na přibližně 45 minut za měsíc.

- Zlatý standard, 99,999% uptime (pět devítek), umožňuje pouhých 30 sekund výpadku měsíčně.

Můžete také zvážit použití bodového hodnocení Apdex pro zjištění spokojenosti uživatelů s dobou odezvy. Toto skóre se pohybuje v rozmezí od 0 (špatná) do 1 (vynikající), a to na základě kategorizace doby odezvy do zón spokojenosti, tolerance a frustrace. Skóre vyšší než 0,85 obecně znamená pozitivní uživatelskou zkušenost.

Základní údaje ukládejte do centralizovaného systému, abyste k nim měli snadný přístup a mohli je porovnávat. K uchovávání historických dat se běžně používají databáze časových řad nebo monitorovací platformy, které usnadňují určení, zda jsou změny výkonu způsobeny škálováním nebo základními problémy systému.

Po zavedení těchto základních údajů jste připraveni přejít k nástrojům a technikám monitorování výkonu v reálném čase.

Nástroje pro monitorování a analýzu

Správné monitorovací nástroje mohou přeměnit nezpracovaná data na užitečné poznatky a pomoci vám odhalit úzká místa dříve, než naruší uživatelskou zkušenost. Díky řadě funkcí, jako jsou upozornění v reálném čase a hloubková analýza výkonu, se výběr správných nástrojů stává zásadním pro efektivní identifikaci a řešení problémů.

Základní monitorovací nástroje

Platformy pro monitorování výkonu aplikací (APM ), jako je New Relic, jsou nepostradatelné pro sledování metrik aplikací a uživatelských zkušeností. Tyto nástroje automaticky zachycují klíčové údaje, jako je doba odezvy, chybovost a sledování transakcí. Funkce, jako je distribuované trasování, usnadňují určení pomalých databázových dotazů nebo pomalých volání API.

Grafana je všestranný vizualizační nástroj, který se integruje s mnoha zdroji dat. Ve spojení s databázemi časových řad, jako je Prometheus nebo InfluxDB, Grafana vyniká při vytváření řídicích panelů, které propojují metriky - například korelují nárůsty CPU s pomalejšími časy odezvy - a usnadňují tak odhalení problémů s výkonem na první pohled.

Apache JMeter je nástroj pro testování zátěže, který aktivně simuluje uživatelský provoz a měří, jak systémy zvládají souběžné uživatele. Generováním provozu a testováním propustnosti serveru za různých podmínek pomáhá JMeter identifikovat zlomová místa a omezení zdrojů dříve, než ovlivní produkční prostředí.

ELK Stack (Elasticsearch, Logstash a Kibana ) se zaměřuje na analýzu logů a možnosti vyhledávání. Logstash shromažďuje a zpracovává data logů, Elasticsearch umožňuje jejich prohledávání a Kibana vizualizuje výsledky. Tato kombinace je ideální pro identifikaci chybových vzorců, sledování četnosti událostí a propojení logů s poklesem výkonu.

Nástroje pro monitorování na úrovni systému, jako jsou Nagios, Zabbix a Datadog, poskytují pohled na metriky infrastruktury z ptačí perspektivy. Tyto platformy monitorují kritické údaje o hardwaru, jako je využití procesoru, spotřeba paměti, diskové vstupy/výstupy a síťový provoz, a jsou tak nezbytné pro odhalování úzkých míst souvisejících s hardwarem a plánování upgradů kapacity.

Nástroje pro monitorování databází, jako je pgAdmin pro PostgreSQL nebo MySQL Enterprise Monitor, nabízejí specializovaný pohled na výkon databází. Tyto nástroje sledují metriky, jako jsou časy provádění dotazů, spor o zámky a využití vyrovnávací paměti - podrobnosti, které mohou monitory pro obecné použití přehlížet, ale které jsou pro optimalizaci výkonu databáze klíčové.

Každý typ nástroje slouží jedinečnému účelu: nástroje APM se zaměřují na výkon aplikací, systémové monitory zpracovávají hardwarové metriky a databázové nástroje se specializují na analýzu úložiště a dotazů. Mnoho organizací používá kombinaci těchto nástrojů, aby pokryly celý svůj technologický stack a zajistily si tak okamžité řešení problémů i dlouhodobou optimalizaci výkonu.

Data v reálném čase vs. historická data

Monitorování v reálném čase poskytuje aktuální přehled o výkonu systému, což týmům umožňuje rychle reagovat na vznikající problémy. Dashboardy se obnovují každých několik sekund a zobrazují živé metriky, jako je využití procesoru, aktivní připojení a doba odezvy. To má zásadní význam pro zachycení náhlých nárůstů provozu, úniků paměti nebo selhávajících komponent dříve, než přerostou ve větší problémy.

Upozornění v reálném čase se spustí, když metriky překročí předem definované prahové hodnoty - například využití CPU přesáhne 80 % nebo doba odezvy překročí 2 sekundy. Tato upozornění umožňují týmům řešit problémy během několika minut, čímž se minimalizují prostoje.

Analýza historických dat zase odhaluje dlouhodobé trendy a opakující se vzorce, které by monitorování v reálném čase mohlo přehlédnout. Zkoumáním dat za několik týdnů nebo měsíců mohou týmy identifikovat sezónní výkyvy provozu, postupný pokles výkonu nebo opakující se úzká místa. Například 15% nárůst doby dotazů do databáze během tří měsíců může signalizovat rostoucí objemy dat nebo neefektivní dotazy, které je třeba optimalizovat.

Historická analýza také podporuje plánování kapacity. Trendy, jako je rostoucí využití paměti nebo stupňující se objem provozu, pomáhají předpovědět, kdy zdroje dosáhnou svých limitů, což umožňuje proaktivní škálování nebo upgrade.

Kombinace obou přístupů vytváří komplexní monitorovací strategii. Data v reálném čase poskytují okamžitou zpětnou vazbu pro krizové řízení, zatímco historická analýza poskytuje informace pro strategická rozhodnutí s cílem předcházet budoucím problémům. Mnoho moderních nástrojů bezproblémově integruje obojí a vedle ukládání historických dat nabízí i ovládací panely v reálném čase, takže týmy mohou bez problémů přepínat mezi krátkodobým řešením problémů a dlouhodobým plánováním.

Nejlepších výsledků dosáhnete, když týmy rutinně procházejí upozornění v reálném čase, aby mohly řešit okamžité problémy, a analyzují historické trendy pro chytřejší rozhodnutí o škálování a optimalizaci. Tento dvojí přístup zajišťuje, že systémy zůstanou efektivní a odolné v průběhu času.

Jak najít úzká místa krok za krokem

Jakmile stanovíte základní metriky a nastavíte monitorovací nástroje, dalším krokem je vyhledání úzkých míst. To zahrnuje systematické testování, monitorování a analýzu systému při zátěži s cílem zjistit, kde vznikají problémy s výkonem.

Zátěžové a zátěžové testování

Testování zátěže vám pomůže vyhodnotit, jak váš systém funguje při typických nárocích uživatelů. Začněte tím, že definujete své výkonnostní cíle, jako je přijatelná doba odezvy, cílové hodnoty propustnosti a prahové hodnoty chybovosti. Tyto cíle slouží jako měřítka pro zjištění odchylek. Nástroje jako JMeter nebo Gatling mohou simulovat provoz a postupně zvyšovat zátěž, dokud se výkon nezačne snižovat.

Zátěžové testování naproti tomu posouvá systém za jeho běžné hranice, aby odhalilo zlomové body. Během obou testů sledujte metriky, jako je využití procesoru, spotřeba paměti a šířka pásma sítě. Například využití procesoru blížící se 100 %, skokové nárůsty paměti nebo maximální šířka pásma často korelují s pomalejší odezvou nebo vyšší chybovostí.

Monitorování reálných uživatelů (RUM) může tyto syntetické testy doplnit o údaje o skutečných zkušenostech uživatelů. To může odhalit úzká místa, která by kontrolované testy mohly přehlédnout.

Dalším krokem je analýza využití zdrojů, která umožní určit hlavní příčiny problémů s výkonem.

Analýza zdrojů

Porovnejte údaje o využití prostředků se základními metrikami, abyste odhalili skrytá omezení. Na co se zaměřit:

- CPU: Úzká místa se často objevují, když využití trvale přesahuje 80 % nebo neočekávaně prudce stoupá.

- Paměť: Vysoké nebo nepravidelné využití může naznačovat úniky paměti nebo neefektivitu.

- Diskové I/O: Sledujte vysoké využití nebo dlouhé čekací doby, které mohou zpomalovat operace.

- Síť: Zkontrolujte využití šířky pásma a latenci, abyste zjistili pomalé odezvy API nebo časové výpadky.

- Výkon databáze: Pomocí nástrojů, jako je MySQL Workbench nebo SQL Profiler, analyzujte dobu provádění dotazů, indexování a zamykání transakcí. Dotazy trvající déle než 100 milisekund mohou naznačovat neefektivní operace, jako je zpracování řádek po řádku (RBAR), které je třeba optimalizovat.

Analýza protokolů a trasování

Protokoly a stopy poskytují v kombinaci se základními metrikami a metrikami v reálném čase kritické poznatky. Protokoly mohou upozornit na opakující se chyby, časové výpadky nebo varování o nedostatku prostředků, které signalizují úzká místa. Například hlášení o časovém limitu nebo chyby související s limity prostředků často ukazují přímo na problémové oblasti.

Distribuované sledovací nástroje, jako je OpenTelemetry s Jaegerem, umožňují sledovat cestu požadavku napříč mikroslužbami a odhalit zpoždění způsobená pomalými dotazy do databáze, časovými limity API nebo problematickými závislostmi služeb. Detailní instrumentace, například zaznamenávání časů zahájení a ukončení operací, může pomoci identifikovat části kódu, které spotřebovávají nadměrné množství prostředků. Podobně mohou protokoly databázových dotazů odhalit neefektivity, jako jsou operace RBAR.

Další oblastí, kterou stojí za to prozkoumat, je konflikt vláken. Analýza výpisů vláken může odhalit mrtvé bloky, hladovění vláken nebo nadměrné přepínání kontextu, které mohou snižovat výkon. Zachycení snímků stop zásobníku během výkonnostních špiček může dále přesně určit cesty kódu, které způsobují zpoždění.

Mezi březnem a listopadem 2020 zaznamenalo Miro sedminásobný nárůst využití, které dosáhlo více než 600 000 unikátních uživatelů denně. Aby bylo možné během tohoto rychlého škálování řešit úzká místa serveru, zaměřil se systémový tým společnosti Miro na sledování mediánu doby dokončení úloh (percentil), nikoli na průměry nebo velikosti front. Tento přístup jim pomohl optimalizovat procesy, které měly dopad na většinu uživatelů.

Běžné zdroje úzkých míst a jejich účinky

Pochopení úzkých míst je klíčové pro zacílení úsilí v oblasti monitorování a zrychlení doby odezvy. Různá úzká místa zanechávají odlišné stopy, které vám mohou pomoci přesně určit a účinně řešit problémy.

Zde je přehled nejčastějších zdrojů úzkých míst, jejich varovných příznaků, metod detekce a způsobů, jak omezují škálovatelnost:

Hlubší ponor do problematiky úzkých míst

Kúzkým místům v procesoru dochází nejčastěji při nárůstu provozu. Když využití CPU překročí 80 %, systém začne řadit požadavky do fronty, což vede ke zpoždění a časovým výpadkům. V tomto okamžiku se jediným schůdným řešením často stává horizontální škálování.

Problémy s pamětí bývají tiché, dokud se využití paměti RAM nepřiblíží kritické úrovni. Jakmile k tomu dojde, mohou aplikace spadnout nebo se výrazně zpomalit v důsledku přetížení odpadkového koše, což si vynutí nákladné upgrady nebo optimalizační úsilí.

Úzká místa v databázi jsou běžným problémem při škálování webových aplikací. Symptomy, jako jsou výpadky dotazů a vyčerpané fondy připojení, mohou ochromit výkon, což často vyžaduje clusterování databáze nebo přidání replik pro čtení, aby se rozložila zátěž.

Síťová omezení se obvykle projevují při práci s velkými soubory nebo častými voláními API. Vysoká latence nebo ztráta paketů, zejména v různých regionech, často signalizuje potřebu sítí pro doručování obsahu (CDN) nebo jiných distribučních strategií.

Úzká místa v úložišti vznikají s rostoucími požadavky na data. Tradiční disky s omezeným počtem IOPS mohou zpomalovat operace se soubory a zápisy do databáze, takže pro zachování výkonu jsou rozhodující disky SSD nebo distribuované architektury úložišť.

Úzká místa v kódu aplikací jsou jedinečná, protože pramení z neefektivity návrhu nebo implementace, jako jsou úniky paměti nebo špatné strategie ukládání do mezipaměti. Náprava těchto problémů často vyžaduje hloubkové profilování, refaktoring nebo dokonce přepracování architektury tak, aby zvládla požadavky na škálování.

Řešení úzkých míst pro lepší škálovatelnost

Úzká místa hardwaru, jako je procesor a paměť, lze někdy zmírnit pomocí vertikálního škálování, ale tento přístup má své limity. Nakonec se horizontální škálování stane nevyhnutelným. Na druhou stranu úzká místa v databázi a aplikačním kódu obvykle vyžadují optimalizační práce, než mohou být dodatečné zdroje plně efektivní.

Odstranění úzkých míst pro lepší škálování

Po identifikaci úzkých míst je dalším krokem jejich účinné řešení. Cílem je řešit základní příčiny, nikoliv pouze příznaky, a zajistit tak, aby vaše infrastruktura zvládla budoucí růst, aniž by se potýkala se stejnými problémy.

Odstranění identifikovaných úzkých míst

Úzká místa v procesoru: Pokud využití procesoru pravidelně přesahuje 80 %, je čas jednat. Začněte optimalizací kódu - zefektivněte neefektivní algoritmy a omezte operace náročné na zdroje. Upgrade hardwaru (vertikální škálování) sice může přinést okamžitou úlevu, ale je to jen dočasné řešení. Pro dlouhodobou škálovatelnost zaveďte vyrovnávání zátěže a horizontální škálování, abyste rozdělili pracovní zátěž mezi více serverů, protože jediný server nakonec narazí na své limity.

Problémy s pamětí: Pomocí profilovacích nástrojů odhalte úniky paměti a optimalizujte způsob, jakým aplikace alokuje paměť. Upgrade paměti RAM je dobrým krátkodobým řešením, ale pro lepší škálovatelnost zvažte návrh bezstavových aplikací. Ty rozdělují paměťovou zátěž mezi více instancí, díky čemuž je váš systém odolnější.

Úzká místa v databázi: Často jsou na vině pomalé dotazy. Optimalizujte je a přidejte vhodné indexy, abyste vše urychlili. Mezi další strategie patří používání sdružování připojení, nastavení replik pro čtení k rozdělení zátěže dotazů a rozdělení databází pro aplikace náročné na zápis. Výrazné zvýšení výkonu může přinést také upgrade na disky SSD NVMe.

Síťová omezení: Pokud má vaše síť potíže, zvažte zvýšení šířky pásma a použití sítí CDN ke snížení vzdálenosti, kterou musí data překonat. Komprimujte odpovědi a minimalizujte velikost užitečného zatížení, abyste zefektivnili přenosy dat. V případě globálního publika může nasazení serverů ve více geografických lokalitách pomoci snížit latenci.

Úzká místa v úložišti: Vyměňte tradiční pevné disky za disky SSD, abyste zvládli vyšší počet vstupních a výstupních operací za sekundu (IOPS). Pro efektivnější správu úložišť používejte distribuované úložné systémy a oddělte pracovní zátěže - například vysoce výkonné úložiště pro databáze a standardní úložiště pro zálohování.

Tyto strategie nejlépe fungují ve spojení s hostingovým prostředím, které podporuje škálovatelnost.

Použití škálovatelných hostingových řešení

Moderní hostingová infrastruktura je klíčovou součástí při řešení a prevenci úzkých míst. Společnost FDC Servers nabízí možnosti hostingu přizpůsobené problémům se škálovatelností, jako jsou dedikované servery bez měření, které odstraňují omezení šířky pásma, a řešení VPS poháněná procesory EPYC s úložištěm NVMe pro špičkový výkon.

Jejich plány dedikovaných serverů, které začínají na 129 dolarech měsíčně, jsou vysoce přizpůsobitelné. Díky přístupu root a možnosti upravovat hardware můžete řešit problémy s výkonem, aniž byste byli vázáni na rigidní hostingové plány. Navíc díky neměřené šířce pásma vás nebudou zpomalovat úzká místa v síti.

Pro pracovní zátěže vyžadující pokročilý výpočetní výkon poskytují GPU servery (od 1 124 USD/měsíc) prostředky potřebné pro AI, strojové učení a další náročné aplikace. Tyto servery jsou také vybaveny neměřenou šířkou pásma a přizpůsobitelnými konfiguracemi pro splnění konkrétních požadavků.

Pro řešení síťové latence je klíčová globální distribuce. FDC Servers působí ve více než 70 lokalitách po celém světě, což vám umožní nasadit servery blíže k uživatelům a zkrátit tak dobu odezvy. Jejich služby CDN dále zlepšují doručování obsahu díky optimalizovaným globálním bodům přítomnosti.

Potřebujete rychle zdroje? Jejich funkce okamžitého nasazení vám umožní rychle rozšířit kapacitu a vyhnout se tak prodlevám při zajišťování hardwaru. To je užitečné zejména při řešení náhlých nárůstů provozu nebo při řešení problémů s výkonem v krátké době.

Začlenění těchto hostingových řešení může výrazně zlepšit vaši schopnost překonávat úzká místa a připravit se na budoucí růst.

Průběžné monitorování a kontrola

Průběžné monitorování je nezbytné k zajištění toho, aby vaše opravy zůstaly účinné v průběhu času. Nastavte automatická upozornění na klíčové metriky, jako je využití procesoru přesahující 75 %, využití paměti nad 85 % nebo doba odezvy přesahující přijatelné prahové hodnoty.

Naplánujte měsíční přezkumy výkonu, abyste mohli sledovat trendy a odhalit vznikající problémy. Sledujte růstové metriky a předvídejte, kdy by vaše současné zdroje mohly být nedostatečné. Proaktivním plánováním upgradů se vyhnete nákladným nouzovým opravám, které naruší uživatelský komfort.

Dalším důležitým krokem je pravidelné testování zátěže. Testujte systém při očekávaném špičkovém zatížení a simulujte náhlé nárůsty provozu, abyste se ujistili, že opravy zvládnou reálné podmínky. Postupné zvyšování zátěže a zátěžové testy mohou odhalit skryté chyby dříve, než se stanou problémem.

Nakonec zdokumentujte každý incident s úzkým místem a jeho řešení. Vytvoříte tak pro svůj tým cennou znalostní bázi, která usnadní řešení podobných problémů v budoucnu. Sledování efektivity řešení vám také pomůže v průběhu času zdokonalovat vaše strategie a zajistí, že vaše infrastruktura zůstane robustní s tím, jak se budou vyvíjet vaše potřeby.

Závěr

Chcete-li efektivně řešit problémy se škálováním, začněte stanovením jasných výchozích hodnot a důsledným sledováním systému. Začněte měřením klíčových metrik, jako je využití procesoru, paměti, diskových vstupů a výstupů a propustnost sítě, abyste pochopili typický výkon svého systému. Tato měřítka vám pomohou odhalit abnormality, když se objeví.

Využijte řídicí panely v reálném čase a historická data k odhalení a vyřešení problémů dříve, než naruší práci uživatelů. Nástroje, jako je testování zátěže a analýza protokolů, jsou neocenitelné pro posouzení výkonu při zátěži a identifikaci slabých míst vaší infrastruktury. Běžná úzká místa, jako je přetížení procesoru, úniky paměti, zpomalení databází, přetížení sítě a omezení úložiště, vyžadují specifická, cílená řešení.

Oprava úzkých míst však sama o sobě nestačí. Skutečnou změnu hry přináší proaktivní monitorování a škálovatelná infrastruktura. Systém navržený tak, aby se přizpůsobil rostoucím nárokům, zajišťuje dlouhodobou spolehlivost a zabraňuje opakovaným problémům. Moderní možnosti hostingu, jako jsou servery FDC, nabízejí škálovatelná řešení s rychlým nasazením a globální sítí pokrývající více než 70 lokalit. Tato flexibilita umožňuje rychle řešit problémy s výkonem bez čekání na nový hardware.

Tajemstvím úspěšného škálování je zůstat ostražitý. Nastavte automatická upozornění, provádějte pravidelné kontroly výkonu a uchovávejte podrobné záznamy o minulých úzkých místech pro budoucí použití. Nezapomeňte, že škálování není jednorázový úkol - je to průběžný proces, který se vyvíjí spolu s vaší infrastrukturou a potřebami uživatelů. Díky správné kombinaci monitorování, nástrojů a škálovatelných hostingových řešení můžete vytvořit systém, který nejen splňuje dnešní požadavky, ale je připraven i na zítřejší růst.

Často kladené dotazy

Jaké jsou nejlepší způsoby řešení úzkých míst databáze při škálování serverů?

Chcete-li řešit úzká místa databáze při škálování serverů, začněte rovnoměrnějším rozložením provozu. To lze provést pomocí nástrojů, jako jsou vyrovnávače zátěže nebo vrstvy mezipaměti, které pomáhají snížit tlak na databázi. Pomocí monitorovacích nástrojů pečlivě sledujte klíčové metriky - sledujte například dobu odezvy, chybovost, využití procesoru, paměti, diskových vstupů a výstupů a síťovou aktivitu, abyste identifikovali problémy dříve, než dojde k jejich eskalaci.

V případě problémů s úložištěm a výkonem zvažte řešení škálování, jako je vertikální škálování (upgrade hardwaru), horizontální škálování (přidání dalších serverů) nebo rozdělení databáze. Efektivitu můžete zvýšit také optimalizací databázových dotazů a zajištěním správného indexování. Pokud budete proaktivně monitorovat a dolaďovat, udržíte hladký chod systému i při růstu serverů.

Jak zjistím, zda jsou problémy s výkonem mého serveru způsobeny hardwarovými omezeními nebo neefektivním kódem aplikace?

Chcete-li zjistit, zda je pomalý výkon vašeho serveru způsoben hardwarovými omezeními nebo špatně optimalizovaným kódem aplikace, začněte sledováním klíčových systémových metrik, jako je využití procesoru, spotřeba paměti, diskové I/O a síťová aktivita. Pokud jsou tyto metriky trvale na maximu, je to jasné znamení, že váš hardware možná nestíhá. Pokud se však metriky hardwaru zdají být v pořádku, ale aplikace stále zaostávají, problém může být skrytý v kódu.

Nástroje pro monitorování výkonu a protokoly serverů jsou vašimi zdroji, které vám pomohou proniknout hlouběji. Hledejte stopy, jako jsou pomalé databázové dotazy, neefektivní smyčky nebo procesy, které zahlcují zdroje. Rutinní testování a ladění jsou klíčové pro zajištění toho, aby váš server zvládl růst a fungoval hladce při zvyšujících se nárocích.

Jaké jsou výhody nástrojů pro monitorování v reálném čase oproti používání historických dat pro správu škálovatelnosti serveru?

Nástroje pro monitorování v reálném čase mění pravidla hry, pokud jde o udržení hladkého chodu systémů. Poskytují okamžitá upozornění a využitelné poznatky, které vám pomohou řešit problémy hned, jak nastanou. Tento druh okamžité zpětné vazby je klíčem k tomu, abyste se vyhnuli výkonnostním zádrhelům při škálování serverů. Navíc zajišťuje efektivní přidělování zdrojů, což je klíčové pro správu neustále se měnících pracovních zátěží.

Analýza historických dat se zase osvědčí, pokud jde o odhalování dlouhodobých trendů nebo zjišťování příčin minulých problémů. Má to však háček - pokud se spoléháte pouze na historická data, můžete propásnout možnost rychle jednat v případě aktuálních problémů. Toto zpoždění by mohlo vést k výpadkům nebo omezení výkonu. I když obě metody mají své místo, monitorování v reálném čase je nepostradatelné pro rychlé úpravy a udržení co nejlepšího výkonu serverů v rychle se měnících prostředích.

Jak nainstalovat a používat Redis na VPS

Přečtěte si, jak nainstalovat a nakonfigurovat Redis na VPS pro optimální výkon, zabezpečení a správu ve vašich aplikacích.

9 min čtení - 7. ledna 2026

Monitorování dedikovaného serveru nebo VPS, jaké jsou možnosti v roce 2025?

12 min čtení - 28. listopadu 2025

Máte dotazy nebo potřebujete vlastní řešení?

Flexibilní možnosti

Globální dosah

Okamžité nasazení

Flexibilní možnosti

Globální dosah

Okamžité nasazení