Pracovní zátěž umělé inteligence v prostředí virtualizovaném na GPU: Průvodce optimalizací

11 min čtení - 10. října 2025

- Pracovní zátěž umělé inteligence v prostředí virtualizovaném na GPU: Průvodce optimalizací

- Základy virtualizace GPU pro AI

- Infrastruktura AI/ML: Vysvětlení časového řezu GPU

- Požadavky na hardware a infrastrukturu

- Konfigurace virtuálního počítače a GPU

- Monitorování výkonu a plánování

- Servery FDC pro infrastrukturu umělé inteligence

- Závěr

- Často kladené dotazy

Prozkoumejte, jak virtualizace GPU zlepšuje pracovní zátěž umělé inteligence tím, že zvyšuje efektivitu, snižuje náklady a optimalizuje správu zdrojů ve virtualizovaných prostředích.

- Pracovní zátěž umělé inteligence v prostředí virtualizovaném na GPU: Průvodce optimalizací

- Základy virtualizace GPU pro AI

- Infrastruktura AI/ML: Vysvětlení časového řezu GPU

- Požadavky na hardware a infrastrukturu

- Konfigurace virtuálního počítače a GPU

- Monitorování výkonu a plánování

- Servery FDC pro infrastrukturu umělé inteligence

- Závěr

- Často kladené dotazy

Pracovní zátěž umělé inteligence v prostředí virtualizovaném na GPU: Průvodce optimalizací

Virtualizace GPU mění způsob správy pracovních zátěží AI. Rozdělením fyzického GPU na více virtuálních instancí lze spustit několik úloh AI současně, což zvyšuje efektivitu a snižuje náklady na hardware. Tento přístup je cenný zejména pro trénování složitých modelů, zpracování úloh náročných na zdroje a škálování projektů AI bez nutnosti investovat do dalších GPU.

Zde je vysvětlení, proč je to důležité:

- Efektivní využití GPU: Vyhněte se nečinnému hardwaru sdílením prostředků mezi úlohami a týmy.

- Úspora nákladů: Vysoce výkonné GPU jsou drahé; virtualizace zajišťuje jejich maximální využití.

- Flexibilita: Přizpůsobení virtuálních instancí GPU konkrétním potřebám, například velikosti paměti nebo verzím CUDA.

- Škálovatelnost: Dynamicky upravujte zdroje podle toho, jak roste pracovní zátěž AI.

- Spolehlivost: Izolované instance zabraňují tomu, aby jedna úloha ovlivnila ostatní.

Optimalizace výkonu:

- Zvolte GPU s velkou pamětí a šířkou pásma (např. NVIDIA A100/H100).

- Pro zpracování dat používejte úložiště NVMe a sítě s nízkou latencí.

- Konfigurujte virtuální počítače s GPU passthrough nebo vGPU partitioning na základě potřeb pracovní zátěže.

- Využívejte nástroje, jako je NVIDIA GPU Operator, zásuvné moduly Kubernetes a SLURM pro orchestraci.

- Monitorujte výkon pomocí nástrojů, jako jsou NVIDIA Nsight Systems a DCGM, a identifikujte úzká místa.

Hostingové služby jako FDC Servers poskytují řešení GPU na míru již od 1 124 USD/měsíc, včetně neměřené šířky pásma a možností globálního nasazení pro rozsáhlé projekty AI.

Závěr: Virtualizace GPU zefektivňuje správu zdrojů, zvyšuje výkon a snižuje náklady na pracovní zátěže AI, což z ní činí praktické řešení pro efektivní škálování operací AI.

Základy virtualizace GPU pro AI

Co je virtualizace GPU?

Virtualizace GPU umožňuje více uživatelům sdílet jeden GPU vytvořením virtuálních instancí, z nichž každá má vlastní vyhrazenou paměť, jádra a výpočetní výkon. To znamená, že jeden GPU může zpracovávat více úloh nebo uživatelů najednou, což z něj činí efektivní řešení pro pracovní zátěže AI.

Ve své podstatě se tato technologie opírá o hypervizor, který funguje jako správce a rozděluje prostředky GPU mezi virtuální stroje. Hypervisor zajišťuje, že každá instance dostane svůj přidělený podíl bez zásahů ostatních. Pro úlohy AI to umožňuje, aby na jediném grafickém procesoru NVIDIA A100 nebo H100 běželo současně několik experimentů strojového učení, tréninkových relací nebo inferenčních operací.

Existují dvě hlavní metody sdílení těchto prostředků:

- Virtualizace na úrovni hardwaru: Technologie NVIDIA Multi-Instance GPU (MIG) fyzicky rozděluje GPU na izolované části, čímž zajišťuje silné oddělení jednotlivých instancí.

- Virtualizace na softwarové úrovni: Tato metoda využívá k rozdělení prostředků GPU ovladače a software a nabízí větší flexibilitu, ale o něco menší izolaci.

Jeden z klíčových rozdílů mezi virtualizací GPU a tradiční virtualizací CPU spočívá ve správě paměti. GPU používají paměť s vysokou propustností (HBM), která pracuje jinak než standardní systémová paměť RAM. Efektivní správa této paměti je klíčová zejména při operacích AI náročných na zdroje, jako je jemné ladění nebo rozsáhlé školení.

Tyto základní poznatky připravují půdu pro zkoumání toho, jak virtualizace GPU zvyšuje výkon AI v praktických scénářích.

Přínosy pro pracovní zátěž AI a strojového učení

Virtualizace nabízí řadu výhod, které přímo řeší problémy pracovních zátěží AI a strojového učení (ML).

Jednou z výrazných výhod je maximální využití GPU. Vysoce výkonné GPU, které mohou stát od 10 000 do 30 000 dolarů, jsou často nedostatečně využívány při úlohách, jako je předzpracování dat nebo nastavení modelu. Virtualizace zajišťuje plné využití těchto nákladných zdrojů tím, že umožňuje více úlohám sdílet stejný GPU, čímž se zkracuje doba nečinnosti a snižují náklady na hardware. Tento přístup umožňuje organizacím obsluhovat více uživatelů a aplikací, aniž by potřebovaly další fyzické GPU.

Flexibilita při vývoji je další změnou, která mění pravidla hry. Díky virtualizaci mohou vývojáři vytvářet virtuální instance GPU přizpůsobené konkrétním potřebám, jako jsou různé verze CUDA, velikosti paměti nebo konfigurace ovladačů. Tato izolace zajišťuje, že projekty využívající frameworky jako PyTorch, TensorFlow nebo JAX mohou koexistovat bez konfliktů, což zefektivňuje pracovní postupy a urychluje inovace.

Škálovatelnost se stává mnohem snadněji spravovatelnou. Pracovní zátěže umělé inteligence se mohou svými nároky výrazně lišit. Například trénování malé neuronové sítě může vyžadovat minimální prostředky, zatímco doladění rozsáhlého jazykového modelu vyžaduje obrovský výpočetní výkon. Virtuální instance mohou dynamicky škálovat nahoru nebo dolů a přidělovat zdroje na základě intenzity pracovní zátěže. Tato přizpůsobivost zajišťuje efektivní využití zdrojů za všech okolností.

Podpora více nájemců je obzvláště cenná pro organizace s různými potřebami. Díky sdílení infrastruktury mohou různá oddělení, zákazníci nebo aplikace přistupovat ke zdrojům GPU bez nutnosti spravovat fyzický hardware. Poskytovatelé cloudu mohou dokonce nabízet GPU jako službu, což uživatelům umožňuje využívat virtuální instance GPU při zachování izolace výkonu a snížení složitosti správy.

A konečně, izolace poruch zajišťuje stabilitu. Pokud dojde k pádu jedné virtuální instance nebo k nadměrné spotřebě prostředků, nenaruší to chod ostatních instancí sdílejících stejný GPU. Tato spolehlivost je kritická v produkčních prostředích, kde musí plynule a konzistentně fungovat více služeb AI.

Virtualizace GPU nejen optimalizuje využití zdrojů, ale také poskytuje týmům AI nástroje a flexibilitu potřebné k řešení složitých, neustále se měnících pracovních zátěží.

Infrastruktura AI/ML: Vysvětlení časového řezu GPU

Požadavky na hardware a infrastrukturu

Dosažení nejlepšího výkonu AI ve virtualizovaných prostředích GPU do značné míry závisí na správném výběru hardwaru a propojení. Tato rozhodnutí hrají klíčovou roli při maximalizaci potenciálu virtualizace GPU pro pracovní zátěže AI.

Výběr správné architektury GPU

Při výběru GPU pro úlohy AI hledejte modely s vysokou kapacitou paměti, rychlou šířkou pásma a integrovanou podporou virtualizace. Mnoho moderních GPU lze rozdělit do několika izolovaných instancí, což umožňuje různým uživatelům nebo aplikacím mít k dispozici vyhrazené výpočetní a paměťové zdroje. Výběr správného GPU je však jen částí rovnice - vaše podpůrná úložná a síťová infrastruktura musí být také schopna držet krok s jeho výkonem.

Požadavky na úložiště a síť

Pracovní zátěže spojené s umělou inteligencí často zahrnují správu obrovského množství dat, a proto jsou vysokorychlostní úložiště NVMe a sítě s nízkou latencí nezbytné. V podnikových prostředích jsou disky NVMe se silnými hodnotami odolnosti ideální pro zvládání náročných cyklů čtení a zápisu, které jsou s aplikacemi AI spojeny.

Pro výměnu dat mezi uzly poskytují technologie jako InfiniBand nebo pokročilá ethernetová řešení šířku pásma potřebnou pro hladký provoz. Použití distribuovaného souborového systému, který umožňuje paralelní I/O, může pomoci minimalizovat úzká místa, když k datům přistupuje více procesů současně. Jakmile jsou potřeby úložiště a sítě splněny, je dalším krokem doladění způsobu, jakým jsou zdroje sladěny.

Zarovnání zdrojů a optimalizace topologie

Chcete-li optimalizovat zarovnání prostředků, nakonfigurujte NUMA (Non-Uniform Memory Access), abyste zajistili přímé spojení mezi GPU, pamětí a CPU. Přiřaďte vysokorychlostní síťová rozhraní a vyhraďte linky PCIe, abyste snížili latenci. Mějte na paměti, že robustní chlazení a dostatečná kapacita napájení jsou rozhodující pro zamezení tepelného škrcení a udržení stability systému. Umístěním úložiště do blízkosti výpočetních jednotek lze navíc dále snížit latenci a vytvořit tak efektivnější a rychleji reagující systémovou architekturu.

Konfigurace virtuálního počítače a GPU

Po nastavení hardwaru je dalším krokem konfigurace virtuálních strojů (VM) a GPU, aby byl zajištěn optimální výkon AI. Správná konfigurace uvolní potenciál virtualizovaných GPU a zefektivní je pro pracovní zátěže AI. Pojďme se ponořit do toho, jak tyto prostředky efektivně konfigurovat a spravovat.

Plné propouštění GPU vs. rozdělení vGPU

Pokud jde o konfigurace GPU, existují dva hlavní přístupy: GPU passthrough a vGPU partitioning.

- GPU passthrough vyhrazuje celý GPU jednomu virtuálnímu počítači a poskytuje téměř nativní výkon pro náročné úlohy tréninku AI. Toto nastavení sice maximalizuje výkon, ale omezuje GPU na jeden virtuální počítač, což může být pro menší pracovní zátěže neefektivní.

- Naproti tomu rozdělení vGPU rozděluje GPU na více virtuálních plátků. Tento přístup je úspornější pro úlohy, které nevyžadují plný výkon GPU, jako jsou inferenční úlohy nebo menší tréninkové úlohy.

Moderní GPU, jako jsou NVIDIA A100 a H100, podporují technologii MIG (Multi-Instance GPU), která umožňuje až sedm izolovaných instancí GPU na jedné kartě. Tato funkce je ideální pro maximalizaci využití hardwaru při zachování nákladů.

Správná volba závisí na vašem případu použití:

- Pro rozsáhlá školení, jako je školení jazykových modelů nebo výzkum hlubokého učení, je obvykle lepší volbou GPU passthrough.

- Pro úlohy, jako je obsluha inferencí, vývoj nebo testování, nabízí vGPU partitioning lepší efektivitu zdrojů a úsporu nákladů.

Alokace prostředků pro maximální paralelismus

Efektivní alokace prostředků je zásadní pro zamezení vzniku úzkých míst a zajištění plynulých operací AI. Zde se dozvíte, jak vyvážit zdroje:

- Alokace CPU: Přiřazení konkrétních jader CPU každému virtuálnímu počítači, aby se minimalizovalo přepínání kontextu. Obvykle dobře funguje přidělení 4-8 jader CPU na GPU, ale toto číslo se může lišit v závislosti na frameworku AI a složitosti pracovní zátěže.

- Správa paměti: Naplánujte systémovou paměť RAM i paměť GPU. Pro většinu úloh AI přidělte alespoň 16-32 GB paměti RAM na GPU a zároveň vyhraďte dostatek paměti pro hypervizor. Použití obrovských stránek může také snížit režii paměti při datově náročných operacích.

- Paměť pro GPU: Při použití rozdělení vGPU pečlivě sledujte využití paměti GPU. Některé rámce, jako je PyTorch a TensorFlow, mohou dynamicky alokovat paměť GPU, ale nastavení limitů zajistí, že jedna pracovní zátěž nebude monopolizovat zdroje.

- Síťování: Povolte SR-IOV (Single Root I/O Virtualization) pro síťová rozhraní, aby virtuální počítače měly přímý přístup k hardwaru. Tím se sníží latence sítě, což je důležité zejména pro distribuované trénování umělé inteligence ve více uzlech.

Nástroje pro orchestraci GPU

Po přidělení prostředků mohou orchestrační nástroje zjednodušit správu GPU, zejména ve škálovaných prostředích AI.

- NVIDIA GPU Operator: Tento nástroj automatizuje úlohy, jako je instalace ovladačů GPU, nastavení běhu kontejnerů a monitorování stavu v rámci Kubernetes. Zajišťuje konzistentní konfigurace napříč clustery a snižuje manuální zátěž.

- Zásuvné moduly GPU pro Kubernetes: Zásuvné moduly, jako je například zásuvný modul zařízení NVIDIA, umožňují jemně vyladit plánování a přidělování GPU. Podporují frakční využití GPU a umožňují přesnou správu prostředků pro pracovní zátěže založené na systému Kubernetes.

- SLURM: Plánovač úloh určený pro vysoce výkonné výpočty (HPC) a pracovní zátěže umělé inteligence nabízí funkce, jako je povědomí o topologii GPU, plánování spravedlivého rozdělení a rezervace prostředků. Je obzvláště užitečný pro správu víceuživatelských a víceprojektových prostředí.

- Docker se sadou NVIDIA Container Toolkit: Toto nastavení umožňuje kontejnerům přistupovat ke grafickým procesorům při zachování izolace mezi pracovními úlohami. Bezproblémově se integruje s platformami pro orchestraci, což z něj činí flexibilní možnost pro nasazení aplikací AI.

S růstem infrastruktury AI se tyto orchestrační nástroje stávají nepostradatelnými. Automatizují správu prostředků, zlepšují jejich využití a poskytují inteligenci potřebnou k efektivnímu provozu více pracovních zátěží na sdíleném hardwaru.

Monitorování výkonu a plánování

Po nastavení hardwaru a konfigurací je dalším krokem k zajištění hladkého chodu věcí zaměřit se na monitorování a plánování. Tyto dva postupy jsou základem udržení špičkového výkonu UI ve virtualizovaných prostředích GPU. I ta nejlepší hardwarová konfigurace může být bez správného přehledu o využití prostředků a inteligentních strategií plánování nedostatečná. Profilování, plánování a průběžné monitorování zajišťují, že pracovní zátěž AI zůstane efektivní a výkonná.

Profilování pracovní zátěže AI

Profilování je jako měření tepu pracovních zátěží AI - pomáhá odhalit úzká místa a zajišťuje rozumné využívání zdrojů dříve, než dojde ke snížení výkonu. Cílem je pochopit, jak různé úlohy spotřebovávají prostředky GPU, paměť a výpočetní cykly.

NVIDIA Nsight Systems je nástroj pro profilování aplikací CUDA, který poskytuje podrobné informace o využití GPU, přenosu paměti a době provádění jádra. U frameworků pro hluboké učení mohou profilovací nástroje pomoci určit, zda je pracovní zátěž vázána na GPU, paměť nebo CPU, což je rozhodující pro jemné vyladění přidělování prostředků.

Nástroje pro konkrétní frameworky, jako je TensorFlow Profiler a PyTorch Profiler, jdou ještě hlouběji. TensorFlow Profiler rozděluje časy kroků a ukazuje, kolik času se stráví úlohami, jako je načítání dat, předzpracování a trénování. PyTorch Profiler zase nabízí podrobný pohled na využití paměti, což pomáhá odhalit úniky paměti nebo neefektivní operace s tenzory.

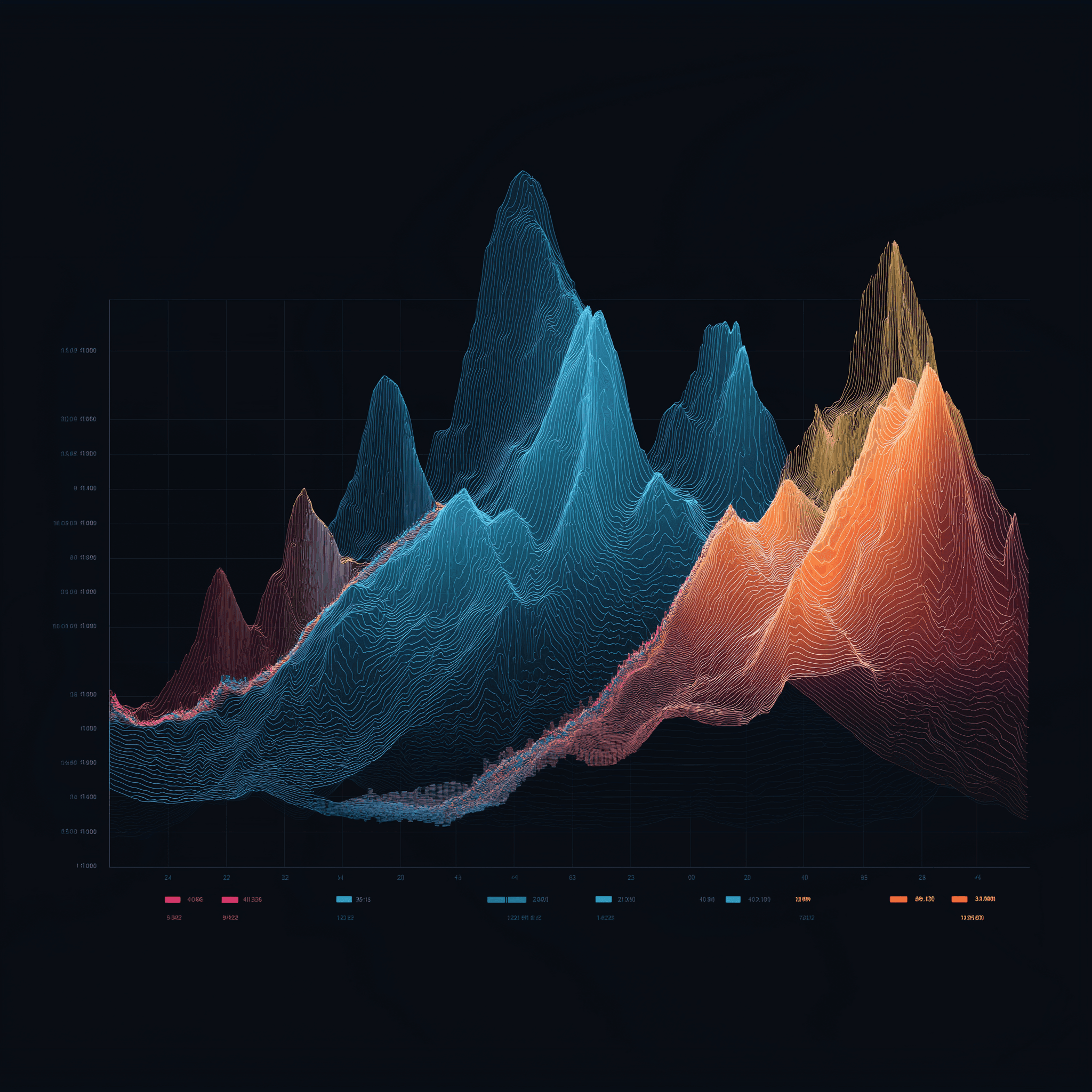

Při profilování je třeba sledovat tyto klíčové metriky:

- Využití GPU: Při trénování se snažte dosáhnout alespoň 80 %, abyste zajistili efektivní využití.

- Využití šířky pásma paměti: To ukazuje, jak dobře je využívána paměť GPU.

- Efektivita jádra: Ukazuje, jak efektivně jsou operace sladěny s architekturou GPU.

Ve virtualizovaných prostředích je profilování trochu složitější kvůli přidané vrstvě hypervizoru. Nástroje, jako jsou grafy výkonu vSphere nebo monitorování výkonu KVM, mohou tuto mezeru překlenout a korelovat metriky na úrovni virtuálního počítače s daty profilování na úrovni hostů. Tento dvouvrstvý přístup pomáhá určit, zda jsou zádrhele ve výkonu způsobeny virtualizační vrstvou nebo samotnou pracovní zátěží.

Poznatky získané z profilování se přímo promítají do chytřejších strategií plánování, které udržují zdroje efektivně přidělené.

Plánování pracovní zátěže s umělou inteligencí

Plánování je místem, kde dochází ke kouzlu - zajišťuje efektivní využití GPU při žonglování s více pracovními zátěžemi AI. Různé strategie vyhovují různým potřebám, od synchronizace distribuovaných úloh po upřednostňování kritických úloh.

- Skupinové plánování: Tato metoda je ideální pro synchronní trénink a zajišťuje, že všechny procesy v distribuovaném tréninku jsou sladěny, takže žádný pracovník nezůstane nečinný.

- Prediktivní plánování: Tento přístup na základě analýzy historických dat předpovídá dobu běhu úloh na základě faktorů, jako je velikost modelu a charakteristiky datové sady, a umožňuje tak inteligentnější rozvržení pracovní zátěže.

- Přednostní plánování úloh: Úlohy s vysokou prioritou mohou dočasně vyřadit úlohy s nižší prioritou. Plánovače sledující kontrolní body bezpečně pozastaví úlohy, uloží jejich stav a později je obnoví, jakmile se uvolní zdroje.

- Spravedlivé plánování: Sleduje historické využití a dynamicky upravuje priority tak, aby byly zdroje spravedlivě rozděleny mezi uživatele nebo projekty.

Zvolená metoda plánování může rozhodnout o efektivitě systému. Dávkové plánování například dobře funguje ve výzkumných sestavách s flexibilními termíny, zatímco plánování v reálném čase je nezbytné pro inferenční zátěže, které vyžadují nízkou latenci.

Jakmile je plánování zavedeno, průběžné monitorování zajistí, že vše zůstane na správné cestě.

Monitorování a srovnávání

Průběžné monitorování funguje jako systém včasného varování, který zachytí potenciální problémy dříve, než naruší produkci. Kombinace metrik v reálném čase s historickými daty pomáhá odhalit trendy a vzorce, které by jinak zůstaly nepovšimnuty.

Nástroje pro monitorování GPU by měly sledovat vše od vytížení a využití paměti až po teplotu a spotřebu energie. Data Center GPU Manager (DCGM ) od společnosti NVIDIA je robustní volbou, která se integruje s platformami, jako jsou Prometheus a Grafana, a poskytuje tak komplexní pohled. Tyto nástroje mohou pomoci odhalit problémy, jako je tepelné přiškrcení nebo tlak na paměť, které by mohly poškodit výkon.

Monitorování na úrovni aplikace se zaměřuje na specifické metriky AI, jako je ztráta při trénování, přesnost validace a míra konvergence. Nástroje jako MLflow a Weights & Biases kombinují tyto metriky s údaji o výkonu systému a nabízejí kompletní obraz o stavu pracovní zátěže.

Pro distribuované školení je monitorování sítě nutností. Je důležité sledovat využití šířky pásma, latenci a ztráty paketů mezi uzly. Vysokorychlostní propojení, jako je InfiniBand, vyžadují specializované nástroje pro zajištění hladké synchronizace gradientů a paralelního trénování dat.

Benchmarking pomáhá nastavit základní výkonnostní parametry a ověřit optimalizace. Srovnávací testyMLPerf jsou standardní volbou pro vyhodnocování trénování a odvozování v různých modelech a hardwarových nastaveních umělé inteligence. Provádění těchto testů ve virtualizovaném prostředí stanoví základní očekávání a upozorní na problémy s konfigurací.

Užitečné jsou také syntetické benchmarky, jako jsou ty v úložišti DeepLearningExamples společnosti NVIDIA. Simulují konkrétní scénáře, pomáhají izolovat režii virtualizace a potvrzují, že vaše prostředí funguje podle očekávání.

Pravidelné srovnávací testy - například jednou měsíčně - mohou odhalit problémy, jako jsou aktualizace ovladačů, odchylky konfigurace nebo zhoršení hardwaru, které by jinak zůstaly nepovšimnuty.

Servery FDC pro infrastrukturu umělé inteligence

Pro dosažení špičkového výkonu v systémech umělé inteligence je spolehlivá hostingová infrastruktura neoddiskutovatelná. Správný hostingový partner zajistí, že vaše strategie profilování, plánování a monitorování budou fungovat bez problémů, a poskytne tak páteř potřebnou k efektivní optimalizaci pracovních zátěží AI.

Právě tato stabilní infrastruktura umožňuje pokročilé nasazení technik profilování, plánování a orchestrace, o kterých jsme hovořili dříve.

GPU servery pro pracovní zátěže AI

FDC Servers nabízí GPU hosting přizpůsobený speciálně pro aplikace AI a strojového učení. Jejich GPU servery začínají na 1 124 dolarech měsíčně a jsou dodávány s neměřenou šířkou pásma, což je při práci s velkými datovými sadami nebo distribuovaným tréninkem nezbytností. Tato funkce odstraňuje obavy z limitů přenosu dat a pomáhá udržet předvídatelné náklady.

Jejich servery jsou vysoce přizpůsobitelné, což vám umožní vyladit hardwarové konfigurace pro modely AI s vysokou pamětí nebo specializované konfigurace GPU, jako jsou ty, které jsou potřebné pro úlohy počítačového vidění. Díky okamžitému nasazení můžete rychle rozšiřovat zdroje GPU, abyste vyhověli kolísajícím požadavkům.

Mezi klíčové funkce patří podpora GPU passthrough, vGPU partitioning a vlastní plánování, které jsou klíčové pro zvládání náročných úloh AI.

Neměřená šířka pásma a globální nasazení

Neměřená šířka pásma mění pravidla hry pro projekty AI s velkým objemem dat. Trénování velkých modelů často vyžaduje přesouvání terabajtů dat mezi úložnými systémy, výpočetními uzly a monitorovacími nástroji. Díky eliminaci limitů pro přenos dat udržují servery FDC Servers váš rozpočet předvídatelný a pracovní postupy nepřerušované.

Se 74 globálními lokalitami poskytuje FDC Servers geografický dosah potřebný pro moderní infrastrukturu AI. Tato globální síť umožňuje umístit výpočetní zdroje blíže ke zdrojům dat, čímž se snižuje latence v distribuovaných tréninkových sestavách. Pro inferenci lze modely nasadit v okrajových lokalitách, což zajistí rychlejší odezvu pro koncové uživatele.

Globální infrastruktura hraje také zásadní roli při obnově po havárii a redundanci. Pokud dojde k výpadku jedné lokality, lze pracovní zátěž plynule přesunout do jiného regionu, čímž je zajištěn plynulý provoz. Pro organizace, které spravují víceregionální potrubí umělé inteligence, zajišťuje konzistentní infrastruktura ve všech 74 lokalitách jednotnost nastavení virtualizace, monitorovacích nástrojů a strategií plánování - bez ohledu na to, kde jsou vaše zdroje nasazeny.

Společnost FDC Servers navíc nabízí nepřetržitou podporu pro řešení jakýchkoli problémů, ať už se týkají ovladačů GPU, konfliktů při virtualizaci nebo přidělování prostředků. To zajišťuje minimální prostoje, a to i ve složitých virtualizovaných prostředích GPU.

Tyto funkce dohromady poskytují silný základ pro dosažení optimalizovaného výkonu UI.

Závěr

Tento průvodce zdůrazňuje, jak kombinace pokročilého hardwaru, vyladěných zdrojů a solidní infrastruktury může výrazně zvýšit výkon AI.

Chcete-li z pracovních zátěží AI vytěžit maximum, slaďte hardware, přidělování prostředků a infrastrukturu se svými specifickými požadavky. Pro dosažení maximálního výkonu je ideální GPU passthrough, zatímco vGPU partitioning nabízí efektivní způsob sdílení zdrojů.

Součinnost mezi výběrem hardwaru a vyladěním zdrojů je klíčem k optimalizaci výkonu. Použití GPU s dostatečnou šířkou paměťového pásma, integrace úložiště NVMe a zajištění vysoké propustnosti sítě může přímo zvýšit efektivitu tréninku a výstup modelu. Jemné vyladění topologie systému snižuje zpoždění propojení, zatímco profilování a inteligentní plánování maximalizují využití GPU. Nástroje pro orchestraci dále zajišťují konzistentní výkon na vysoké úrovni.

Vše spojuje spolehlivý partner pro hosting. Pro organizace, které se snaží překonat problémy se zdroji, je spolehlivý hosting zásadní. FDC Servers nabízí GPU hosting za 1 124 USD/měsíc s neměřenou šířkou pásma - možnost, která eliminuje limity přenosu dat a nepředvídatelné náklady.

Díky funkcím, jako je geografická škálovatelnost, okamžité nasazení a nepřetržitá podpora, můžete operace s umělou inteligencí plynule škálovat. Ať už spravujete distribuované školení napříč regiony nebo nasazujete okrajové inferenční modely, spolehlivá infrastruktura odstraňuje mnoho technických překážek, které často zpomalují projekty AI.

Dosažení úspěchu v oblasti AI vyžaduje bezproblémovou kombinaci výkonu GPU, přesné správy zdrojů a spolehlivého hostingu. Dodržováním těchto strategií a využíváním infrastruktury FDC Servers můžete připravit půdu pro špičkový výkon AI.

Často kladené dotazy

Jak virtualizace GPU zefektivňuje pracovní zátěž AI a snižuje náklady?

Virtualizace GPU umožňuje více virtuálním strojům využívat jeden fyzický GPU, což zvyšuje efektivitu a zároveň snižuje náklady. Díky sdílení zdrojů odpadá potřeba dalšího hardwaru, lépe se využívá to, co je již k dispozici, a snižují se celkové náklady.

Toto nastavení také výrazně usnadňuje škálování a správu. Organizace mohou přijmout více pracovních zátěží AI, aniž by potřebovaly pro každý virtuální stroj samostatný GPU. Výsledek? Zefektivněný výkon a kontrolované náklady - ideální kombinace pro projekty AI a strojového učení.

Jaký je rozdíl mezi GPU passthrough a vGPU partitioning a kdy byste měli použít každý z nich?

Pokud jde o GPU passthrough, je celý GPU vyhrazen pro jeden virtuální stroj (VM) a nabízí výkon, který je téměř nerozeznatelný od výkonu na fyzickém hardwaru. To z něj činí vhodnou volbu pro náročné úlohy, jako je trénování modelů umělé inteligence, hluboké učení nebo 3D vykreslování, kde je nezbytné vyždímat každý gram výkonu.

Naproti tomu rozdělení vGPU rozděluje jeden GPU na více hardwarových segmentů, což umožňuje několika virtuálním počítačům nebo uživatelům sdílet stejný GPU současně. Toto nastavení se nejlépe osvědčuje ve sdílených prostředích, jako jsou virtuální desktopy nebo společné pracovní stanice, kde je prioritou vyvážení flexibility a efektivního využití zdrojů.

Jaké jsou nejlepší nástroje a strategie pro monitorování a optimalizaci pracovních zátěží AI ve virtualizovaných prostředích s GPU?

Aby bylo možné vytěžit maximum z pracovních zátěží AI ve virtualizovaných prostředích GPU, je nezbytné využívat nástroje pro monitorování GPU, které nabízejí data o využití zdrojů a výkonu v reálném čase. Například řešení pro správu vGPU od společnosti NVIDIA usnadňují sledování využití GPU a optimalizaci distribuce zdrojů.

Dalším klíčovým přístupem je využití orchestračních platforem, jako je Kubernetes. Tyto platformy mohou dynamicky upravovat pracovní zátěž a efektivněji rozdělovat zdroje, což vám pomůže dosáhnout lepšího výkonu GPU. Kromě toho hraje při udržování vysoké úrovně výkonu velkou roli pravidelné dolaďování hyperparametrů a zdokonalování datových pipeline. Průběžným sledováním metrik GPU můžete včas odhalit úzká místa a vyhnout se konfliktům zdrojů, čímž zajistíte hladký průběh úloh AI.

Jak nainstalovat a používat Redis na VPS

Přečtěte si, jak nainstalovat a nakonfigurovat Redis na VPS pro optimální výkon, zabezpečení a správu ve vašich aplikacích.

9 min čtení - 7. ledna 2026

Monitorování dedikovaného serveru nebo VPS, jaké jsou možnosti v roce 2025?

12 min čtení - 28. listopadu 2025

Máte dotazy nebo potřebujete vlastní řešení?

Flexibilní možnosti

Globální dosah

Okamžité nasazení

Flexibilní možnosti

Globální dosah

Okamžité nasazení