Hur man identifierar flaskhalsar vid skalning av servrar

8 min läsning - 22 september 2025

Lär dig hur du identifierar och åtgärdar flaskhalsar i prestandan vid serverskalning för att förbättra användarupplevelsen och optimera resursanvändningen.

Hur man identifierar flaskhalsar vid skalning av servrar

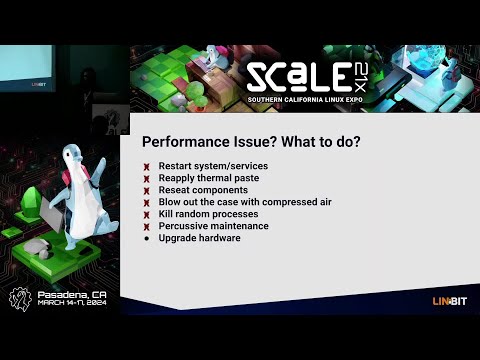

Att skala servrar handlar inte bara om att lägga till resurser - det handlar också om att hitta och åtgärda flaskhalsar som begränsar prestandan. Dessa flaskhalsar kan orsaka fördröjningar, krascher och dåliga användarupplevelser, även med uppgraderad hårdvara. För att ta itu med detta bör du fokusera på:

- Baslinjemätningar: Mät CPU-användning, minne, disk-I/O, nätverksgenomströmning och svarstider under normala förhållanden.

- Övervakningsverktyg: Använd plattformar som New Relic, Grafana och JMeter för att spåra prestanda och simulera trafik.

- Testning: Utför belastnings- och stresstester för att identifiera brytpunkter.

- Analys: Undersök loggar, resursanvändning och databasprestanda för att hitta ineffektivitet.

- Korrigeringar: Optimera kod, uppgradera hårdvara (t.ex. SSD-enheter) och implementera horisontell skalning vid behov.

Diagnostisering av flaskhalsar i produktionssystem

Upprätta baslinjer för prestanda

Att ha baslinjedata är avgörande för att identifiera om förändringar i serverprestanda är rutinmässiga fluktuationer eller faktiska flaskhalsar. Baslinjerna utgör en referenspunkt som gör det lättare att upptäcka avvikelser från typiskt serverbeteende.

För att skapa korrekta baslinjer bör du samla in prestandadata som återspeglar normala dagliga och veckovisa trafikmönster.

Viktiga mätvärden att spåra

Att spåra rätt mätvärden är viktigt för att identifiera prestandaproblem tidigt.

- CPU-användning: Detta visar hur mycket processorkraft din server använder i varje ögonblick. Även om acceptabla intervall beror på din specifika installation kan övervakning av CPU-användningen avslöja när ditt system antingen är överbelastat eller underutnyttjat.

- Minnesanvändning: Detta spårar mängden RAM-minne som dina applikationer förbrukar. Långvarig hög minnesanvändning kan tvinga systemet att förlita sig på långsammare diskbaserat swaputrymme, vilket avsevärt sänker prestandan.

- Disk I/O-mätvärden: Dessa mäter hur effektivt din lagring läser och skriver data. Viktiga mått är bland annat IOPS (Input/Output Operations Per Second) och disklatens. Till exempel uppnår traditionella hårddiskar vanligtvis 100-200 IOPS med 10-15 millisekunders latens, medan NVMe SSD-enheter kan leverera mycket högre IOPS med latens på under en millisekund.

- Genomströmning i nätverk: Detta mäter dataöverföringshastigheter i Mbps eller Gbps. Det är viktigt att övervaka både inkommande och utgående bandbredd samt paketförlust. Paketförluster på över 0,1% tyder ofta på överbelastning i nätverket eller hårdvaruproblem.

- Svarstider: Svarstiderna speglar hur snabbt dina applikationer hanterar förfrågningar. För webbapplikationer är svarstider inom några hundra millisekunder idealiska. Forskning från Google visar att mobilsidor som tar tre sekunder eller mer att ladda överges av 53% av besökarna.

- Applikationsspecifika mätvärden: Dessa varierar beroende på din programvarustack men kan inkludera databasfrågetider, cache-träfffrekvens eller antal aktiva anslutningar. Till exempel är snabba databasfrågor och hög träfffrekvens i cacheminnet avgörande för att upprätthålla en stark övergripande prestanda.

Regelbunden övervakning av dessa mätvärden säkerställer att du kan ta itu med prestandaproblem innan skalning blir nödvändig.

Benchmarking och registrering av data

För att skapa tillförlitliga baslinjer bör du köra dina servrar under normal produktionsbelastning i minst två veckor. Spela in data med regelbundna intervall - var 5-10:e minut är en bra balans mellan detaljrikedom och lagringseffektivitet.

Benchmarking avtoppbelastningar är också viktigt. Mät hur systemet presterar under de mest belastade perioderna för att förutse framtida skalningsbehov.

När du dokumenterar baslinjedata ska du inkludera tidsstämplar, mätvärden och relevanta sammanhang. Denna detaljerade dokumentation hjälper dig att jämföra prestanda före och efter skalningsinsatser.

Mätningar av drifttid är en annan kritisk komponent. Ett exempel:

- 99 % drifttid motsvarar ungefär 7 timmars driftstopp per månad.

- Med 99,9 % drifttid minskar driftstoppet till cirka 45 minuter per månad.

- Guldstandarden, 99,999% drifttid (fem nio), tillåter bara 30 sekunder av driftstopp per månad.

Du kan också överväga att använda Apdex-scoring för att mäta användarnas tillfredsställelse med svarstiderna. Poängen sträcker sig från 0 (dålig) till 1 (utmärkt) genom att svarstiderna kategoriseras i zonerna nöjd, tolerant och frustrerad. En poäng över 0,85 indikerar i allmänhet en positiv användarupplevelse.

Lagra dina baslinjedata i ett centraliserat system för enkel åtkomst och jämförelse. Tidsseriedatabaser eller övervakningsplattformar används ofta för att lagra historiska data, vilket gör det enklare att avgöra om prestandaförändringar beror på skalning eller underliggande systemproblem.

Med dessa baslinjer på plats är du redo att gå vidare till verktyg och tekniker för prestandaövervakning i realtid.

Verktyg för övervakning och analys

Rätt övervakningsverktyg kan omvandla rådata till användbara insikter och hjälpa dig att upptäcka flaskhalsar innan de stör användarupplevelsen. Med en mängd olika funktioner som realtidsvarningar och djupgående prestandaanalys blir det viktigt att välja rätt verktyg för att identifiera och lösa problem på ett effektivt sätt.

Centrala övervakningsverktyg

APM-plattformar (Application Performance Monitoring) som New Relic är oumbärliga för att spåra applikationsmätvärden och användarupplevelser. Dessa verktyg samlar automatiskt in nyckeldata som svarstider, felfrekvenser och transaktionsspår. Funktioner som distribuerad spårning gör det lättare att lokalisera långsamma databasfrågor eller tröga API-anrop.

Grafana är ett mångsidigt visualiseringsverktyg som integreras med flera datakällor. När Grafana paras ihop med tidsseriedatabaser som Prometheus eller InfluxDB utmärker sig Grafana för att skapa instrumentpaneler som länkar mätvärden - till exempel korrelerar CPU-toppar med långsammare svarstider - vilket gör det lättare att upptäcka prestandaproblem med en blick.

Apache JMeter är ett lasttestverktyg som aktivt simulerar användartrafik för att mäta hur system hanterar samtidiga användare. Genom att generera trafik och testa serverns genomströmning under olika förhållanden hjälper JMeter till att identifiera brytpunkter och resursbegränsningar innan de påverkar produktionsmiljöer.

ELK Stack (Elasticsearch, Logstash och Kibana ) fokuserar på logganalys och sökfunktioner. Logstash samlar in och bearbetar loggdata, Elasticsearch gör dem sökbara och Kibana visualiserar resultaten. Den här kombinationen är idealisk för att identifiera felmönster, spåra händelsefrekvenser och koppla loggar till prestandaförluster.

Övervakningsverktyg på systemnivå som Nagios, Zabbix och Datadog ger en fågelperspektivvy av infrastrukturmätvärden. Dessa plattformar övervakar kritiska hårdvarudata som CPU-användning, minnesförbrukning, disk-I/O och nätverkstrafik, vilket gör dem viktiga för att upptäcka hårdvarurelaterade flaskhalsar och planera kapacitetsuppgraderingar.

Databasövervakningsverktyg som pgAdmin för PostgreSQL eller MySQL Enterprise Monitor erbjuder specialiserade insikter i databasprestanda. Dessa verktyg spårar mätvärden som frågekörningstider, låskonflikter och buffertpoolanvändning - detaljer som allmänna övervakare kan förbise men som är avgörande för att optimera databasens prestanda.

Varje typ av verktyg har ett unikt syfte: APM-verktyg fokuserar på applikationsprestanda, systemövervakare hanterar hårdvarumätvärden och databasverktyg specialiserar sig på lagrings- och frågeanalys. Många organisationer använder en blandning av dessa verktyg för att täcka hela sin tekniska stack, vilket säkerställer både omedelbar problemlösning och långsiktig prestandaoptimering.

Realtid kontra historiska data

Realtidsövervakning ger omedelbar insyn i systemets prestanda, vilket gör att teamen kan reagera snabbt på nya problem. Instrumentpaneler uppdateras med några sekunders mellanrum och visar mätvärden i realtid som CPU-användning, aktiva anslutningar och svarstider. Detta är avgörande för att fånga upp plötsliga trafikökningar, minnesläckor eller felande komponenter innan de utvecklas till större problem.

Realtidsvarningar utlöses när mätvärdena överskrider fördefinierade tröskelvärden - t.ex. om CPU-användningen överstiger 80 % eller svarstiderna överstiger 2 sekunder. Dessa varningar gör det möjligt för team att ta itu med problem inom några minuter, vilket minimerar driftstopp.

Historisk dataanalys å andra sidan avslöjar långsiktiga trender och återkommande mönster som realtidsövervakning kan missa. Genom att undersöka data över veckor eller månader kan teamen identifiera säsongsmässiga trafikfluktuationer, gradvisa prestandaförluster eller återkommande flaskhalsar. Till exempel kan en 15% ökning av databasfrågetiderna under tre månader signalera växande datavolymer eller ineffektiva frågor som behöver optimeras.

Historisk analys stöder också kapacitetsplaneringen. Trender som ökande minnesanvändning eller eskalerande trafikvolymer hjälper till att förutse när resurserna når sina gränser, vilket möjliggör proaktiv skalning eller uppgraderingar.

Genomatt kombinera båda metoderna skapas en väl avrundad övervakningsstrategi. Realtidsdata ger omedelbar feedback för krishantering, medan historisk analys ger underlag för strategiska beslut för att förhindra framtida problem. Många moderna verktyg integrerar sömlöst båda dessa metoder och erbjuder instrumentpaneler i realtid parallellt med lagring av historiska data, så att teamen enkelt kan växla mellan kortsiktig felsökning och långsiktig planering.

De bästa resultaten uppnås när teamen rutinmässigt granskar realtidsvarningar för att ta itu med omedelbara problem och analyserar historiska trender för smartare skalnings- och optimeringsbeslut. Detta dubbla tillvägagångssätt säkerställer att systemen förblir effektiva och motståndskraftiga över tid.

Så här hittar du flaskhalsar steg för steg

När du har fastställt baslinjemätvärden och konfigurerat övervakningsverktyg är nästa steg att leta efter flaskhalsar. Detta innebär att du systematiskt testar, övervakar och analyserar ditt system under belastning för att identifiera var prestandaproblem uppstår.

Belastnings- och stresstestning

Belastningstester hjälper dig att utvärdera hur ditt system presterar under typiska användarbehov. Börja med att definiera dina prestandamål, t.ex. acceptabla svarstider, genomströmningsmål och tröskelvärden för felfrekvens. Dessa mål fungerar som riktmärken för att upptäcka avvikelser. Verktyg som JMeter eller Gatling kan simulera trafik och gradvis öka belastningen tills prestandan börjar försämras.

Stresstester, å andra sidan, pressar systemet bortom dess normala gränser för att avslöja brytpunkter. Under båda testerna bör du hålla ett öga på mätvärden som CPU-användning, minnesförbrukning och nätverksbandbredd. Till exempel korrelerar CPU-användning som närmar sig 100%, minnestoppar eller maxad bandbredd ofta med långsammare svarstider eller högre felfrekvenser.

Real User Monitoring (RUM) kan komplettera dessa syntetiska tester genom att tillhandahålla data om faktiska användarupplevelser. Detta kan avslöja flaskhalsar som kontrollerade tester kanske missar.

Nästa steg är att analysera resursanvändningen för att hitta grundorsakerna till prestandaproblemen.

Analys av resurser

Jämför resursanvändningsdata med dina baslinjemätvärden för att upptäcka dolda begränsningar. Här är vad du ska leta efter:

- CPU: Flaskhalsar uppstår ofta när användningen konsekvent överstiger 80% eller oväntat ökar.

- Minne: Hög eller oregelbunden användning kan tyda på minnesläckor eller ineffektivitet.

- Disk I/O: Övervaka hög användning eller långa väntetider, vilket kan sakta ned driften.

- Nätverk: Kontrollera bandbreddsanvändning och latens för att identifiera långsamma API-svar eller timeouts.

- Databasprestanda: Använd verktyg som MySQL Workbench eller SQL Profiler för att analysera exekveringstider för frågor, indexering och transaktionslåsning. Frågor som tar längre tid än 100 millisekunder kan tyda på ineffektiva operationer, t.ex. bearbetning rad för rad (RBAR), som behöver optimeras.

Analys av loggar och spårning

Loggar och spår ger viktiga insikter när de kombineras med baslinje- och realtidsmätvärden. Loggar kan belysa återkommande fel, timeouts eller resursvarningar som signalerar flaskhalsar. Till exempel pekar timeout-meddelanden eller fel relaterade till resursbegränsningar ofta direkt på problemområden.

Distribuerade spårningsverktyg som OpenTelemetry med Jaeger gör att du kan spåra en förfrågnings resa över mikrotjänster och avslöja förseningar som orsakas av långsamma databasfrågor, API-timeouts eller problematiska tjänsteberoenden. Detaljerad instrumentering, till exempel loggning av start- och sluttider för operationer, kan hjälpa till att identifiera kodavsnitt som förbrukar överdrivna resurser. På samma sätt kan loggar över databasförfrågningar avslöja ineffektivitet som RBAR-operationer.

Trådtvister är ett annat område som är värt att undersöka. Genom att analysera tråddumpar kan man upptäcka dödlås, trådsvält eller överdriven kontextväxling, som alla kan dra ner prestandan. Att fånga ögonblicksbilder av stackspår under prestandatoppar kan ytterligare fastställa de exakta kodvägarna som orsakar förseningar.

Mellan mars och november 2020 ökade användningen av Miro sjufaldigt och nådde över 600 000 unika användare per dag. För att hantera serverflaskhalsar under denna snabba skalning fokuserade Miros systemteam på att övervaka mediantiden för slutförande av uppgifter (percentil) snarare än medelvärden eller köstorlekar. Detta tillvägagångssätt hjälpte dem att optimera processer som påverkade majoriteten av användarna.

Vanliga källor till flaskhalsar och deras effekter

Att förstå flaskhalsar är avgörande för att kunna rikta övervakningsinsatserna och snabba upp svarstiderna. Olika flaskhalsar lämnar distinkta spår, vilket kan hjälpa dig att lokalisera och lösa problem på ett effektivt sätt.

Här följer en sammanställning av de vanligaste flaskhalskällorna, deras varningssignaler, detekteringsmetoder och hur de begränsar skalbarheten:

Dyk djupare in i flaskhalsar

CPU-flaskhalsar uppstår oftast under trafikökningar. När CPU-användningen överstiger 80% börjar systemet ställa förfrågningar i kö, vilket leder till förseningar och timeouts. Vid den här tidpunkten blir horisontell skalning ofta den enda hållbara lösningen.

Minnesproblem tenderar att vara tysta tills RAM-användningen närmar sig kritiska nivåer. När det händer kan applikationer krascha eller bli betydligt långsammare på grund av överbelastning av skräpinsamlingen, vilket tvingar fram dyra uppgraderingar eller optimeringsinsatser.

Flaskhalsar i databaser är en vanlig utmaning vid skalning av webbapplikationer. Symptom som timeouts för frågor och uttömda anslutningspooler kan försämra prestandan, vilket ofta kräver databaskluster eller tillägg av läsrepliker för att fördela belastningen.

Nätverksbegränsningar dyker vanligtvis upp när man hanterar stora filer eller frekventa API-anrop. Hög latens eller paketförlust, särskilt mellan olika regioner, signalerar ofta behovet av CDN (Content Delivery Network) eller andra distributionsstrategier.

Flaskhalsar i lagringsutrymmet uppstår när databehovet ökar. Traditionella hårddiskar med begränsad IOPS kan sakta ner filoperationer och databasskrivningar, vilket gör SSD-enheter eller distribuerade lagringsarkitekturer avgörande för att upprätthålla prestanda.

Flaskhalsar i applikationskoden är unika eftersom de beror på ineffektivitet i design eller implementering, till exempel minnesläckor eller dåliga cachningsstrategier. För att åtgärda dessa problem krävs ofta djupgående profilering, refaktorisering eller till och med omarbetning av arkitekturen för att hantera skalningskrav.

Åtgärda flaskhalsar för bättre skalbarhet

Flaskhalsar i hårdvaran, som CPU och minne, kan ibland hanteras med vertikal skalning, men det finns gränser för detta tillvägagångssätt. Så småningom blir horisontell skalning oundviklig. Å andra sidan kräver flaskhalsar i databas- och applikationskod vanligtvis optimeringsarbete innan ytterligare resurser kan vara fullt effektiva.

Åtgärda flaskhalsar för bättre skalning

När flaskhalsarna har identifierats är nästa steg att ta itu med dem på ett effektivt sätt. Målet är att ta itu med grundorsakerna snarare än bara symptomen, vilket säkerställer att din infrastruktur kan hantera framtida tillväxt utan att stöta på samma problem.

Åtgärda identifierade flaskhalsar

Flaskhalsar i processorn: Om CPU-användningen regelbundet överstiger 80 % är det dags att agera. Börja med att optimera din kod - effektivisera ineffektiva algoritmer och minska resurskrävande operationer. Även om en uppgradering av hårdvaran (vertikal skalning) kan ge omedelbar lindring är det bara en tillfällig lösning. För långsiktig skalbarhet bör du implementera lastbalansering och horisontell skalning för att fördela arbetsbelastningen över flera servrar, eftersom en enda server så småningom kommer att nå sina gränser.

Problem med minnet: Använd profileringsverktyg för att upptäcka minnesläckor och optimera hur din applikation allokerar minne. Att uppgradera RAM-minnet är en bra kortsiktig lösning, men för bättre skalbarhet bör du överväga att utforma statslösa applikationer. Dessa fördelar minnesbelastningen över flera instanser, vilket gör ditt system mer motståndskraftigt.

Flaskhalsar i databasen: Långsamma frågor är ofta boven i dramat. Optimera dem och lägg till lämpliga index för att påskynda saker och ting. Andra strategier är att använda anslutningspoolning, sätta upp läsrepliker för att fördela frågebelastningar och dela upp databaser för skrivtunga applikationer. Att uppgradera till NVMe SSD-enheter kan också ge en betydande prestandaökning.

Begränsningar i nätverket: Om ditt nätverk har problem kan du överväga att uppgradera bandbredden och använda CDN:er för att minska det avstånd som data behöver färdas. Komprimera svar och minimera storleken på nyttolasten för att göra dataöverföringen mer effektiv. För globala målgrupper kan servrar på flera geografiska platser bidra till att minska latensen.

Flaskhalsar i lagringsutrymmet: Byt ut traditionella hårddiskar mot SSD-enheter för att hantera högre IOPS (input/output-operationer per sekund). För effektivare lagringshantering kan du använda distribuerade lagringssystem och separera arbetsbelastningar - till exempel högpresterande lagring för databaser och standardlagring för säkerhetskopior.

Dessa strategier fungerar bäst när de kombineras med en hostingmiljö som stöder skalbarhet.

Använda skalbara hostinglösningar

En modern hostinginfrastruktur är en viktig komponent för att lösa och förebygga flaskhalsar. FDC Servers erbjuder hostingalternativ som är skräddarsydda för skalbarhetsutmaningar, till exempel dedikerade servrar utan mätning som eliminerar bandbreddsbegränsningar och VPS-lösningar som drivs av EPYC-processorer med NVMe-lagring för topprestanda.

Deras dedikerade serverplaner, som börjar på 129 USD/månad, är mycket anpassningsbara. Med root-åtkomst och möjlighet att modifiera hårdvara kan du ta itu med prestandaproblem utan att vara låst till rigida hostingplaner. Dessutom garanterar obegränsad bandbredd att flaskhalsar i nätverket inte gör dig långsammare.

För arbetsbelastningar som kräver avancerad processorkraft ger GPU-servrar (från 1 124 USD/månad) de resurser som behövs för AI, maskininlärning och andra intensiva applikationer. Dessa servrar levereras också med obegränsad bandbredd och anpassningsbara konfigurationer för att uppfylla specifika krav.

För att hantera nätverksfördröjning är global distribution nyckeln. FDC Servers har verksamhet på över 70 platser över hela världen, vilket gör att du kan distribuera servrar närmare dina användare för snabbare svarstider. Deras CDN-tjänster förbättrar innehållsleveransen ytterligare med optimerade globala närvaropunkter.

Behöver du resurser snabbt? Med deras funktion för omedelbar drift sättning kan du skala upp snabbt och undvika förseningar i hårdvaruförsörjningen. Detta är särskilt användbart för att hantera plötsliga trafikökningar eller lösa prestandaproblem med kort varsel.

Genom att använda dessa hostinglösningar kan du avsevärt förbättra din förmåga att övervinna flaskhalsar och förbereda dig för framtida tillväxt.

Löpande övervakning och granskning

Kontinuerlig övervakning är avgörande för att säkerställa att dina lösningar förblir effektiva över tid. Ställ in automatiska varningar för viktiga mätvärden, t.ex. CPU-användning som överstiger 75 %, minnesanvändning som överstiger 85 % eller svarstider som överskrider acceptabla tröskelvärden.

Schemalägg månatliga prestandagranskningar för att spåra trender och upptäcka nya problem. Håll ett öga på tillväxtmått och förutse när dina nuvarande resurser kan komma att bli otillräckliga. Genom att planera uppgraderingar proaktivt kan du undvika kostsamma nödlösningar som stör användarupplevelsen.

Regelbundna belastningstester är ett annat viktigt steg. Testa systemet under förväntade belastningstoppar och simulera plötsliga trafiktoppar för att säkerställa att dina lösningar kan hantera verkliga förhållanden. Gradvisa belastningsökningar och stresstester kan avslöja dolda sårbarheter innan de blir problem.

Dokumentera slutligen varje flaskhalsincident och dess lösning. Detta skapar en värdefull kunskapsbas för ditt team, vilket gör det lättare att hantera liknande problem i framtiden. Genom att spåra hur effektiva dina lösningar är kan du också förfina dina strategier över tid och se till att din infrastruktur förblir robust i takt med att dina behov utvecklas.

Slutsats

För att hantera skalningsutmaningar på ett effektivt sätt bör du börja med att fastställa tydliga baslinjer och övervaka ditt system konsekvent. Börja med att mäta viktiga mätvärden som CPU-användning, minne, disk-I/O och nätverksgenomströmning för att förstå systemets typiska prestanda. Dessa riktmärken hjälper dig att hitta avvikelser när de uppstår.

Utnyttja instrumentpaneler i realtid och historiska data för att upptäcka och lösa problem innan de stör användarupplevelsen. Verktyg som belastningstestning och logganalys är ovärderliga för att bedöma prestanda under stress och identifiera svaga punkter i din infrastruktur. Vanliga flaskhalsar som CPU-överbelastning, minnesläckor, databashastighet, överbelastning i nätverket och lagringsbegränsningar kräver specifika, riktade lösningar.

Att åtgärda flaskhalsar räcker dock inte på egen hand. Det som verkligen förändrar spelplanen är proaktiv övervakning och skalbar infrastruktur. Ett system som är utformat för att anpassa sig till ökande efterfrågan säkerställer långsiktig tillförlitlighet och förhindrar återkommande problem. Moderna hostingalternativ, som FDC Servers, erbjuder skalbara lösningar med snabb driftsättning och ett globalt nätverk som sträcker sig över 70+ platser. Denna flexibilitet gör att du snabbt kan åtgärda prestandaproblem utan att behöva vänta på ny hårdvara.

Hemligheten bakom en framgångsrik skalning är att vara vaksam. Ställ in automatiska varningar, utför regelbundna prestandakontroller och för detaljerade register över tidigare flaskhalsar för framtida referens. Kom ihåg att skalning inte är en engångsuppgift - det är en pågående process som utvecklas tillsammans med din infrastruktur och dina användares behov. Med rätt kombination av övervakning, verktyg och skalbara hostinglösningar kan du bygga ett system som inte bara uppfyller dagens krav utan också är redo för morgondagens tillväxt.

Vanliga frågor

Vilka är de bästa sätten att lösa flaskhalsar i databaser vid skalning av servrar?

För att hantera databasflaskhalsar vid skalning av servrar kan du börja med att sprida trafiken jämnare. Detta kan göras med verktyg som lastbalanserare eller cachningslager, som hjälper till att lätta på trycket på din databas. Håll ett öga på viktiga mätvärden med hjälp av övervakningsverktyg - spåra saker som svarstider, felfrekvenser, CPU-användning, minne, disk-I/O och nätverksaktivitet för att identifiera problem innan de eskalerar.

Om du har problem med lagring och prestanda kan du överväga skalningslösningar som vertikal skalning (uppgradering av maskinvaran), horisontell skalning (fler servrar) eller databasdelning. Du kan också förbättra effektiviteten genom att optimera databasfrågor och säkerställa korrekt indexering. Genom att vara proaktiv med övervakning och finjustering kan du se till att ditt system fungerar smidigt när dina servrar växer.

Hur vet jag om prestandaproblemen på min server beror på hårdvarubegränsningar eller ineffektiv applikationskod?

För att ta reda på om serverns tröga prestanda beror på hårdvarubegränsningar eller dåligt optimerad applikationskod, börja med att hålla ett öga på viktiga systemmätvärden som CPU-användning, minnesförbrukning, disk-I/O och nätverksaktivitet. Om dessa mätvärden konsekvent är maximerade är det ett starkt tecken på att din hårdvara kanske kämpar för att hålla jämna steg. Men om hårdvarumätvärdena verkar bra men applikationerna fortfarande släpar efter kan problemet ligga begravet i koden.

Verktyg för prestandaövervakning och serverloggar är dina bästa resurser för att gräva djupare. Leta efter ledtrådar som långsamma databasfrågor, ineffektiva loopar eller processer som tar resurser i anspråk. Rutinmässiga tester och tuning är avgörande för att säkerställa att din server kan hantera tillväxt och fungera smidigt när kraven ökar.

Vilka är fördelarna med övervakningsverktyg i realtid jämfört med att använda historiska data för att hantera serverns skalbarhet?

Övervakningsverktyg i realtid förändrar spelplanen när det gäller att hålla systemen igång smidigt. De levererar omedelbara varningar och handlingsbara insikter, vilket hjälper dig att hantera problem när de uppstår. Den här typen av omedelbar feedback är nyckeln till att undvika prestandahicka under serverskalning. Dessutom säkerställer det att dina resurser allokeras effektivt, vilket är avgörande för att hantera ständigt föränderliga arbetsbelastningar.

Samtidigt är analys av historiska data utmärkt när det gäller att upptäcka långsiktiga trender eller ta reda på grundorsakerna till tidigare problem. Men det finns en hake - om du bara förlitar dig på historiska data kan du missa chansen att agera snabbt på aktuella problem. Den förseningen kan leda till driftstopp eller flaskhalsar i prestandan. Båda metoderna har sin plats, men realtidsövervakning är oumbärlig för att göra snabba justeringar och se till att servrarna presterar på topp i miljöer med högt tempo.

Så här installerar och använder du Redis på en VPS

Lär dig hur du installerar och konfigurerar Redis på en VPS för optimal prestanda, säkerhet och hantering i dina applikationer.

9 min läsning - 7 januari 2026

Övervakning av din dedikerade server eller VPS, vilka är alternativen 2025?

12 min läsning - 28 november 2025

Har du frågor eller behöver du en anpassad lösning?

Flexibla alternativ

Global räckvidd

Omedelbar driftsättning

Flexibla alternativ

Global räckvidd

Omedelbar driftsättning