Рабочие нагрузки ИИ в виртуализированных средах на GPU: Руководство по оптимизации

11 мин чтения - 10 октября 2025 г.

- Рабочие нагрузки ИИ в виртуализированных средах на GPU: Руководство по оптимизации

- Основы виртуализации GPU для ИИ

- Инфраструктура AI/ML: GPU с временной нарезкой - объяснение

- Требования к аппаратному обеспечению и инфраструктуре

- Конфигурация виртуальной машины и графического процессора

- Мониторинг производительности и планирование

- Серверы FDC для инфраструктуры искусственного интеллекта

- Заключение

- Вопросы и ответы

Узнайте, как виртуализация GPU повышает эффективность рабочих нагрузок ИИ за счет повышения эффективности, снижения затрат и оптимизации управления ресурсами в виртуализированных средах.

- Рабочие нагрузки ИИ в виртуализированных средах на GPU: Руководство по оптимизации

- Основы виртуализации GPU для ИИ

- Инфраструктура AI/ML: GPU с временной нарезкой - объяснение

- Требования к аппаратному обеспечению и инфраструктуре

- Конфигурация виртуальной машины и графического процессора

- Мониторинг производительности и планирование

- Серверы FDC для инфраструктуры искусственного интеллекта

- Заключение

- Вопросы и ответы

Рабочие нагрузки ИИ в виртуализированных средах на GPU: Руководство по оптимизации

Виртуализация GPU меняет способы управления рабочими нагрузками ИИ. Разделив физический GPU на несколько виртуальных экземпляров, вы можете выполнять несколько задач ИИ одновременно, повышая эффективность и снижая затраты на оборудование. Такой подход особенно ценен для обучения сложных моделей, решения ресурсоемких задач и масштабирования проектов ИИ без инвестиций в дополнительные GPU.

Вот почему это важно:

- Эффективное использование GPU: Избегайте простоя оборудования, распределяя ресурсы между задачами и командами.

- Экономия средств: Высокопроизводительные графические процессоры стоят дорого; виртуализация обеспечивает их максимальное использование.

- Гибкость: Настраивайте виртуальные экземпляры GPU под конкретные нужды, например объем памяти или версии CUDA.

- Масштабируемость: Динамическая настройка ресурсов по мере роста рабочих нагрузок ИИ.

- Надежность: Изолированные экземпляры не позволяют одной задаче влиять на другие.

Для оптимизации производительности:

- Выбирайте GPU с большим объемом памяти и пропускной способностью (например, NVIDIA A100/H100).

- Используйте NVMe-накопители и сети с низкой задержкой при обработке данных.

- Настройте виртуальные машины с GPU passthrough или vGPU partitioning в зависимости от потребностей рабочей нагрузки.

- Используйте такие инструменты, как NVIDIA GPU Operator, плагины Kubernetes и SLURM для оркестровки.

- Мониторинг производительности с помощью таких инструментов, как NVIDIA Nsight Systems и DCGM, для выявления узких мест.

Хостинг-сервисы, такие как FDC Servers, предоставляют индивидуальные GPU-решения по цене от 1 124 долларов в месяц, включая нерегулируемую полосу пропускания и глобальные возможности развертывания для масштабных AI-проектов.

Выводы: Виртуализация GPU упрощает управление ресурсами, повышает производительность и снижает затраты на рабочие нагрузки ИИ, что делает ее практичным решением для эффективного масштабирования операций ИИ.

Основы виртуализации GPU для ИИ

Что такое виртуализация GPU?

Виртуализация GPU позволяет нескольким пользователям совместно использовать один GPU, создавая виртуальные экземпляры, каждый из которых обладает собственной выделенной памятью, ядрами и вычислительной мощностью. Это означает, что один GPU может одновременно обслуживать несколько задач или пользователей, что делает его эффективным решением для рабочих нагрузок ИИ.

В основе этой технологии лежит гипервизор, который выступает в роли менеджера, распределяющего ресурсы GPU между виртуальными машинами. Гипервизор гарантирует, что каждый экземпляр получит свою долю без вмешательства других. Для задач ИИ это позволяет одному графическому процессору NVIDIA A100 или H100 одновременно выполнять несколько экспериментов по машинному обучению, сеансов обучения или операций вывода.

Существует два основных метода разделения этих ресурсов:

- Виртуализация на аппаратном уровне: Технология NVIDIA Multi-Instance GPU (MIG) физически разделяет GPU на изолированные секции, обеспечивая сильное разделение между экземплярами.

- Виртуализация на программном уровне: Этот метод использует драйверы и программное обеспечение для разделения ресурсов GPU, обеспечивая большую гибкость, но немного меньшую изоляцию.

Одно из ключевых различий между виртуализацией GPU и традиционной виртуализацией CPU заключается в управлении памятью. В GPU используется память с высокой пропускной способностью (HBM), которая работает иначе, чем стандартная системная оперативная память. Эффективное управление этой памятью очень важно, особенно при выполнении ресурсоемких операций ИИ, таких как тонкая настройка или масштабное обучение.

Это фундаментальное понимание закладывает основу для изучения того, как виртуализация GPU повышает производительность ИИ в практических сценариях.

Преимущества для рабочих нагрузок ИИ и машинного обучения

Виртуализация предлагает целый ряд преимуществ, которые напрямую решают проблемы рабочих нагрузок ИИ и машинного обучения (ML).

Максимальное использование GPU - одно из главных преимуществ. Высокопроизводительные графические процессоры, стоимость которых может составлять от 10 000 до 30 000 долларов США, часто используются недостаточно эффективно при выполнении таких задач, как предварительная обработка данных или настройка моделей. Виртуализация обеспечивает полное использование этих дорогостоящих ресурсов, позволяя нескольким задачам совместно использовать один и тот же GPU, сокращая время простоя и снижая затраты на оборудование. Такой подход позволяет организациям обслуживать больше пользователей и приложений, не нуждаясь в дополнительных физических GPU.

Гибкость в разработке - еще один важный момент. Благодаря виртуализации разработчики могут создавать виртуальные экземпляры GPU с учетом конкретных потребностей, например, различных версий CUDA, объемов памяти или конфигураций драйверов. Благодаря такой изоляции проекты, использующие такие фреймворки, как PyTorch, TensorFlow или JAX, могут сосуществовать без конфликтов, оптимизируя рабочие процессы и ускоряя инновации.

Масштабируемостью стало управлять гораздо проще. Рабочие нагрузки ИИ могут значительно отличаться по своим требованиям. Например, обучение небольшой нейронной сети может требовать минимальных ресурсов, в то время как тонкая настройка большой языковой модели требует огромных вычислительных мощностей. Виртуальные экземпляры могут динамически увеличиваться или уменьшаться, распределяя ресурсы в зависимости от интенсивности рабочей нагрузки. Такая адаптивность обеспечивает эффективное использование ресурсов в любое время.

Поддержка многопользовательской аренды особенно важна для организаций с различными потребностями. Благодаря совместному использованию инфраструктуры различные отделы, клиенты или приложения могут получить доступ к ресурсам GPU без необходимости управлять физическим оборудованием. Облачные провайдеры могут даже предлагать услуги GPU-как-услугу, позволяя пользователям использовать виртуальные экземпляры GPU, сохраняя при этом изоляцию производительности и снижая сложность администрирования.

Наконец, изоляция от сбоев обеспечивает стабильность. Если один виртуальный экземпляр выйдет из строя или будет потреблять чрезмерное количество ресурсов, это не нарушит работу других экземпляров, использующих тот же GPU. Такая надежность крайне важна в производственных средах, где многочисленные службы искусственного интеллекта должны работать бесперебойно и стабильно.

Виртуализация GPU не только оптимизирует использование ресурсов, но и дает командам разработчиков ИИ инструменты и гибкость, необходимые для решения сложных, постоянно меняющихся рабочих нагрузок.

Инфраструктура AI/ML: GPU с временной нарезкой - объяснение

Требования к аппаратному обеспечению и инфраструктуре

Получение наилучшей производительности ИИ в виртуализированных средах GPU в значительной степени зависит от правильного выбора аппаратного обеспечения и межсоединений. Эти решения играют ключевую роль в максимальном использовании потенциала виртуализации GPU для рабочих нагрузок ИИ.

Выбор правильной архитектуры GPU

При выборе графических процессоров для задач ИИ обратите внимание на модели с большим объемом памяти, высокой пропускной способностью и встроенной поддержкой виртуализации. Многие современные GPU могут быть разделены на несколько изолированных экземпляров, что позволяет разным пользователям или приложениям иметь выделенные ресурсы вычислений и памяти. Но выбор правильного GPU - это только часть уравнения: ваша вспомогательная инфраструктура хранения данных и сетевая инфраструктура также должны быть в состоянии поддерживать его производительность.

Требования к системам хранения и сетям

Рабочие нагрузки ИИ часто связаны с управлением огромными объемами данных, что делает высокоскоростные NVMe-хранилища и сети с низкой задержкой необходимыми. В корпоративных средах диски NVMe с высокими показателями выносливости идеально подходят для работы с интенсивными циклами чтения/записи, характерными для приложений ИИ.

Для обмена данными между узлами такие технологии, как InfiniBand или передовые решения Ethernet, обеспечивают пропускную способность, необходимую для бесперебойной работы. Использование распределенной файловой системы для обеспечения параллельного ввода-вывода поможет минимизировать узкие места при одновременном доступе к данным нескольких процессов. Когда потребности в хранении и сети удовлетворены, следующим шагом будет точная настройка выравнивания ресурсов.

Выравнивание ресурсов и оптимизация топологии

Чтобы оптимизировать распределение ресурсов, настройте NUMA (Non-Uniform Memory Access), чтобы обеспечить прямые соединения между GPU, памятью и CPU. Назначьте высокоскоростные сетевые интерфейсы и выделите дорожки PCIe для снижения задержек. Не забывайте, что надежное охлаждение и достаточная мощность имеют решающее значение для предотвращения теплового дросселирования и поддержания стабильности системы. Кроме того, расположение хранилища рядом с вычислительными блоками может еще больше снизить задержки, создавая более эффективную и отзывчивую архитектуру системы.

Конфигурация виртуальной машины и графического процессора

После настройки аппаратного обеспечения следующий шаг - конфигурирование виртуальных машин (ВМ) и графических процессоров для обеспечения оптимальной производительности ИИ. Правильные конфигурации раскрывают потенциал виртуализированных GPU, делая их более эффективными для рабочих нагрузок ИИ. Давайте рассмотрим, как эффективно настраивать и управлять этими ресурсами.

Полный GPU Passthrough против vGPU Partitioning

Когда речь заходит о конфигурациях GPU, существует два основных подхода: GPU passthrough и vGPU partitioning.

- GPU passthrough выделяет весь GPU для одной виртуальной машины, обеспечивая производительность, близкую к нативной, для сложных задач обучения ИИ. Хотя такая настройка позволяет максимально увеличить мощность, она ограничивает GPU одной ВМ, что может быть неэффективно для небольших рабочих нагрузок.

- Разделение vGPU, с другой стороны, делит GPU на несколько виртуальных фрагментов. Такой подход более экономичен для задач, не требующих полной мощности GPU, например, для вычислений или небольших учебных заданий.

Современные GPU, такие как NVIDIA A100 и H100, поддерживают MIG (Multi-Instance GPU), позволяя использовать до семи изолированных экземпляров GPU на одной карте. Эта функция идеально подходит для максимального использования аппаратного обеспечения при сохранении стоимости.

Правильный выбор зависит от вашего сценария использования:

- Для крупномасштабного обучения, например, для обучения языковых моделей или исследований в области глубокого обучения, как правило, лучше использовать пропускной режим GPU.

- Для таких задач, как обработка выводов, разработка или тестирование, разделение vGPU обеспечивает более высокую эффективность использования ресурсов и экономию средств.

Распределение ресурсов для максимального параллелизма

Эффективное распределение ресурсов необходимо для того, чтобы избежать узких мест и обеспечить бесперебойную работу ИИ. Вот как сбалансировать ресурсы:

- Распределение процессора: Назначьте каждой ВМ определенные ядра ЦП, чтобы минимизировать переключение контекста. Как правило, хорошо работает распределение 4-8 ядер CPU на GPU, но это может меняться в зависимости от фреймворка ИИ и сложности рабочей нагрузки.

- Управление памятью: Планируйте как системную оперативную память, так и память GPU. Выделите не менее 16-32 ГБ оперативной памяти на GPU для большинства задач ИИ, оставив при этом достаточно памяти для гипервизора. Использование огромных страниц также может снизить накладные расходы памяти при выполнении операций с большим объемом данных.

- Память GPU: При использовании разделения vGPU внимательно следите за использованием памяти GPU. Некоторые фреймворки, такие как PyTorch и TensorFlow, могут динамически распределять память GPU, но установление лимитов гарантирует, что одна рабочая нагрузка не будет монополизировать ресурсы.

- Работа с сетью: Включите SR-IOV (Single Root I/O Virtualization) для сетевых интерфейсов, чтобы предоставить виртуальным машинам прямой аппаратный доступ. Это снижает сетевые задержки, что особенно важно для распределенного обучения ИИ на нескольких узлах.

Средства оркестровки GPU

После выделения ресурсов инструменты оркестровки могут упростить управление GPU, особенно в масштабируемых средах ИИ.

- NVIDIA GPU Operator: Этот инструмент автоматизирует такие задачи, как установка драйверов GPU, настройка времени выполнения контейнеров и мониторинг состояния в Kubernetes. Он обеспечивает согласованность конфигураций в кластерах и снижает ручную нагрузку.

- Плагины Kubernetes GPU: Такие плагины, как плагин для устройств NVIDIA, позволяют точно настроить планирование и распределение GPU. Они поддерживают дробное использование GPU и обеспечивают точное управление ресурсами для рабочих нагрузок на базе Kubernetes.

- SLURM: планировщик заданий, разработанный для высокопроизводительных вычислений (HPC) и нагрузок искусственного интеллекта, предлагает такие функции, как понимание топологии GPU, планирование справедливого распределения и резервирование ресурсов. Он особенно полезен для управления многопользовательскими и многопроектными средами.

- Docker с NVIDIA Container Toolkit: Эта настройка позволяет контейнерам получать доступ к GPU, сохраняя изоляцию между рабочими нагрузками. Она легко интегрируется с платформами оркестровки, что делает ее гибким вариантом для развертывания приложений ИИ.

По мере роста инфраструктуры ИИ эти инструменты оркестровки становятся незаменимыми. Они автоматизируют управление ресурсами, улучшают их использование и предоставляют интеллектуальные возможности, необходимые для эффективного запуска нескольких рабочих нагрузок на общем оборудовании.

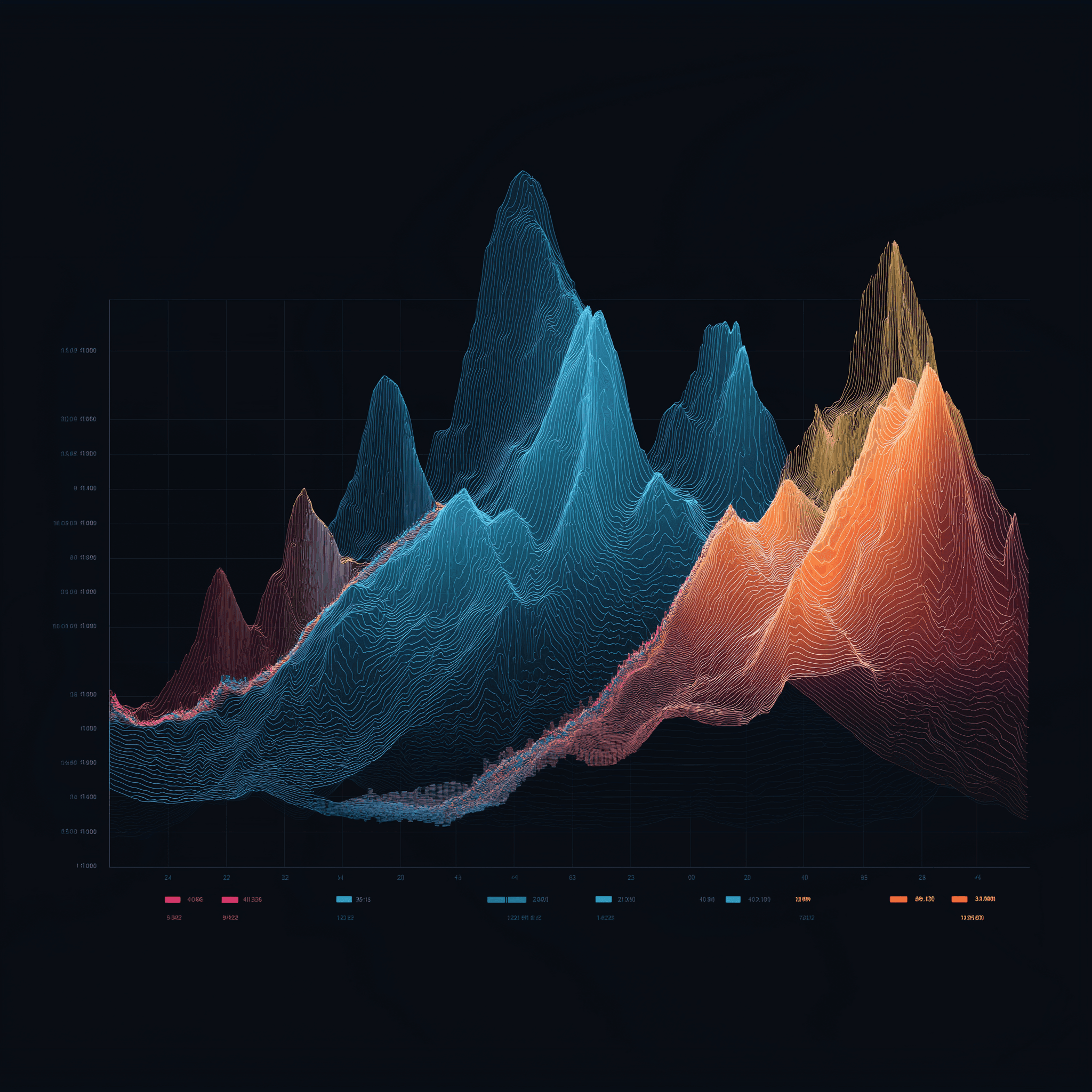

Мониторинг производительности и планирование

После настройки оборудования и конфигураций следующим шагом для обеспечения бесперебойной работы будет мониторинг и составление расписания. Эти две практики являются основой для поддержания пиковой производительности ИИ в виртуализированных средах с GPU. Даже самая лучшая аппаратная настройка может оказаться неэффективной без надлежащей визуализации использования ресурсов и продуманных стратегий планирования. Профилирование, планирование и постоянный мониторинг обеспечивают эффективность и результативность рабочих нагрузок ИИ.

Профилирование рабочих нагрузок ИИ

Профилирование - это как измерение пульса рабочих нагрузок ИИ. Оно помогает выявить узкие места и обеспечить рациональное использование ресурсов до того, как производительность упадет. Цель - понять, как различные задачи потребляют ресурсы GPU, память и вычислительные циклы.

NVIDIA Nsight Systems является основным инструментом для профилирования CUDA приложений, предоставляя подробную информацию об использовании GPU, передаче памяти и времени выполнения ядра. Для фреймворков глубокого обучения инструменты профилирования могут помочь определить, какие рабочие нагрузки связаны с GPU, памятью или CPU, что очень важно для точной настройки распределения ресурсов.

Специфические для фреймворка инструменты, такие как TensorFlow Profiler и PyTorch Profiler, позволяют копнуть еще глубже. TensorFlow Profiler разбивает время выполнения шагов, показывая, сколько времени тратится на такие задачи, как загрузка данных, предварительная обработка и обучение. В то же время PyTorch Profiler внимательно следит за использованием памяти, помогая выявить утечки памяти или неэффективные тензорные операции.

При профилировании необходимо следить за следующими ключевыми показателями:

- Использование GPU: Стремитесь к уровню не менее 80 % во время обучения, чтобы обеспечить эффективное использование.

- Использование пропускной способности памяти: Это показывает, насколько эффективно используется память GPU.

- Эффективность ядра: Показывает, насколько эффективно операции согласуются с архитектурой GPU.

В виртуализированных средах профилирование становится немного сложнее из-за дополнительного слоя гипервизора. Такие инструменты, как vSphere Performance Charts или мониторинг производительности KVM, могут устранить этот пробел, сопоставляя метрики уровня виртуальной машины с данными профилирования на уровне гостя. Такой двухуровневый подход помогает определить, связаны ли проблемы с производительностью с уровнем виртуализации или с самой рабочей нагрузкой.

Полученные в результате профилирования данные напрямую используются в более разумных стратегиях планирования, что позволяет эффективно распределять ресурсы.

Планирование рабочей нагрузки с помощью искусственного интеллекта

Планирование - это то место, где происходит волшебство, обеспечивающее эффективное использование GPU при жонглировании несколькими рабочими нагрузками ИИ. Различные стратегии отвечают разным потребностям - от синхронизации распределенных задач до определения приоритетности критически важных заданий.

- Групповое планирование: Этот метод идеально подходит для синхронного обучения и обеспечивает согласованность всех процессов в распределенном обучении, так что ни один работник не сидит без дела.

- Предиктивное планирование: Анализируя исторические данные, этот подход предсказывает время выполнения заданий на основе таких факторов, как размер модели и характеристики набора данных, обеспечивая более разумное размещение рабочей нагрузки.

- Предварительное выполнение заданий: Высокоприоритетные задания могут временно оттеснить менее приоритетные. Планировщики с учетом контрольных точек безопасно приостанавливают задания, сохраняют их состояние и возобновляют выполнение позже, когда ресурсы освободятся.

- Планирование на основе справедливого распределения: Отслеживает историческое использование и динамически корректирует приоритеты, чтобы обеспечить справедливое распределение ресурсов между пользователями или проектами.

Выбранный метод составления расписания может как повысить, так и понизить эффективность системы. Например, пакетное планирование хорошо работает в исследовательских системах с гибкими сроками, в то время как планирование в реальном времени необходимо для рабочих нагрузок, связанных с выводами, которые требуют низкой задержки.

После составления расписания постоянный мониторинг гарантирует, что все будет идти по плану.

Мониторинг и бенчмаркинг

Непрерывный мониторинг действует как система раннего предупреждения, выявляя потенциальные проблемы до того, как они нарушат работу производства. Сочетание показателей в реальном времени с историческими данными помогает выявить тенденции и закономерности, которые в противном случае могут остаться незамеченными.

Инструменты мониторинга GPU должны отслеживать все: от загрузки и использования памяти до температуры и энергопотребления. NVIDIA Data Center GPU Manager (DCGM) - это надежный вариант, интегрирующийся с такими платформами, как Prometheus и Grafana, чтобы обеспечить всесторонний обзор. Эти инструменты помогут обнаружить такие проблемы, как тепловое дросселирование или давление на память, которые могут снизить производительность.

Мониторинг на уровне приложений позволяет определить такие специфические для ИИ показатели, как потери при обучении, точность проверки и скорость сходимости. Такие инструменты, как MLflow и Weights & Biases, объединяют эти показатели с данными о производительности системы, предоставляя полную картину состояния рабочей нагрузки.

Для распределенного обучения необходим мониторинг сети. Важно отслеживать использование полосы пропускания, задержки и потери пакетов между узлами. Высокоскоростные межсоединения, такие как InfiniBand, требуют специализированных инструментов для обеспечения плавной синхронизации градиентов и параллельного обучения данных.

Бенчмаркинг помогает установить базовые показатели производительности и проверить оптимизацию. БенчмаркиMLPerf - это стандартный выбор для оценки обучения и выводов в различных моделях ИИ и аппаратных установках. Запуск этих тестов в виртуализированной среде позволяет установить базовые ожидания и выявить проблемы конфигурации.

Синтетические тесты, например, в репозитории NVIDIA DeepLearningExamples, также полезны. Они моделируют конкретные сценарии, помогая изолировать накладные расходы на виртуализацию и подтвердить, что ваша среда работает так, как ожидалось.

Регулярные бенчмарки - скажем, раз в месяц - могут выявить такие проблемы, как обновление драйверов, смещение конфигурации или деградация оборудования, которые в противном случае могут остаться незамеченными.

Серверы FDC для инфраструктуры искусственного интеллекта

Для достижения максимальной производительности систем искусственного интеллекта наличие надежной хостинговой инфраструктуры не является обязательным условием. Правильно выбранный хостинг-партнер обеспечивает бесперебойную работу стратегий профилирования, планирования и мониторинга, создавая основу, необходимую для эффективной оптимизации рабочих нагрузок ИИ.

Эта стабильная инфраструктура позволяет развернуть передовые методы профилирования, планирования и оркестровки, о которых говорилось ранее.

Серверы GPU для рабочих нагрузок ИИ

FDC Servers предлагает GPU-хостинг, специально разработанный для приложений ИИ и машинного обучения. Начиная с 1 124 долларов в месяц, их GPU-серверы поставляются с нерегулируемой пропускной способностью - обязательное условие при работе с большими наборами данных или распределенном обучении. Эта функция позволяет не беспокоиться о лимитах на передачу данных и сохранять предсказуемые расходы.

Серверы компании отличаются высокой степенью настраиваемости, что позволяет точно настроить аппаратные конфигурации для моделей ИИ с большим объемом памяти или специализированных GPU, например, необходимых для задач компьютерного зрения. Благодаря мгновенному развертыванию вы можете быстро наращивать ресурсы GPU в соответствии с меняющимися требованиями.

Ключевые функции включают поддержку GPU passthrough, разделение vGPU и настраиваемое планирование - все это очень важно для работы с требовательными рабочими нагрузками ИИ.

Неизмеряемая пропускная способность и глобальное развертывание

Неизмеряемая пропускная способность - это переломный момент для проектов ИИ с большим объемом данных. Для обучения больших моделей часто требуется перемещать терабайты данных между системами хранения, вычислительными узлами и инструментами мониторинга. Благодаря отсутствию ограничений на передачу данных FDC Servers сохраняет предсказуемость вашего бюджета и бесперебойность рабочих процессов.

Благодаря 74 глобальным офисам FDC Servers обеспечивает географический охват, необходимый для современной инфраструктуры искусственного интеллекта. Эта глобальная сеть позволяет размещать вычислительные ресурсы ближе к источникам данных, сокращая задержки в распределенных системах обучения. Для вывода результатов модели могут быть развернуты в периферийных точках, что обеспечивает более быстрое время отклика для конечных пользователей.

Глобальная инфраструктура также играет важную роль в аварийном восстановлении и резервировании. Если в одном из регионов произойдет сбой, рабочие нагрузки можно легко перенести в другой регион, обеспечив бесперебойную работу. Для организаций, управляющих многорегиональными конвейерами искусственного интеллекта, наличие единой инфраструктуры во всех 74 точках обеспечивает единообразие настроек виртуализации, инструментов мониторинга и стратегий планирования - независимо от того, где развернуты ваши ресурсы.

Кроме того, FDC Servers предлагает круглосуточную поддержку для решения любых проблем, связанных с драйверами GPU, конфликтами виртуализации или распределением ресурсов. Это обеспечивает минимальное время простоя даже в сложных виртуализированных средах с GPU.

Все эти функции в совокупности обеспечивают прочную основу для достижения оптимизированной производительности ИИ.

Заключение

В этом руководстве рассказывается о том, как сочетание передового оборудования, точно настроенных ресурсов и надежной инфраструктуры может значительно повысить производительность ИИ.

Чтобы получить максимальную отдачу от рабочих нагрузок ИИ, согласуйте аппаратное обеспечение, распределение ресурсов и инфраструктуру с вашими конкретными требованиями. Для достижения максимальной производительности идеально подходит пропускная способность GPU, а разделение vGPU обеспечивает эффективное разделение ресурсов.

Синергия между выбором оборудования и настройкой ресурсов - ключ к оптимизации производительности. Использование графических процессоров с достаточной пропускной способностью памяти, интеграция NVMe-накопителей и обеспечение высокой пропускной способности сети могут напрямую повысить эффективность обучения и производительность модели. Точная настройка топологии системы позволяет снизить задержки в межсоединениях, а профилирование и интеллектуальное планирование - максимально эффективно использовать GPU. Инструменты оркестровки обеспечивают стабильную производительность высокого уровня.

Надежный хостинг-партнер связывает все воедино. Для организаций, стремящихся преодолеть проблемы с ресурсами, надежный хостинг имеет решающее значение. FDC Servers предлагает GPU-хостинг по цене 1 124 доллара в месяц с неизмеряемой пропускной способностью - опция, которая устраняет ограничения на передачу данных и непредсказуемые расходы.

Благодаря таким функциям, как географическая масштабируемость, мгновенное развертывание и круглосуточная поддержка, вы сможете беспрепятственно масштабировать операции ИИ. Независимо от того, управляете ли вы распределенным обучением по регионам или развертываете краевые модели вывода, надежная инфраструктура устраняет многие технические препятствия, которые часто тормозят проекты ИИ.

Для достижения успеха в области ИИ необходимо органичное сочетание мощности GPU, точного управления ресурсами и надежного хостинга. Следуя этим стратегиям и используя инфраструктуру FDC Servers, вы сможете проложить путь к максимальной производительности ИИ.

Вопросы и ответы

Как виртуализация GPU делает рабочие нагрузки ИИ более эффективными и экономичными?

Виртуализация GPU позволяет нескольким виртуальным машинам использовать один физический GPU, что повышает эффективность и сокращает расходы. Благодаря совместному использованию ресурсов отпадает необходимость в дополнительном оборудовании, что позволяет лучше использовать уже имеющееся и сократить общие расходы.

Такая конфигурация также значительно упрощает масштабирование и управление. Организации могут выполнять больше рабочих нагрузок, связанных с искусственным интеллектом, не нуждаясь в отдельном GPU для каждой виртуальной машины. Результат? Повышенная производительность и контролируемые расходы - идеальное сочетание для проектов ИИ и машинного обучения.

В чем разница между GPU passthrough и vGPU partitioning, и когда следует использовать каждую из них?

При использовании GPU passthrough весь графический процессор выделяется для одной виртуальной машины (ВМ), обеспечивая производительность, практически неотличимую от работы на физическом оборудовании. Это делает его оптимальным вариантом для таких требовательных задач, как обучение моделей ИИ, глубокое обучение или 3D-рендеринг, где необходимо выжимать каждую унцию производительности.

Разделение vGPU, напротив, разделяет один GPU на несколько аппаратных сегментов, позволяя нескольким виртуальным машинам или пользователям одновременно использовать один и тот же GPU. Такая настройка лучше всего подходит для общих сред, таких как виртуальные рабочие столы или совместные рабочие станции, где приоритетом является баланс между гибкостью и эффективным использованием ресурсов.

Какие инструменты и стратегии лучше всего подходят для мониторинга и оптимизации рабочих нагрузок ИИ в виртуализированных средах на GPU?

Чтобы получить максимальную отдачу от рабочих нагрузок ИИ в виртуализированных средах GPU, необходимо использовать инструменты мониторинга GPU, которые предоставляют данные об использовании ресурсов и производительности в режиме реального времени. Например, решения NVIDIA для управления vGPU позволяют отслеживать использование GPU и оптимизировать распределение ресурсов.

Еще один ключевой подход - использование платформ оркестровки, таких как Kubernetes. Эти платформы могут динамически регулировать рабочие нагрузки и более эффективно распределять ресурсы, помогая достичь более высокой производительности GPU. Кроме того, большую роль в поддержании высокого уровня производительности играет регулярная тонкая настройка гиперпараметров и совершенствование конвейеров обработки данных. Постоянный мониторинг показателей GPU позволяет своевременно выявлять узкие места и избегать конфликтов ресурсов, обеспечивая бесперебойную работу задач ИИ.

Как установить и использовать Redis на VPS

Узнайте, как установить и настроить Redis на VPS для оптимальной производительности, безопасности и управления вашими приложениями.

9 мин чтения - 7 января 2026 г.

Мониторинг вашего выделенного сервера или VPS, какие возможности появятся в 2025 году?

12 мин чтения - 28 ноября 2025 г.

У вас есть вопросы или вам нужно индивидуальное решение?

Гибкие варианты

Глобальный охват

Мгновенное развертывание

Гибкие варианты

Глобальный охват

Мгновенное развертывание