Beban Kerja AI di Lingkungan Virtualisasi GPU: Panduan Pengoptimalan

11 menit baca - 10 Oktober 2025

- Beban Kerja AI di Lingkungan Virtualisasi GPU: Panduan Pengoptimalan

- Dasar-dasar Virtualisasi GPU untuk AI

- Infrastruktur AI/ML: Penjelasan GPU Pembagi Waktu

- Persyaratan Perangkat Keras dan Infrastruktur

- Konfigurasi Mesin Virtual dan GPU

- Pemantauan dan Penjadwalan Kinerja

- Server FDC untuk Infrastruktur AI

- Kesimpulan

- Pertanyaan yang Sering Diajukan

Jelajahi bagaimana virtualisasi GPU meningkatkan beban kerja AI dengan meningkatkan efisiensi, mengurangi biaya, dan mengoptimalkan manajemen sumber daya di lingkungan yang tervirtualisasi.

- Beban Kerja AI di Lingkungan Virtualisasi GPU: Panduan Pengoptimalan

- Dasar-dasar Virtualisasi GPU untuk AI

- Infrastruktur AI/ML: Penjelasan GPU Pembagi Waktu

- Persyaratan Perangkat Keras dan Infrastruktur

- Konfigurasi Mesin Virtual dan GPU

- Pemantauan dan Penjadwalan Kinerja

- Server FDC untuk Infrastruktur AI

- Kesimpulan

- Pertanyaan yang Sering Diajukan

Beban Kerja AI di Lingkungan Virtualisasi GPU: Panduan Pengoptimalan

Virtualisasi GPU mengubah cara pengelolaan beban kerja AI. Dengan membagi GPU fisik menjadi beberapa instance virtual, Anda dapat menjalankan beberapa tugas AI secara bersamaan, meningkatkan efisiensi dan mengurangi biaya perangkat keras. Pendekatan ini sangat bermanfaat untuk melatih model yang kompleks, menangani tugas-tugas yang membutuhkan banyak sumber daya, dan menskalakan proyek AI tanpa berinvestasi pada GPU tambahan.

Inilah alasan mengapa hal ini penting:

- Penggunaan GPU yang efisien: Hindari perangkat keras yang menganggur dengan berbagi sumber daya di seluruh tugas dan tim.

- Penghematan Biaya: GPU berkinerja tinggi itu mahal; virtualisasi memastikan pemanfaatan maksimum.

- Fleksibilitas: Menyesuaikan instance GPU virtual dengan kebutuhan spesifik, seperti ukuran memori atau versi CUDA.

- Skalabilitas: Sesuaikan sumber daya secara dinamis seiring dengan bertambahnya beban kerja AI.

- Keandalan: Instance yang terisolasi mencegah satu tugas memengaruhi tugas lainnya.

Untuk mengoptimalkan kinerja:

- Pilih GPU dengan memori dan bandwidth tinggi (misalnya, NVIDIA A100/H100).

- Gunakan penyimpanan NVMe dan jaringan latensi rendah untuk penanganan data.

- Konfigurasikan mesin virtual dengan passthrough GPU atau partisi vGPU berdasarkan kebutuhan beban kerja.

- Memanfaatkan alat bantu seperti NVIDIA GPU Operator, plugin Kubernetes, dan SLURM untuk orkestrasi.

- Pantau performa dengan alat seperti NVIDIA Nsight Systems dan DCGM untuk mengidentifikasi kemacetan.

Layanan hosting seperti FDC Servers menyediakan solusi GPU yang disesuaikan mulai dari $1.124/bulan, termasuk bandwidth tak terukur dan opsi penerapan global untuk proyek AI berskala besar.

Kesimpulan Virtualisasi GPU menyederhanakan manajemen sumber daya, meningkatkan kinerja, dan menurunkan biaya untuk beban kerja AI, menjadikannya solusi praktis untuk menskalakan operasi AI secara efisien.

Dasar-dasar Virtualisasi GPU untuk AI

Apa itu Virtualisasi GPU?

Virtualisasi GPU memungkinkan beberapa pengguna untuk berbagi satu GPU dengan membuat instance virtual, masing-masing dengan memori, inti, dan daya pemrosesan tersendiri. Ini berarti satu GPU dapat menangani banyak tugas atau pengguna secara bersamaan, sehingga menjadikannya solusi yang efisien untuk beban kerja AI.

Pada intinya, teknologi ini bergantung pada hypervisor, yang bertindak sebagai manajer, membagi sumber daya GPU di antara mesin virtual. Hypervisor memastikan setiap instance mendapatkan bagian yang dialokasikan tanpa gangguan dari yang lain. Untuk tugas AI, hal ini memungkinkan satu GPU NVIDIA A100 atau H100 untuk menjalankan beberapa eksperimen pembelajaran mesin, sesi pelatihan, atau operasi inferensi secara bersamaan.

Ada dua metode utama untuk berbagi sumber daya ini:

- Virtualisasi tingkat perangkat keras: Teknologi Multi-Instance GPU (MIG) NVIDIA secara fisik membagi GPU menjadi beberapa bagian yang terisolasi, sehingga memastikan pemisahan yang kuat di antara beberapa instance.

- Virtualisasi tingkat perangkat lunak: Metode ini menggunakan driver dan perangkat lunak untuk membagi sumber daya GPU, menawarkan fleksibilitas yang lebih tinggi tetapi sedikit lebih sedikit isolasi.

Satu perbedaan utama antara GPU dan virtualisasi CPU tradisional terletak pada manajemen memori. GPU menggunakan memori bandwidth tinggi (HBM), yang beroperasi secara berbeda dari RAM sistem standar. Mengelola memori ini secara efisien sangat penting, terutama selama operasi AI yang membutuhkan banyak sumber daya seperti penyempurnaan atau pelatihan berskala besar.

Pemahaman dasar ini menjadi dasar untuk mengeksplorasi bagaimana virtualisasi GPU meningkatkan kinerja AI dalam skenario praktis.

Manfaat untuk Beban Kerja AI dan Pembelajaran Mesin

Virtualisasi menawarkan berbagai manfaat yang secara langsung menjawab tantangan beban kerja AI dan machine learning (ML).

Memaksimalkan pemanfaatan GPU adalah salah satu keuntungan yang menonjol. GPU berkinerja tinggi, yang harganya bisa berkisar antara $10.000 hingga $30.000, sering kali kurang dimanfaatkan selama tugas-tugas seperti prapemrosesan data atau penyiapan model. Virtualisasi memastikan sumber daya yang mahal ini digunakan sepenuhnya dengan memungkinkan beberapa tugas untuk berbagi GPU yang sama, mengurangi waktu menganggur dan memangkas biaya perangkat keras. Pendekatan ini memungkinkan organisasi untuk melayani lebih banyak pengguna dan aplikasi tanpa memerlukan GPU fisik tambahan.

Fleksibilitas dalam pengembangan adalah pengubah permainan lainnya. Dengan virtualisasi, pengembang dapat membuat instance GPU virtual yang disesuaikan dengan kebutuhan spesifik, seperti versi CUDA, ukuran memori, atau konfigurasi driver yang berbeda. Isolasi ini memastikan bahwa proyek yang menggunakan kerangka kerja seperti PyTorch, TensorFlow, atau JAX dapat hidup berdampingan tanpa konflik, merampingkan alur kerja, dan mempercepat inovasi.

Skalabilitas menjadi lebih mudah dikelola. Beban kerja AI dapat sangat bervariasi dalam tuntutannya. Sebagai contoh, melatih jaringan saraf tiruan yang kecil mungkin membutuhkan sumber daya yang minimal, sementara menyempurnakan model bahasa yang besar membutuhkan daya komputasi yang besar. Instance virtual dapat ditingkatkan atau diturunkan secara dinamis, mengalokasikan sumber daya berdasarkan intensitas beban kerja. Kemampuan beradaptasi ini memastikan penggunaan sumber daya yang efisien setiap saat.

Dukungan multi-tenancy sangat berharga bagi organisasi dengan beragam kebutuhan. Dengan berbagi infrastruktur, departemen, pelanggan, atau aplikasi yang berbeda dapat mengakses sumber daya GPU tanpa perlu mengelola perangkat keras fisik. Penyedia cloud bahkan dapat menawarkan GPU-as-a-Service, sehingga pengguna dapat memanfaatkan instance GPU virtual dengan tetap menjaga isolasi kinerja dan mengurangi kompleksitas administratif.

Terakhir, isolasi kesalahan memastikan stabilitas. Jika satu instance virtual mogok atau menghabiskan sumber daya yang berlebihan, hal tersebut tidak akan mengganggu instance lain yang menggunakan GPU yang sama. Keandalan ini sangat penting dalam lingkungan produksi di mana beberapa layanan AI harus berjalan dengan lancar dan konsisten.

Virtualisasi GPU tidak hanya mengoptimalkan penggunaan sumber daya, tetapi juga memberdayakan tim AI dengan alat dan fleksibilitas yang diperlukan untuk menangani beban kerja yang kompleks dan selalu berubah.

Infrastruktur AI/ML: Penjelasan GPU Pembagi Waktu

Persyaratan Perangkat Keras dan Infrastruktur

Mendapatkan performa AI terbaik di lingkungan GPU tervirtualisasi sangat bergantung pada pemilihan perangkat keras dan interkoneksi yang tepat. Keputusan ini memainkan peran penting dalam memaksimalkan potensi virtualisasi GPU untuk beban kerja AI.

Memilih Arsitektur GPU yang Tepat

Saat memilih GPU untuk tugas AI, carilah model dengan kapasitas memori yang tinggi, bandwidth yang cepat, dan dukungan virtualisasi bawaan. Banyak GPU modern yang dapat dipecah menjadi beberapa instance yang terisolasi, sehingga pengguna atau aplikasi yang berbeda dapat memiliki sumber daya komputasi dan memori khusus. Namun, memilih GPU yang tepat hanyalah sebagian dari persamaan - penyimpanan pendukung dan infrastruktur jaringan Anda juga harus dapat mengimbangi kinerjanya.

Persyaratan Penyimpanan dan Jaringan

Beban kerja AI sering kali melibatkan pengelolaan data dalam jumlah yang sangat besar, sehingga penyimpanan NVMe berkecepatan tinggi dan jaringan latensi rendah menjadi sangat penting. Di lingkungan perusahaan, drive NVMe dengan peringkat daya tahan yang kuat sangat ideal untuk menangani siklus baca/tulis yang berat pada aplikasi AI.

Untuk pertukaran data di seluruh node, teknologi seperti InfiniBand atau solusi Ethernet canggih menyediakan bandwidth yang dibutuhkan untuk kelancaran operasional. Menggunakan sistem file terdistribusi untuk mengaktifkan I/O paralel dapat membantu meminimalkan kemacetan ketika beberapa proses mengakses data pada saat yang bersamaan. Setelah kebutuhan penyimpanan dan jaringan terpenuhi, langkah selanjutnya adalah menyempurnakan bagaimana sumber daya diselaraskan.

Penyelarasan Sumber Daya dan Optimalisasi Topologi

Untuk mengoptimalkan penyelarasan sumber daya, konfigurasikan NUMA (Non-Uniform Memory Access) untuk memastikan koneksi langsung antara GPU, memori, dan CPU. Tetapkan antarmuka jaringan berkecepatan tinggi dan dedikasikan jalur PCIe untuk mengurangi latensi. Ingatlah bahwa pendinginan yang kuat dan kapasitas daya yang memadai sangat penting untuk menghindari pelambatan termal dan menjaga stabilitas sistem. Selain itu, memposisikan penyimpanan dekat dengan unit pemrosesan dapat mengurangi latensi lebih lanjut, menciptakan arsitektur sistem yang lebih efisien dan responsif.

Konfigurasi Mesin Virtual dan GPU

Setelah perangkat keras disiapkan, langkah selanjutnya adalah mengonfigurasi mesin virtual (VM) dan GPU untuk memastikan kinerja AI yang optimal. Konfigurasi yang tepat akan membuka potensi GPU tervirtualisasi, sehingga lebih efektif untuk beban kerja AI. Mari pelajari cara mengonfigurasi dan mengelola sumber daya ini secara efisien.

Passthrough GPU Penuh vs Partisi vGPU

Dalam hal konfigurasi GPU, ada dua pendekatan utama: Passthrough GPU dan partisi vGPU.

- GPU passthrough mendedikasikan seluruh GPU untuk satu VM, memberikan performa yang mendekati performa asli untuk tugas pelatihan AI yang berat. Meskipun pengaturan ini memaksimalkan daya, namun membatasi GPU pada satu VM, yang bisa jadi tidak efisien untuk beban kerja yang lebih kecil.

- Partisi vGPU, di sisi lain, membagi GPU menjadi beberapa irisan virtual. Pendekatan ini lebih hemat biaya untuk tugas yang tidak memerlukan daya penuh GPU, seperti beban kerja inferensi atau pekerjaan pelatihan yang lebih kecil.

GPU modern seperti NVIDIA A100 dan H100 mendukung MIG (Multi-Instance GPU), yang memungkinkan hingga tujuh instance GPU yang terisolasi dalam satu kartu. Fitur ini sempurna untuk memaksimalkan pemanfaatan perangkat keras sekaligus menjaga biaya tetap terkendali.

Pilihan yang tepat tergantung pada kasus penggunaan Anda:

- Untuk pelatihan berskala besar, seperti melatih model bahasa atau penelitian pembelajaran mendalam, passthrough GPU biasanya merupakan pilihan yang lebih baik.

- Untuk tugas-tugas seperti penyajian inferensi, pengembangan, atau pengujian, partisi vGPU menawarkan efisiensi sumber daya yang lebih baik dan penghematan biaya.

Alokasi Sumber Daya untuk Paralelisme Maksimal

Alokasi sumber daya yang efisien sangat penting untuk menghindari kemacetan dan memastikan kelancaran operasi AI. Berikut cara menyeimbangkan sumber daya Anda:

- Alokasi CPU: Tetapkan inti CPU tertentu ke setiap VM untuk meminimalkan peralihan konteks. Biasanya, mengalokasikan 4-8 inti CPU per GPU bekerja dengan baik, tetapi ini dapat bervariasi berdasarkan kerangka kerja AI dan kompleksitas beban kerja.

- Manajemen Memori: Rencanakan RAM sistem dan memori GPU. Alokasikan setidaknya 16-32 GB RAM per GPU untuk sebagian besar tugas AI, sambil menyisakan memori yang cukup untuk hypervisor. Menggunakan halaman yang besar juga dapat mengurangi overhead memori dalam operasi yang membutuhkan banyak data.

- Memori GPU: Saat menggunakan partisi vGPU, pantau penggunaan memori GPU dengan cermat. Beberapa kerangka kerja seperti PyTorch dan TensorFlow dapat mengalokasikan memori GPU secara dinamis, tetapi menetapkan batas memastikan satu beban kerja tidak memonopoli sumber daya.

- Jaringan: Aktifkan SR-IOV (Single Root I/O Virtualization) untuk antarmuka jaringan agar VM dapat mengakses perangkat keras secara langsung. Hal ini mengurangi latensi jaringan, yang sangat penting untuk pelatihan AI terdistribusi di beberapa node.

Alat Orkestrasi GPU

Setelah sumber daya dialokasikan, alat orkestrasi dapat menyederhanakan pengelolaan GPU, terutama di lingkungan AI berskala besar.

- Operator GPU NVIDIA: Alat ini mengotomatiskan tugas-tugas seperti penginstalan driver GPU, penyiapan runtime kontainer, dan pemantauan kesehatan di dalam Kubernetes. Alat ini memastikan konfigurasi yang konsisten di seluruh cluster dan mengurangi beban kerja manual.

- Plugin GPU Kubernetes: Plugin seperti plugin perangkat NVIDIA memungkinkan Anda menyempurnakan penjadwalan dan alokasi GPU. Plugin ini mendukung penggunaan GPU pecahan dan memungkinkan manajemen sumber daya yang tepat untuk beban kerja berbasis Kubernetes.

- SLURM: Penjadwal pekerjaan yang dirancang untuk komputasi berkinerja tinggi (HPC) dan beban kerja AI, SLURM menawarkan fitur-fitur seperti kesadaran topologi GPU, penjadwalan pembagian yang adil, dan reservasi sumber daya. Ini sangat berguna untuk mengelola lingkungan multi-pengguna, multi-proyek.

- Docker dengan NVIDIA Container Toolkit: Pengaturan ini memungkinkan kontainer mengakses GPU sambil mempertahankan isolasi di antara beban kerja. Ini terintegrasi secara mulus dengan platform orkestrasi, menjadikannya opsi yang fleksibel untuk menerapkan aplikasi AI.

Seiring dengan pertumbuhan infrastruktur AI Anda, alat orkestrasi ini menjadi sangat diperlukan. Alat ini mengotomatiskan manajemen sumber daya, meningkatkan pemanfaatan, dan memberikan kecerdasan yang diperlukan untuk menjalankan banyak beban kerja secara efisien pada perangkat keras bersama.

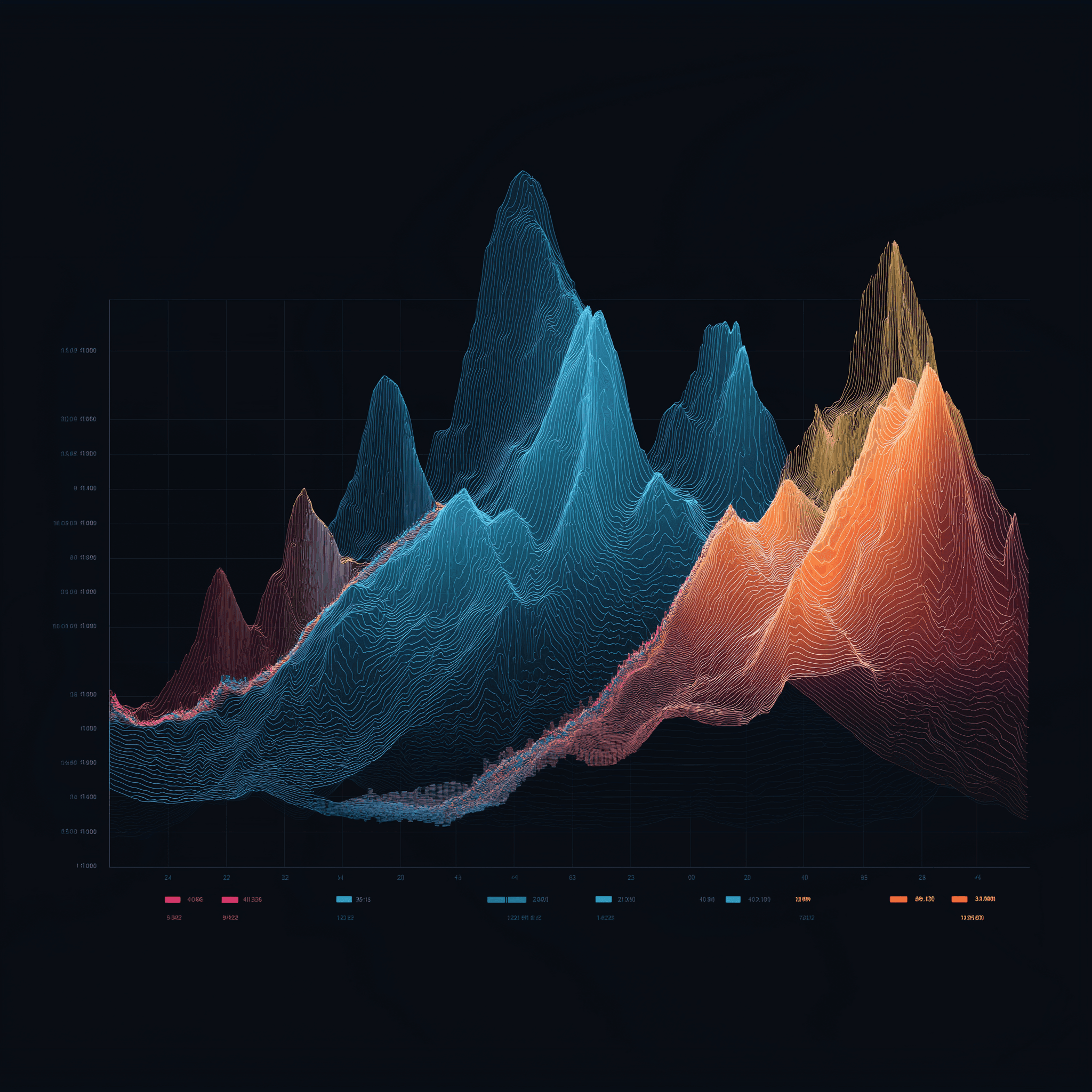

Pemantauan dan Penjadwalan Kinerja

Setelah menyiapkan perangkat keras dan konfigurasi Anda, langkah selanjutnya untuk menjaga agar semuanya berjalan dengan lancar adalah fokus pada pemantauan dan penjadwalan. Kedua praktik ini merupakan tulang punggung untuk mempertahankan performa AI yang prima di lingkungan virtualisasi GPU. Bahkan pengaturan perangkat keras terbaik pun dapat gagal tanpa visibilitas yang tepat ke dalam penggunaan sumber daya dan strategi penjadwalan yang cerdas. Pembuatan profil, penjadwalan, dan pemantauan berkelanjutan memastikan beban kerja AI tetap efisien dan efektif.

Pembuatan Profil Beban Kerja AI

Pembuatan profil seperti mengukur denyut nadi beban kerja AI Anda - ini membantu menunjukkan dengan tepat kemacetan dan memastikan sumber daya digunakan dengan bijak sebelum kinerja menurun. Tujuannya adalah untuk memahami bagaimana tugas yang berbeda menghabiskan sumber daya GPU, memori, dan siklus komputasi.

NVIDIA Nsight Systems adalah alat yang tepat untuk membuat profil aplikasi CUDA, memberikan wawasan mendetail tentang pemanfaatan GPU, transfer memori, dan waktu eksekusi kernel. Untuk kerangka kerja deep learning, alat profiling dapat membantu mengidentifikasi apakah beban kerja menggunakan GPU, memori, atau CPU, yang sangat penting untuk menyempurnakan alokasi sumber daya.

Alat khusus kerangka kerja seperti TensorFlow Profiler dan PyTorch Profiler menggali lebih dalam lagi. TensorFlow Profiler merinci waktu langkah, menunjukkan berapa banyak waktu yang dihabiskan untuk tugas-tugas seperti pemuatan data, prapemrosesan, dan pelatihan. Sementara itu, PyTorch Profiler menawarkan pandangan yang lebih dekat pada penggunaan memori, membantu menangkap kebocoran memori atau operasi tensor yang tidak efisien.

Saat membuat profil, metrik utama yang harus diperhatikan meliputi:

- Pemanfaatan GPU: Targetkan setidaknya 80% selama pelatihan untuk memastikan penggunaan yang efisien.

- Pemanfaatan bandwidth memori: Hal ini menunjukkan seberapa baik memori GPU digunakan.

- Efisiensi kernel: Menunjukkan seberapa efektif operasi selaras dengan arsitektur GPU.

Di lingkungan tervirtualisasi, pembuatan profil menjadi sedikit lebih rumit karena adanya lapisan hypervisor tambahan. Alat-alat seperti vSphere Performance Charts atau pemantauan kinerja KVM dapat menjembatani kesenjangan ini, menghubungkan metrik tingkat VM dengan data profil tingkat tamu. Pendekatan dua lapisan ini membantu menentukan apakah cegukan kinerja disebabkan oleh lapisan virtualisasi atau beban kerja itu sendiri.

Wawasan yang diperoleh dari pembuatan profil langsung masuk ke dalam strategi penjadwalan yang lebih cerdas, menjaga sumber daya tetap dialokasikan secara efektif.

Penjadwalan Beban Kerja AI

Penjadwalan adalah tempat keajaiban terjadi - memastikan GPU digunakan secara efisien sambil menyulap beberapa beban kerja AI. Strategi yang berbeda memenuhi kebutuhan yang berbeda, mulai dari menyinkronkan tugas yang didistribusikan hingga memprioritaskan pekerjaan penting.

- Penjadwalan kelompok: Sempurna untuk pelatihan sinkron, metode ini memastikan semua proses dalam pelatihan terdistribusi selaras, sehingga tidak ada pekerja yang menganggur.

- Penjadwalan prediktif: Dengan menganalisis data historis, pendekatan ini memprediksi waktu pengerjaan pekerjaan berdasarkan faktor-faktor seperti ukuran model dan karakteristik kumpulan data, sehingga memungkinkan penempatan beban kerja yang lebih cerdas.

- Preemption pekerjaan: Tugas dengan prioritas tinggi dapat mendahulukan tugas dengan prioritas lebih rendah untuk sementara waktu. Penjadwal yang sadar pos pemeriksaan menghentikan pekerjaan dengan aman, menyimpan statusnya, dan melanjutkannya nanti saat sumber daya tersedia.

- Penjadwalan pembagian yang adil: Melacak penggunaan historis dan secara dinamis menyesuaikan prioritas untuk memastikan sumber daya didistribusikan secara adil ke seluruh pengguna atau proyek.

Metode penjadwalan yang Anda pilih dapat membuat atau menghancurkan efisiensi sistem. Misalnya, penjadwalan batch bekerja dengan baik dalam pengaturan penelitian dengan tenggat waktu yang fleksibel, sementara penjadwalan waktu nyata sangat penting untuk beban kerja inferensi yang menuntut latensi rendah.

Setelah penjadwalan diterapkan, pemantauan berkelanjutan memastikan semuanya tetap berada di jalurnya.

Pemantauan dan Pembandingan

Pemantauan berkelanjutan bertindak sebagai sistem peringatan dini Anda, menangkap potensi masalah sebelum mengganggu produksi. Menggabungkan metrik waktu nyata dengan data historis membantu mengungkap tren dan pola yang mungkin luput dari perhatian.

Alat pemantauan GPU harus melacak segala sesuatu mulai dari pemanfaatan dan penggunaan memori hingga suhu dan konsumsi daya. Data Center GPU Manager (DCGM ) dari NVIDIA merupakan pilihan yang kuat, yang terintegrasi dengan platform seperti Prometheus dan Grafana untuk memberikan tampilan yang komprehensif. Alat-alat ini dapat membantu mendeteksi masalah seperti pelambatan termal atau tekanan memori yang dapat mengganggu kinerja.

Pemantauan tingkat aplikasi memusatkan perhatian pada metrik khusus AI seperti kehilangan pelatihan, akurasi validasi, dan tingkat konvergensi. Alat-alat seperti MLflow dan Weights & Biases menggabungkan metrik ini dengan data kinerja sistem, sehingga memberikan gambaran lengkap tentang kesehatan beban kerja.

Untuk pelatihan terdistribusi, pemantauan jaringan adalah suatu keharusan. Penting untuk melacak penggunaan bandwidth, latensi, dan kehilangan paket di antara node. Interkoneksi berkecepatan tinggi seperti InfiniBand memerlukan alat khusus untuk memastikan sinkronisasi gradien yang mulus dan pelatihan paralel data.

Benchmarking membantu menetapkan garis dasar kinerja dan memvalidasi pengoptimalan. Tolok ukurMLPerf adalah pilihan standar untuk mengevaluasi pelatihan dan kesimpulan di berbagai model AI dan pengaturan perangkat keras. Menjalankan pengujian ini di lingkungan tervirtualisasi Anda akan menetapkan ekspektasi dasar dan menyoroti masalah konfigurasi.

Benchmark sintetis, seperti yang ada di repositori DeepLearningExamples NVIDIA, juga berguna. Mereka mensimulasikan skenario tertentu, membantu mengisolasi overhead virtualisasi dan memastikan lingkungan Anda berkinerja seperti yang diharapkan.

Pembandingan rutin - katakanlah, sebulan sekali - dapat mengungkapkan masalah seperti pembaruan driver, perubahan konfigurasi, atau degradasi perangkat keras yang mungkin tidak diketahui.

Server FDC untuk Infrastruktur AI

Untuk mencapai kinerja puncak dalam sistem AI, memiliki infrastruktur hosting yang andal tidak dapat ditawar. Mitra hosting yang tepat memastikan strategi pembuatan profil, penjadwalan, dan pemantauan Anda berjalan dengan lancar, menyediakan tulang punggung yang diperlukan untuk mengoptimalkan beban kerja AI secara efektif.

Infrastruktur yang stabil inilah yang memungkinkan penerapan lanjutan dari teknik pembuatan profil, penjadwalan, dan orkestrasi yang telah dibahas sebelumnya.

Server GPU untuk Beban Kerja AI

FDC Servers menawarkan hosting GPU yang dirancang khusus untuk aplikasi AI dan pembelajaran mesin. Mulai dari $1.124 per bulan, server GPU mereka hadir dengan bandwidth tak terukur - yang harus dimiliki saat bekerja dengan dataset besar atau pelatihan terdistribusi. Fitur ini menghilangkan kekhawatiran tentang batas transfer data, membantu Anda mempertahankan biaya yang dapat diprediksi.

Server mereka sangat dapat disesuaikan, memungkinkan Anda untuk menyempurnakan konfigurasi perangkat keras untuk model AI dengan memori tinggi atau pengaturan GPU khusus, seperti yang diperlukan untuk tugas-tugas visi komputer. Dengan penerapan instan, Anda dapat dengan cepat meningkatkan sumber daya GPU untuk memenuhi permintaan yang berfluktuasi.

Fitur utama termasuk dukungan untuk passthrough GPU, partisi vGPU, dan penjadwalan khusus, yang semuanya sangat penting untuk menangani beban kerja AI yang berat.

Bandwidth Tidak Terukur dan Penerapan Global

Bandwidth tak terukur adalah pengubah permainan untuk proyek AI yang sangat besar. Pelatihan model yang besar sering kali membutuhkan pemindahan data terabyte di antara sistem penyimpanan, node komputasi, dan alat pemantauan. Dengan menghilangkan batasan transfer data, FDC Server membuat anggaran Anda dapat diprediksi dan alur kerja Anda tidak terganggu.

Dengan 74 lokasi global, FDC Server menyediakan jangkauan geografis yang dibutuhkan untuk infrastruktur AI modern. Jaringan global ini memungkinkan Anda menempatkan sumber daya komputasi lebih dekat dengan sumber data, sehingga mengurangi latensi dalam pengaturan pelatihan terdistribusi. Untuk inferensi, model dapat digunakan di lokasi tepi, memastikan waktu respons yang lebih cepat bagi pengguna akhir.

Infrastruktur global juga memainkan peran penting dalam pemulihan bencana dan redundansi. Jika satu lokasi mengalami pemadaman, beban kerja dapat dimigrasikan dengan mulus ke wilayah lain, sehingga operasi tetap berjalan dengan lancar. Untuk organisasi yang mengelola pipeline AI multi-wilayah, memiliki infrastruktur yang konsisten di seluruh 74 lokasi memastikan keseragaman dalam pengaturan virtualisasi, alat pemantauan, dan strategi penjadwalan - di mana pun sumber daya Anda ditempatkan.

Selain itu, Server FDC menawarkan dukungan 24/7 untuk mengatasi masalah apa pun, baik yang terkait dengan driver GPU, konflik virtualisasi, atau alokasi sumber daya. Hal ini memastikan waktu henti yang minimal, bahkan di lingkungan GPU yang kompleks dan tervirtualisasi.

Fitur-fitur ini secara kolektif memberikan fondasi yang kuat untuk mencapai kinerja AI yang dioptimalkan.

Kesimpulan

Panduan ini menyoroti bagaimana menggabungkan perangkat keras canggih, sumber daya yang disetel dengan baik, dan infrastruktur yang solid dapat meningkatkan kinerja AI secara signifikan.

Untuk mendapatkan hasil maksimal dari beban kerja AI Anda, selaraskan perangkat keras, alokasi sumber daya, dan infrastruktur Anda dengan kebutuhan spesifik Anda. Untuk performa maksimum, passthrough GPU sangat ideal, sementara partisi vGPU menawarkan cara yang efisien untuk berbagi sumber daya.

Sinergi antara pemilihan perangkat keras dan penyetelan sumber daya adalah kunci untuk mengoptimalkan kinerja. Menggunakan GPU dengan bandwidth memori yang besar, mengintegrasikan penyimpanan NVMe, dan memastikan throughput jaringan yang tinggi dapat secara langsung meningkatkan efisiensi pelatihan dan keluaran model. Menyempurnakan topologi sistem akan mengurangi penundaan interkoneksi, sementara pembuatan profil dan penjadwalan cerdas memaksimalkan penggunaan GPU. Alat orkestrasi lebih lanjut memastikan kinerja tingkat tinggi yang konsisten.

Mitra hosting yang dapat diandalkan menyatukan semuanya. Untuk organisasi yang ingin mengatasi tantangan sumber daya, hosting yang andal sangat penting. FDC Servers menawarkan hosting GPU dengan harga $1.124/bulan dengan bandwidth tak terukur - sebuah opsi yang menghilangkan batas transfer data dan biaya tak terduga.

Dengan fitur-fitur seperti skalabilitas geografis, penerapan instan, dan dukungan 24/7, Anda dapat meningkatkan operasi AI dengan lancar. Baik Anda mengelola pelatihan terdistribusi di seluruh wilayah atau menerapkan model inferensi tepi, infrastruktur yang andal menghilangkan banyak rintangan teknis yang sering kali memperlambat proyek AI.

Untuk mencapai kesuksesan dalam AI, diperlukan perpaduan yang mulus antara kekuatan GPU, manajemen sumber daya yang tepat, dan hosting yang andal. Dengan mengikuti strategi ini dan memanfaatkan infrastruktur FDC Server, Anda dapat membuka jalan menuju kinerja AI yang maksimal.

Pertanyaan yang Sering Diajukan

Bagaimana virtualisasi GPU membuat beban kerja AI menjadi lebih efisien dan hemat biaya?

Virtualisasi GPU memungkinkan beberapa mesin virtual memanfaatkan satu GPU fisik, sehingga meningkatkan efisiensi sekaligus memangkas biaya. Dengan berbagi sumber daya, hal ini menghilangkan kebutuhan akan perangkat keras tambahan, memanfaatkan apa yang sudah tersedia dengan lebih baik, dan memangkas biaya secara keseluruhan.

Pengaturan ini juga membuat penskalaan dan manajemen menjadi lebih mudah. Organisasi dapat menangani lebih banyak beban kerja AI tanpa memerlukan GPU terpisah untuk setiap mesin virtual. Hasilnya? Performa yang efisien dan biaya yang terkendali - kombinasi yang ideal untuk proyek AI dan pembelajaran mesin.

Apa perbedaan antara passthrough GPU dan partisi vGPU, dan kapan Anda harus menggunakan masing-masing?

Dalam hal passthrough GPU, seluruh GPU didedikasikan untuk satu mesin virtual (VM), yang menawarkan performa yang hampir tidak dapat dibedakan dengan menjalankannya pada perangkat keras fisik. Hal ini menjadikannya pilihan utama untuk tugas-tugas berat seperti pelatihan model AI, pembelajaran mendalam, atau rendering 3D, di mana memeras setiap ons kinerja sangat penting.

Sebaliknya, partisi vGPU membagi satu GPU menjadi beberapa segmen berbasis perangkat keras, sehingga memungkinkan beberapa VM atau pengguna berbagi GPU yang sama secara bersamaan. Pengaturan ini bekerja paling baik untuk lingkungan bersama seperti desktop virtual atau workstation kolaboratif, di mana menyeimbangkan fleksibilitas dan penggunaan sumber daya yang efisien adalah prioritas.

Apa saja alat dan strategi terbaik untuk memantau dan mengoptimalkan beban kerja AI di lingkungan tervirtualisasi GPU?

Untuk mendapatkan hasil maksimal dari beban kerja AI di lingkungan tervirtualisasi GPU, sangat penting untuk memanfaatkan alat pemantauan GPU yang menawarkan data waktu nyata tentang penggunaan sumber daya dan kinerja. Sebagai contoh, solusi manajemen vGPU NVIDIA memudahkan untuk melacak pemanfaatan GPU dan mengoptimalkan bagaimana sumber daya didistribusikan.

Pendekatan utama lainnya adalah menggunakan platform orkestrasi seperti Kubernetes. Platform ini dapat menyesuaikan beban kerja secara dinamis dan mengalokasikan sumber daya secara lebih efektif, sehingga membantu Anda mencapai performa GPU yang lebih baik. Selain itu, menyempurnakan hyperparameter dan menyempurnakan pipeline data secara teratur memainkan peran besar dalam menjaga tingkat kinerja tetap tinggi. Dengan terus memantau metrik GPU, Anda dapat menemukan kemacetan lebih awal dan menghindari konflik sumber daya, sehingga memastikan tugas AI Anda berjalan dengan lancar.

Cara menginstal dan menggunakan Redis pada VPS

Pelajari cara menginstal dan mengonfigurasi Redis di VPS untuk performa, keamanan, dan manajemen yang optimal dalam aplikasi Anda.

9 menit baca - 7 Januari 2026

Memantau server khusus atau VPS Anda, apa saja pilihannya di tahun 2025?

12 menit baca - 28 November 2025

Ada pertanyaan atau butuh solusi khusus?

Opsi yang fleksibel

Jangkauan global

Penerapan instan

Opsi yang fleksibel

Jangkauan global

Penerapan instan